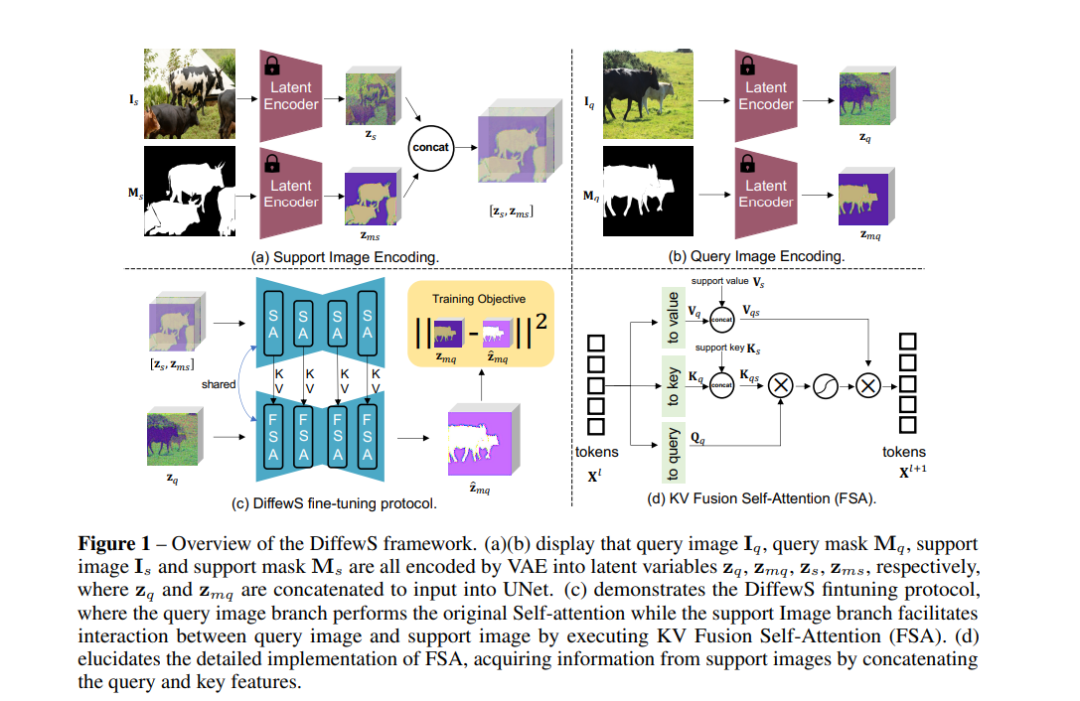

扩散模型(Diffusion Model)不仅在图像生成领域取得了显著成果,还展示了作为一种利用未标注数据的有效预训练方法的潜力。鉴于扩散模型在语义对应和开放词汇分割中的广泛潜力,我们的研究启动了将潜在扩散模型(Latent Diffusion Model)应用于小样本语义分割的探索。最近,受到大型语言模型上下文学习能力的启发,小样本语义分割逐渐演变为上下文分割任务,成为评估通用分割模型的重要元素。在此背景下,我们专注于小样本语义分割,为基于扩散模型的通用分割模型的未来发展奠定坚实基础。 我们的初步重点在于理解如何促进查询图像与支持图像之间的交互,并在此基础上提出了一种在自注意力框架中的 KV 融合方法。接下来,我们深入优化了支持掩码信息的注入方式,同时重新评估如何从查询掩码中提供合理的监督。基于我们的分析,我们建立了一个名为 DiffewS 的简单而有效的框架,最大程度地保留了原始潜在扩散模型的生成框架,并有效利用了预训练先验。实验结果表明,我们的方法在多种设置下显著优于先前的最先进(SOTA)模型。

https://www.zhuanzhi.ai/paper/dead1a1c65dabbbea61fa5bfe6709e7c

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2024年11月8日

Arxiv

39+阅读 · 2023年4月19日

Arxiv

209+阅读 · 2023年4月7日

Arxiv

142+阅读 · 2023年3月29日