因果推理提供了一套原则和工具,使人们能够结合有关环境的数据和知识,推理出具有反事实性质的问题--即如果现实情况不同,会发生什么--即使目前没有这种未实现现实的数据。强化学习提供了一系列方法,当智能体被部署在一个环境中,并采用探索性的试错方法时,可以学习一种能优化特定衡量标准(如奖励、遗憾)的策略。这两门学科各自独立发展,彼此之间几乎没有互动。我们注意到,它们在同一构件(即反事实关系)的不同方面进行操作,这使得它们之间有着千丝万缕的联系。基于这些观察,我们进一步认识到,当这种联系被明确承认、理解和数学化时,各种新的学习机会就会自然而然地产生。为了实现这一潜能,我们进一步指出,任何部署有智能体的环境都可以分解为一系列自主机制,这些自主机制会导致不同的因果不变性,并可被简化为一个结构因果模型;今天的任何标准智能体设置都隐含地编码了其中的一个模型。这种自然的形式化反过来又允许我们将不同的学习模式(包括在线学习、非策略学习和因果微积分学习)置于统一的处理之下,而这些模式在文献中似乎并不相关。人们可能会猜测,这三种标准学习模式是详尽无遗的,因为所有可能的反事实关系都可以通过它们的连续实施来学习。我们通过介绍几类相当自然且普遍存在的学习环境,证明事实并非如此,这些学习环境并不符合这些模式,而是包含了新的分析维度和类型。具体来说,我们将通过因果视角介绍和讨论离线到在线学习、在何处干预、模仿学习和反事实学习等问题。这一系列新任务和新理解将为反事实学习带来更广阔的视角,并表明因果推理和强化学习并行研究的巨大潜力,我们称之为因果强化学习(CRL)。

关键词 结构因果模型、干预、反事实、强化学习、可识别性、稳健性、策略外评估、模仿学习。

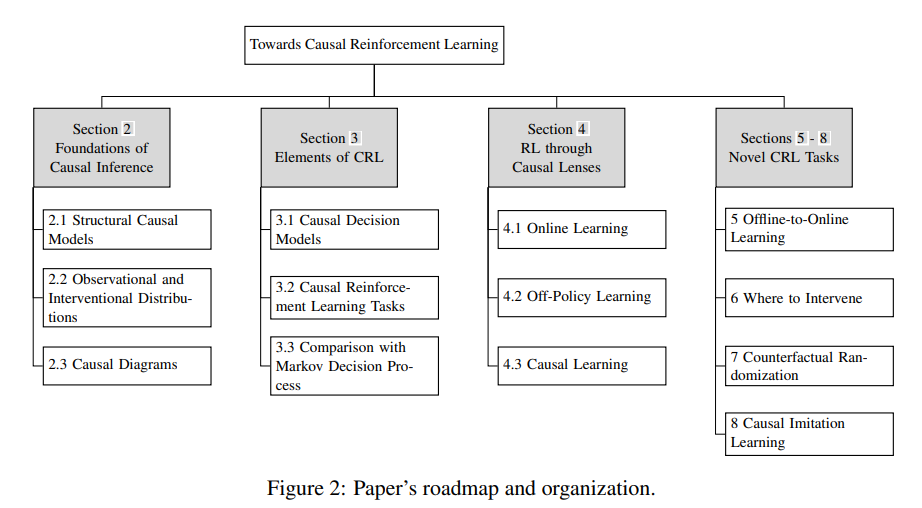

本文其余部分的组织结构如图 2 所示。在第 2 节中,我们提供了理解本文其余部分所必需的背景和因果推断的逻辑基础。我们回顾了结构因果模型的定义(第 2.1 节)、观察和干预分布的评估(第 2.2 节)以及在单片机中构建表示定性知识的因果图(第 2.3 节)。本文提供了大量实例来说明这些概念。

第 3 章是基础性章节,将 RL 中的不同学习模式与本章介绍的因果语言联系起来。特别是,第 3 章使用单片机语义语言(称为因果决策模型)将策略学习问题形式化(第 3.1 节)。基于这个框架,我们引入了因果强化学习任务,这些任务考虑了学习智能体的交互能力和智能体可获取的环境先验知识(第 3.2 节)。我们将 CRL 形式与马尔可夫决策过程标准模型假设下的强化学习进行比较,强调这里不存在自由裁量权,因果知识是解决 CRL 任务不可或缺的。

第 4 节通过 CRL 框架研究强化学习和因果推理的经典学习任务,包括非策略学习(第 4.1 节)、在线学习(第 4.2 节)和因果识别(第 4.3 节)。具体而言,我们讨论了针对上述各项任务进行策略学习的若干条件和算法程序。在最后一节中,我们介绍了一种图形标准,它将非策略学习方法扩展到了结构因果关系语言中,在这种语言中,未观察到的混杂因素并没有被先验地排除。

第 5 节考虑了因果离线到在线学习(COOL)问题,智能体试图首先从离线数据中预先训练最优策略的信息表征,然后通过进行在线实验来微调策略估计值。第 5.1 节介绍了在强盗模型中转移观测数据的混杂稳健程序。第 5.2 和 5.3 节将这种转移策略扩展到智能体必须决定一系列行动以最大化主要结果的顺序决策环境(例如动态治疗制度)。

第 6 节引入了一项新任务,称为混合策略学习。这项任务关注的是智能体是否应该对系统进行干预,如果干预,干预的目标应该是哪里。第 6.1 节研究了具有原子干预的混合策略空间的内在结构特性,这些特性可以帮助智能体更高效、更有效地探索该空间。第 6.2 节进一步研究了智能体可以进行软干预的场景,即选择观察哪些变量来执行软干预。

第 7 节拓宽了策略的范围,并引入了一种新颖的反事实决策标准,该标准适用于智能体自身存在偏见并在对抗性环境中运行的情况。第 7.1 节正式提出了反事实策略的概念,使智能体能够通过考虑其最初的预期行动来进行反事实推理。第 7.2 节介绍了一种新型反事实随机化策略,它支持反事实决策标准的实现,并有助于学习最优反事实策略。在最后一节,我们正式提出了反事实决策标准下最优性与自主性之间的权衡,并提供了一种实用的规划算法来解决这一权衡问题。

第 8 节研究了在不完全了解衡量智能体绩效的奖励函数的情况下,从观测数据中学习策略的问题--称为模仿学习。第 8.1 节提出了学习模仿策略的完整图形条件,利用行为克隆达到专家的性能。第 8.2 节对这一条件进行了扩展,通过逆 RL 利用有关未知奖励函数的参数知识,生成了一种可以持续支配专家的策略。我们还开发了一种算法方法,可以在提供环境因果图的更广义单片机系列中应用逆 RL。

最后,第 9 节总结了前几节中研究的工作和算法,并给出了结束语。我们还讨论了其他基本的 CRL 任务,包括可迁移性、可泛化性和模型归纳,并概述了设计 CRL 智能体的未来挑战。