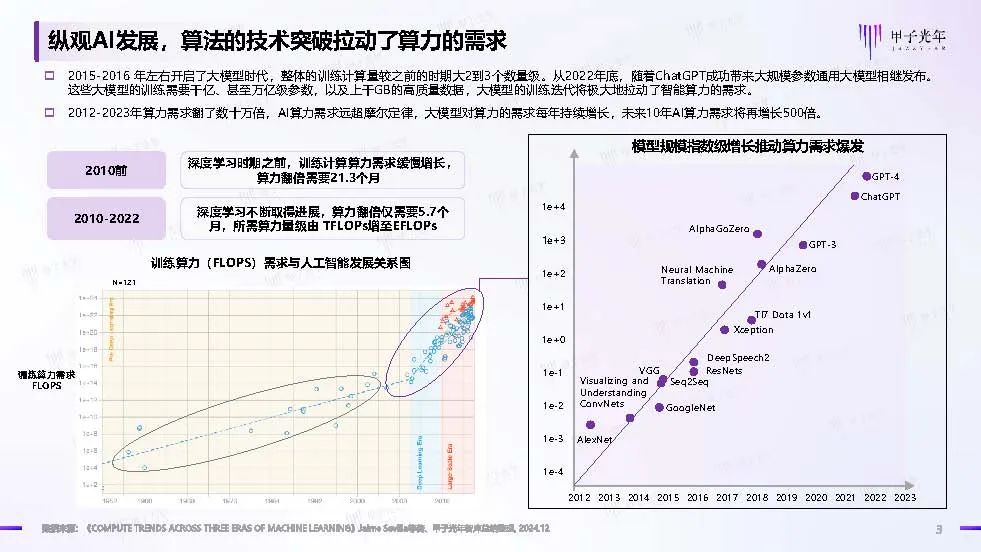

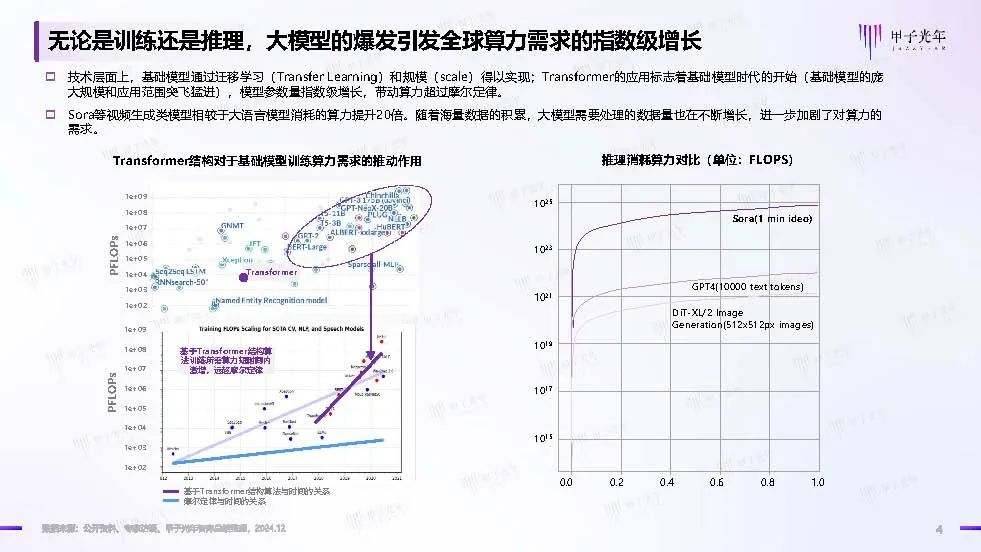

纵观AI发展,算法的技术突破拉动了算力的需求 2015-2016年左右开启了大模型时代,整体的训练计算量较之前的时期大2到3个数量级。从2022年底,随着ChatGPT成功带来大规模参数通用大模型相继发布。这些大模型的训练需要千亿、甚至万亿级参数,以及上千GB的高质量数据,大模型的训练迭代将极大地拉动了智能算力的需求。 2012-2023年算力需求翻了数十万倍,AI算力需求远超摩尔定律,大模型对算力的需求每年持续增长,未来10年AI算力需求将再增长500倍。无论是训练还是推理,大模型的爆发引发全球算力需求的指数级增长 技术层面上,基础模型通过迁移学习(Transfer Learning)和规模(scale)得以实现;Transformer的应用标志着基础模型时代的开始(基础模型的庞大规模和应用范围突飞猛进),模型参数量指数级增长,带动算力超过摩尔定律。 Sora等视频生成类模型相较于大语言模型消耗的算力提升20倍。随着海量数据的积累,大模型需要处理的数据量也在不断增长,进一步加剧了对算力的需求。

成为VIP会员查看完整内容

相关内容

Arxiv

36+阅读 · 2023年4月19日

Arxiv

185+阅读 · 2023年4月7日

Arxiv

130+阅读 · 2023年3月29日

Arxiv

77+阅读 · 2023年3月21日