高精度操控的策略学习前沿研究

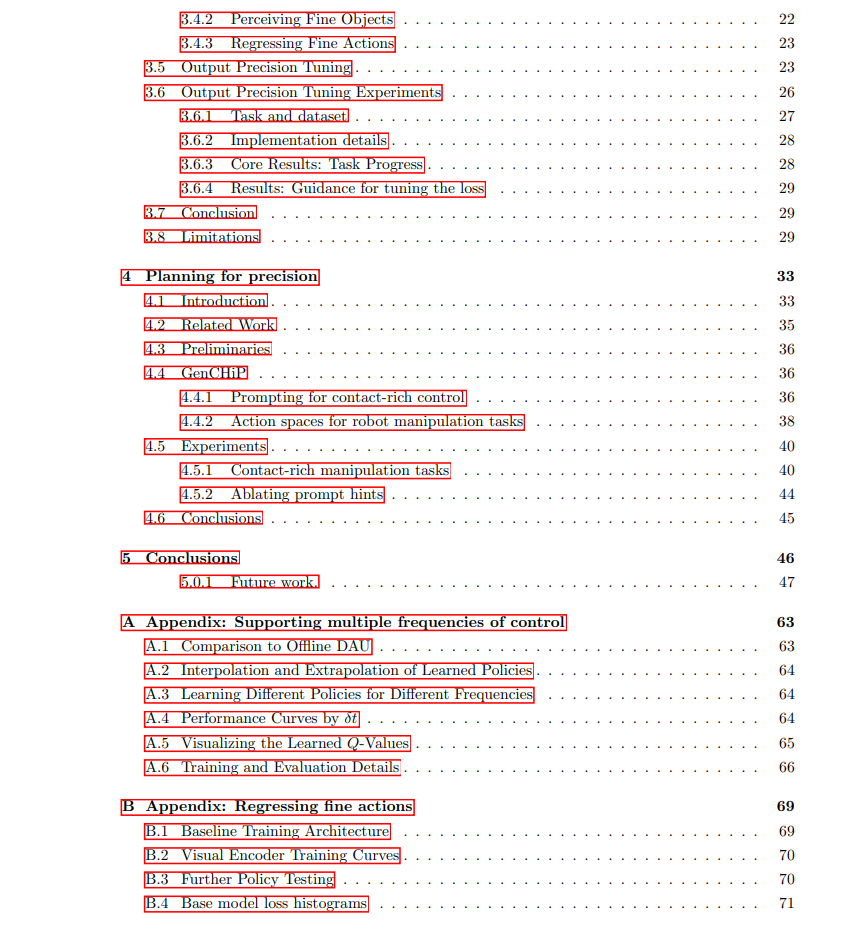

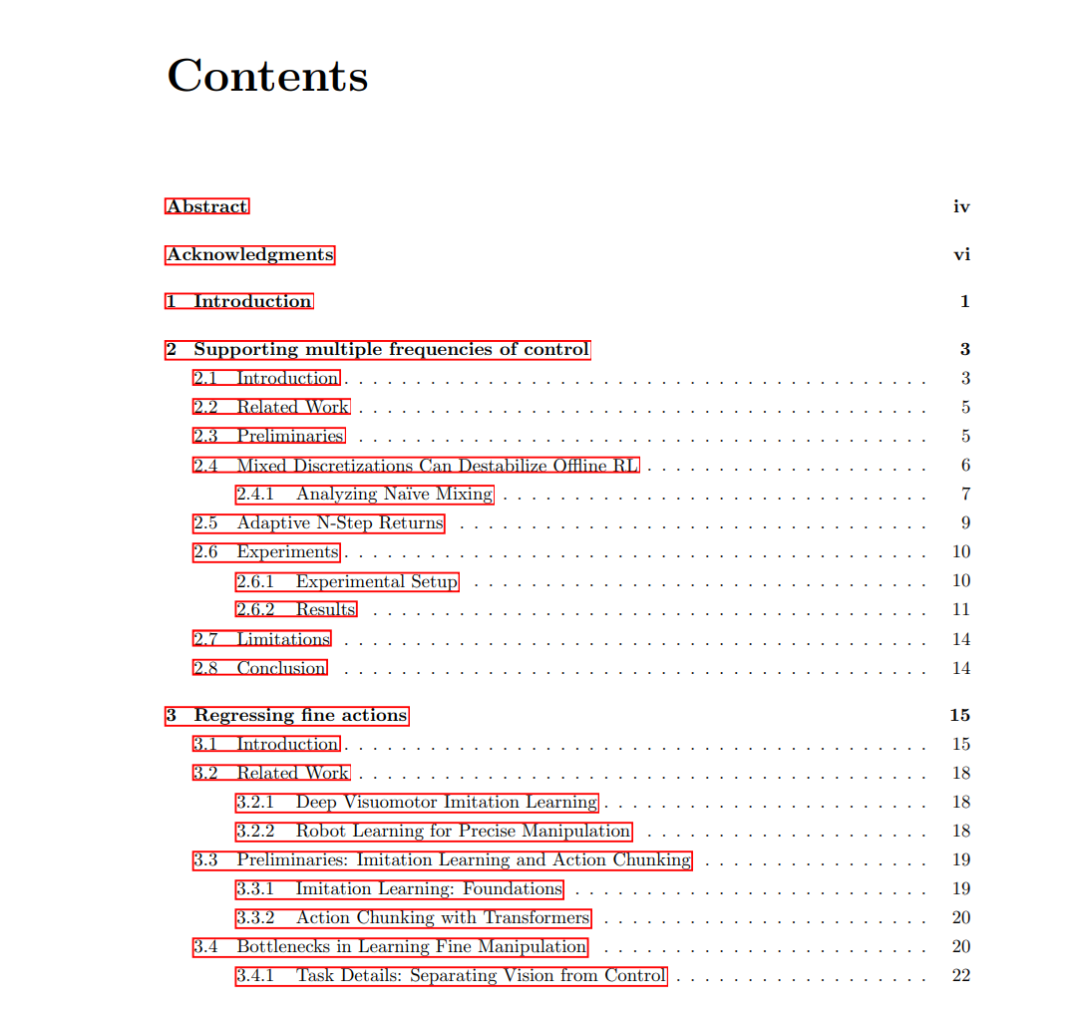

本论文致力于通过现代策略学习方法突破高精度操控任务的极限,系统性地解决了当前策略学习框架在全控制栈中的不足。我们首先揭示了高频控制对精确策略的关键作用:当任务容差阈值极小时,策略查询频率不足将导致响应能力缺失。针对离线强化学习(RL)原生不支持混合频率数据的局限,我们发现不同离散化频率会导致Q值传播速率差异,进而提出通过Q-step回报的离散化规模缩放来实现Q值更新速率一致性的创新方法。在三个机器人控制仿真任务中,该方法成功实现了跨频率泛化能力。 在模仿学习方面,我们通过仿真实验解耦物体几何属性与视觉特征,首次证实精确控制(而非视觉感知)是精细操作任务的主要瓶颈。针对典型模仿学习流程的系统分析揭示了三大障碍:(i) 传统损失函数在不同误差区间的非线性行为;(ii) 批次不足导致的梯度噪声超过任务精度要求;(iii) 收敛所需梯度步数过多。由此提出的"输出精度调优"方案整合了分段L1损失函数、梯度累积虚拟批次和输出层过训练三项技术,在六项真实世界精细操作任务中平均提升75%的性能表现。 针对基于大语言模型(LLM)的规划器,我们创新性地设计了兼容接触力约束的动作空间参数化方法。实验表明,通过融合目标位姿的交互刚度约束估计,LLM策略生成成功率较非兼容动作空间提升3-4倍,成功拓展了代码生成方法在接触密集型高精度任务中的应用边界。这项研究为突破感知噪声和抓取误差等现实条件限制下的精确控制提供了新范式。

成为VIP会员查看完整内容

相关内容

Arxiv

37+阅读 · 2023年4月19日

Arxiv

203+阅读 · 2023年4月7日

Arxiv

78+阅读 · 2023年4月4日

Arxiv

138+阅读 · 2023年3月29日