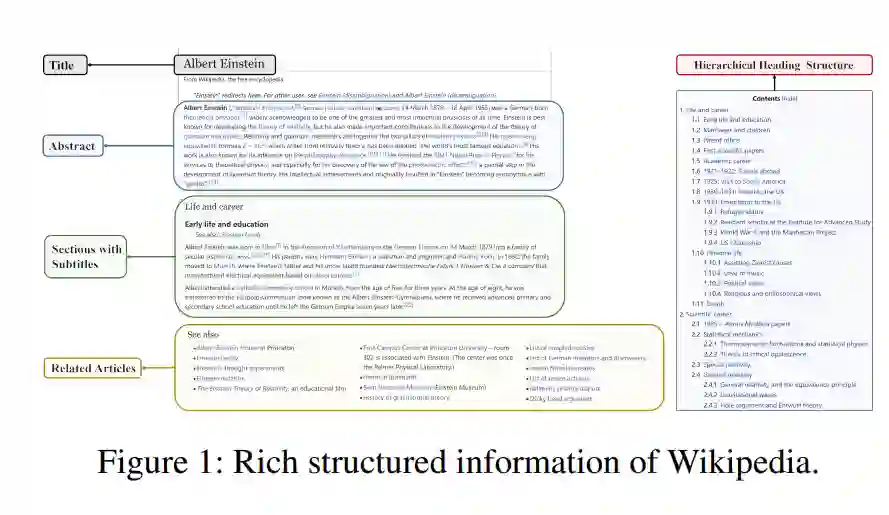

随着深度学习和自然语言处理技术的发展,预训练语言模型已广泛用于解决信息检索(IR)问题。得益于预训练和微调的范式,这些模型实现了最先进的性能。在以前的工作中,维基百科中的纯文本在预训练阶段被广泛使用。然而,维基百科中的丰富结构化信息,如标题、摘要、层次化标题(多级标题)结构、文章之间的关系、参考文献、超链接结构和写作组织,并未被充分探索。在本文中,我们根据维基百科的结构化知识,设计了四个针对IR任务的预训练目标。与现有的预训练方法相比,我们的方法通过利用维基百科中由人类编辑的结构化数据,可以更好地捕获训练语料库中的语义知识。在多个IR基准数据集上的实验结果显示,与现有强大的检索基线相比,我们的模型在零样本和微调设置中均表现出色。此外,在生物医学和法律领域的实验结果表明,与以前的模型相比,我们的方法在垂直领域中实现了更好的性能,尤其是在需要长文本相似性匹配的场景中。代码可在 https://github.com/oneal2000/Wikiformer 获取。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日