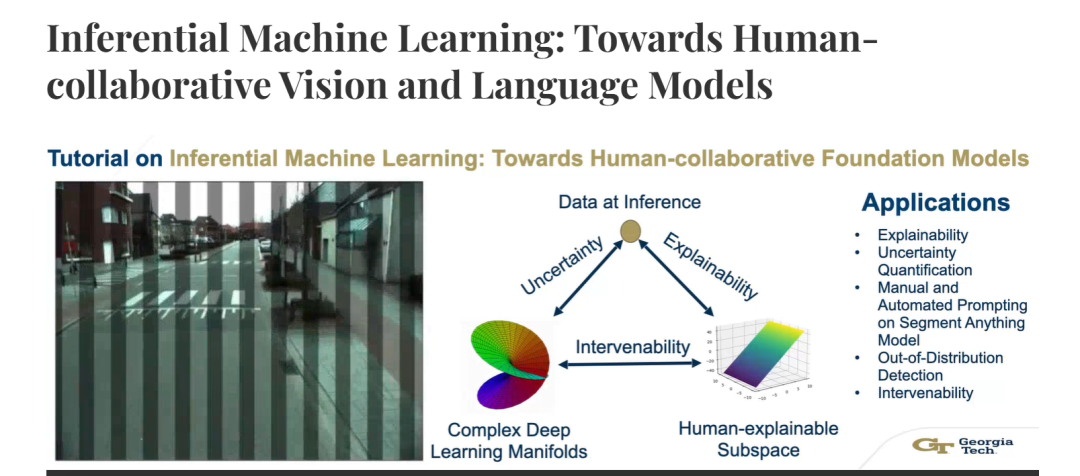

像ChatGPT这样的神经网络驱动应用存在幻觉问题,即它们自信地提供不准确的信息。这种不准确性的根本原因在于神经网络的前馈式归纳决策机制。这些决策是训练方案的结果,这些方案不允许网络在推理过程中偏离或创造性地推断原因。随着基础模型的出现,这些模型可以跨应用和数据适应,人类可以直接干预并提示视觉-语言基础模型。然而,如果不了解底层网络的操作限制,人类干预往往会导致不公平、不准确、幻觉化和难以理解的输出。这些输出削弱了对基础模型的信任,从而阻碍了其在日常生活中的采用。 在本教程中,我们提供了一种系统的方法来分析和理解神经网络在推理过程中的人类干预功能。具体而言,我们的见解如下:

- 决策理论必须是溯因的,而非演绎或归纳的:推理过程应允许网络通过溯因推理生成合理的解释,而不仅仅是基于训练数据的归纳或逻辑演绎。

- 干预必须作为“未采取”的剩余干预的函数进行分析:评估干预效果时,应考虑未实施的干预可能带来的影响,以全面理解干预的作用。

- 干预并非总是积极的,网络必须能够检测不公平和对抗性决策及交互:网络需要具备识别和拒绝不公平或恶意干预的能力,以确保输出的公平性和准确性。

最终目标是通过推理机器学习技术促进人机协作环境。 人工智能促进协会(AAAI)历来处于推动AI采用研究的前沿。随着基于神经网络的AI系统从学术界过渡到日常生活,允许用户在推理阶段提供有限输入的提示式架构变得越来越重要。然而,用户采用的“试错”策略可能会超出研究人员在训练阶段设计的操作限制。因此,必须更加重视推理过程中的可信度措施。本教程及时强调了有助于AI适用性的推理机器学习措施。由于AAAI吸引了包括学生、研究人员、企业家、政策制定者、媒体机构以及学术界和工业界其他相关方在内的各级利益相关者,这为强调推理过程中的人机协作概念提供了理想的机会。

成为VIP会员查看完整内容

相关内容

Arxiv

195+阅读 · 2023年4月7日