强化学习(RL)在自主智能体领域展现了巨大的潜力。然而,当将机器人应用于安全关键领域时,系统必须足够稳健,才能在现实生活中部署。例如,机器人应能够在不同的场景中执行任务,并避免进入不希望发生且不可逆的状态,例如撞到障碍物,理想情况下,即使机器人无法实现其主要目标,也应满足安全要求。 提高强化学习智能体稳健性的一种方法是通过领域随机化来探索多种场景、环境参数和对手策略。然而,随着智能体表现的提升,它变得不太可能探索那些表现较差的区域。解决这一问题的一种方法是对抗性训练,其中对抗性智能体尝试注入噪声,迫使自我智能体表现不佳。然而,在这种设置中,对抗智能体更容易战胜自我智能体,因此自我智能体往往在没有专家监督的情况下无法克服对抗性噪声。另外,随着机器人进入更加非结构化的环境,环境因素可能比噪声更大程度地影响状态空间和动态的分布。

在我的论文中,我将讨论如何利用课程学习帮助智能体有效地探索各种不同的情况、对手和动态,从而实现稳健的表现。论文的第一部分将介绍课程学习的基本理念,以及它如何被用来探索广泛的环境。第二部分将扩展这一概念到多智能体领域,探讨课程学习如何在协作和竞争、对称和非对称的设置中帮助找到稳健的策略。最后,我将扩展这些研究成果到质量多样性领域,探索课程学习如何帮助我们找到一系列行为,这些行为累计起来能实现稳健性。

1.1 人工智能的进展与稳健性的需求

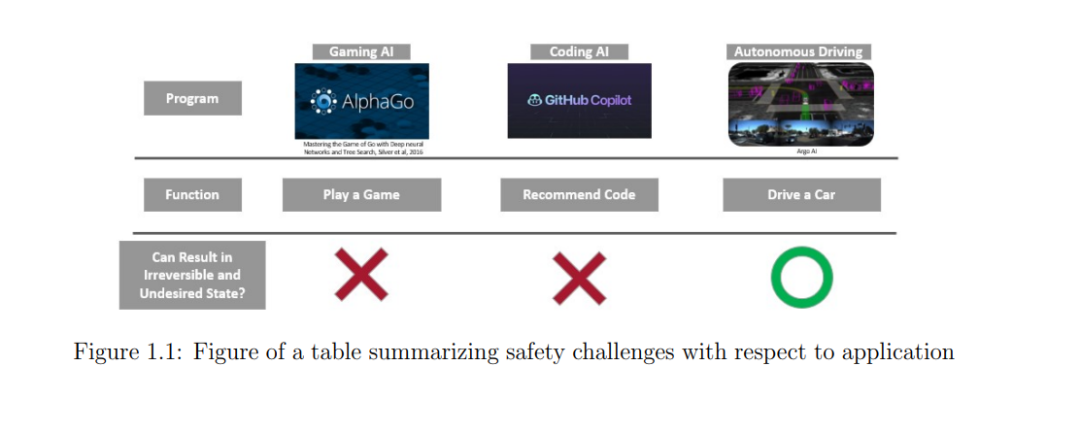

近年来,人工智能(AI)和深度学习经历了显著增长,并展现出了巨大的潜力。多家公司正在推出能够基于数据识别和提出建议的AI智能体(79;80),这些智能体已经开始改善我们的生活质量。此外,还有努力在推动开发能够不仅在看到某些数据时向人类提出建议,还能在看到这些数据时知道如何与世界物理互动并执行相应操作的智能体。对于能够自主决策的智能体,强化学习(RL)展现了巨大的潜力。与其要求专家为每种情况手动设计并硬编码所需的动作,RL智能体可以通过探索和与真实或模拟环境互动,自主训练自己。RL智能体已经在各种模拟环境中展现出超越人类的表现,如围棋、赛车甚至空对空战斗(92;104;118)。 然而,这种应用也提出了一个新的稳健性挑战,如图1.1所示。虽然智能体可以展示超越人类的表现,但如果人类操作员不信任智能体的安全性,这些智能体将无法部署。例如,游戏AI在现实生活中已经相对被信任并得到应用。即使游戏AI遇到无法发挥全部性能的情况并未能赢得比赛,结果也不会是灾难性的。游戏的目标是娱乐,只要人类用户享受体验,偶尔输掉比赛的游戏AI是可以接受的。同样,像OpenAI的Copilot这样的代码助手也相对被信任并得到应用。尽管该智能体会提供编程建议,但最终还是由人类程序员决定是否接受推荐并执行程序。假设人类程序员完成其工作,智能体的失败不会直接导致灾难性失败。另一方面,在自动驾驶的情况下,自动驾驶智能体是决策算法,通常是与现实世界交互的自动化流程中的最后一环。自动驾驶智能体的设计目的是完全移除安全驾驶员,因此,如果自动驾驶智能体出现故障,由于没有人类进行错误过滤,结果可能会导致灾难性后果,且在某些情况下是不可逆的。因此,为了将自动驾驶智能体部署到现实生活中的安全关键应用中,我们不仅需要智能体表现良好,还需要它在各种情况和环境中持续稳定地表现,而不会导致不可逆和灾难性的状态。本文将把稳健性作为确保智能体在预期操作的情境中不会陷入不可逆和灾难性状态的一种方式进行探讨。

1.2 解决稳健性问题的方法

机器学习中关于稳健性的研究有多种方式。一些研究专注于验证训练后的模型在操作数据集中的表现不会失败(40;55)。将这一概念扩展到强化学习(RL),可以使用控制屏障函数(CBF)(3)来确保RL策略不会进入不可恢复的状态(30)。控制屏障函数结合了领域和动态的专家知识,用于定义哪些状态是安全且可恢复的。 结合这一思想,我们关注自主智能体能够覆盖和解决多少种情况,而不会进入不可逆和灾难性的区域。在本文中,我们将稳健性定义为智能体在更广泛的情境中实现高性能的能力。我们的目标是训练出能够部署到安全关键情境中的稳健策略,如驾驶和飞行,其中无法处理某些不可避免的长尾情境会阻碍RL智能体的部署。