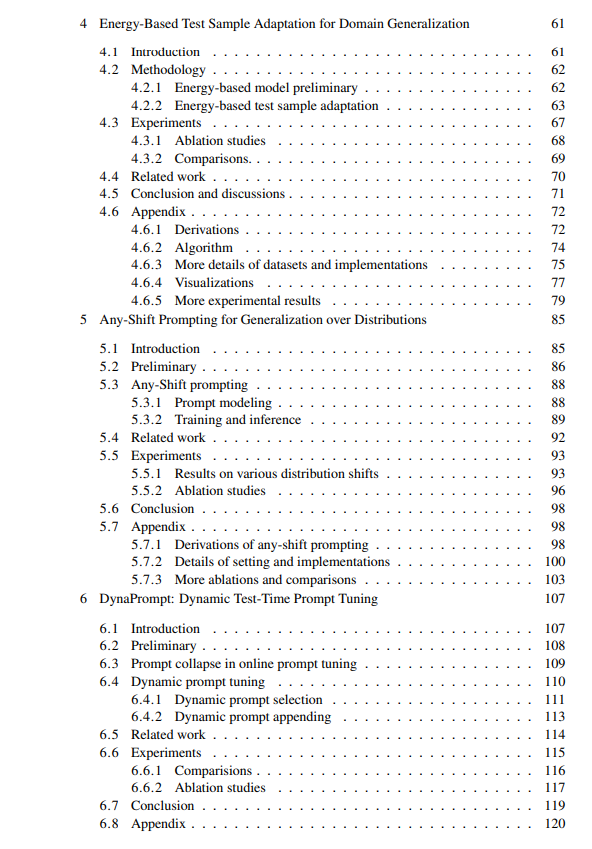

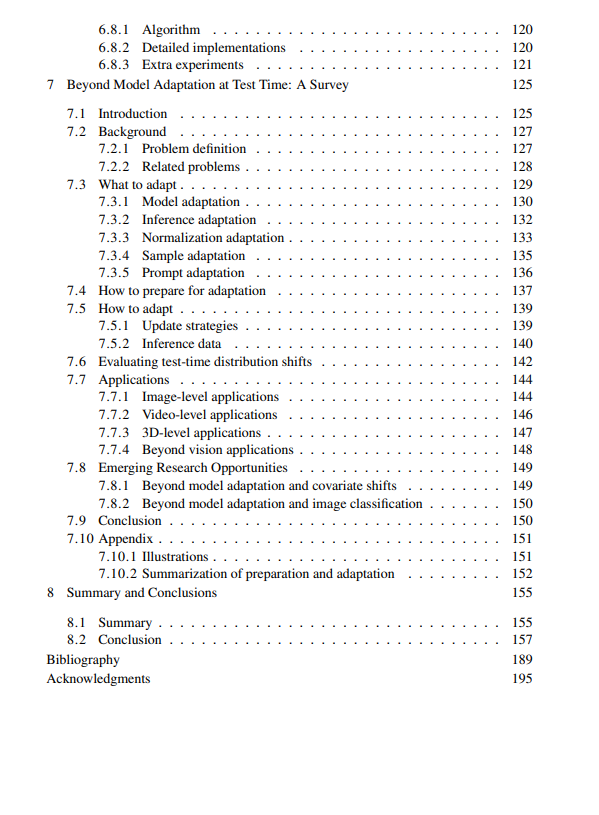

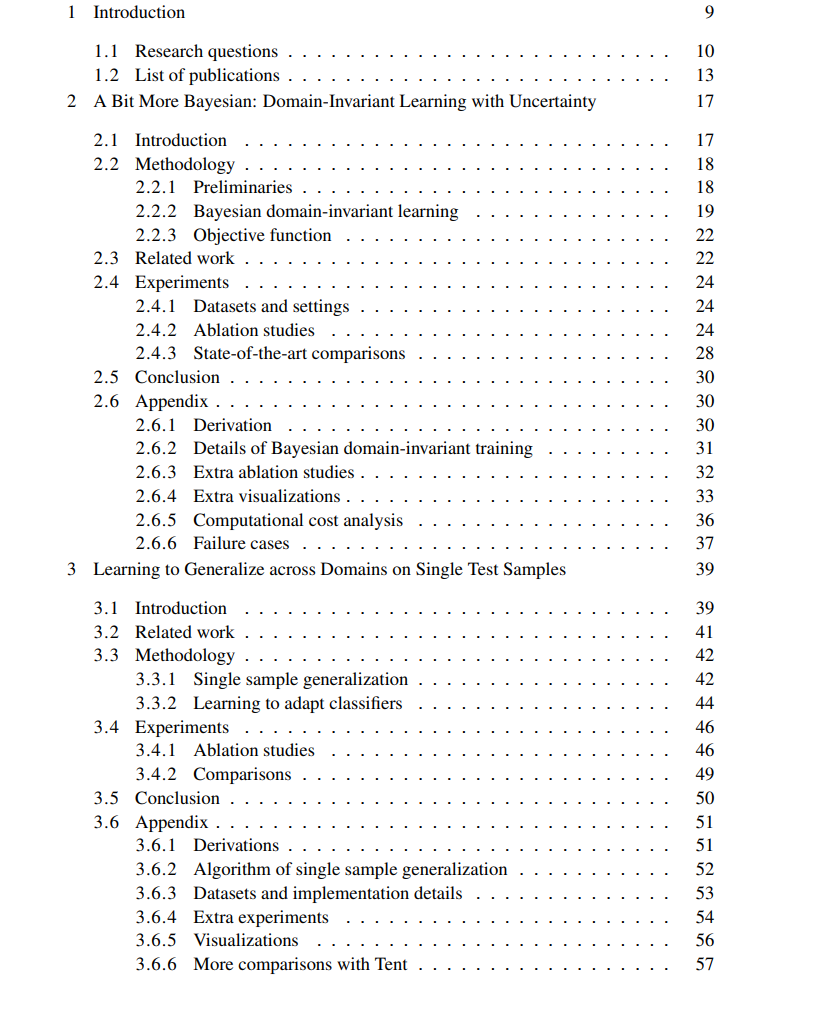

泛化能力,即将从已见上下文中学习到的知识有效应用于陌生情境的能力,是人类智能的重要特征,但对当前的人工智能系统而言仍是一项重大挑战。传统的机器学习算法通常依赖于训练数据与测试数据来自相同分布的假设,因此在面临分布偏移时,其性能往往显著下降。本论文聚焦于提升泛化能力这一关键问题,尤其是在测试时泛化,即在训练阶段无法访问测试数据的前提下提高模型在测试阶段的表现。 本论文的结构如下: 1. 训练阶段的泛化模型学习:通过贝叶斯神经网络中的不变性学习实现更具泛化能力的模型训练; 1. 测试阶段的泛化模型学习:在无标签和无额外测试信息的情况下,利用元学习和变分推断技术,使模型能对每个测试样本直接进行自适应; 1. 测试阶段的泛化样本学习:采用能量模型将测试样本适配至训练分布,以避免调整模型本身,从而规避灾难性遗忘问题; 1. 测试阶段的泛化提示学习(prompt-learning):面向多模态基础模型,设计新颖的提示学习框架,涵盖针对任意类型分布偏移的测试任务专属提示生成,以及用于在线提示更新的动态测试时提示调整方法。

每一章均提出了创新方法,详细介绍了方法论与实验结果,展示了在测试阶段提升泛化能力的全面路径。 最后,论文进一步探讨了测试时泛化的历史与未来,并系统回顾了测试时自适应(Test-Time Adaptation, TTA)领域的研究进展,为测试时泛化的发展提供了全面总结与未来展望。

https://hdl.handle.net/11245.1/a165fad4-684a-4767-9e55-1caa83e59f59

成为VIP会员查看完整内容

相关内容

Arxiv

40+阅读 · 2023年4月19日

Arxiv

210+阅读 · 2023年4月7日

Arxiv

79+阅读 · 2023年4月4日

Arxiv

144+阅读 · 2023年3月29日