尽管有这些见解,大多数机器学习模型仍然使用Groot倡导的单模态监督学习模式进行训练,其中通过标签来训练模型以提取特征。这种模式被用于几乎所有计算机视觉任务的最先进模型中(Bhat et al., 2021; Zhai et al., 2022; Liu et al., 2022a; Li et al., 2022a):对于图像分类,标签是图像所属类别的索引;对于深度估计,使用场景中物体的每像素距离来监督模型的学习。虽然这种方法对于某些任务可能有效,但它存在几个潜在的缺陷。首先,获取足够数量的标记数据既昂贵又耗时。此外,这些算法可能脆弱且容易过拟合,尤其是在处理高维和复杂数据时。它们在处理类别分布不均衡的数据集时也可能会遇到困难(Abd Elrahman and Abraham, 2013; Buda et al., 2018)。最近的研究还揭示了使用监督学习训练的模型容易受到对抗性攻击(Szegedy et al., 2013)、易受简单性偏见的影响(Shah et al., 2020),并且在分布外(OOD)泛化性能较差(Koh et al., 2021; Gulrajani and Lopez-Paz, 2020)。

多模态学习,利用不同模态之间复杂而微妙的关系,可能是解决监督学习挑战的潜在解决方案。除了前面提到的人类学习启示,多模态学习允许模型通过利用不同模态之间的复杂和微妙的关系来学习抽象概念,从而对给定问题或任务有更全面的理解。这可能解决监督学习从简单、潜在噪声和偏见标签中学习时遇到的鲁棒性问题;此外,多模态数据更容易获取且无需人工标注,因为可以简单地利用不同感知模态之间的时间一致性。例如,YouTube上的烹饪教学视频包含三种感知模态:图像(视频)、文本(字幕)和音频(声音轨道)。可以认为这些模态互为标签,不同之处在于这些“标签”更复杂,可能包含输入模态中未包含的信息。 在本论文中,我们研究了从多模态数据中学习表示。由于目标是探索联合嵌入来自多个源数据的好处,我们将“模态”的定义从传统的视觉和语言等感知模态放宽到不同的数据分布,例如狗的素描和真实照片,或同一图像的两个随机增强视图。这使我们能够在多种机器学习设置下研究联合嵌入问题,从领域泛化、自监督学习到视觉-语言生成模型。我们通过生成模型和判别模型展示了从多模态数据中学习的优势,无论是在流行基准测试中的表现还是在泛化等鲁棒性方面;我们还首次提出了多模态深度生成模型的系统需求。此外,受限于我们当时的计算资源和合适的数据集,我们还研究了提高多模态学习数据效率的方法,包括严格使用更少的多模态对和生成多模态数据。接下来,我们介绍本论文在这些不同主题上的贡献如何组织。

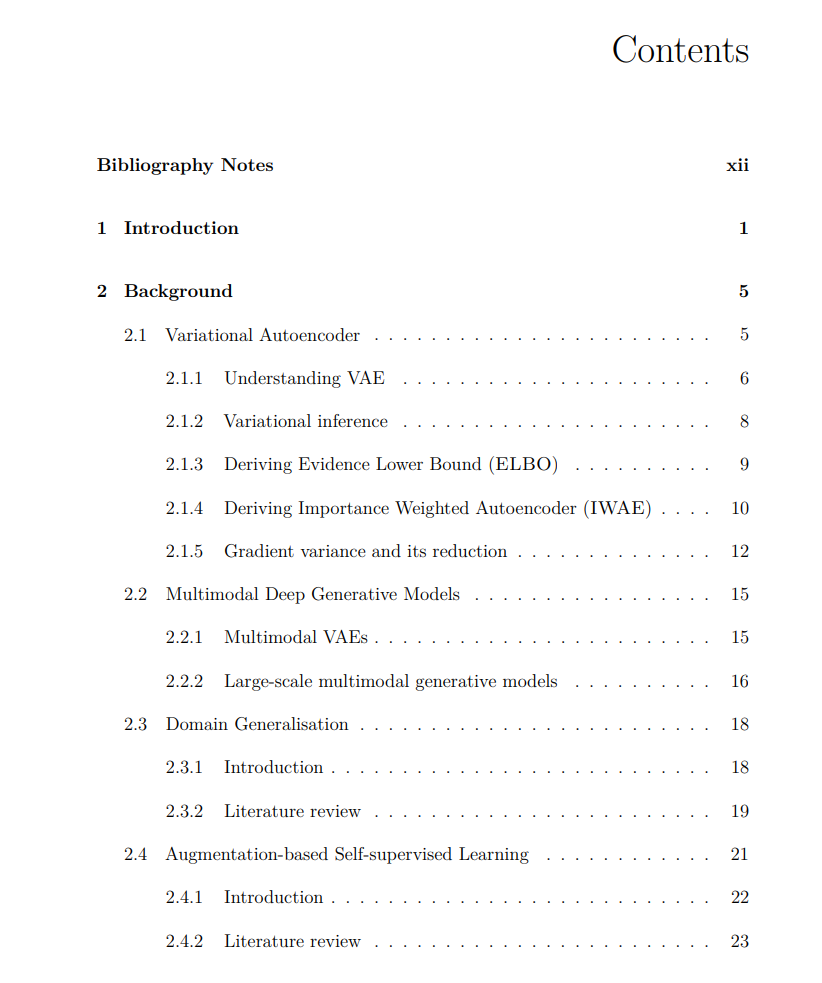

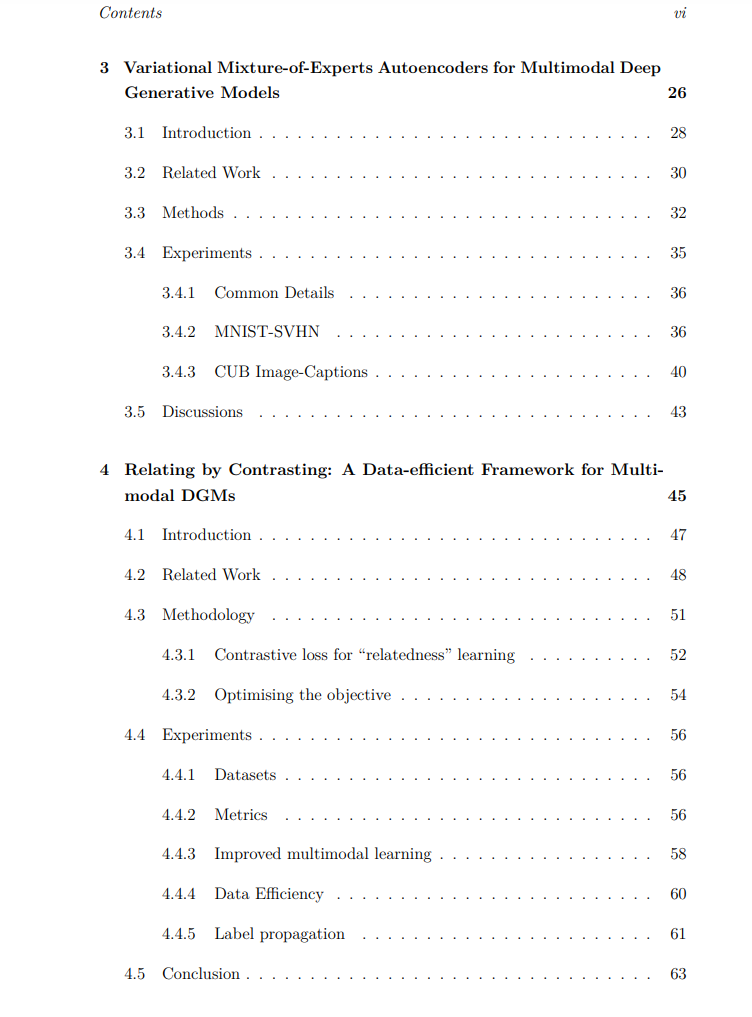

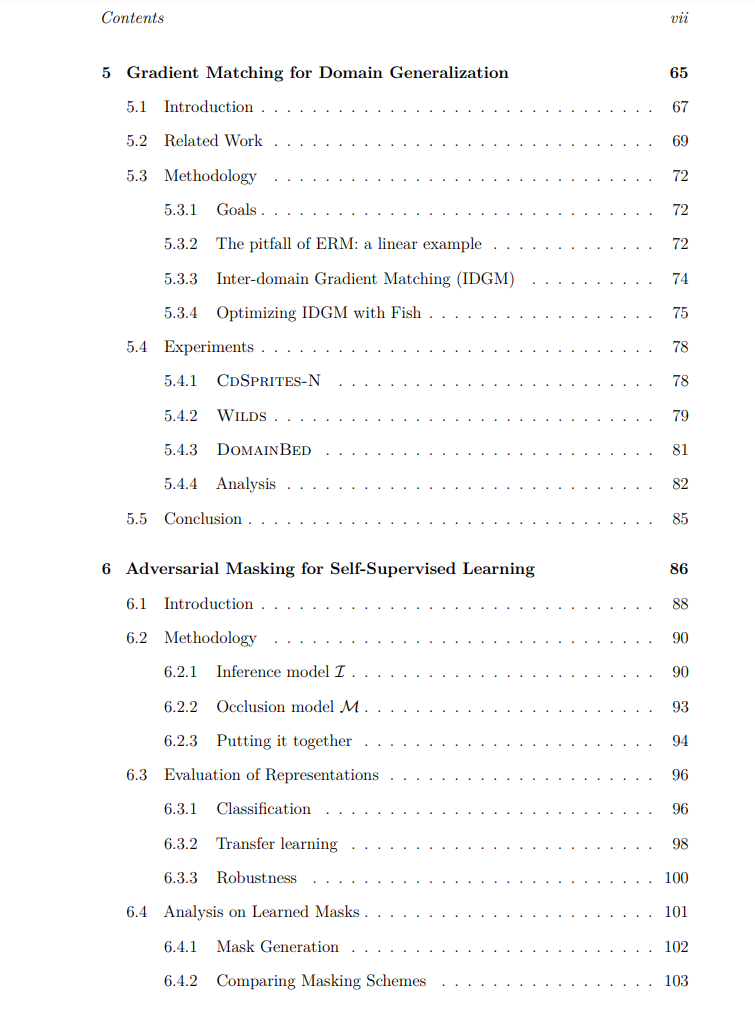

贡献和组织摘要 第2章提供了理解本论文其余部分所需的背景,包括所研究问题的介绍以及全面的文献综述。 在第3章中,我们在生成模型设置下研究多模态学习,提出了一种新的多模态VAE,名为MMVAE,它为其所有输入模态学习高质量、平衡的表示。重要的是,我们的工作是第一个能够在测试时无需辅助组件进行跨模态生成(例如语言→视觉,视觉→语言)的多模态VAE。此外,我们还提出了多模态VAE应满足的四个需求,这些需求现已被多模态VAE领域广泛采用。 第4章继续研究多模态VAE,并着眼于提高此类模型的数据效率。我们提出了一个可用于任何多模态VAE的对比框架,并通过实验证明我们的框架大大减少了达到同一性能水平所需的标记多模态对的数量;请注意,我们将对比目标适配于多模态学习的工作早于CLIP(Radford et al., 2021),在发表时具有新颖性。 在第5章中,我们从判别角度重新审视多模态学习问题,研究领域泛化,即模型必须利用多个源领域之间的共性,以便在未见过的目标领域中表现良好。我们提出了一种名为Fish的方法,通过最大化域间梯度内积来鼓励学习这些共性。 最后,在第6章中,我们研究了自监督学习(SSL),其学习原理可以被认为本质上是“多模态”的,因为学习目标依赖于保持同一图像的两个增强视图之间的共性。我们提出使用对图像编码器生成的对抗性掩码遮蔽一个增强视图,使我们能够遮蔽图像中的完整语义实体,从而从图像编码器中学习到更高质量的表示。 值得注意的是,本论文主体所涵盖的工作研究了三种不同的表示学习机制:基于重构的生成模型(VAE)、监督学习和自监督学习。大多数模型评估遵循标准统计假设,即训练和测试数据来自相同分布。然而,在机器学习模型的部署中,这一假设并不成立。因此,在附录A中,我们研究了这些不同机制的方法如何在未见过的分布中泛化,以评估它们在现实世界中的表现。通过精心设计的实验和评估指标,我们发现令人惊讶的是,特别是自监督学习,在分布变化较大的情况下,泛化效果更好。由于这项工作与论文的多模态主题不太契合,因此我们将其排除在正文之外,感兴趣的读者可参考附录。

相关内容

牛津大学是一所英国研究型大学,也是罗素大学集团、英国“G5超级精英大学”,欧洲顶尖大学科英布拉集团、欧洲研究型大学联盟的核心成员。牛津大学培养了众多社会名人,包括了27位英国首相、60位诺贝尔奖得主以及数十位世界各国的皇室成员和政治领袖。2016年9月,泰晤士高等教育发布了2016-2017年度世界大学排名,其中牛津大学排名第一。