2022 年底,ChatGPT 凭借强大的信息收集和处理能力而爆火“出 圈”,社会上掀起了对人工智能技术发展和应用风险的热烈讨论。这 其中不乏对ChatGPT在军事上对作战行动影响的讨论。2023年3月14日, 俄罗斯的一架苏 -27 战斗机与一架美军地 MQ-9“死神”无人机发生 碰撞,美军无人机受损并最终坠入黑海海域。该事件似乎验证了关于 未来战场有人和无人装备将更加频繁互动的观点。这在一定程度上强 化了国际社会对自主武器和人工智能军事化开展全球安全治理的关切 和推动意愿。有鉴于人工智能军事化风险及其全球安全治理的讨论已 成为一项热点话题,本文将重点分析人工智能全球安全治理的发展趋 势,并结合近期荷兰主办全球军事领域负责任的人工智能峰会的主要观点进行评论.

一、人工智能全球安全治理的演进与挑战

随着人们对以致命性自主武器为代表的无人装备的安全担忧日 甚,国际社会对管控相关技术的意愿愈发迫切。从当前的全球安全治 理主张来看,有一些人极力推崇达成一项全面禁止致命性自主武器的 国际协议;另一些人则认为应当确立武器研发、部署和使用的“良好实践”。在全球安全治理路径争论不休的情况下,美欧等发达国家却 把“软规则”建构视作建立自身发展优势的工具,利用其在治理机制 中的主导地位建构排华“小圈子”。与此同时,推动人工智能安全治 理的知识生产面临着供给不均衡、不充足的挑战。

(一)取向多元化:对致命性自主武器进行管控争论不休 国际社会在如何管控致命性自主武器的议题上出现了“全面禁 止”和“有限发展”的尖锐分歧。一方面,较为激进的观点主张全面 禁止致命性自主武器的研发、部署和应用。人权观察组织、红十字国 际委员会等国际组织不断发布研究报告,期望在国际社会形成禁止致 命性自主武器的舆论压力。b 它们呼吁能够倡导达成一项具有约束力 的国际条约,尽早对致命性自主武器开启严格的军备控制。在 2022 年 7 月的《特定常规武器公约》政府专家会议上,阿根廷等十个人工 技术弱国坚定地反对在国际场合讨论军事无人化的好处,联合发布了 禁止致命性自主武器的路线图,这预示着中小国家将形成强化全面禁 武主张的核心阵营。它们强调要尽早采取的预防措施是禁止发展、交 易、部署和使用致命自主武器,从而彻底排除自主武器系统对人类造 成巨大伤害的可能性。

另一方面,美国拉拢盟友在 2022 年 7 月的《特定常规武器公约》 政府专家会议上发布《致命自主武器系统领域新兴技术的原则和良 好实践》,提出武器发展的全生命周期只要符合相关规制便是所谓的 “良好实践”。发达国家联盟强调“良好实践”的原因是,它们认为完全自主的致命性自主武器还没有出现,当前的致命性自主武器处在 “有意义的人类控制”之下,就算致命性自主武器还存在一些技术风 险,这些风险也会随着科技的进步而得到缓解。d 上述针锋相对的立 场呈现出国际社会对规制致命性自主武器不同的路径和最终指向,而 这种分歧恐怕在短期内是难以化解的。

(二)机制集团化:全球安全治理结构正趋向西方主导的政治 “中心化”

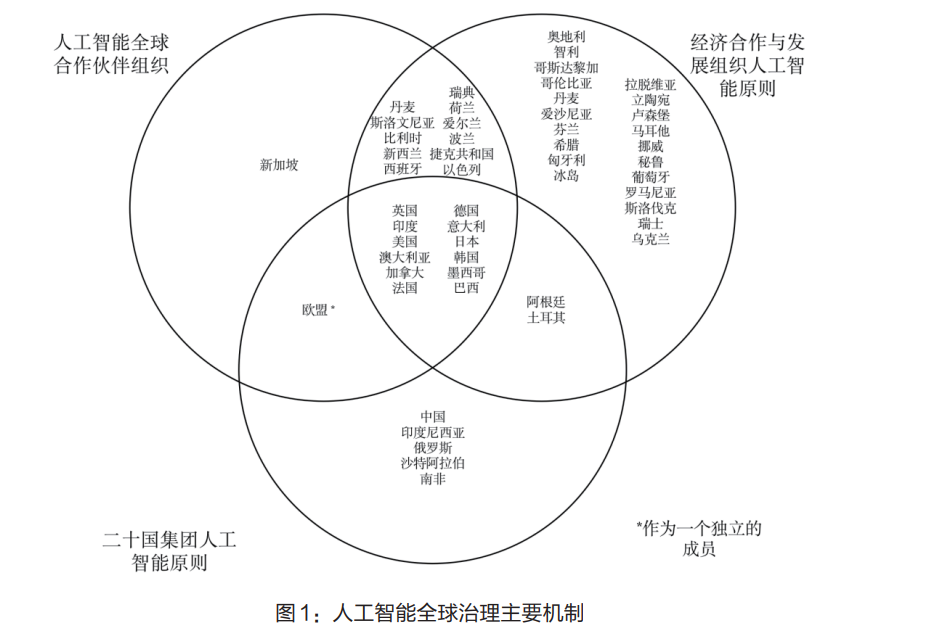

经济与合作发展组织、二十国集团以及人工智能全球伙伴组织是 具有一定代表性的人工智能安全治理多边机制。从图 1 可看出,七国 集团成员、澳大利亚、印度等等是这三个国际论坛的核心成员,中国 与俄罗斯两个大国只是“二十国集团人工智能原则”的参与国。尽管“中心化”的国际治理结构更有利于反应某些国家的关切、凝聚中心 参与者的共识,但是这难免会让其他成员的治理主张边缘化。尤其是 处于核心地位的美国正利用其在国际平台中的“核心地位”打造民主 / 威权集团对抗的治理结构,增加了不同成员推动人工智能全球安全 治理合作的困难。 一是把美国的价值观嵌入“二十国集团人工智能原则”的文本 中。2019 年 5 月,经济合作与发展组织公布了经多个国家和国际组织 研讨后的人工智能原则建议。在该原则通过后,特朗普政府的白宫首 席技术官迈克尔·科雷特西奥斯(Michael Kratsios)指出,“历史上第 一次,美国和世界上志同道合的民主国家将致力于共同的人工智能原 则,来反映我们共同的价值观和优先事项。”e 从结果来看,经济合作 与发展组织人工智能原则的最终文本基本与《美国人工智能倡议》行 政令的基调一致。f 该原则建议后被二十国集团正式采纳为其人工智 能原则。 二是美国加强与北约就人工智能军事应用的协调,逐步吸收新 兴经济体并完善五眼联盟、四边安全对话、“人工智能国防伙伴关系” 等机制,不断将人工智能议题纳入到遏华的亚太“小多边”安全体系 中。这些行动的官方基调是西方需要共同捍卫芯片供应链安全,确保 标准制定权不落入中国手中,以及协调集体安全军事安全行动。北约 人工智能战略着力推动人工智能互操作性、技术标准对接、人力资本 发展等;五眼联盟成员将制定解决人工智能应用和互操作性的方法, 包括与北约一起搭建测试和应用人工智能的平台;四边安全对话将在 美国、日本、印度、澳大利亚四方合作框架的基础上深化人工智能合 作,并在印度 - 太平洋地区谈判达成正式的人工智能合作协议。由此来看,美国正将人工智能治理议题安全化,将盟友推上新一轮军事竞 争和规则制定权争夺的轨道。

三是美国聚拢西方国家搞排斥中国的新制度,拉拢盟友力推“人 工智能全球合作伙伴”,肆意制造“中国滥用人工智能技术”的论调 和阵营对抗。七国集团在 2016 年 4 月的信息通信技术(ICT)部长会 议讨论了人工智能技术及应用监管议题。从 2016 年到 2019 年,七国 集团(G7)以人工智能负责任应用及监管为核心的议题逐渐成熟。法 国和加拿大倡议组建工作小组,并希望在 2020 年初正式启动人工智 能全球合作伙伴(GPAI)。g 白宫官员则对此方案持保留意见,强调 该计划过度谨慎的监管规则会威胁和妨碍技术发展,并且认为经济合 作与发展组织已经建立专家组并向成员国提供政策建议,所以人工智 能全球合作伙伴是在重复经济合作与发展组织的工作。h 法国数字事 务部长塞德里克·奥(Cédric O) 试图说服迈克尔·克拉西奥斯,表示, “如果你不希望西方国家采用中国模式,比如用人工智能来控制人口, 你就需要建立一些普遍的规则。但这只针对一个国家”。考虑到继续 反对该计划恐将让美国在西方集团内失去人工智能治理的规则主导 权,而加入其中则可以借此扭曲中国的人工智能应用,美国最终决定 支持启动人工智能全球合作伙伴。 (三)知识供给匮乏:人工智能安全治理知识供给不均衡、不充足 先进人工智能技术的创新和大规模应用集中于少数大国。全球人 工智能的研究在 2020-2021 年间共出版 17 万本期刊论文和七万部会议 论文,中国、美国、欧盟和英国的出版物占据了其中的绝大多数。纵观全球军用人工智能发展格局,有能力大规模研发、制造、部署和 使用先进军用人工智能也只有大国。或许,从人工智能技术在俄乌冲 突中的应用、伊朗核科学家和苏莱曼尼将军被“定点清除”、无人机 助力阿塞拜疆取得“纳卡冲突”制空权等战例来看,相关武器的购买 成本不是高不可攀。但是,大国在开发和评估新武器系统方面有更强 大的能力,而弱国采购进行评估和创新的能力较弱。仅从目标识别环 节来看,军用人工智能系统需要一个国家有强大的情报侦察能力以提 供规模大和质量好的数据。而拥有更多的研发资金、科研人力和实战 化训练的大国能够比中小国家获取更多、更好的战场数据。因此,大 国可以开发出更加先进的算法和硬件。这意味着中小国家推动军备智 能化升级和技术评估的天花板要低于大国,它们的人工智能安全治理 的知识积累要弱于强国。