视觉-语言模型的迅速扩展需要大量资源,包括计算和数据。越来越多的人对高效训练这些模型并将它们用于各种下游任务产生了兴趣。本论文提出了几项旨在提高视觉-语言模型训练中的学习和数据效率的贡献,并阐明了如何在下游任务中利用它们。论文围绕三个关键领域展开:

-

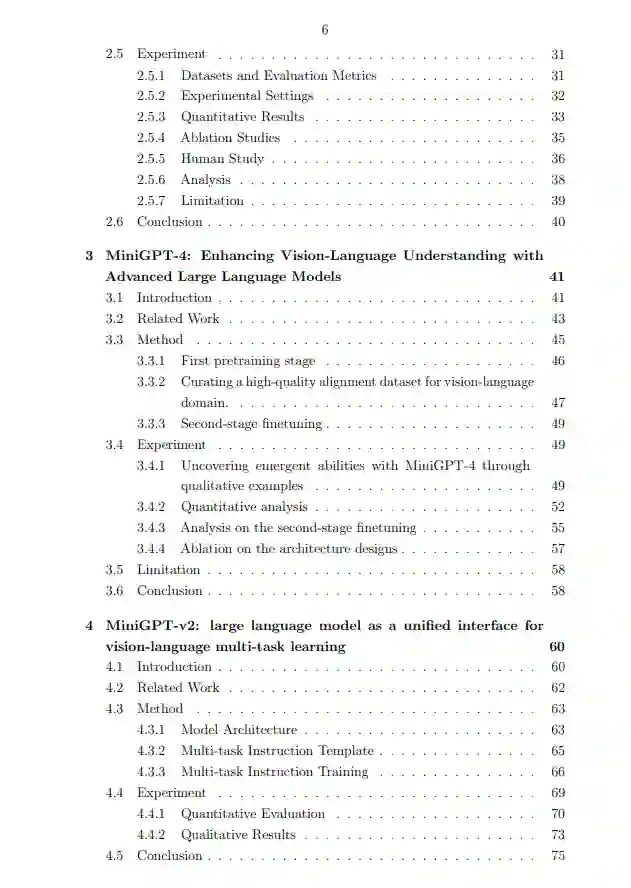

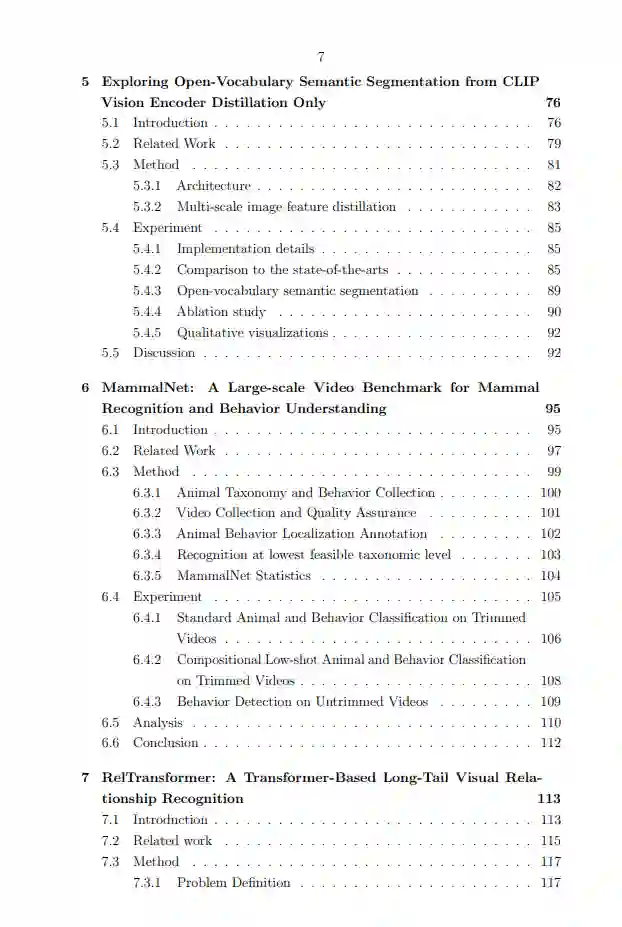

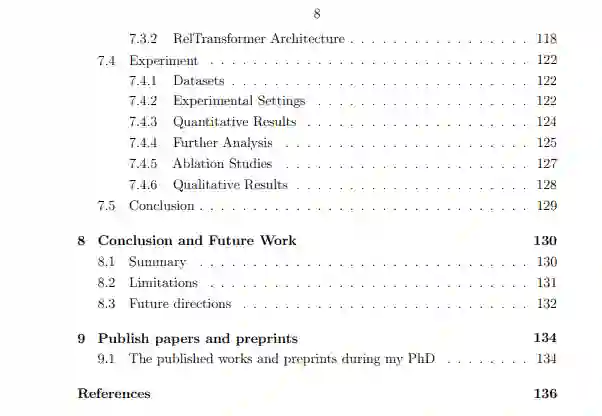

学习高效的视觉-语言基础模型:本节讨论了VisualGPT,这是一个数据高效的图像描述模型,探讨了如何有效地将预训练的语言模型整合到视觉-语言模型中。它还涵盖了MiniGPT-4,旨在将先进的大型语言模型技术应用于视觉-语言模型,从而增强它们的能力。此外,还介绍了MiniGPT-v2,它使大型语言模型能够作为一个通用界面,统一多种视觉-语言任务。

-

学习高效的视觉-语言模型,用于开放和长尾感知任务:这部分包括ZeroSeg,它研究了如何高效地将从CLIP视觉编码器中学到的视觉-语言概念转移到开放词汇的语义分割中,而无需像素级监督。它还研究了RelTransformer,通过利用局部、全局和增强的记忆层次的视觉上下文来识别长尾视觉关系。

-

在开发更高效的视频-语言理解模型中的数据贡献:本节介绍了一个大规模的视频数据集,重点是复合性地识别动物及其行为。对这些模型进行广泛的评估,与常见基准相比显示出显著的进步。这些发现对于视觉-语言模型中高效学习的持续发展有所贡献。这些洞见和方法论旨在加速实际应用,并为未来在视觉-语言领域的研究奠定基础。

成为VIP会员查看完整内容

相关内容

Arxiv

87+阅读 · 2023年4月4日

Arxiv

153+阅读 · 2023年3月29日