机器学习领域见证了对从未整理数据中学习的日益浓厚的兴趣,这涉及从未经精心整理或标记的数据中训练模型。然而,这种类型的数据通常嘈杂、不完整,并充斥着错误,使得机器学习算法难以有效学习。本论文关注于开发能够有效利用未整理数据同时对数据中固有的噪声和错误具有韧性的强健学习方法。具体来说,我们调查了对比学习的韧性,这是一种通过比较语义上相似和不同的样本对的自监督表示学习的突出技术。 首先,我们深入探讨了从未标记数据中学习所固有的基本挑战。我们发现,消除假阴性和鼓励困难的负面案例显著提高了下游性能和训练效率。随后,我们将焦点转移到数据集内无处不在的噪声。我们特别关注于假阳性对的出现,这是多模态对比学习环境中特别普遍的现象。

在我们研究的最后部分,我们思考了从大规模模型中有效地消除偏见。观察到,当模型在有偏见的未整理数据上进行预训练时,它们通常会继承许多不适当的偏见,从而导致倾斜的预测。为了纠正这一点,我们设计了一种独立于任何数据或训练要求的去偏算法。

贯穿整篇论文的共同线索是对未标记、嘈杂和有偏见数据分别所关联的独特错误类型的韧性和全面的缓解方法,为机器学习研究领域提供了实质性的贡献。

近年来,机器学习取得了显著进展,尤其是在使用标记数据训练模型的监督学习领域。然而,获取大量标记数据可能是一个成本高昂且耗时的过程,这促使越来越多的人对从未整理数据中学习产生了兴趣。 未整理数据指的是那些未经仔细整理或标记的数据,这些数据通常包含噪音,不完整且包含错误。从这类数据中学习对机器学习算法来说是一个重大挑战,因为它们必须能够有效利用可用信息,同时对固有的噪声和错误具有韧性。本论文关注于以下基本目标:能够从未整理数据中学习的强健学习算法。 为了实现这一目标,我分析了对比学习,这是一种通过比较语义上相似和不同的样本对来进行自监督表示学习的突出技术[24, 81, 147]。传统上,监督学习一直是人工智能(AI)进步的基石,依赖大量的标记数据来训练模型。然而,收集和标记如此大量的数据可能既昂贵又耗时。此外,在现实世界的应用中,标记数据往往稀缺甚至无法获得。为了克服这些障碍,研究人员转向使用无标记数据的无监督和自监督学习技术来训练模型。然而,这些技术在性能上通常落后于监督方法,主要是因为定义引导模型走向有用表示的目标很困难。 对比学习就在这里发挥了作用。通过设定目标,将语义上相似(正面)和不同(负面)的数据点对在学习到的特征空间中拉近或推远,对比学习提供了一种从无标记数据构建有用且富有信息的表示的方法。对比学习在包括计算机视觉、自然语言处理、图表示学习和强化学习等多个领域的能力已被证明,实现了许多基准测试中的最先进性能。

本论文解决了上述瓶颈问题,分为三个部分:第一部分:从未标记数据中学习,第二部分:从嘈杂数据中学习,第三部分:从有偏见的数据中学习。

在第一部分,我解决了负样本的两个关键问题:假负样本和困难负样本。我们首先在第2章提供问题形式化和对比学习的背景。在第3章中,基于Chuang等人的研究[36],我用一种新的对比损失解决了假负样本的问题。然后在第4章,基于Robinson等人的研究[163],我们通过重要性采样估计扩展了提出的损失,包括困难负样本采样。

在第二部分,我将揭示假阳性样本的问题,特别是在多模态环境中,并开发针对它的强健损失函数。在第5章中,基于Chuang等人的研究[39],我将对比学习与二元分类联系起来,并为对比损失开发强健的损失函数。第6章提供了所提出损失的理论基础,即Wasserstein互信息的变分下界。

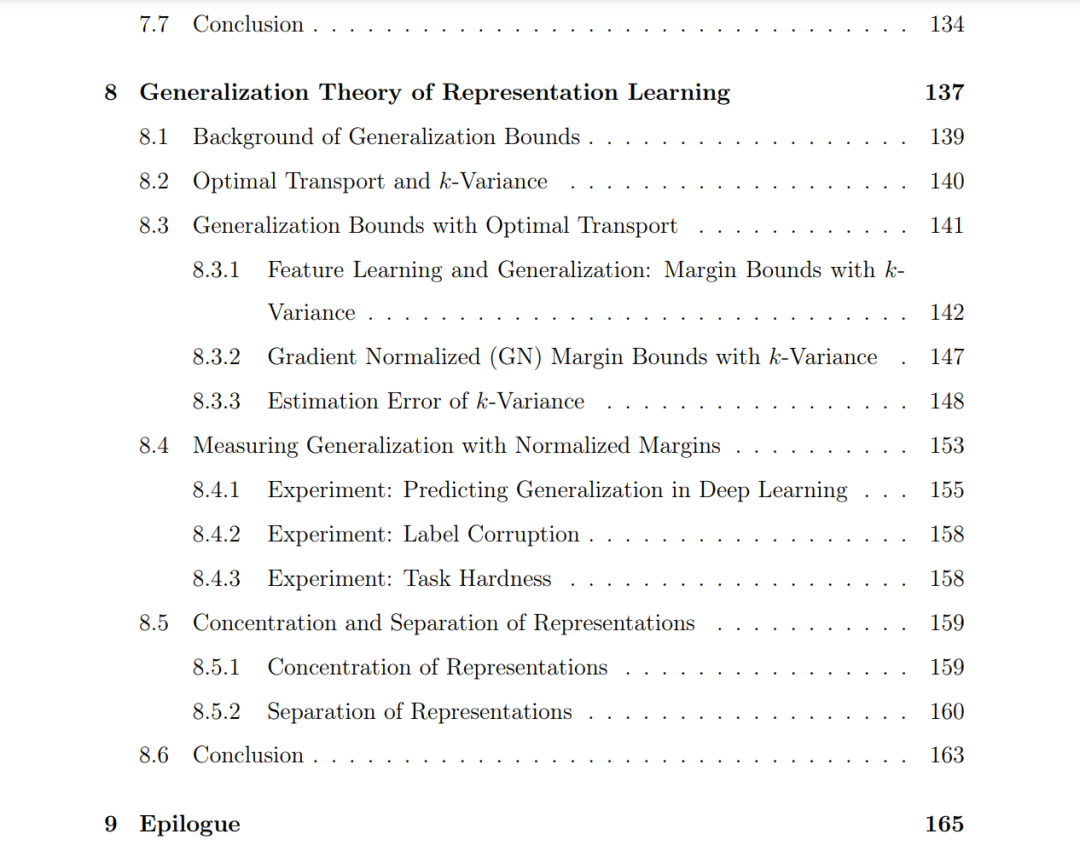

在第三部分,我将讨论如何消除大规模基础模型中的偏见,基于Chuang等人的研究[40]。第7章概述了基础模型的兴起,并提出了一种去偏算法,以高效地消除视觉-语言基础模型的偏见。 第8章建立了表示学习与泛化理论之间的联系,使用边界界限,从而为对比学习提供了理论验证。作为结语,第9章总结了本论文,并进行了一些讨论。