1 引言

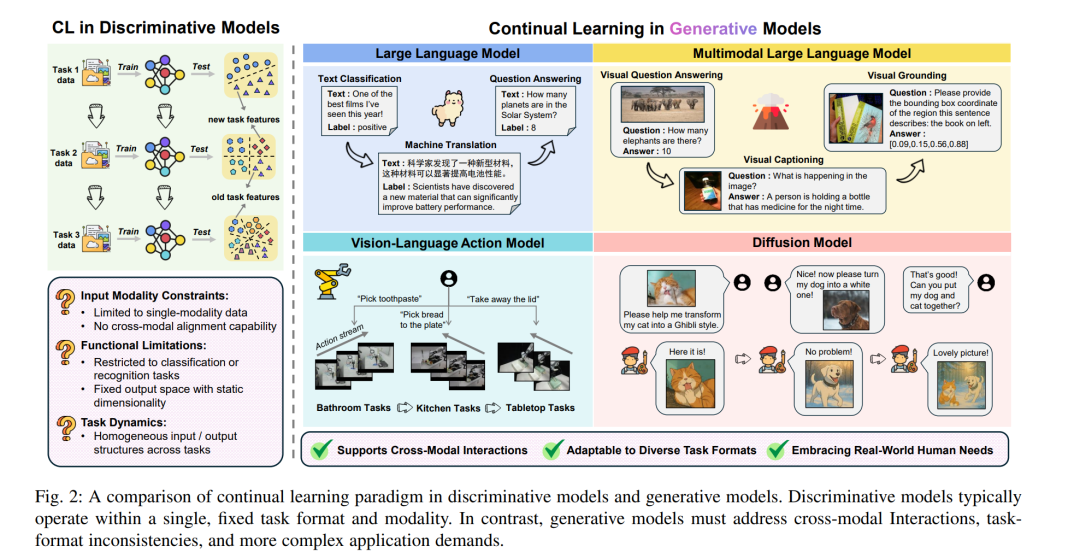

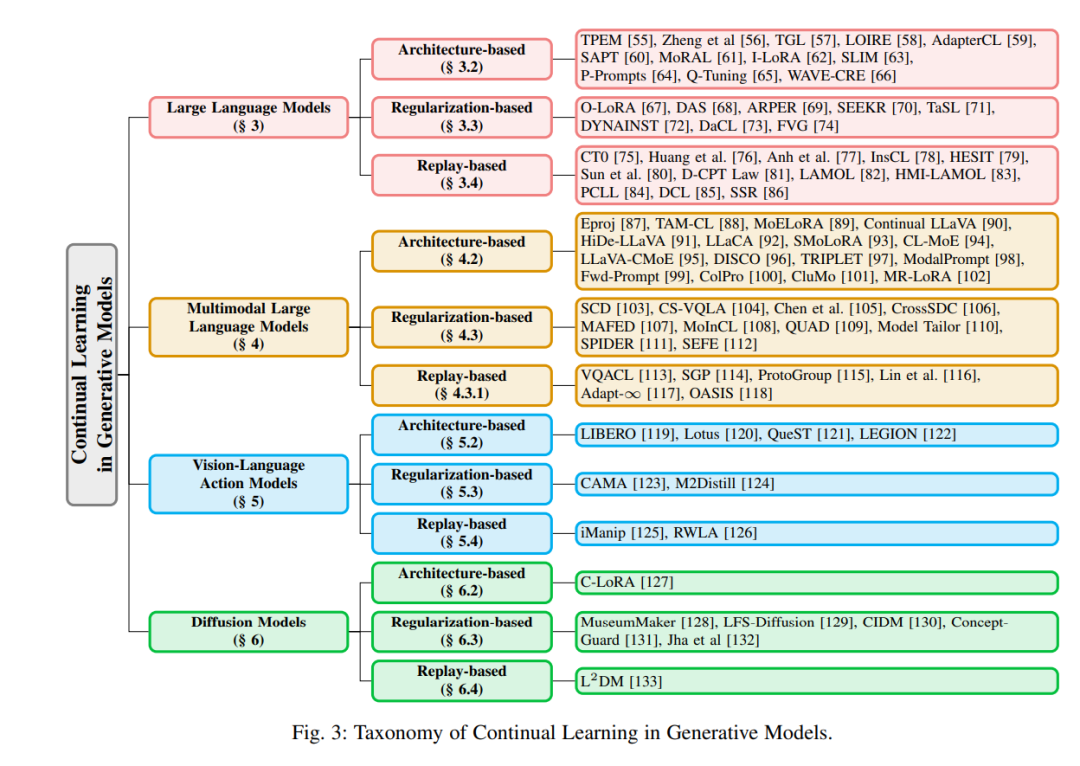

人工智能的发展正经历着从“理解世界”向“创造世界”的范式转变。传统的判别式模型,如分类网络 [1]–[6] 和目标检测器 [7]–[11],在过去十年中取得了显著的成功。这些模型擅长从大规模标注数据中学习决策边界,从而实现对已知概念的准确识别和判断。然而,这种基于判别的智能在创造性和泛化能力方面存在局限。它们在单一模态下对已知概念的区分能力突出,但在生成新颖内容以及在多模态之间建立语义关联方面却表现乏力。 生成模型的兴起有效弥补了这些不足,它们通过大规模预训练以捕捉数据的底层分布。由此,主流生成模型(如大语言模型 LLMs [12]–[14]、多模态大语言模型 MLLMs [15]–[19]、视觉-语言-动作模型 VLA [20], [21] 以及扩散模型 [22], [23])不仅能够解释输入特征,还能主动生成连贯的文本、逼真的图像,甚至跨模态内容。随着研究范式从判别式向生成式转变,人工智能正从“识别已知”进化为“创造未知”。这一转变正重新定义人机协作的基础,使生成能力更具表达性、灵活性和多模态性。 生成模型(如 GPT-4)的成功在根本上依赖于大规模预训练和人类对齐。然而,这一过程本质上是动态的,因为语言、数据分布和用户需求不断演化。更关键的是,不可能穷尽未来所有场景,这就要求模型具备持续学习(Continual Learning)的能力(如图 1 所示),以适应开放世界环境 [24]–[26]。例如,将通用模型(如 ChatGPT)微调于特定领域数据(如数学)时,尽管在目标任务上表现提升,但常常伴随着灾难性遗忘 [27]–[29] —— 即先前知识被迅速覆盖。当模型在多个下游任务上按序训练时,每一次更新都会进一步加剧灾难性遗忘,导致知识保持能力持续下降。 一个直接的解决方案是保留所有历史任务数据,并在学习新任务时进行联合训练。但由于存储成本高昂 [30] 或数据隐私问题 [31],该方案在现实中往往不可行。相比之下,人类在习得新知识时很少遭遇灾难性遗忘 [32], [33],这揭示了当前 AI 系统与人类学习能力之间的根本差距。为了弥合这一差距,持续学习作为研究方向 [34]–[38] 正受到越来越多关注,目标是使模型具备在不遗忘旧知识的前提下持续学习新任务的能力。 不同于传统判别式模型 [39],生成模型中的持续学习更加复杂。一方面,判别式模型主要建模条件概率(即 P(y|x)),灾难性遗忘主要表现为分类空间中决策边界的漂移 [40]–[44];而生成模型则学习联合概率分布(即 P(x, y)),或进行自回归生成,要求在开放生成空间中保持语义连贯性与知识完整性。因此,持续学习不仅要维护事实性知识表示,还需优化生成推理过程,以缓解幻觉现象 [45], [46] 和语义不一致 [47]。 另一方面,生成模型面临的任务形式更加多样,例如在多模态大语言模型(MLLMs)中涵盖视觉问答、图像描述、视觉指向等多种任务,这增加了灾难性遗忘的风险,并对多任务知识整合提出更高要求。相比之下,判别式模型通常聚焦于单一任务,持续学习难度相对较小。此外,生成模型涉及多模态输入,要求跨模态协调,传统面向单模态任务的持续学习方法往往难以胜任这些挑战。图 2 所示的这些挑战表明,生成模型中的持续学习仍是人工智能领域一个充满前景却尚未充分探索的研究方向。 目前的持续学习综述大多聚焦于某一类生成模型,如大语言模型(LLMs)[48]–[51] 或多模态大语言模型(MLLMs)[52]–[54]。尽管这些研究在各自领域内系统总结了相关方法,但缺乏跨生成模型的广泛讨论与关联。考虑到 AI 社区对生成模型与大规模统一模型研究热度的持续上升,我们认为,一篇全面、及时的综述有助于从整体视角指导后续研究。 因此,本文提出了首个面向生成模型的持续学习综合综述,系统分析了大语言模型、多模态大语言模型、视觉-语言-动作模型以及扩散模型中持续学习的关键方法与挑战。我们进一步在持续学习背景下,从方法维度对这四类生成模型进行了统一分析,探索其共同的理论基础。 本论文结构如下:第 2 节介绍持续学习的基本设置,包括基本定义、评估指标及方法分类;第 3 至第 6 节分别深入探讨大语言模型(第 3 节)、多模态大语言模型(第 4 节)、视觉-语言-动作模型(第 5 节)以及扩散模型(第 6 节)中的持续学习问题,包括训练策略、常用基准、模型架构,以及现有方法的动机与实现。第 7 节展望未来研究方向与新兴趋势。最后,第 8 节总结全文并介绍一个持续更新的 GitHub 项目库,用于追踪生成模型持续学习领域的最新进展。