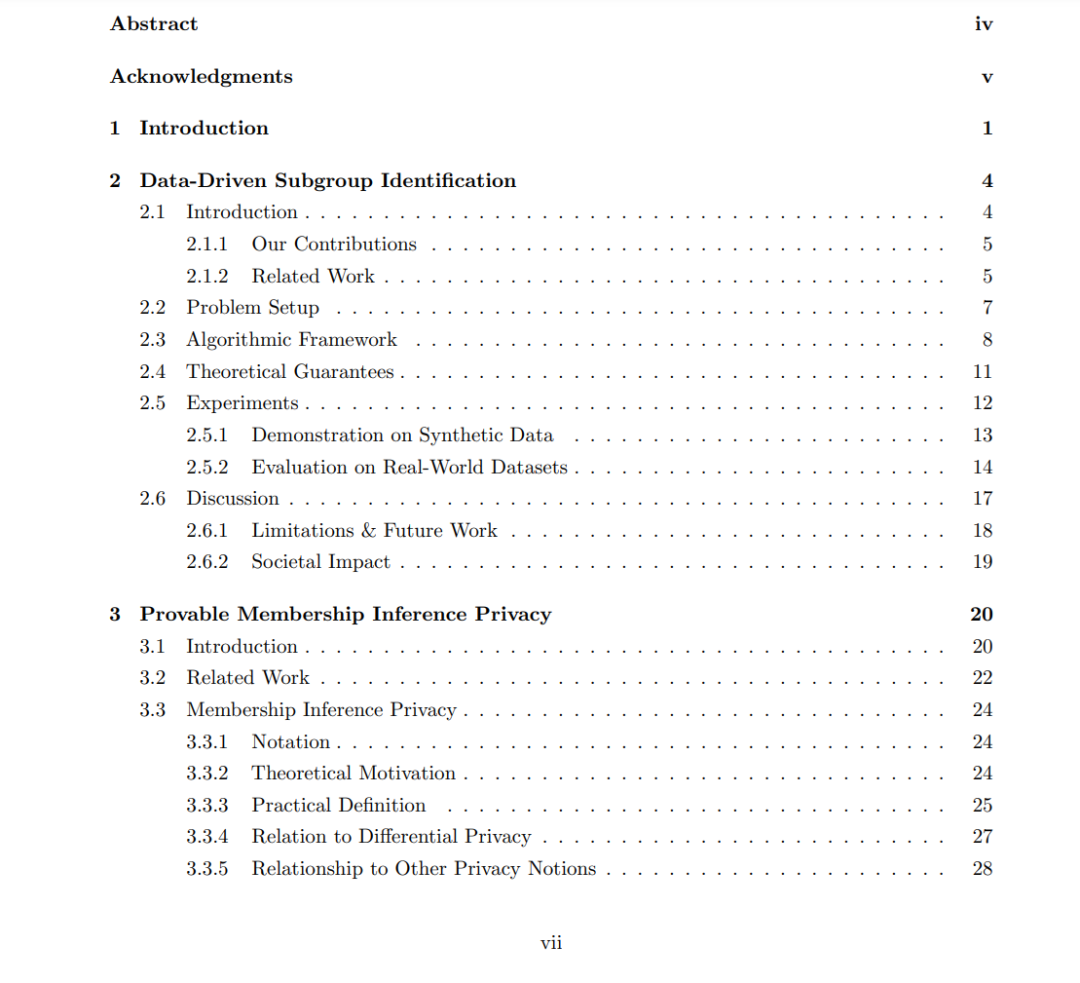

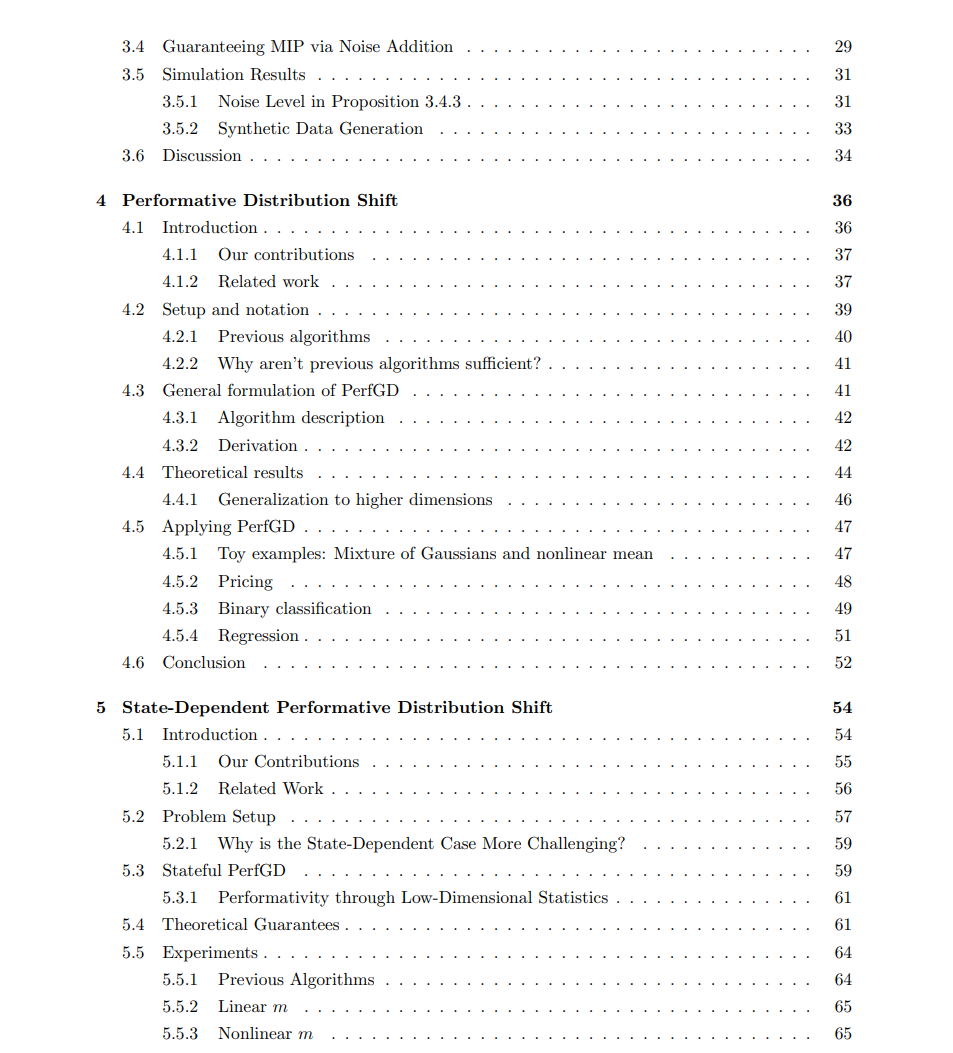

机器学习(ML)和人工智能(AI)在各种领域取得了卓越的、超越人类水平的表现:计算机视觉、自然语言处理和蛋白质折叠等等。直到最近,大多数进展都采用了一种以模型为中心的方法,主要关注于改进神经网络架构(如ConvNets、ResNets、transformers等)以及用于训练这些模型的优化过程(如批归一化、丢弃、神经结构搜索等)。相对较少的注意力被付在了用于训练这些模型的数据上,尽管众所周知,ML在高质量数据上具有关键依赖性,用“垃圾进,垃圾出”这个短语来简洁地表达这一事实。随着越来越大型和更复杂的模型的回报逐渐减小(如Nvidia和微软的MT-NLG模型具有5300亿参数),研究人员开始意识到采取以数据为中心的方法以及开发研究这些模型的燃料——数据本身的原则性方法的重要性。

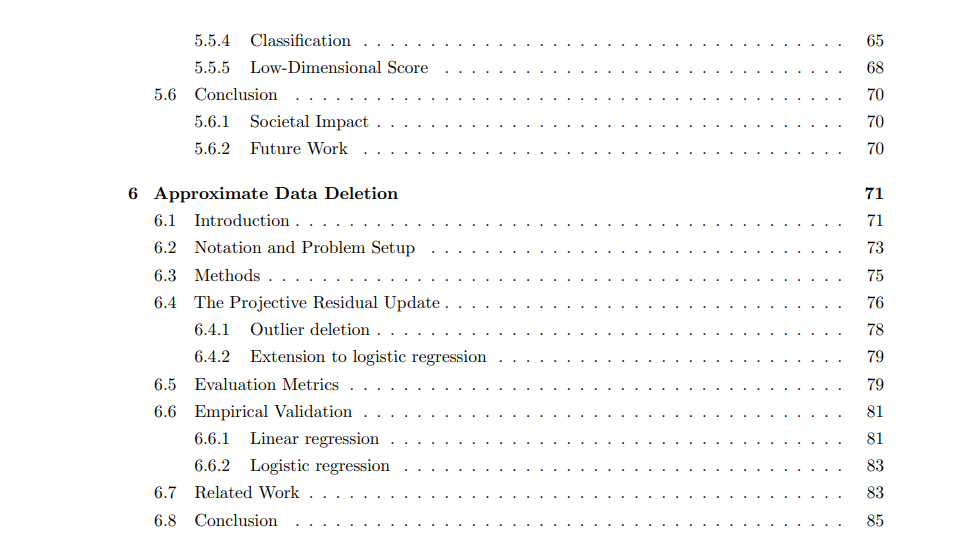

除了提高任务性能外,以数据为中心的视角还使我们能够考虑到社会关键因素,如数据隐私。在这篇论文中,我们将对ML数据管道中的几个关键点进行批判性审视:模型训练之前、期间和之后。在模型训练之前,我们将探讨数据选择的问题:应该使用哪些数据来训练模型,我们期望模型在什么类型的数据上工作?随着我们进入模型训练,我们将关注与我们的ML系统与其部署环境的交互作用可能导致的两个问题。第一个问题是数据隐私:我们如何防止我们的模型泄露有关其训练数据的敏感信息?第二个问题涉及某些被建模群体的动态性质。特别是当我们的模型用于做出对社会有影响的决策(如自动贷款批准或推荐系统)时,模型本身可能会影响数据的分布,从而导致性能下降。最后,尽管在模型训练之前和之间遵循最佳实践,但可能会出现我们希望在训练后删除某些数据影响的情况。如何以计算有效的方式实现这一点?这篇论文涵盖了每个前述问题的新颖解决方案,重点强调了每个提出的算法的可证保证。通过将数学严谨性应用于具有挑战性的现实问题,我们可以开发出既有效又可信赖的算法。