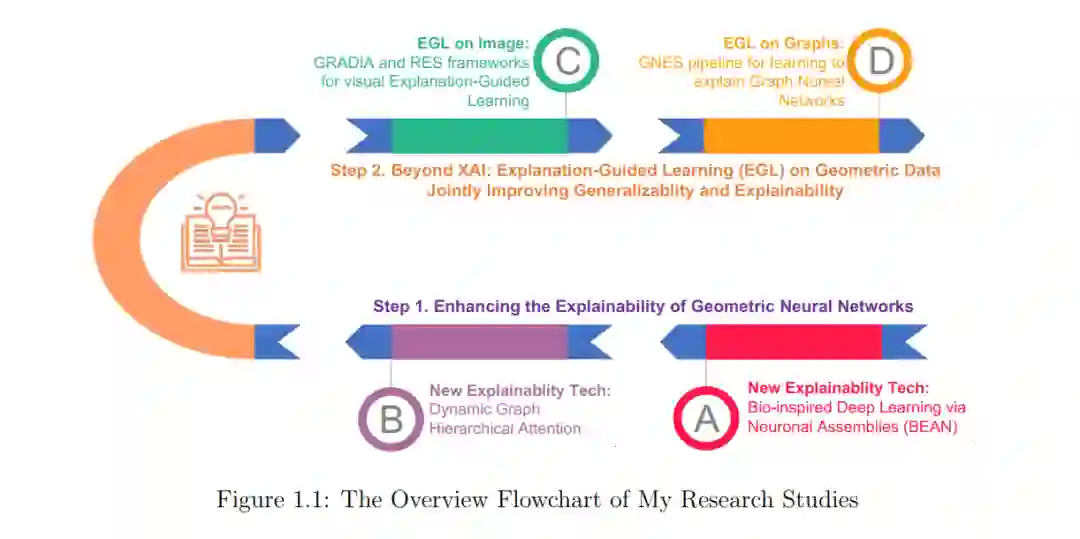

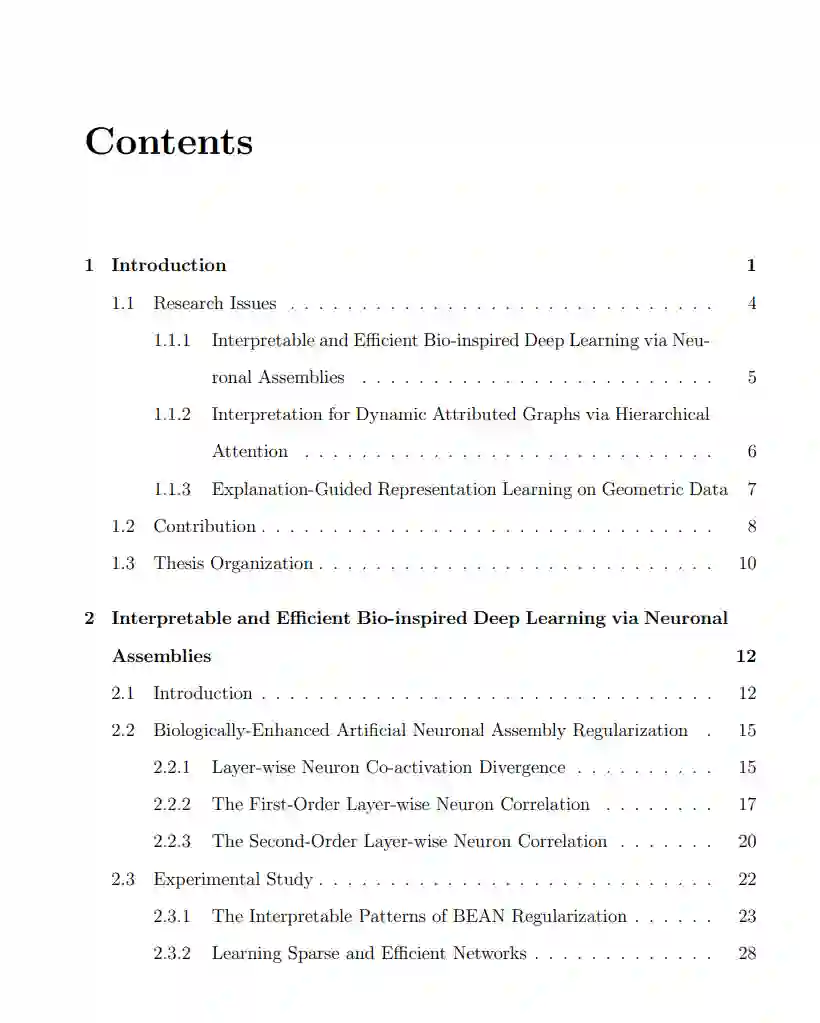

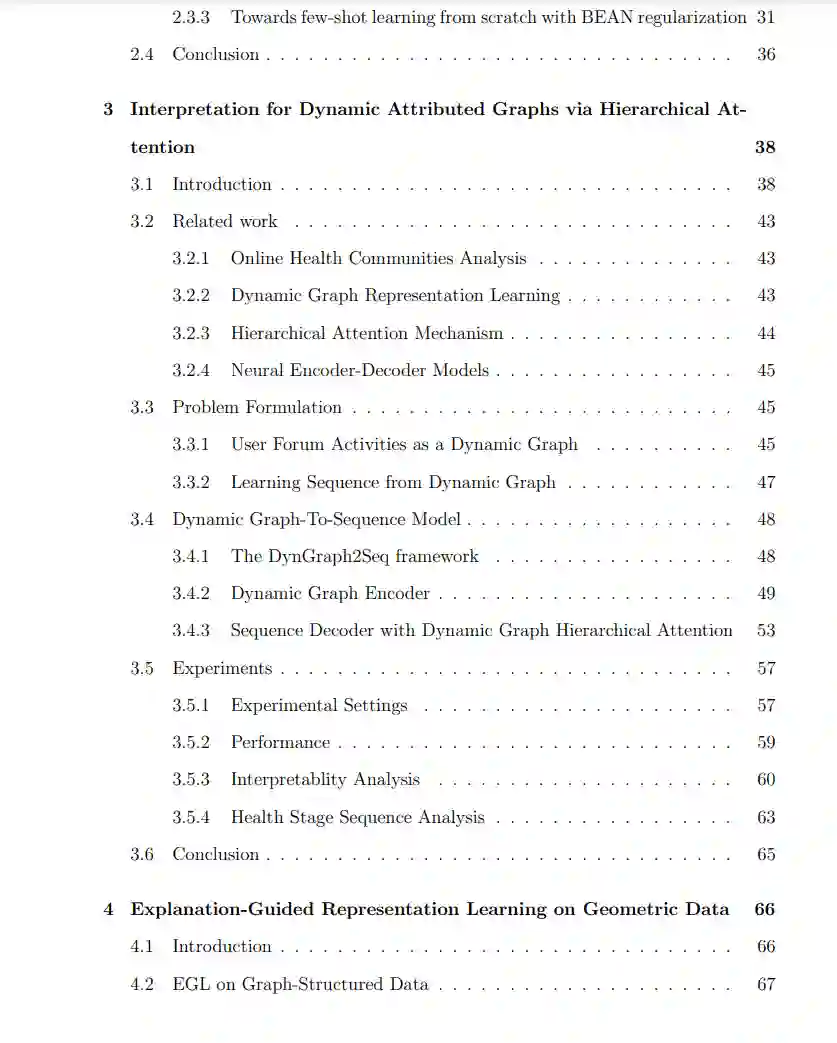

近年来,深度神经网络(Deep Neural Networks, DNNs),包括卷积神经网络(Convolutional Neural Networks, cnn)和图神经网络(Graph Neural Networks, GNNs)的快速发展,使得图像和图结构数据等几何数据的表示学习得到了快速的发展,并取得了显著的进展。然而,dnn通常提供非常有限的透明度,这对观察和理解模型何时以及为什么做出成功/不成功的预测提出了重大挑战[61]。近年来,局部解释技术的研究快速发展,但大部分关注的是如何生成解释,而不是理解“解释是否准确/合理”、“如果解释不准确/不合理该如何处理”、“如何调整模型以生成更准确/合理的解释”[13,108,168,88,129,130,62,183,151]。 **为探索和回答上述问题,本文旨在探索一条新的研究路线,即解释引导学习(EGL),通过XAI技术干预深度学习模型的行为,共同提高深度神经网络的可解释性和泛化性。**本文提出在几何数据上探索EGL,包括图像和图结构数据,由于几何数据解释的复杂性和固有挑战,这些数据目前在研究界未得到充分探索[61]。为实现上述目标,本文首先探索了几何数据的可解释性方法,以理解深度神经网络(dnn)用生物启发方法学习的概念,并提出了解释图神经网络(gnn)对医疗保健应用的预测的方法。为图神经网络设计了一个交互式通用解释监督框架GNES,以实现"学习解释"管道,从而可以提供更合理、更可控的解释。本文提出两个通用框架,即梯度和RES,通过开发新的解释模型目标,用于鲁棒的视觉解释指导学习,可以将噪声的人类注释标签作为监督信号,并从理论上证明了模型泛化的好处。这项研究跨越了多个学科,并通过提出新的框架,可应用于各种现实世界问题,这些问题的可解释性和任务性能都至关重要,有望在各个领域做出一般性贡献,如深度学习、可解释的人工智能、医疗保健、计算神经科学和人机交互。

https://etd.library.emory.edu/concern/etds/k930bz47x?locale=en