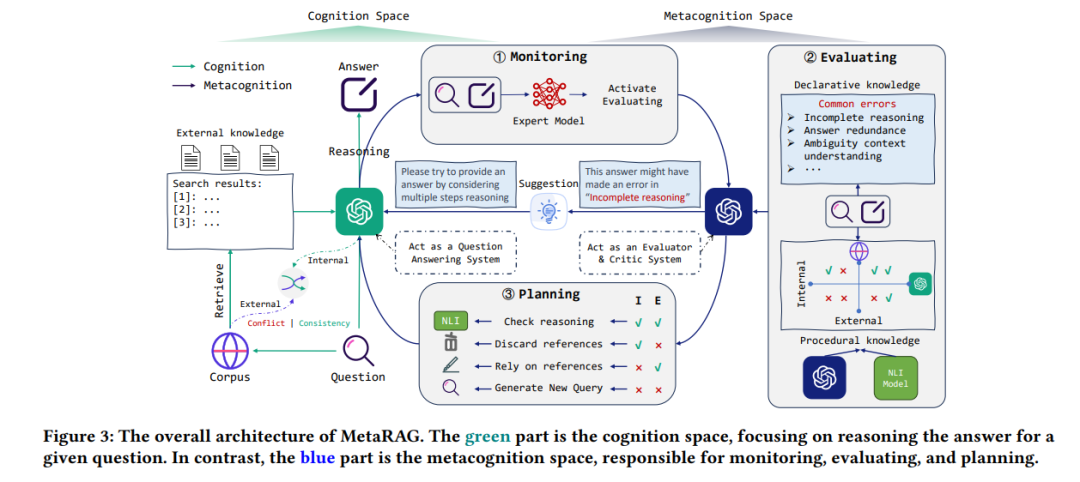

检索增强生成已成为自然语言处理的核心,因为它们在生成事实内容方面的有效性。虽然传统方法采用单次检索,但更多最近的方法已转向多次检索,以执行多跳推理任务。然而,这些策略受到预定义推理步骤的限制,可能导致响应生成的不准确性。本文介绍了MetaRAG,一种将检索增强生成过程与元认知相结合的方法。借鉴认知心理学,元认知允许实体自我反思和批判性评估其认知过程。通过整合元认知,MetaRAG使模型能够监控、评估和规划其响应策略,增强其内省推理能力。通过三步元认知调节管道,模型能够识别初步认知响应中的不足并修正它们。实证评估显示MetaRAG显著优于现有方法。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

223+阅读 · 2023年4月7日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

152+阅读 · 2023年3月29日