整合大型语言模型与图神经网络

讲者:Xavier Bresson

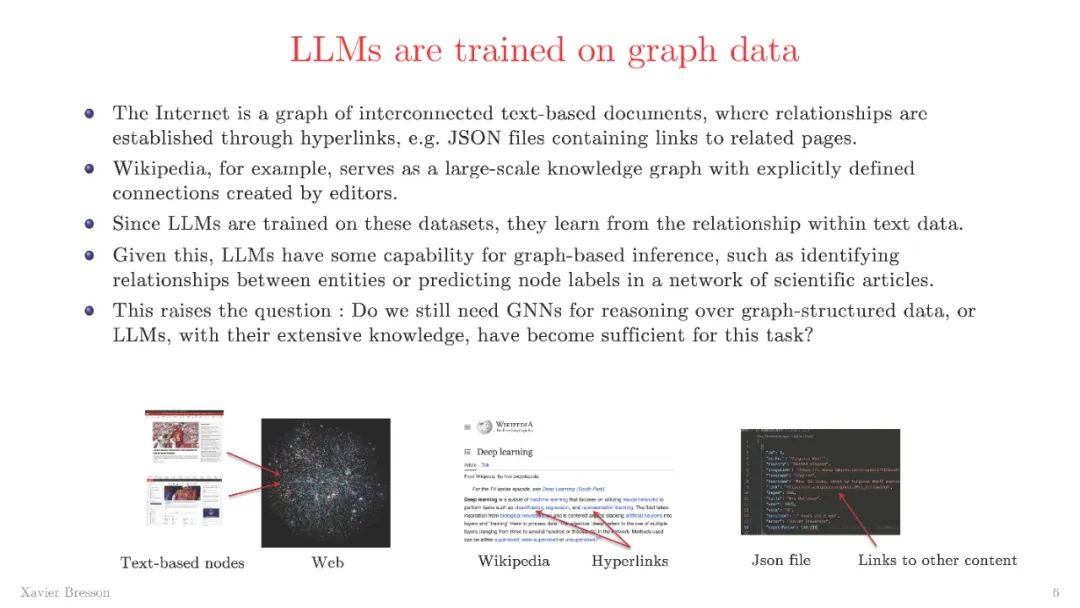

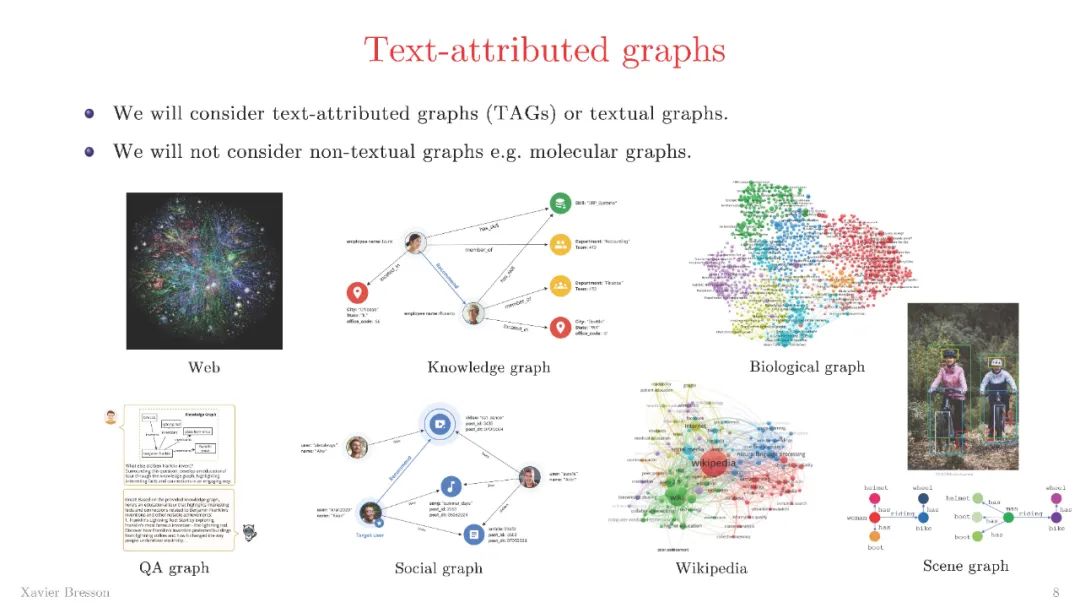

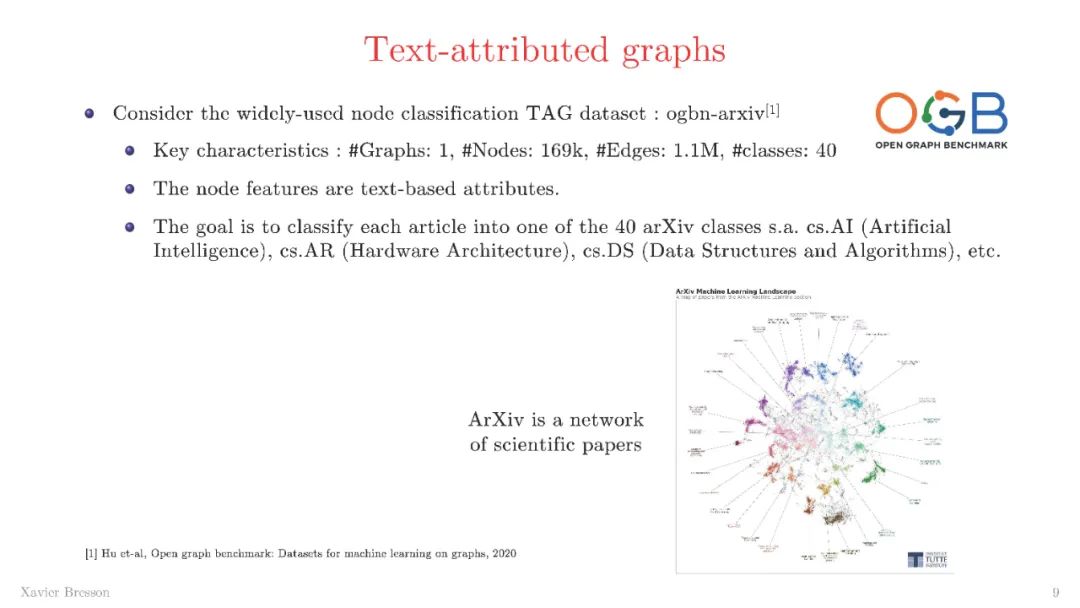

摘要:在大规模数据集上进行预训练的语言模型已经彻底改变了基于文本的应用,推动了自然语言处理的新能力。当文档之间有联系时,它们形成一个文本属性图(TAG),例如互联网、维基百科、社交网络、学术文献网络、生物学网络、场景图和知识图。TAG的主要应用包括推荐(网页推荐)、分类(节点、链接、图)、基于文本和视觉的推理,以及检索增强生成(RAG)。在本次讲座中,我将介绍两种整合大型语言模型(LLMs)与图神经网络(GNNs)的方法。第一种方法展示了LLM的推理能力如何增强TAG节点特征。第二种方法引入了一种创新技术——GraphRAG,旨在将LLM的响应与相关的子图结构对接。这个可扩展的技术规范化了语言模型,显著减少了错误响应,也就是所谓的“幻觉”。

个人简介:Xavier Bresson是新加坡国立大学计算机科学系的副教授。他的研究聚焦于图深度学习,这是一个结合了图论和神经网络的新框架,旨在解决复杂的数据领域。他获得了200万美元的NRF奖学金,这是新加坡最大的个人资助,用于开发这一新框架。他还获得了美国和香港的多个研究资助。他共同撰写的论文是这一领域引用最多的论文之一(NeurIPS第10篇引用最多的论文),并为这些新兴技术的发展做出了重要贡献。他曾组织过多个关于图深度学习的会议、研讨会和教程,例如IPAM'23的“分子系统中的学习与涌现”研讨会、IPAM'23'21的“深度学习与组合优化”研讨会、MLSys'21的“图神经网络与系统”研讨会、IPAM'19和IPAM'18的“新深度学习技术”研讨会,以及NeurIPS'17、CVPR'17和SIAM'18的“图与流形上的几何深度学习”教程。他曾是多所大学和企业的常驻讲者,分享他的研究成果。他还是NeurIPS'22、KDD'21'23、AAAI'21和ICML'20关于“图表示学习”研讨会的讲者,及ICLR'20关于“深度神经模型与微分方程”的研讨会讲者。自2014年起,他一直教授本科生和研究生的深度学习与图神经网络课程。