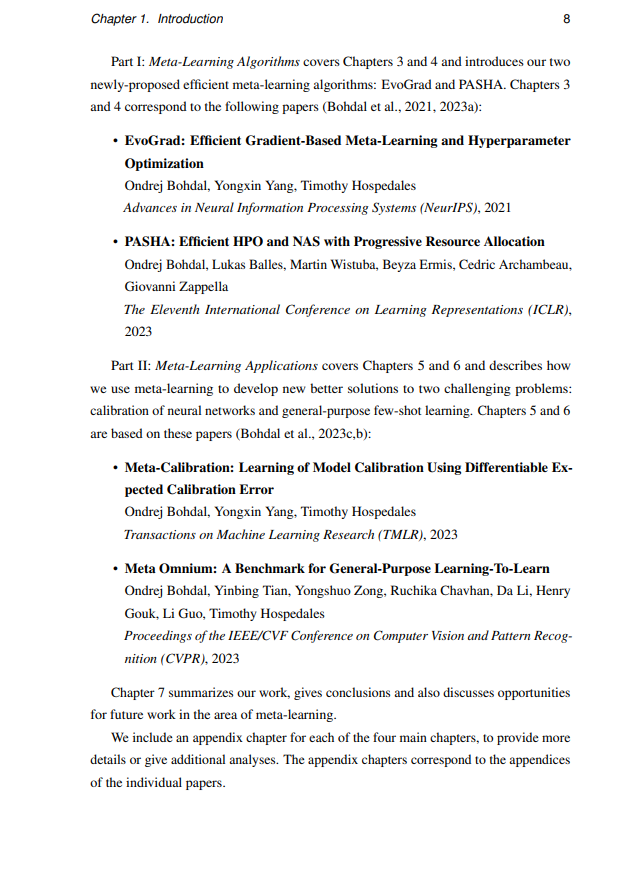

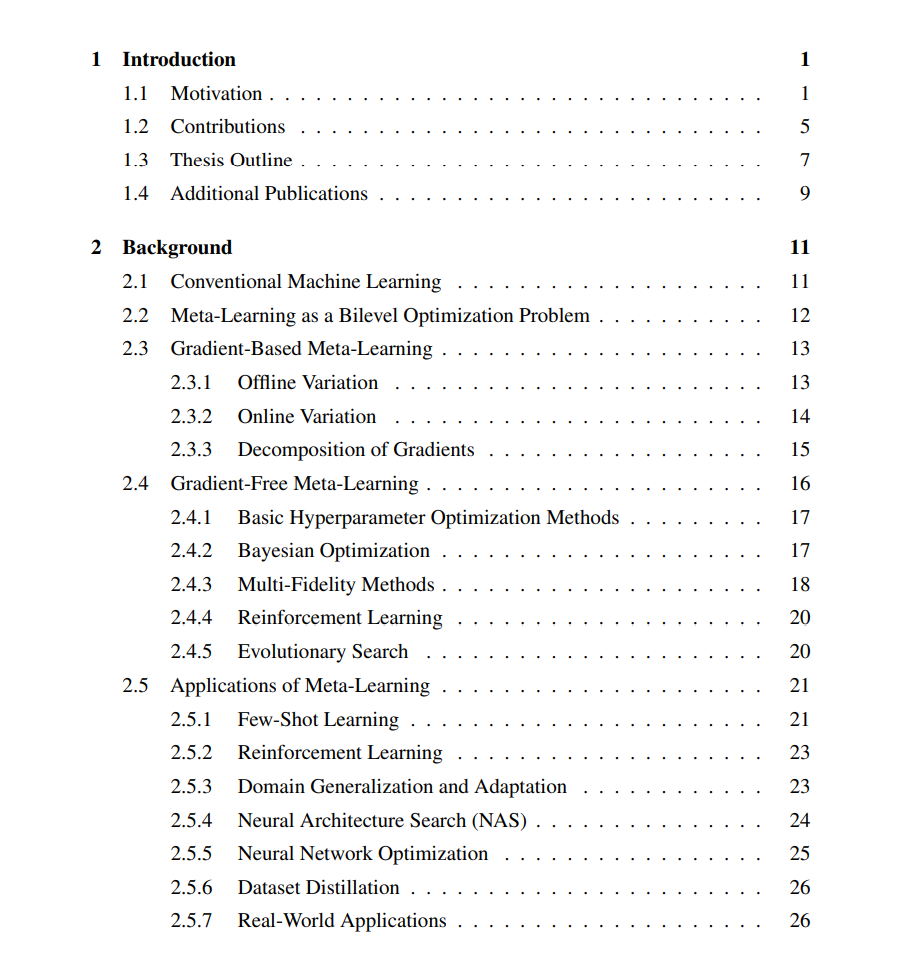

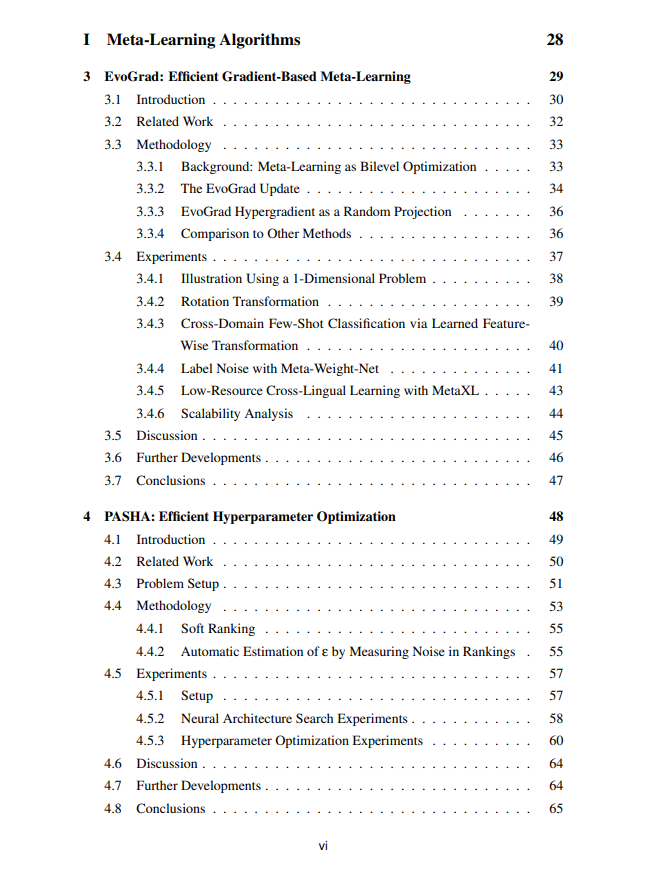

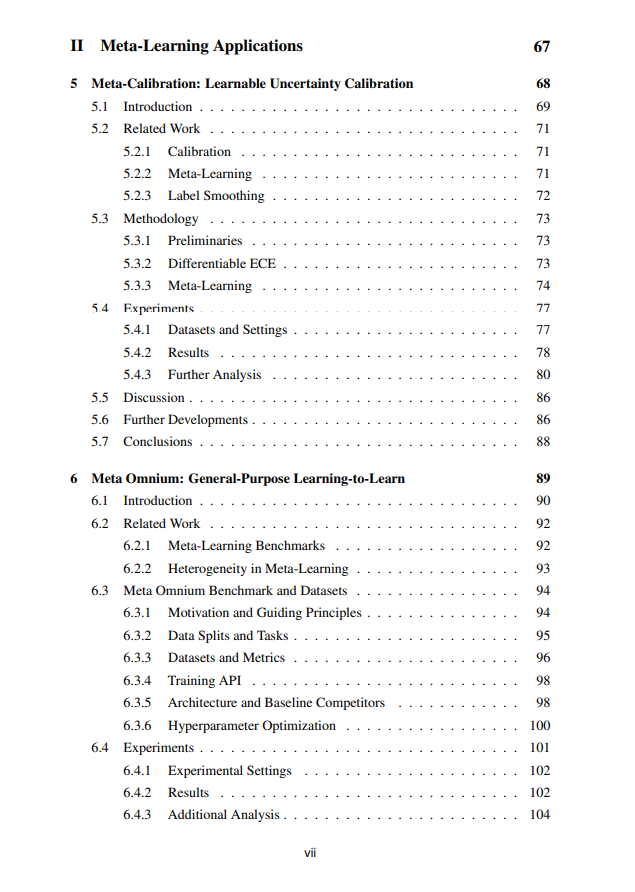

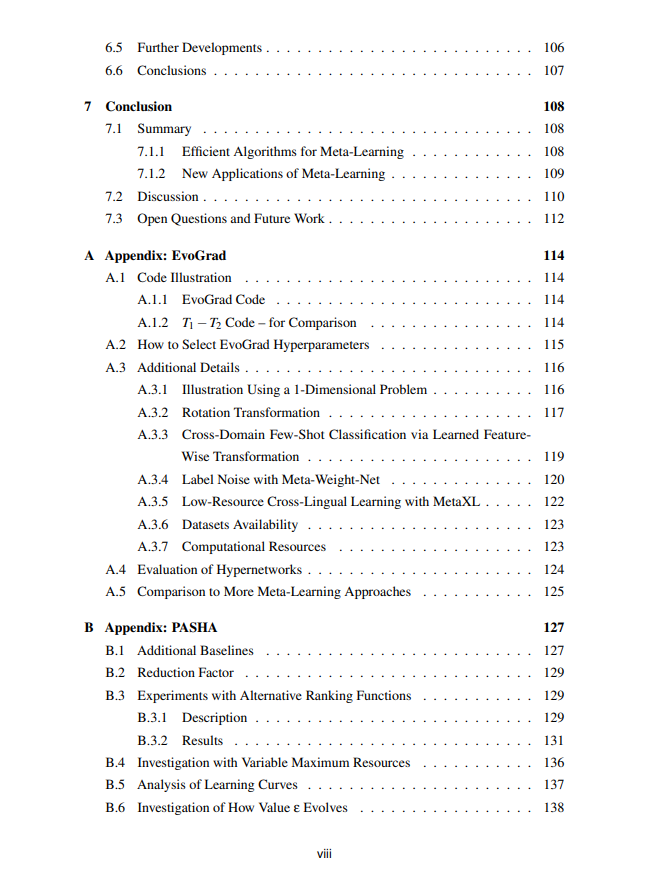

在更广泛的背景下,元学习关注的是一个智能体如何了解自己的学习过程,从而改进其学习过程。学习如何学习不仅对人类有益,而且也显示出对改进机器学习方式的巨大好处。在机器学习的背景下,元学习使模型能够通过选择影响学习的适当元参数来改进其学习过程。具体到深度学习,元参数通常描述模型训练的细节,但也可以包括模型本身的描述——即架构。元学习通常是以特定目标为导向的,例如尝试改善泛化能力或从少数几个例子中学习新概念的能力。元学习可以很强大,但它有一个主要缺点:通常计算成本高昂。如果能够减轻这些成本,元学习将更容易被新的人工智能模型开发者访问,使他们能够实现更伟大的目标或节省资源。因此,我们研究的一个关键重点是显著提高元学习的效率。我们发展了两种方法:EvoGrad和PASHA,两者在两种常见场景中显著提高了元学习效率。EvoGrad允许我们高效地优化大量可微分的元参数值,而PASHA则能够高效地优化数量较少的任何类型的元参数。

https://era.ed.ac.uk/handle/1842/41452 元学习是一个可以应用于解决各种问题的工具。最常见的应用是从少量例子中学习新概念(少样本学习),但也存在其他应用。为了展示元学习在神经网络背景下可以产生的实际影响,我们使用元学习作为两个选定问题的新解决方案:更准确的不确定性量化(校准)和通用少样本学习。这两个都是实际重要的问题,通过使用元学习方法,我们可以获得比使用现有方法获得的更好的解决方案。校准对神经网络的安全关键应用至关重要,而通用少样本学习测试了模型在诸如识别、分割和关键点估计等多样化任务上的少样本学习能力的泛化能力。 更高效的算法以及新的应用使得元学习领域能够对深度学习的更广泛领域产生更显著的影响,并有潜力解决之前过于具有挑战性的问题。最终,这两者都使我们能够更好地利用人工智能呈现的机会。