开发机器学习模型严重依赖于对数据的访问。为了建立一个负责任的数据经济体和保护数据所有权,允许来自独立、异构数据源的学习模型而无需集中是至关重要的。联邦学习(FL)旨在在大量的远程设备或孤立组织中集体训练模型,同时保持用户数据的本地性。然而,联邦网络引入了一些超出传统分布式学习场景的挑战。尽管FL对于实现边缘应用展现出巨大的潜力,但当前的FL系统受到几个约束的制约。除了准确性外,联邦方法还必须扩展到潜在的庞大和异构设备网络,并且必须表现出可信的行为—解决与公平性、稳健性和用户隐私等问题相关的实际关注。

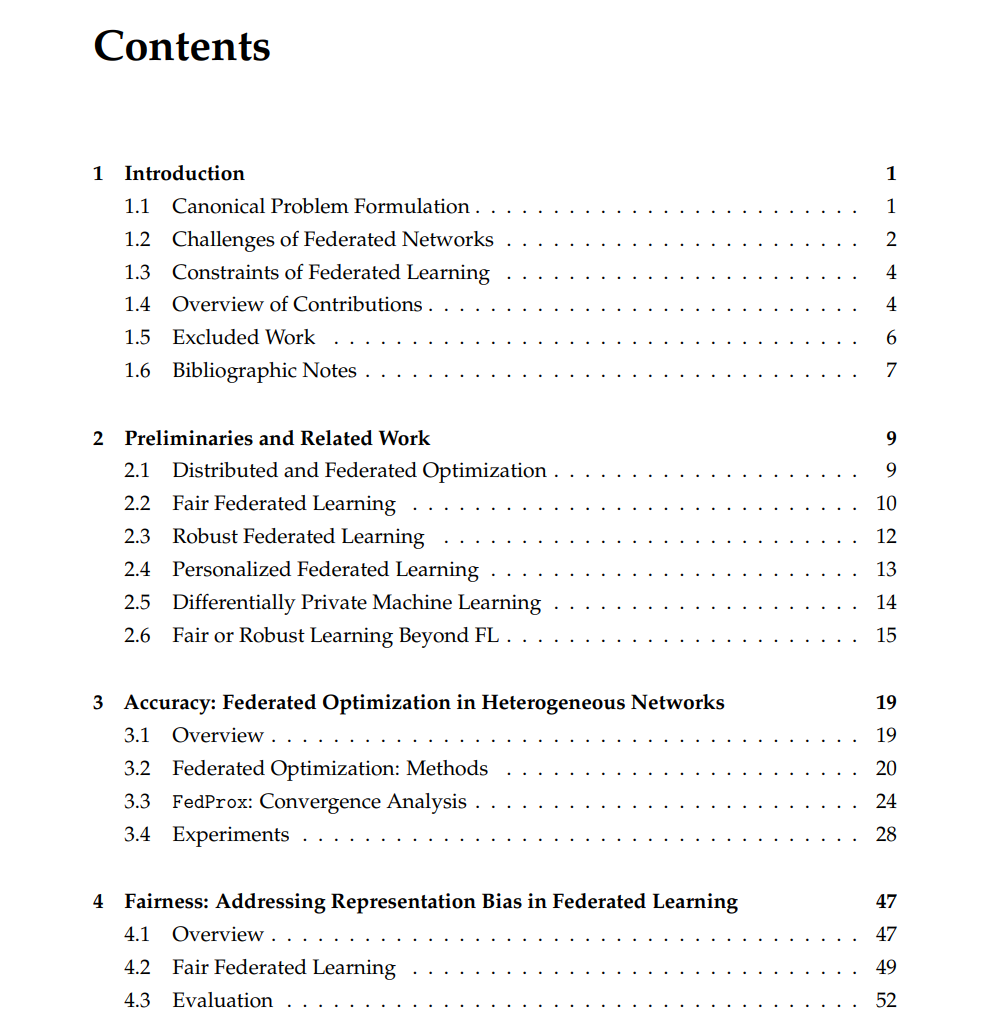

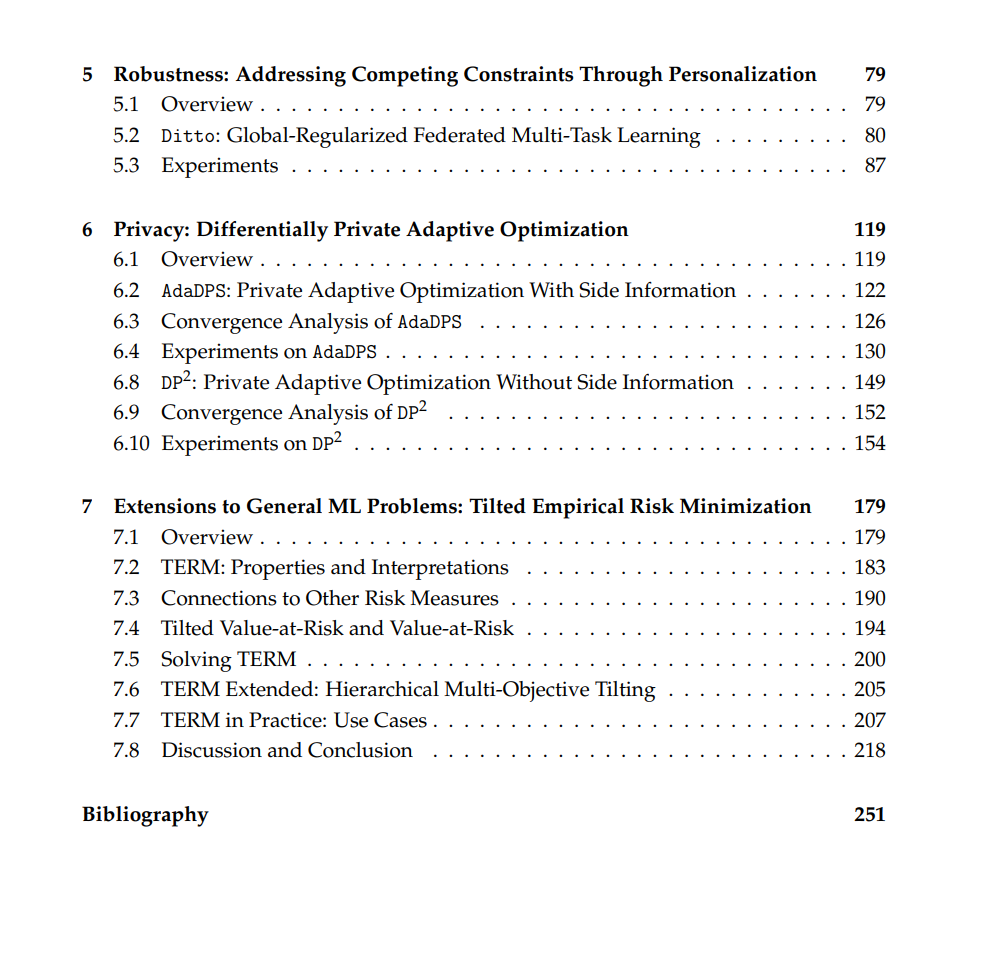

在这篇论文中,我们旨在以有原则的方式解决联邦学习的实际挑战。我们研究异质性是如何位于联邦学习的约束的中心—不仅影响模型的准确性,而且与公平性、稳健性和隐私等其他关键指标相竞争。为了解决这些指标,我们开发了新的、可扩展的学习目标和算法,严格考虑和解决异质性的来源。特别是在准确性方面,我们在实际的异质性假设下提出了具有收敛保证的新型联邦优化框架。在可信性方面,我们开发并分析提供灵活公平性/效用权衡的公平学习目标。我们考虑公平性和稳健性之间的联合约束,并探索个性化FL来证明同时解决它们。最后,我们研究了具有改进收敛行为的新型差分私有优化方法,在隐私约束下实现了最先进的性能。 尽管我们的工作是基于联邦学习的应用,我们展示了许多技术和基本权衡不仅仅延伸到这一用例,还延伸到大规模和可信机器学习的更一般应用。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日