本文讨论了在联合全域作战中,由于数据超载超出了人的能力,因此迫切需要算法支持来锁定移动威胁。文章介绍了马尔可夫决策过程(MDP)及其在预测分析中的应用,以优化目标定位策略,提高资源分配和未来场景规划的效率。

本文讨论了在军事行动中使用预测数据模型,特别是马尔可夫决策过程(MDP)及其扩展模型--部分可观测马尔可夫决策过程(POMDP)的必要性,以优化针对高流动性威胁的瞄准程序。由于传统的分析方法不足以管理产生的大量数据,因此算法支持至关重要。MDP 为不确定环境中的决策建模提供了一个数学框架,使分析人员能够根据当前状态和行动预测结果。POMDP 提供了一种机制,用于处理目标状态不完全可观测的情况。这一框架可以对目标行为进行预测分析,而不是简单地对检测到的特征做出反应,从而提高军事行动中的资源分配效率。本文强调军方有必要推进这些预测模型,并将其纳入作战战略,提倡分配资源以有效开发和运行这些框架。总之,在日益复杂和机动的战场场景中,利用预测模型对保持作战效能至关重要。

在这个新兴技术迅速过时的时代,谁能最快地创造和传播新颖的解决方案,谁就能赢得战斗。在不断演变的联合全域作战(JADO)概念中,成功的关键在于目标定位和打击数量日益增多的高机动性目标的能力。为支持这一任务而收集的数据量已经超出了人类分析师简单简化传统流程的能力,因此有必要在未来的收集和目标定位战略中转向算法支持。马尔可夫决策过程(MDP)是一种连续过程,它使用数学框架来模拟动态系统,其结果要么是随机的,要么是由决策者控制的。使用 MDP 为算法开发概率方程提供了机会,可用于以未来战场所需的速度和规模优化目标收集。

特征分析与保管

随着时间的推移,联合部队通过增加可用于探测和识别威胁系统的独特特征收集数量,改进了其目标定位流程,但由于需要维持偶发性融合目标监护(FTC),使大规模打击这些目标的能力变得复杂。FTC 是一个以使用多源分析为中心的过程,目的是维护目标系统的责任,以支持联合火力。当收集传感器检测到一个独特的特征时,与该特征相关的威胁就被认为 “已发现”。然后对各种传感器进行协调并分配任务,以保持监管。然而,当这一过程扩展到广阔作战区域中更多的威胁系统时,资源分配和管理的规模和需求就会变得太大,难以监管。未来作战空间要求探索提高效率的替代方案。情报专业人员如何才能预测威胁的位置,优化有限收集资源的使用,而不是等待特征被探测到?

重视预测

阿莫斯-特沃斯基(Amos Tversky)是研究概率和预测的著名心理学家,他认为 “人是一个被扔进概率宇宙的确定性装置”。人类喜欢用非黑即白的观点来看待结果。实际上,决策是基于对未来结果的预测概率。不同领域的分析师都需要依靠自己的能力来整理大量信息,从而进行预测分析。如今,可供分析人员使用的信息量不断扩大,从而产生了无数关于如何优化数据分析过程的产品和理论。

美国空军情报分析师依靠描述性分析而非预测性分析来为指挥官的关键信息需求(CCIR)提供信息。因此,情报分析员倾向于依靠过去的事件来了解对手,并确定确认或否认趋势的要求。分析人员有工具来显示历史或接近实时的情报数据,但却没有旨在告知未来不同结果概率的预测模型。MDP 可以填补这一空白。它由四个关键要素组成:智能体、状态、行动和政策。智能体是做出决策的系统或个人。在任何给定时间内,智能体都能在多种状态或环境中工作。根据当前的状态,智能体确定了一套固定的行动,它可以采取这些行动来保持当前状态或过渡到不同的状态。策略有助于根据智能体的当前状态确定其下一步行动。

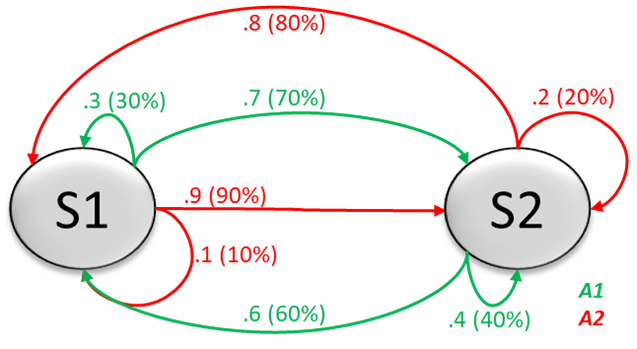

从理论上讲,智能体从一种状态过渡到另一种状态的可能性是由当前状态和智能体下一步能进入哪种状态的概率来预测的。 在下面的例子中,智能体可以存在两种状态: 状态 1(S1)和状态 2(S2)。绿线与行动 1(A1)相关,红线与行动 2(A2)相关。假设在 S1 中使用了 A1。该模型显示,所采取的行动有 30% 的概率会保持在 S1 状态,而有 70% 的概率会进入 S2 状态。因此,如果处于 S1 并采取 A1,智能体很有可能会移动到 S2。

图 1. MDP 示例

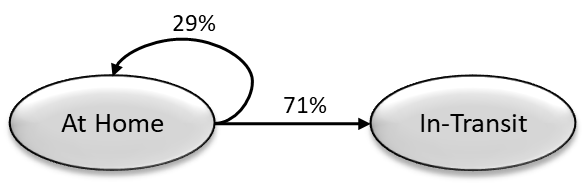

例如,一个人的状态可能是 “在家”、“在途中 ”和 “在工作”。通过了解当前状态,我们可以利用过去的观察结果来确定过渡到新状态的可能性。在一周的观察期内,观察对象在工作日会从 “在家 ”状态过渡到 “在途中 ”状态,而在周末则会保持 “在家 ”状态。如果已知被试处于 “在家 ”状态,我们就可以推断出很有可能发生向 “在途 ”状态的转换,在过去 7 天中有 5 天(71%)都是如此。还有一种较小但明显的概率,即状态不会发生变化,被试仍然 “在家”,这可能是因为今天是周末(29%)。

图 2. 状态转换概率

应用于移动威胁

在未来的战争中,我们无法了解和监控每个目标的状态及其在战场上的行动。因此,在将 MDP 模型应用于移动威胁系统时,必须考虑其部分可观测的性质。部分可观测 MDP(POMDP)是 MDP 在信息缺失情况下的一般化。在 POMDP 中,分析人员在观察智能体的行动时,无法确定智能体当前所处的状态。这些观察结果为根据返回相同状态或进入不同状态的相关概率预测下一个状态提供了洞察力。

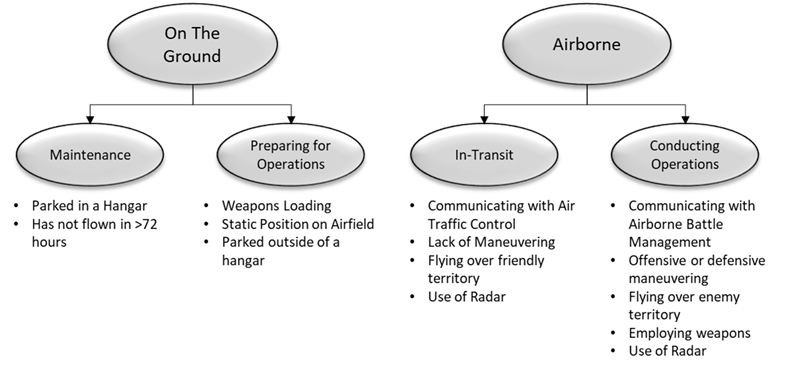

更具体地说,POMDP 可以让分析人员将此模型应用于目标集,如飞机。每个目标都可以被视为一个智能体(一架飞机),能够在多种状态(地面或空中)下运行。在 “地面 ”或 “机载 ”的主要状态下,飞机可以处于以下几种子状态中的任何一种:维护、准备行动、在前往行动区域的途中或正在进行行动。与每个子状态相关的特征可用于深入了解其当前和未来状态。图 3 是这一概念的图解。

图 3. 飞机 POMDP 示例

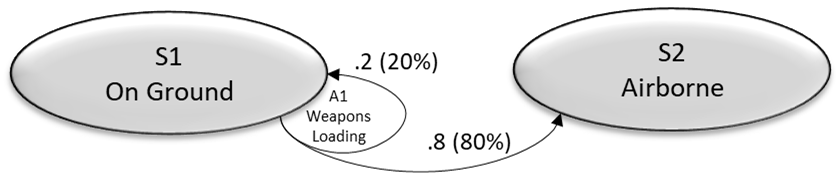

假设状态和子状态未知,分析人员可以利用可观察到的特征来推断飞机当前状态的概率。例如,如果观察到飞机停在机库中,那么飞机处于维护子状态的概率要高于 “准备运行”。如果将这些信息用于预测行为,与状态相关的观察结果的价值就会增加。如果分析员在观察武器装载的历史背景时了解到,之前 80% 的武器装载观察结果导致飞机在 12 小时内起飞,那么我们就可以更有把握地预测飞机将很快过渡到 “空降 ”状态。如图 4 所示,仍有 20% 的几率飞机不准备转场,而是返回维护区或在机场静止不动。

图 4. 状态转换概率

识别相应状态转换的能力将使高需求、低密度收集资源的效率达到一个新的水平。与其试图保持对每个战区每个目标的感知,不如针对可能对蓝军构成近期威胁的敌方系统优先部署传感器。这样,收集协调工作就变成了一系列概率性的 “如果,那么 ”语句,可由算法以超出人类能力的规模进行求解和优先排序。如果威胁处于状态 2,则必须继续监护。如果威胁处于状态 2 的可观测特征之一是使用了雷达,则需要使用 SIGINT 收集资产。虽然人类可以通过制定收集策略来完成类似的流程,但同级冲突的规模和速度以及历史时限将使传统流程失效。

未来方向

威胁系统的机动性和战场的复杂性只会继续增加,进一步阻碍联合部队有效打击对手的能力。一小部分规划人员和分析人员已经开始为现实世界的目标集生成初步的 POMDP 模型。这项工作必须扩大,并更加重视整合 MDP。在开展这些工作的同时,规划人员和分析人员必须总结经验教训,并开始针对多个责任区(AOR)的其他目标集应用他们的 POMDP 模型。与此同时,联合领导人必须倡导在其行动区域内应用这种完善的预测模型。在 POMDP 模型证明其有效性后,国防部必须通过计划目标备忘录为 POMDP 模型提供充足的资源,将其纳入目标选择战略,并进行规模不断扩大的作战测试,直至全球可行的解决方案投入使用。