语言模型已在自然语言处理中无处不在,它们利用大量未标记的数据并为下游任务进行微调。但人们对这些模型生成的文本的准确性和可信度提出了担忧。

与此同时,差分隐私已成为一种框架,用于保护敏感信息,同时允许机器学习算法从中学习。然而,统计保证与实用性之间的权衡对许多应用都带来了挑战**。因此,这篇论文旨在开发平衡保证和实用性的技术,重点是提高生成模型的可靠性,同时保持其灵活性**。

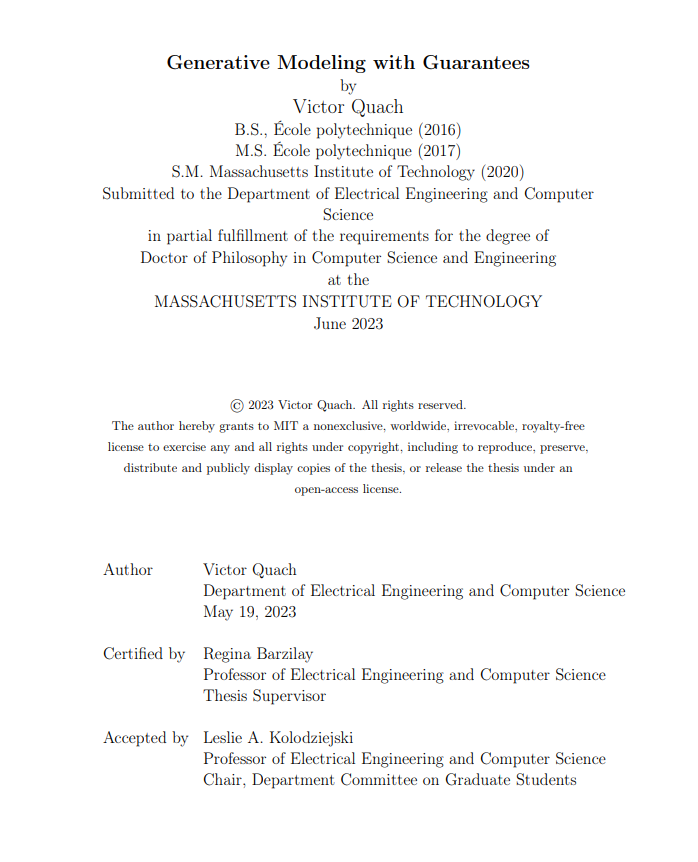

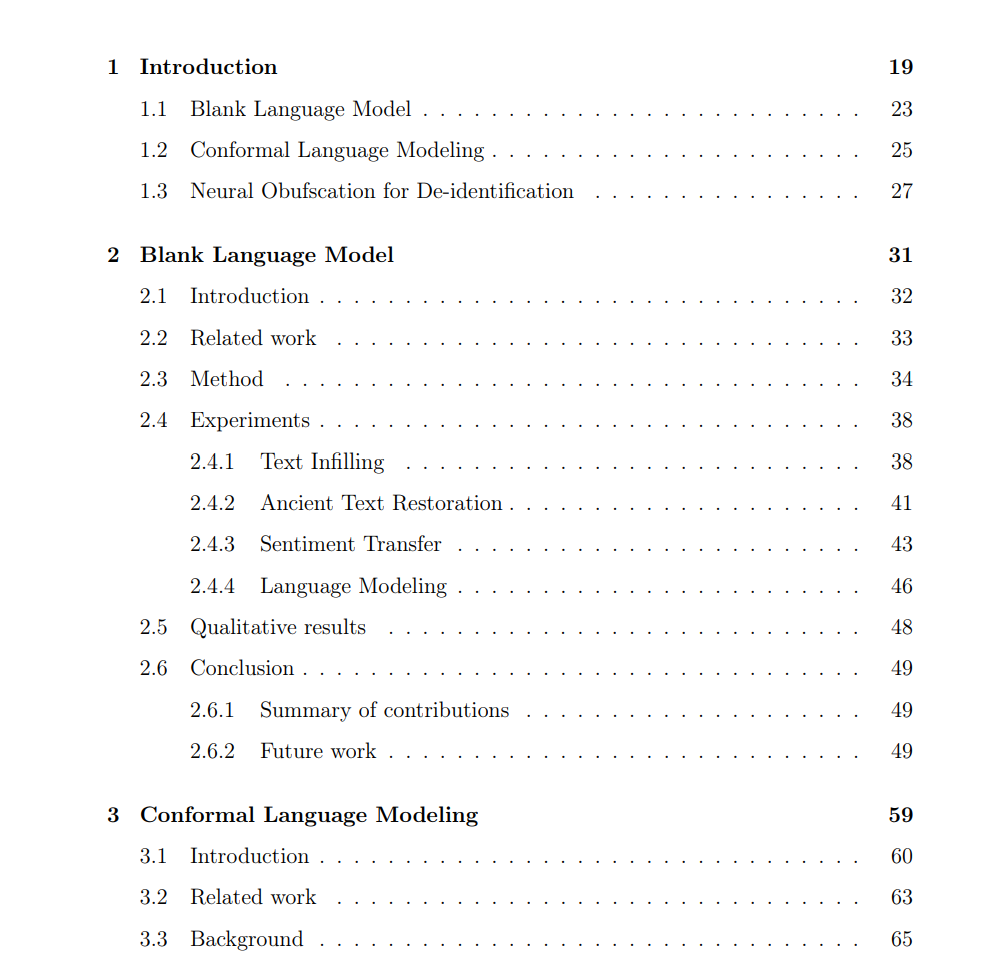

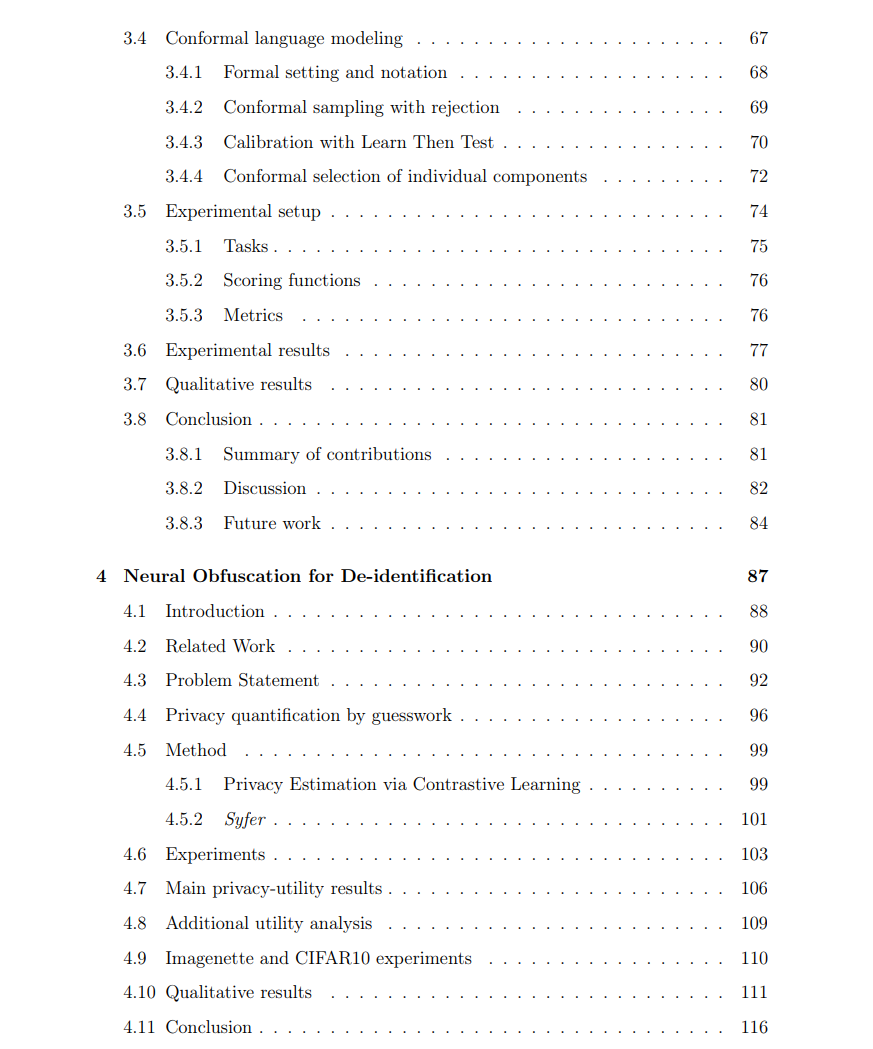

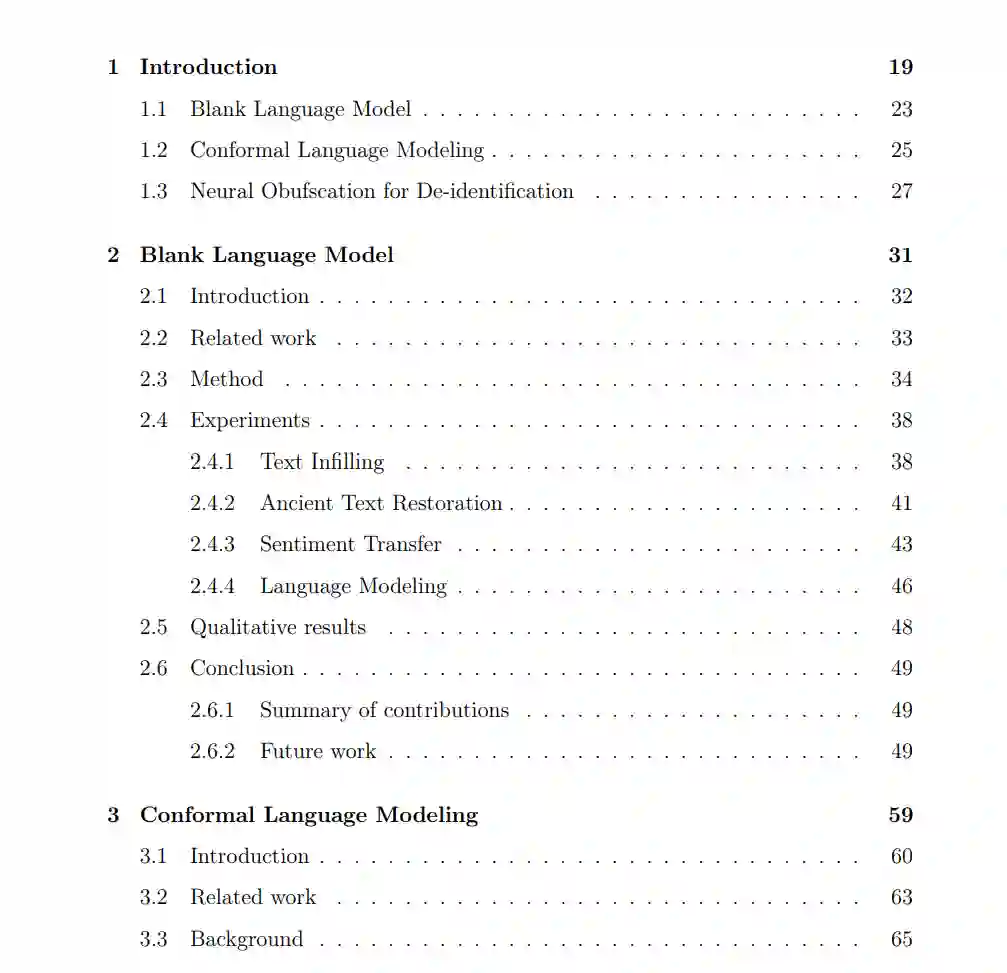

首先,我们提出了一个框架,可以有条件地使用硬约束生成文本,允许用户事先指定某些元素,而留下其他元素供模型预测。通过促进交互式编辑和重写,此框架为用户提供了对生成文本的精确控制。 接下来,我们引入了在软约束下生成预测的共形预测方法,以确保统计的正确性。这些方法在保持高经验精度的同时,为文本生成产生有效的置信集。

最后,我们通过放宽差分隐私的保证概念到基于猜测的定义,探索数据发布中隐私与实用性之间的平衡。我们提出了一种基于学习的去识别化方法,解决了隐私保护的挑战,同时仍能有效地利用数据。我们提出的方法的有效性通过一系列任务得到了证明,包括文本填充、放射学报告生成和X光分类。这些任务展示了我们的技术在各种实际场景中的实用性。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日