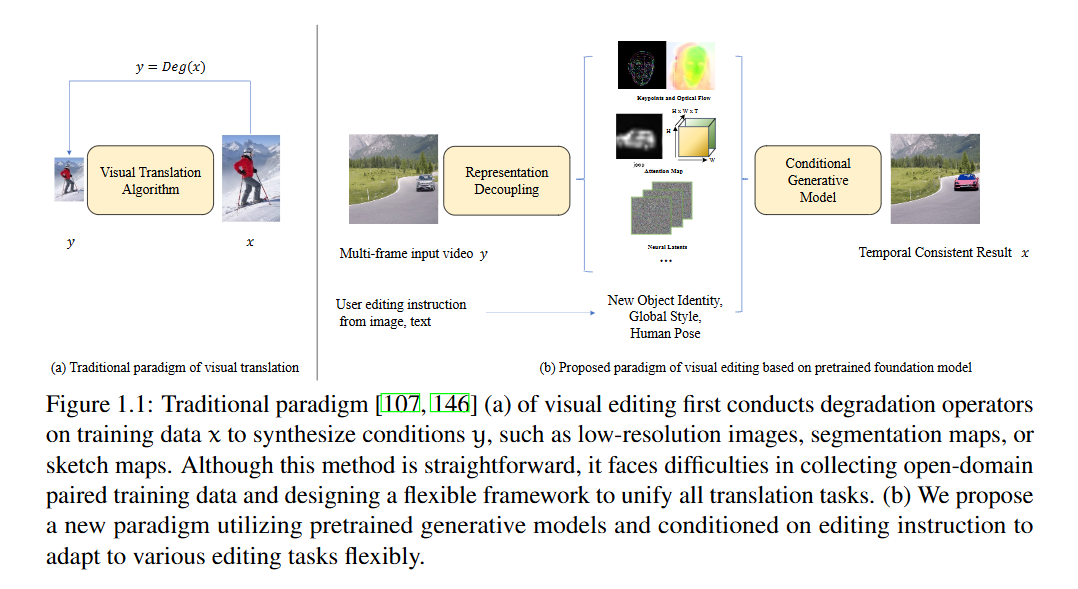

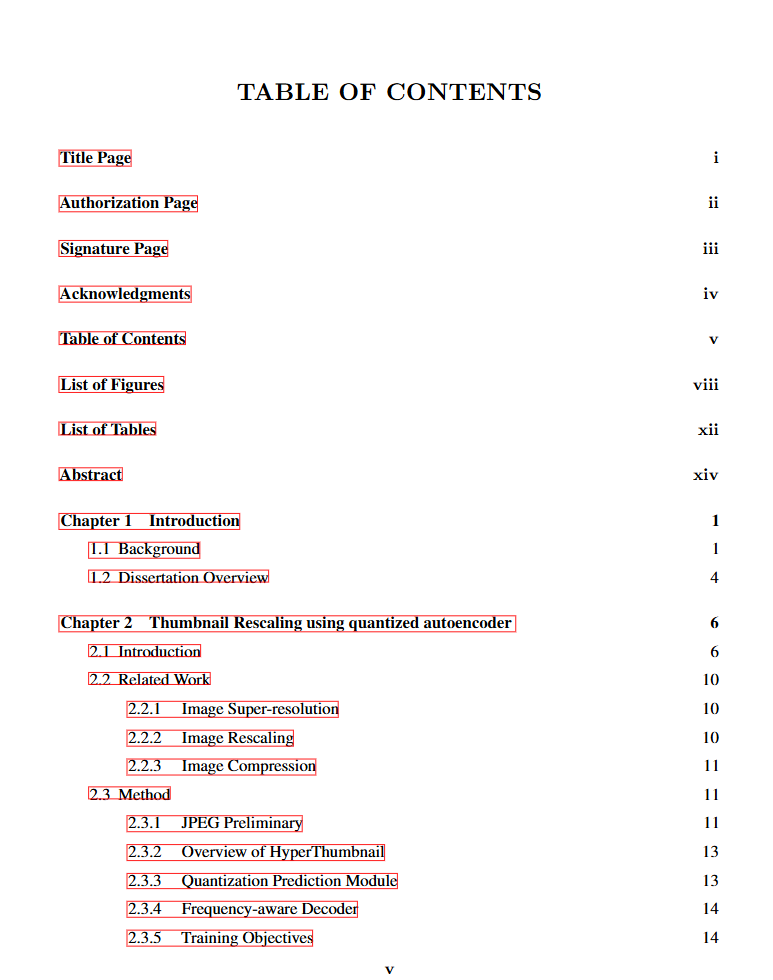

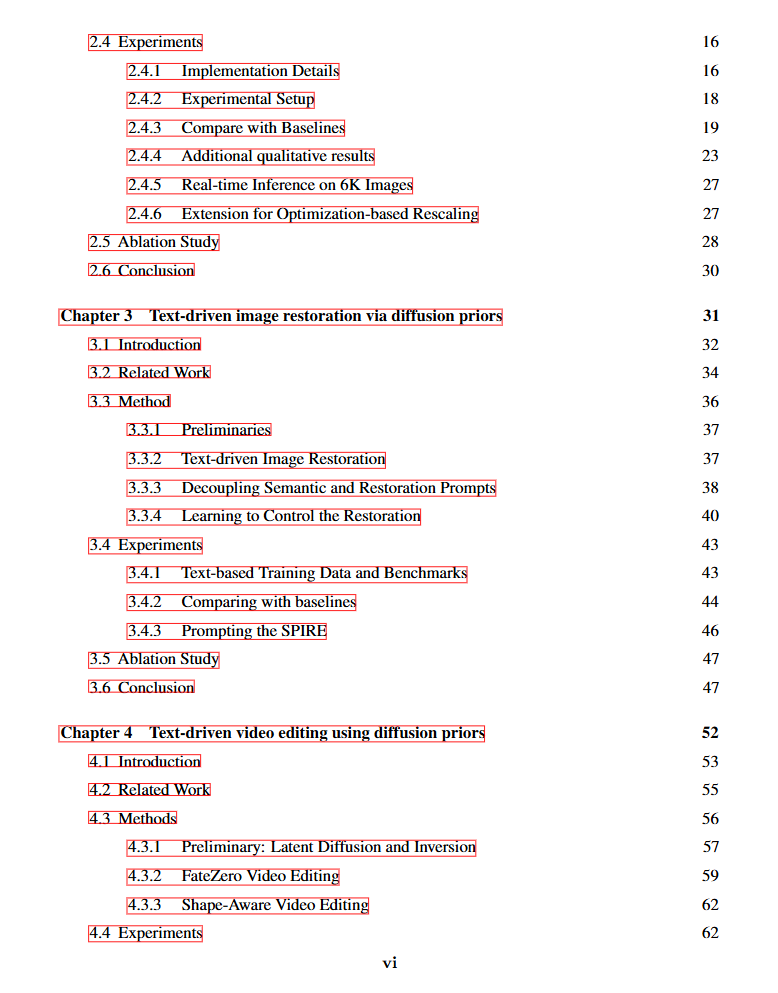

近年来,在计算摄影、虚拟现实、游戏和电影产业等领域,对视觉内容(如2D图像和多帧视频)的需求不断增长。为了满足这些需求,研究者们提出了多种生成模型,包括VQVAE、GAN和扩散模型(Diffusion Models),以促进从噪声或文本生成视觉内容。然而,如何将这些模型应用于更实际的图像到图像生成任务(也称为图像处理与编辑)仍然是一个开放的挑战。本论文探讨了基于生成模型的图像编辑范式,重点关注来自大规模预训练的基础模型。 我们首先探索了实时图像缩放技术。现代相机拍摄的图像可以达到6K分辨率,但这些图像占用的存储空间过大。为此,我们提出了一种量化自编码器,通过优化熵损失将大型6K图像压缩为JPEG缩略图,从而减小文件大小。随后,一个高效的解码器可以实时将低分辨率缩略图还原为高分辨率图像。 接着,我们转向文本驱动的图像修复技术。相机运动、数字电路噪声以及恶劣天气(如雨和雾)可能会降低摄影师拍摄的图像质量。我们提出了一种基于扩散模型的图像修复方法,该方法通过语义和修复指令进行引导。为了以较低的训练成本实现这种多模态应用,我们使用合成退化图像对预训练的潜在扩散模型进行适配器微调。 最后,我们讨论了文本驱动的视频编辑方法。除了图像层面的计算摄影外,创意特效也广泛应用于游戏、电影和短视频应用中。这些特效通常需要时间运动一致性和语义层面的编辑,例如身份和风格。由于目前没有鲁棒且开源的视频生成模型可用,我们专注于以零样本方式利用文本到图像的潜在扩散模型。具体来说,我们将图像生成模型转换为视频模型,并在DDIM反演过程中提取扩散Unet中的时空注意力图,作为运动和几何表示。然后,在DDIM去噪过程中,根据目标提示重新使用这些注意力图。我们简洁的框架能够在保持显著时间一致性的同时,实现形状、属性和全局风格的编辑。