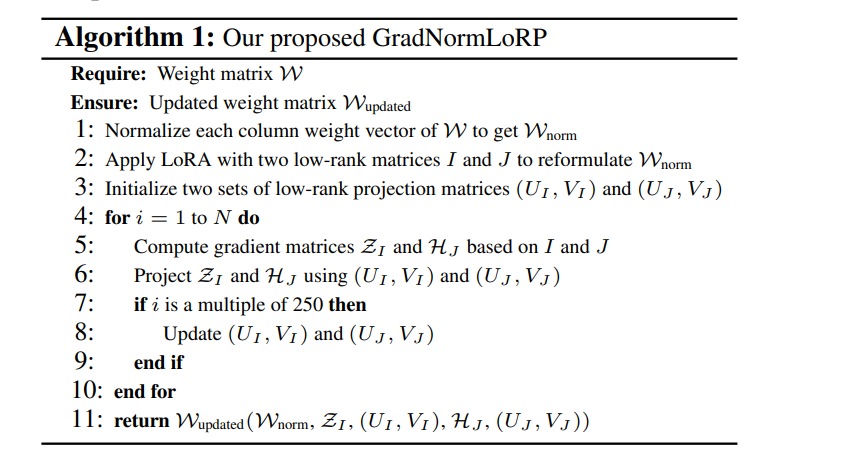

大型语言模型(LLM)在各类任务中表现出色,但对计算资源的需求不断增加,特别是在下游任务中广泛使用全量微调时,带来了显著的挑战。为了解决这一问题,已经提出了参数高效微调(PEFT)方法,但它们往往表现不如全量微调,并且在内存效率方面存在困难。在本研究中,我们提出了一种新方法——梯度权重归一化低秩投影(GradNormLoRP),它在保持与全量微调相当的性能的同时,提升了参数和内存效率。GradNormLoRP 通过归一化权重矩阵来改善梯度的条件,从而促进优化过程中更好的收敛。此外,它对权重和梯度矩阵应用低秩近似,大幅减少了训练过程中的内存使用。大量实验表明,我们的 8 位 GradNormLoRP 能够将优化器的内存使用减少最多 89.5%,并使得大规模 LLM(如 LLaMA 7B)能够在消费者级 GPU(如 NVIDIA RTX 4090)上进行预训练,而无需额外的推理成本。更重要的是,GradNormLoRP 在微调任务中优于现有的低秩方法。例如,在对 RoBERTa 模型进行所有 GLUE 任务的微调时,使用秩为 8 的 GradNormLoRP 平均得分为 80.65,超越了 LoRA 的 79.23 分。这些结果突显了 GradNormLoRP 作为一种高效 LLM 预训练和微调的有前途替代方案。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

219+阅读 · 2023年4月7日

Arxiv

84+阅读 · 2023年4月4日

Arxiv

151+阅读 · 2023年3月29日