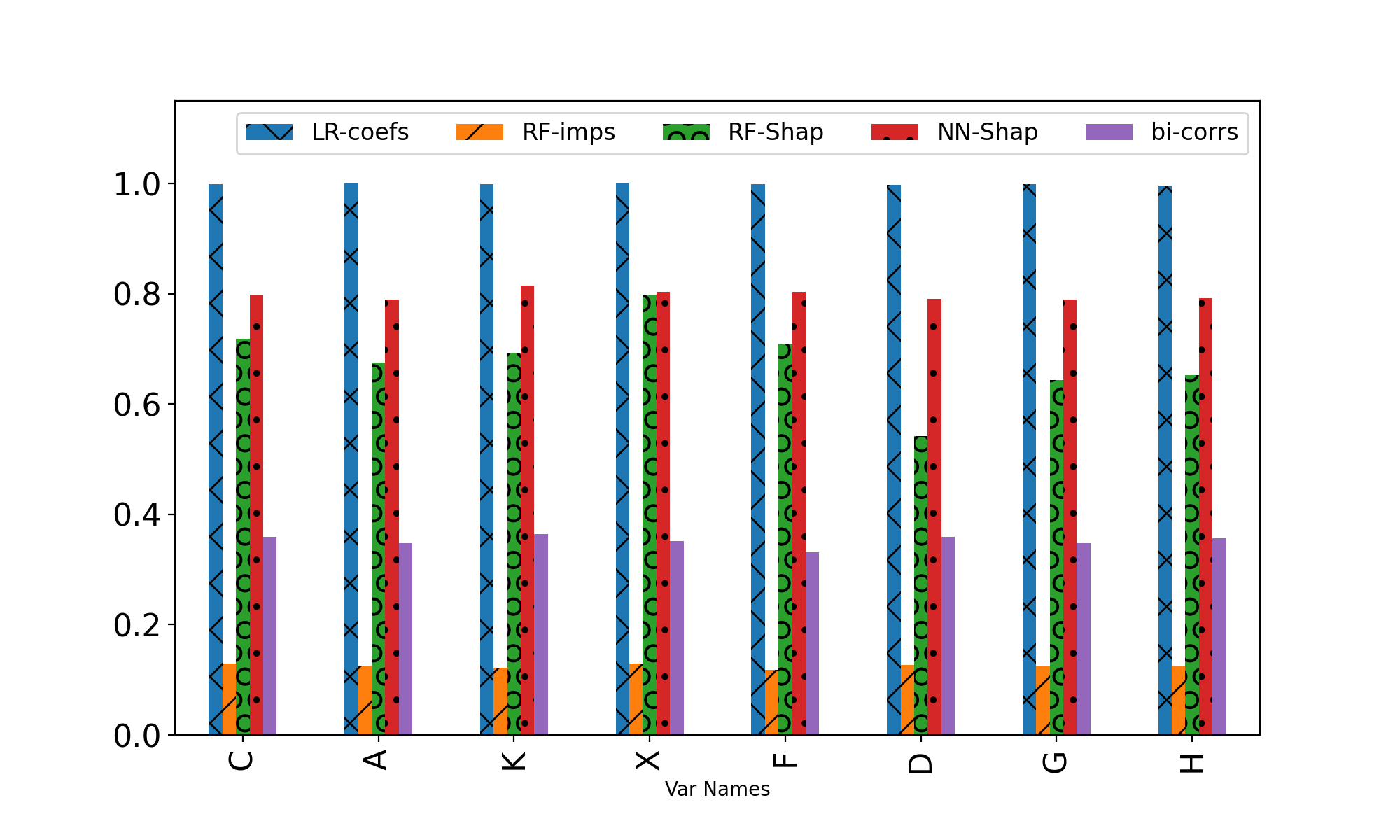

Machine Learning explainability techniques have been proposed as a means of `explaining' or interrogating a model in order to understand why a particular decision or prediction has been made. Such an ability is especially important at a time when machine learning is being used to automate decision processes which concern sensitive factors and legal outcomes. Indeed, it is even a requirement according to EU law. Furthermore, researchers concerned with imposing overly restrictive functional form (e.g. as would be the case in a linear regression) may be motivated to use machine learning algorithms in conjunction with explainability techniques, as part of exploratory research, with the goal of identifying important variables which are associated with an outcome of interest. For example, epidemiologists might be interested in identifying 'risk factors' - i.e., factors which affect recovery from disease - by using random forests and assessing variable relevance using importance measures. However, and as we aim to demonstrate, machine learning algorithms are not as flexible as they might seem, and are instead incredibly sensitive to the underling causal structure in the data. The consequences of this are that predictors which are, in fact, critical to a causal system and highly correlated with the outcome, may nonetheless be deemed by explainability techniques to be unrelated/unimportant/unpredictive of the outcome. Rather than this being a limitation of explainability techniques per se, it is rather a consequence of the mathematical implications of regressions, and the interaction of these implications with the associated conditional independencies of the underlying causal structure. We provide some alternative recommendations for researchers wanting to explore the data for important variables.

翻译:为了了解为什么作出某项决定或预测的原因,有人提议采用“解释”或询问模型的方法,作为“解释”或“调查”的一种方法。当机器学习被用来使涉及敏感因素和法律结果的决策过程自动化时,这种能力特别重要。事实上,这甚至是根据欧盟法律的要求。此外,研究者如果担心施加过于限制性的功能形式(如线性回归中的情况),可能会被鼓动使用机器学习算法和解释性技术,作为探索性研究的一部分,目的是查明与兴趣结果相关的重要变量。例如,在利用机器学习使涉及敏感因素和法律结果的决策过程自动化时,这种能力可能特别重要。事实上,流行病学家可能有兴趣确定“风险因素”-即影响疾病康复的因素,使用随机森林和采用重要措施评估不同的相关性。然而,正如我们想表明,机器学习算法可能没有像看上去那样灵活,而是对数据中我们较低的因果关系结构非常敏感。这种结果的后果是,事实上对一个因果关系系统至关重要的预测,而且与这种因果关系和这种不确定性的结果之间,也许通过一种不相关的技术来解释这种不确定性的结果。