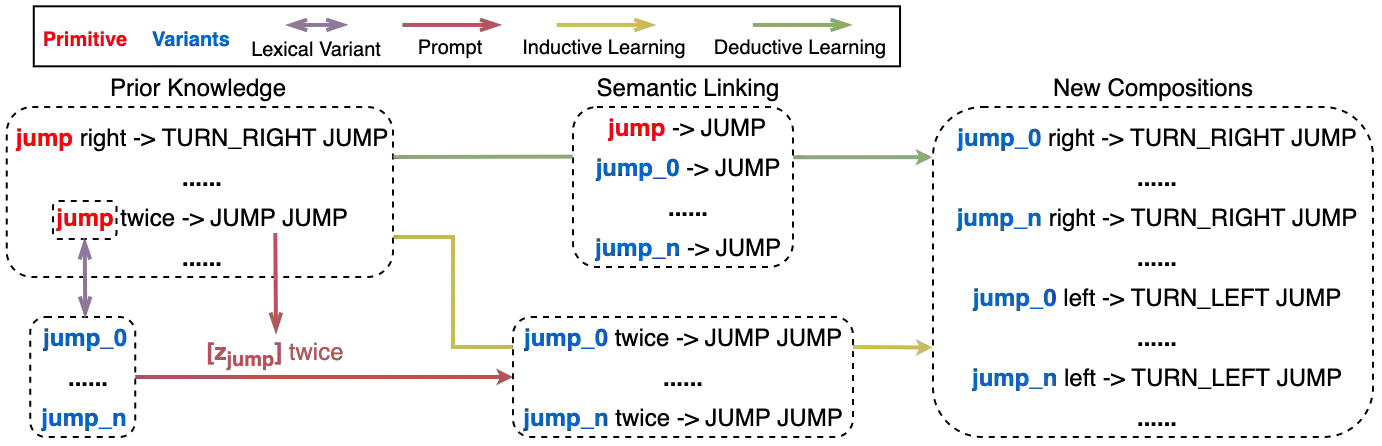

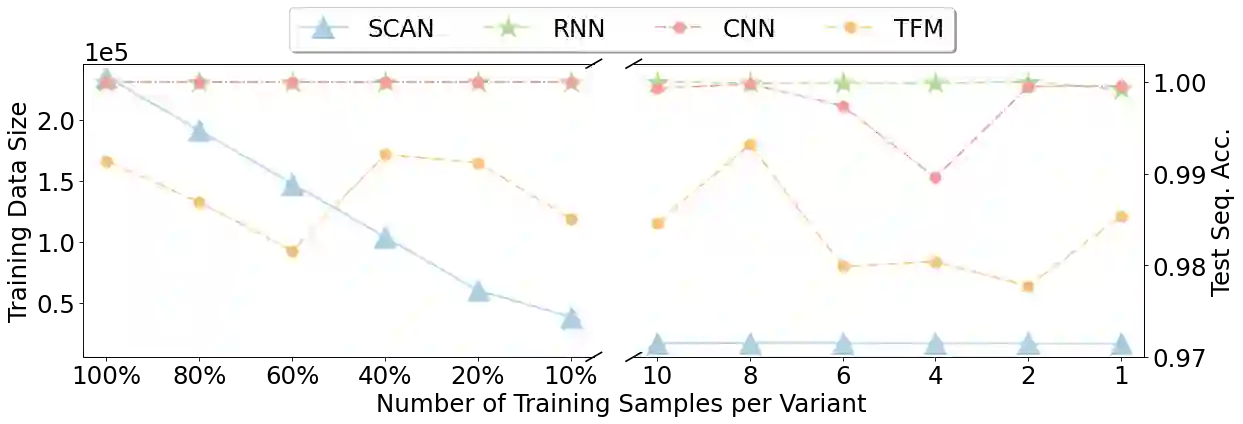

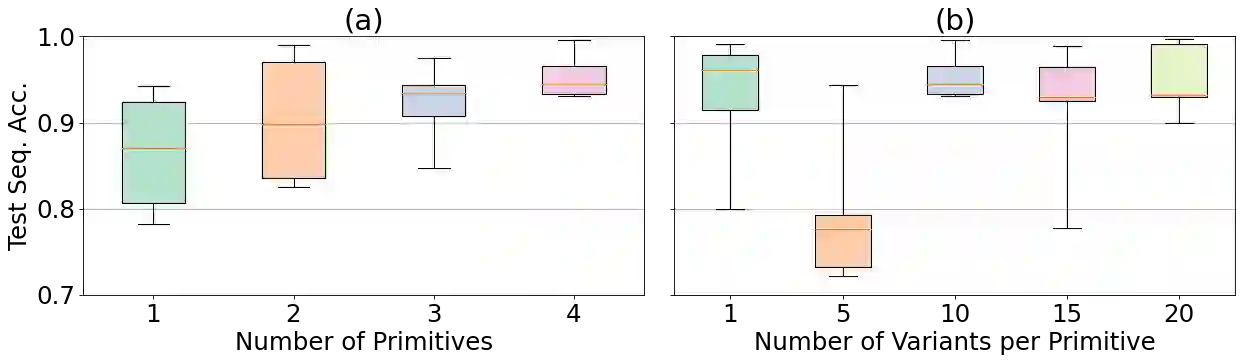

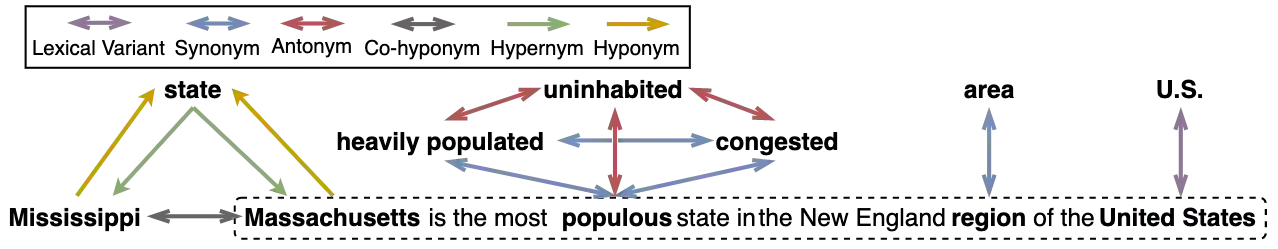

Humans can systematically generalize to novel compositions of existing concepts. There have been extensive conjectures into the extent to which neural networks can do the same. Recent arguments supported by evidence on the SCAN dataset claim that neural networks are inherently ineffective in such cognitive capacity. In this paper, we revisit systematic generalization from the perspective of meaningful learning, an exceptional capability of humans to learn new concepts by connecting them with other previously known knowledge. We propose to augment a training dataset in either an inductive or deductive manner to build semantic links between new and old concepts. Our observations on SCAN suggest that, following the meaningful learning principle, modern sequence-to-sequence models, including RNNs, CNNs, and Transformers, can successfully generalize to compositions of new concepts. We further validate our findings on two real-world datasets on semantic parsing and consistent compositional generalization is also observed. Moreover, our experiments demonstrate that both prior knowledge and semantic linking play a key role to achieve systematic generalization. Meanwhile, inductive learning generally works better than deductive learning in our experiments. Finally, we provide an explanation for data augmentation techniques by concluding them into either inductive-based or deductive-based meaningful learning. We hope our findings will encourage excavating existing neural networks' potential in systematic generalization through more advanced learning schemes.

翻译:人类可以系统化地概括现有概念的新构思。 已经对神经网络能够达到的相同程度进行了广泛的推测。 最近得到SCAN数据集声称神经网络在这种认知能力方面本质上是无效的的证据支持的论点。 在本文中,我们从有意义的学习的角度重新审视系统化的概括性概念,这是人类通过与其他已知知识连接来学习新概念的特殊能力。我们提议以感知或推断的方式增加一个培训数据集,以建立新概念和旧概念之间的语义联系。 我们对SCAN的观察表明,根据有意义的学习原则,现代序列到序列模型,包括RNN、CNN和变异器,可以成功地将新概念的构成加以概括化。我们进一步验证我们关于两个真实世界数据集的研究结果,这些数据集与先前已知的语义和一致的构成概略相连接。 此外,我们的实验表明,先前的知识和语义联系对于实现系统化的概括化联系都起着关键作用。 同时,我们对SCANCAN的观察表明,根据有意义的学习通常比在我们的实验中进行推论式式式式学习,而不是在我们的实验中进行神经化的学习。 最后的学习,我们将通过我们现有的学习方法提供一种有意义的深层次的深层次的理论解释。