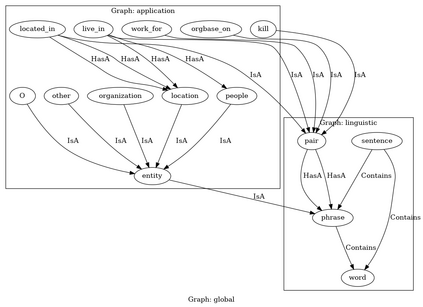

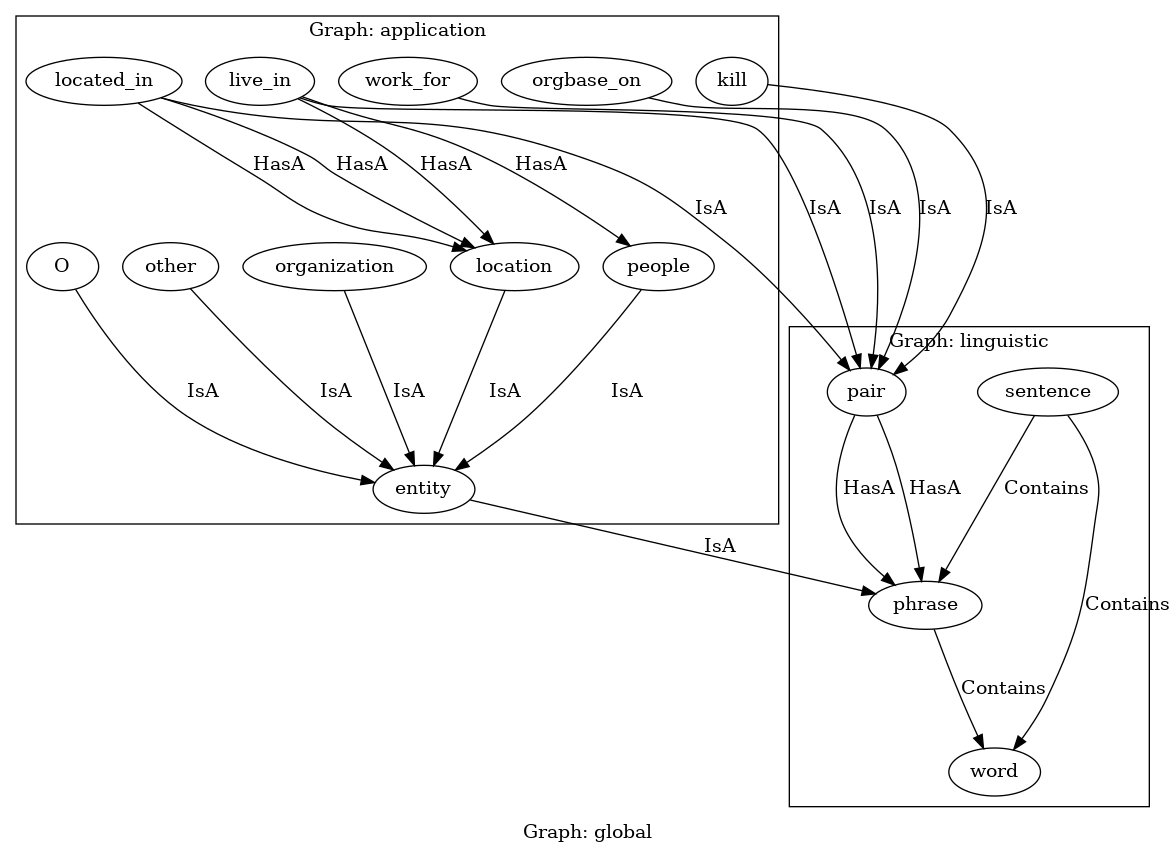

We demonstrate a library for the integration of domain knowledge in deep learning architectures. Using this library, the structure of the data is expressed symbolically via graph declarations and the logical constraints over outputs or latent variables can be seamlessly added to the deep models. The domain knowledge can be defined explicitly, which improves the models' explainability in addition to the performance and generalizability in the low-data regime. Several approaches for such an integration of symbolic and sub-symbolic models have been introduced; however, there is no library to facilitate the programming for such an integration in a generic way while various underlying algorithms can be used. Our library aims to simplify programming for such an integration in both training and inference phases while separating the knowledge representation from learning algorithms. We showcase various NLP benchmark tasks and beyond. The framework is publicly available at Github(https://github.com/HLR/DomiKnowS).

翻译:我们展示了一个将域知识纳入深层学习结构的图书馆。利用这个图书馆,数据结构通过图表声明象征性地表达,对产出或潜在变量的逻辑限制可以无缝地添加到深层模型中。可以明确界定域知识,除了低数据制度中的性能和可概括性外,还可以改进模型的解释性。采用了几种办法将象征性和亚心理模式结合起来;然而,在使用各种基本算法的同时,没有图书馆便利以通用方式为这种整合编制程序。我们的图书馆旨在简化在培训和推断阶段进行这种整合的方案编制,同时将知识代表与学习算法分开。我们展示了各种NLP基准任务及其他任务。该框架在Github(https://github.com/HLR/DomiKenes)公开提供。