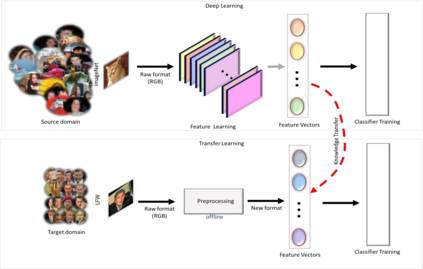

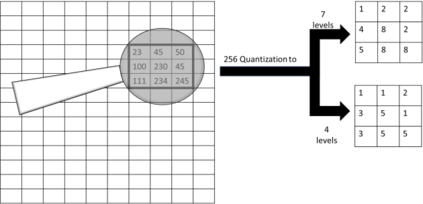

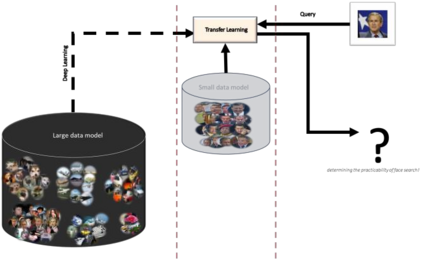

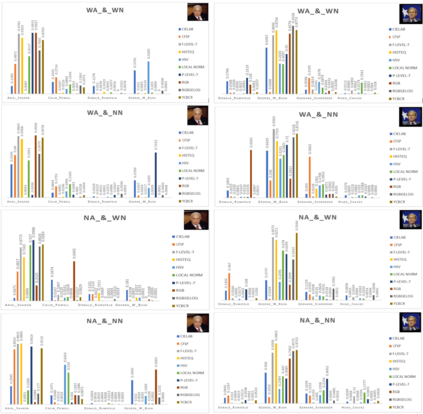

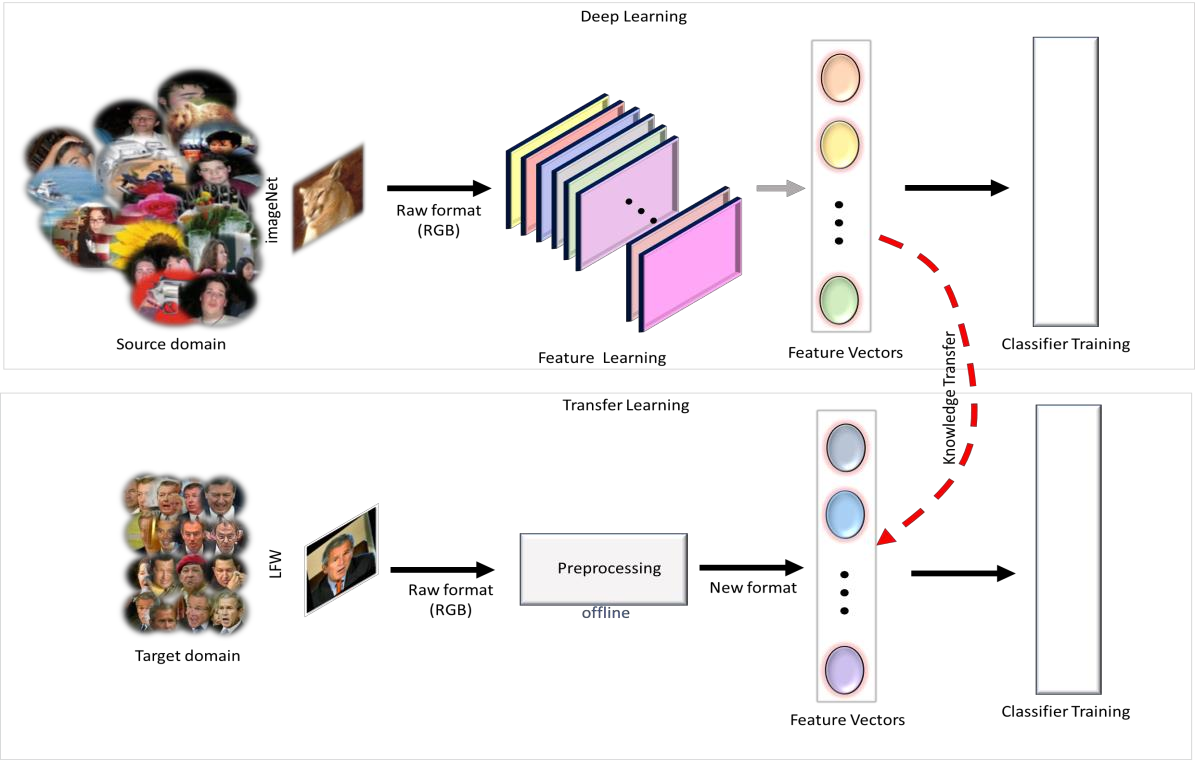

Deep networks have achieved huge successes in application domains like object and face recognition. The performance gain is attributed to different facets of the network architecture such as: depth of the convolutional layers, activation function, pooling, batch normalization, forward and back propagation and many more. However, very little emphasis is made on the preprocessors. Therefore, in this paper, the network's preprocessing module is varied across different preprocessing approaches while keeping constant other facets of the network architecture, to investigate the contribution preprocessing makes to the network. Commonly used preprocessors are the data augmentation and normalization and are termed conventional preprocessors. Others are termed the unconventional preprocessors, they are: color space converters; HSV, CIE L*a*b* and YCBCR, grey-level resolution preprocessors; full-based and plane-based image quantization, illumination normalization and insensitive feature preprocessing using: histogram equalization (HE), local contrast normalization (LN) and complete face structural pattern (CFSP). To achieve fixed network parameters, CNNs with transfer learning is employed. Knowledge from the high-level feature vectors of the Inception-V3 network is transferred to offline preprocessed LFW target data; and features trained using the SoftMax classifier for face identification. The experiments show that the discriminative capability of the deep networks can be improved by preprocessing RGB data with HE, full-based and plane-based quantization, rgbGELog, and YCBCR, preprocessors before feeding it to CNNs. However, for best performance, the right setup of preprocessed data with augmentation and/or normalization is required. The plane-based image quantization is found to increase the homogeneity of neighborhood pixels and utilizes reduced bit depth for better storage efficiency.

翻译:深度网络在物体和面部识别等应用领域取得了巨大成功。 绩效增益归因于网络结构的不同方面, 例如: 变异层深度、 激活功能、 集合、 批量正常化、 向前和向后传播等。 但是, 很少强调预处理器。 因此, 在本文中, 网络的预处理模块在不同预处理方法中各不相同, 同时保持网络结构的固定其他方面, 以调查预处理对网络的贡献。 常用预处理器是数据增强和正常化, 并被称为常规预处理器。 其他人被称为非常规预处理器, 它们是: 彩色空间转换器; HSV、 CIEL*a*b* 和 YCBCCR、 灰级解析前处理器; 完全基于和基于飞机的预处理模块的预处理模块有差异, 同时保持网络结构稳定( HE) 、 本地对比标准化(LN) 和完整的结构模式(CFF) 实现固定的网络参数, 使用有传输的最佳CNN 。 从高层次的地段预处理器转换空间空间空间空间转换器转换器转换系统,, 并用经机前的磁部前的磁部前系统 测试系统 测试系统 测试系统 升级 升级 将数据系统 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 系统 升级 升级 升级 升级 升级 升级 数据 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 数据 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级 升级