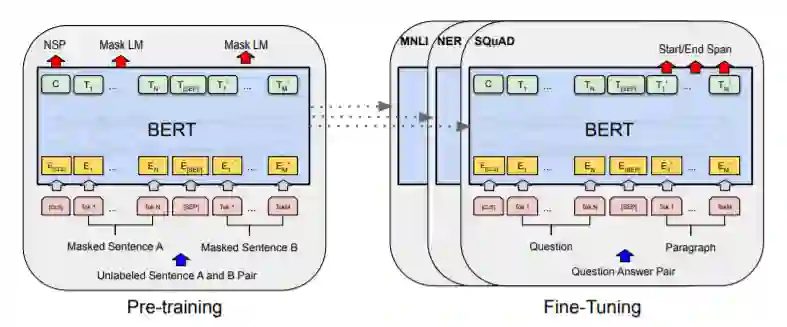

With increasing popularity of social media platforms hate speech is emerging as a major concern, where it expresses abusive speech that targets specific group characteristics, such as gender, religion or ethnicity to spread violence. Earlier people use to verbally deliver hate speeches but now with the expansion of technology, some people are deliberately using social media platforms to spread hate by posting, sharing, commenting, etc. Whether it is Christchurch mosque shootings or hate crimes against Asians in west, it has been observed that the convicts are very much influenced from hate text present online. Even though AI systems are in place to flag such text but one of the key challenges is to reduce the false positive rate (marking non hate as hate), so that these systems can detect hate speech without undermining the freedom of expression. In this paper, we use ETHOS hate speech detection dataset and analyze the performance of hate speech detection classifier by replacing or integrating the word embeddings (fastText (FT), GloVe (GV) or FT + GV) with static BERT embeddings (BE). With the extensive experimental trails it is observed that the neural network performed better with static BE compared to using FT, GV or FT + GV as word embeddings. In comparison to fine-tuned BERT, one metric that significantly improved is specificity.

翻译:随着社会媒体平台日益受欢迎,仇恨言论正在成为一个主要关切,因为社会媒体平台正在日益流行,仇恨言论正在成为一个主要关注问题,它表达了针对性别、宗教或族裔等特定群体特征的虐待性言论,以传播暴力。早期人们使用口头发表仇恨言论,但随着技术的扩展,一些人正在蓄意使用社交媒体平台,通过张贴、分享、评论等传播仇恨。 无论是基督教教堂清真寺的枪击事件,还是针对西方亚洲人的仇恨犯罪,人们发现罪犯受到网上仇恨文本的影响很大。 尽管已经建立了大赦国际系统,以标出此类文本,但主要挑战之一是降低假正率(将非仇恨标记为仇恨),以便这些系统能够检测仇恨言论,而不损害言论自由。 在本文中,我们使用ETHOS仇恨言论检测数据集,分析仇恨言论分类的性能,替换或整合嵌入词(fastText(FT)、GloVe(GV)或FT+GV),与静态的BERT(BEE)嵌入(BE)系统相比,与静态的GFFS(BF)系统相比,与静态化的GFT(GFT)系统相比,改进了网络。