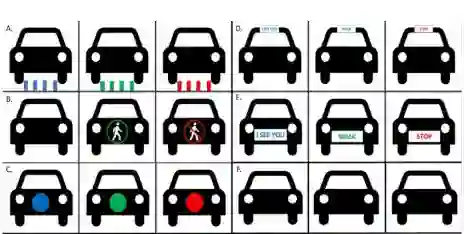

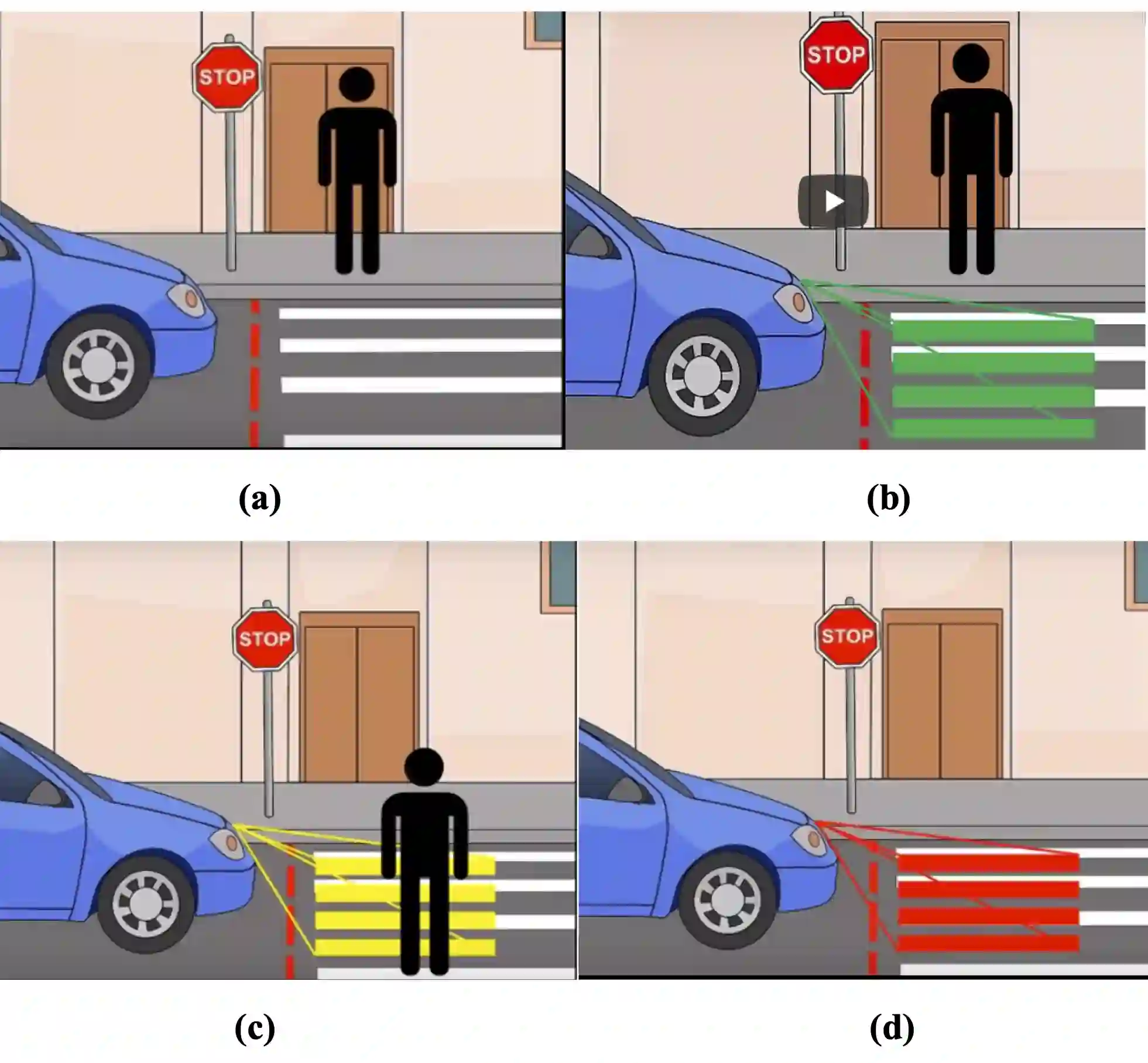

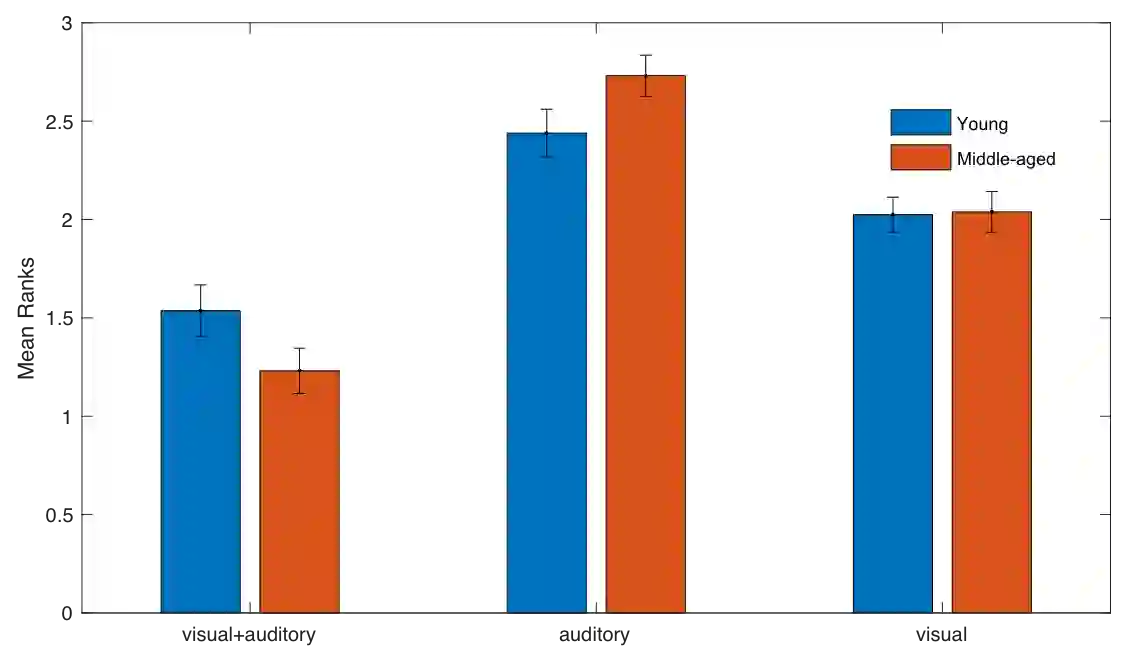

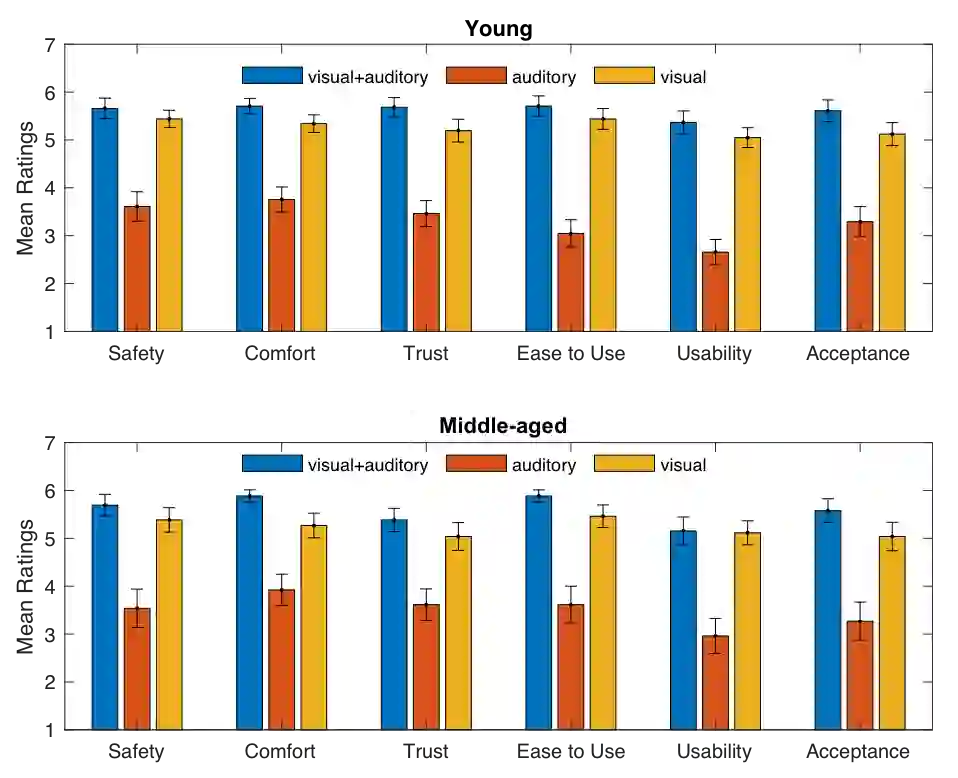

In this study, we investigated the effectiveness and user acceptance of three external interaction modalities (i.e., visual, auditory, and visual+auditory) in promoting communications between automated vehicle systems (AVS) and pedestrians at a crosswalk through a large number of combined designs. For this purpose, an online survey was designed and distributed to 68 participants. All participants reported their overall preferences for safety, comfort, trust, ease of understanding, usability, and acceptance towards the systems. Results showed that the visual+auditory interaction modality was the mostly preferred, followed by the visual interaction modality and then the auditory one. We also tested different visual and auditory interaction methods, and found that "Pedestrian silhouette on the front of the vehicle" was the best preferred option while middle-aged participants liked "Chime" much better than young participants though it was overall better preferred than others. Finally, communication between the AVS and pedestrians' phones was not well received due to privacy concerns. These results provided important interface design recommendations in identifying better combination of visual and auditory designs and therefore improving AVS communicating their intention with pedestrians.

翻译:在这项研究中,我们调查了三种外部互动模式(即视觉、听觉和视觉+听觉)在通过大量综合设计促进自动车辆系统(AVS)和横行行行人之间通信方面的有效性和用户接受度,为此设计了一个在线调查,分发给68名参与者;所有参与者都报告了他们对安全、舒适、信任、理解方便、易用和对系统的接受的总体偏好;结果显示,视觉+听觉互动模式最受青睐,其次是视觉互动模式,然后是听觉模式。我们还测试了不同的视觉和听觉互动方法,发现“在车辆前面的Pedestrian shoulette”是最好的选择,而中年参与者对“Chime”的偏好程度高于年轻参与者。最后,由于隐私问题,AVS和行人手机之间的通信没有得到很好的接受。这些结果提供了重要的界面设计建议,以确定视觉和听觉设计更好的组合,从而改进了与行人之间的AVS的意向。