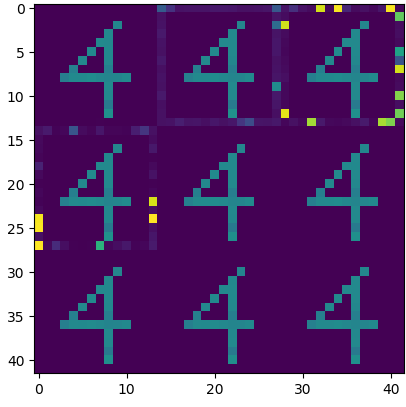

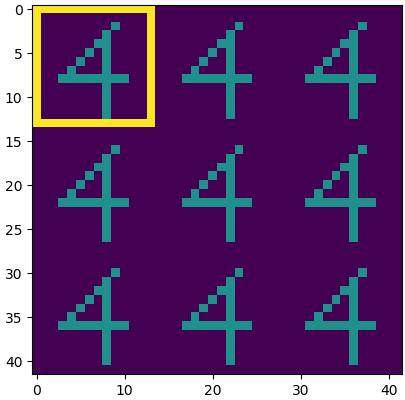

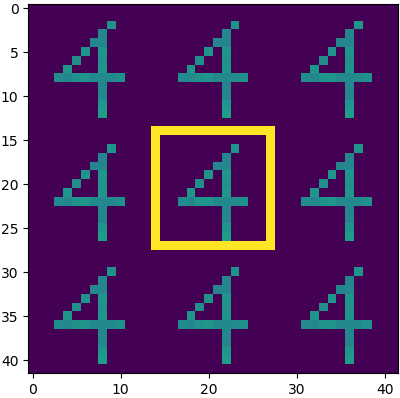

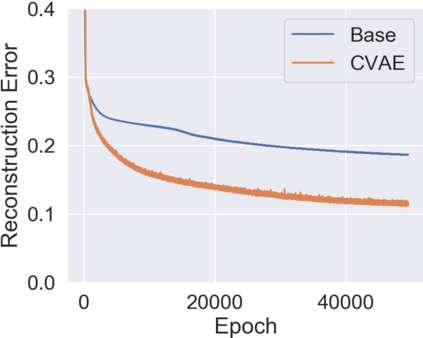

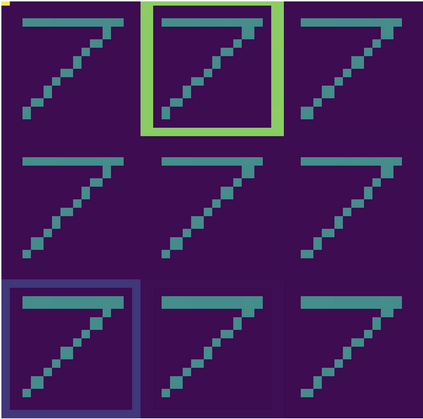

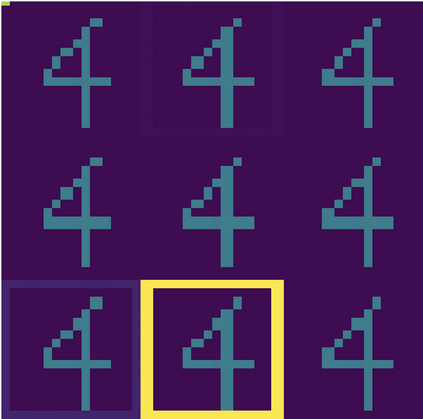

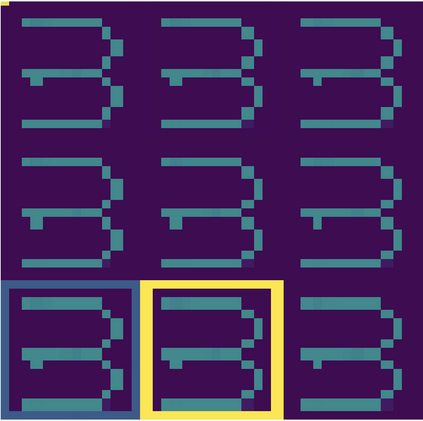

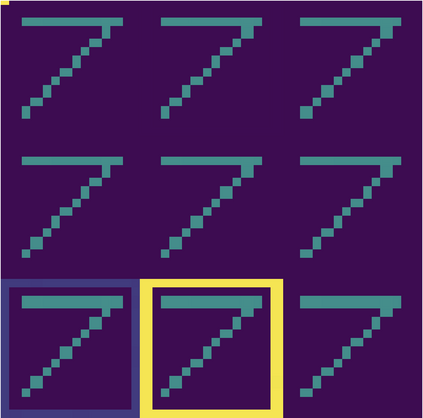

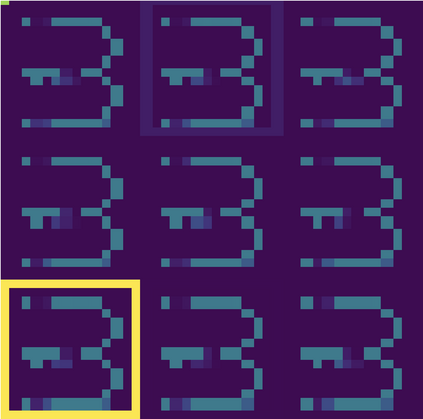

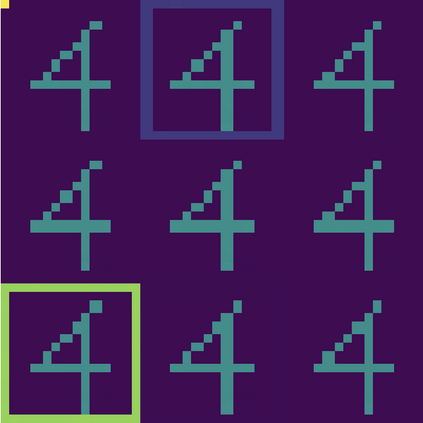

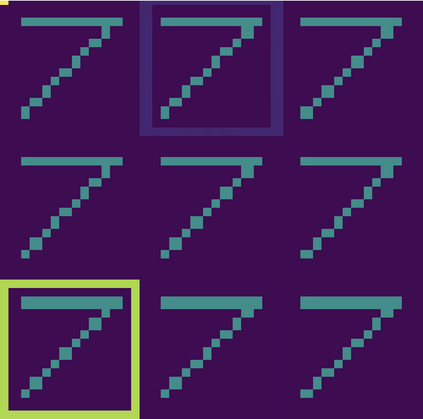

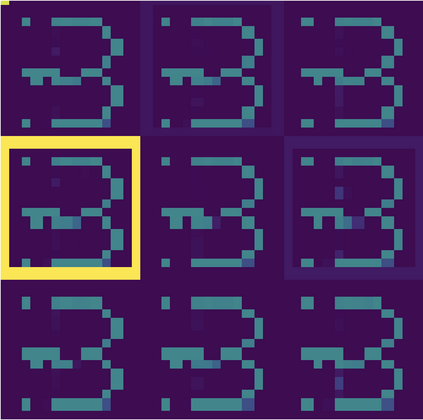

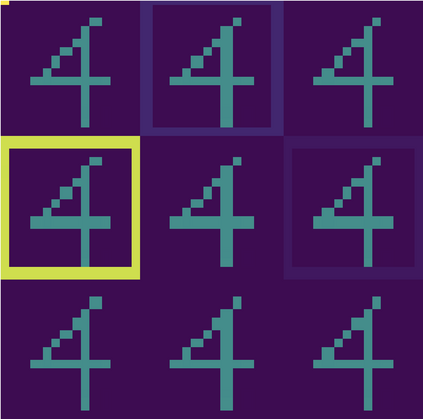

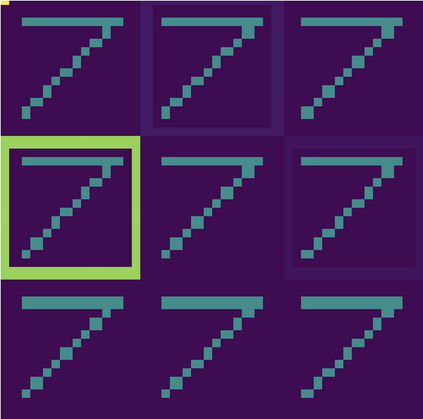

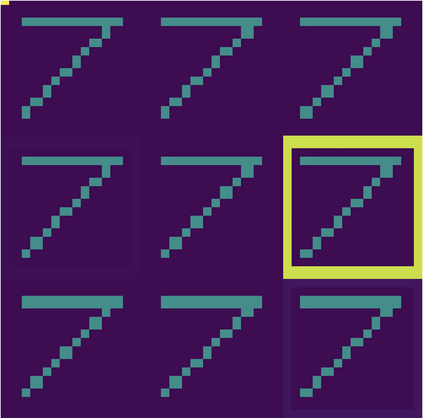

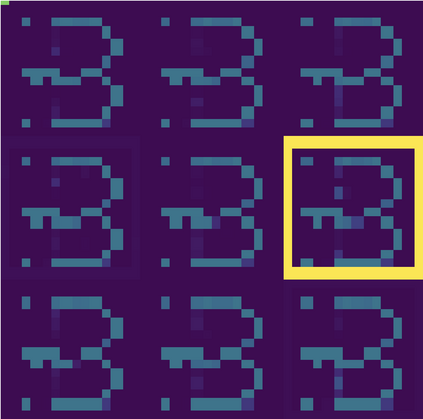

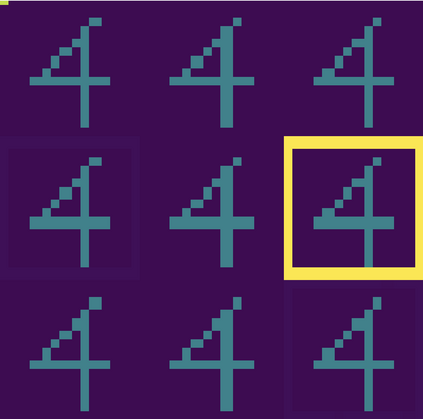

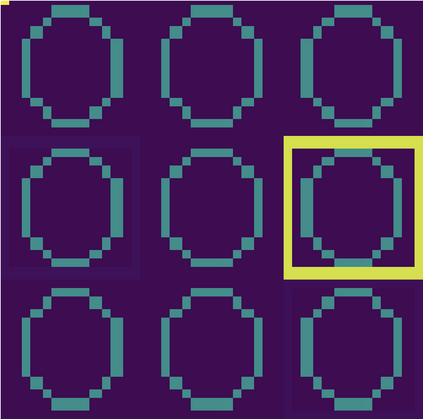

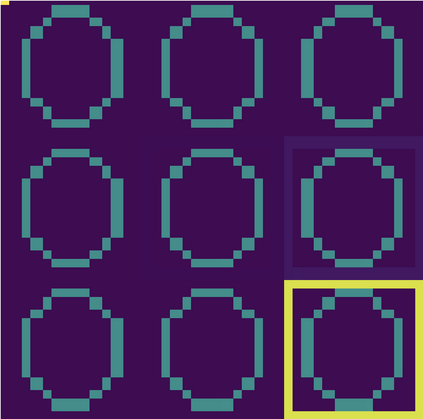

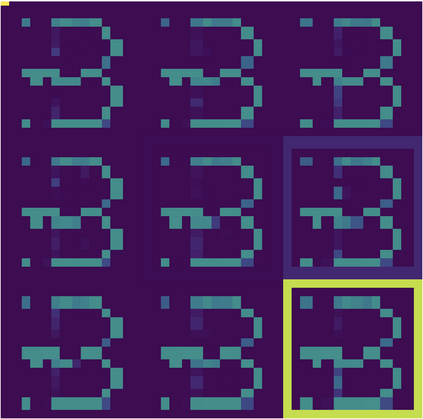

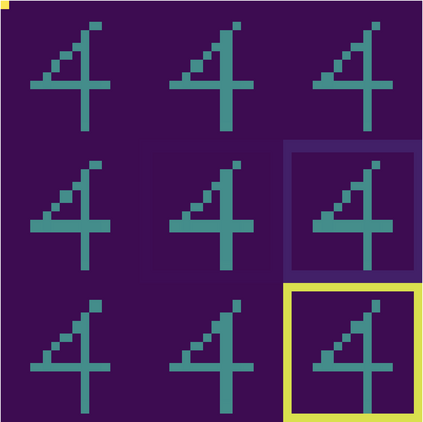

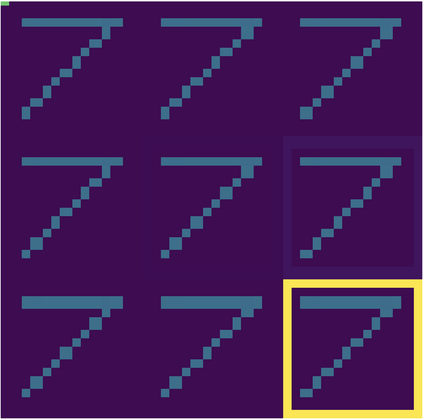

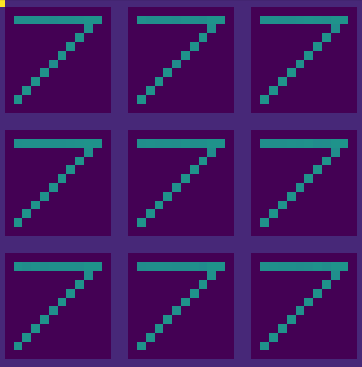

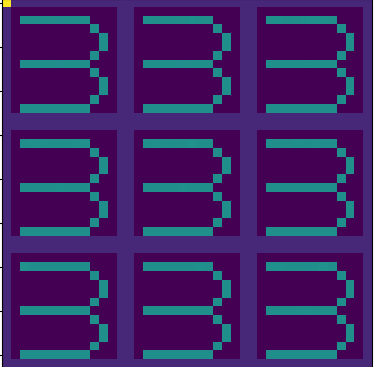

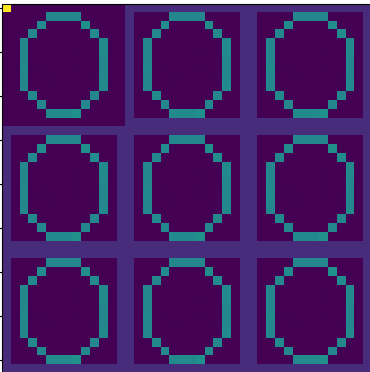

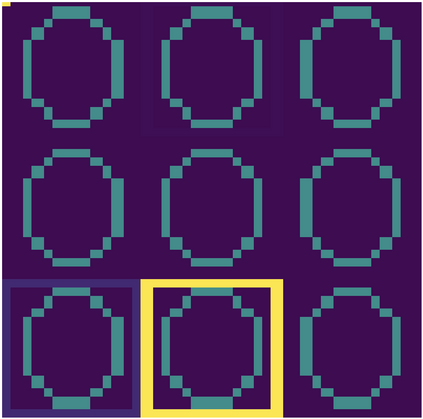

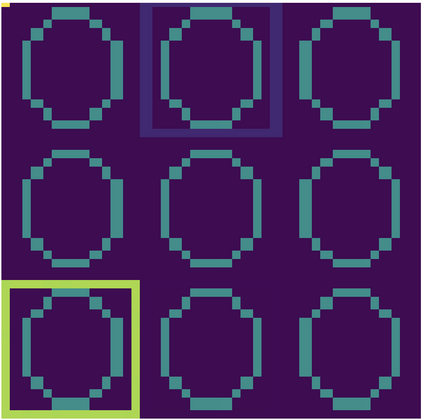

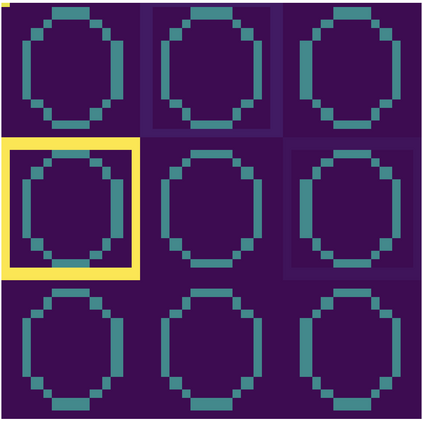

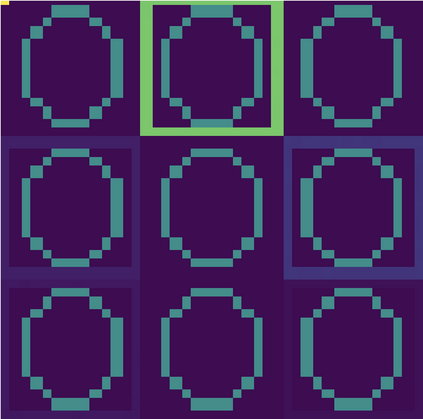

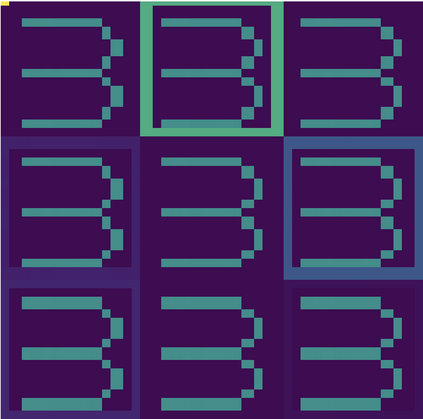

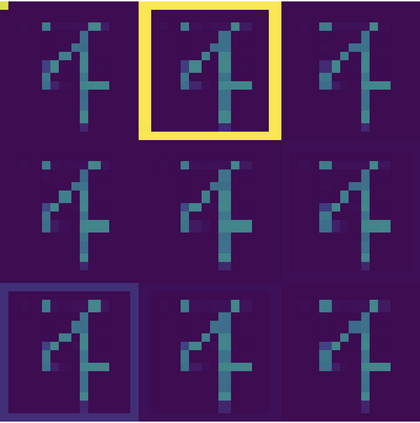

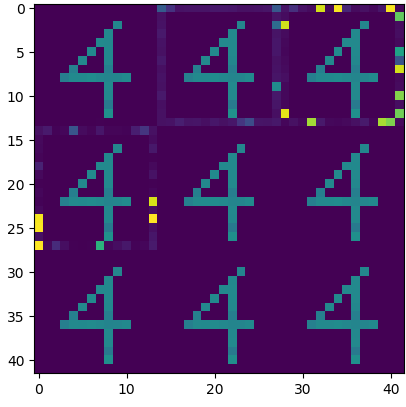

Cycle-consistent training is widely used for jointly learning a forward and inverse mapping between two domains of interest without the cumbersome requirement of collecting matched pairs within each domain. In this regard, the implicit assumption is that there exists (at least approximately) a ground-truth bijection such that a given input from either domain can be accurately reconstructed from successive application of the respective mappings. But in many applications no such bijection can be expected to exist and large reconstruction errors can compromise the success of cycle-consistent training. As one important instance of this limitation, we consider practically-relevant situations where there exists a many-to-one or surjective mapping between domains. To address this regime, we develop a conditional variational autoencoder (CVAE) approach that can be viewed as converting surjective mappings to implicit bijections whereby reconstruction errors in both directions can be minimized, and as a natural byproduct, realistic output diversity can be obtained in the one-to-many direction. As theoretical motivation, we analyze a simplified scenario whereby minima of the proposed CVAE-based energy function align with the recovery of ground-truth surjective mappings. On the empirical side, we consider a synthetic image dataset with known ground-truth, as well as a real-world application involving natural language generation from knowledge graphs and vice versa, a prototypical surjective case. For the latter, our CVAE pipeline can capture such many-to-one mappings during cycle training while promoting textural diversity for graph-to-text tasks. Our code is available at github.com/QipengGuo/CycleGT

翻译:循环协调培训被广泛用于在两个感兴趣的领域之间共同学习前方和反向绘图,而没有累赘地要求在每个领域收集匹配配对。 在这方面,隐含的假设是,存在(至少大约)一个条件性变异自动算法(CVAE),可以将任一领域的特定输入精确地从相继应用各自的映射中重建。但在许多应用中,无法预期存在这种双向图象,大型重建错误会损害周期一致培训的成功。作为这一限制的一个重要实例,我们考虑到存在不同领域间多对一或超导间线映射的实际相关情况。为了解决这个问题,我们开发了一个条件性变异自动解算法(CVAE) 方法,可以将预知性映射图转换成隐性图,从而将两个方向的重建错误最小化,作为自然副产品,可以在一对多个图象方向上获取现实的输出多样性。作为理论动机,我们分析一个简化的假设情景,即基于CVAE的侧能源函数与我们所了解的图像结合,同时将我们所知道的图像的翻版图像学应用。