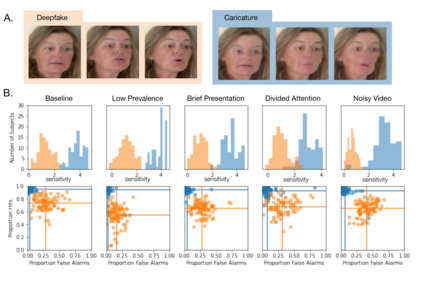

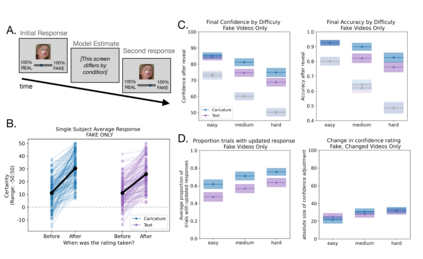

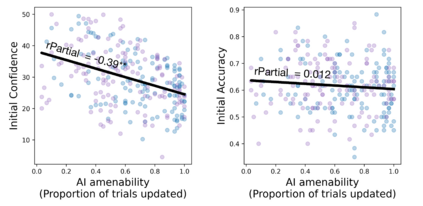

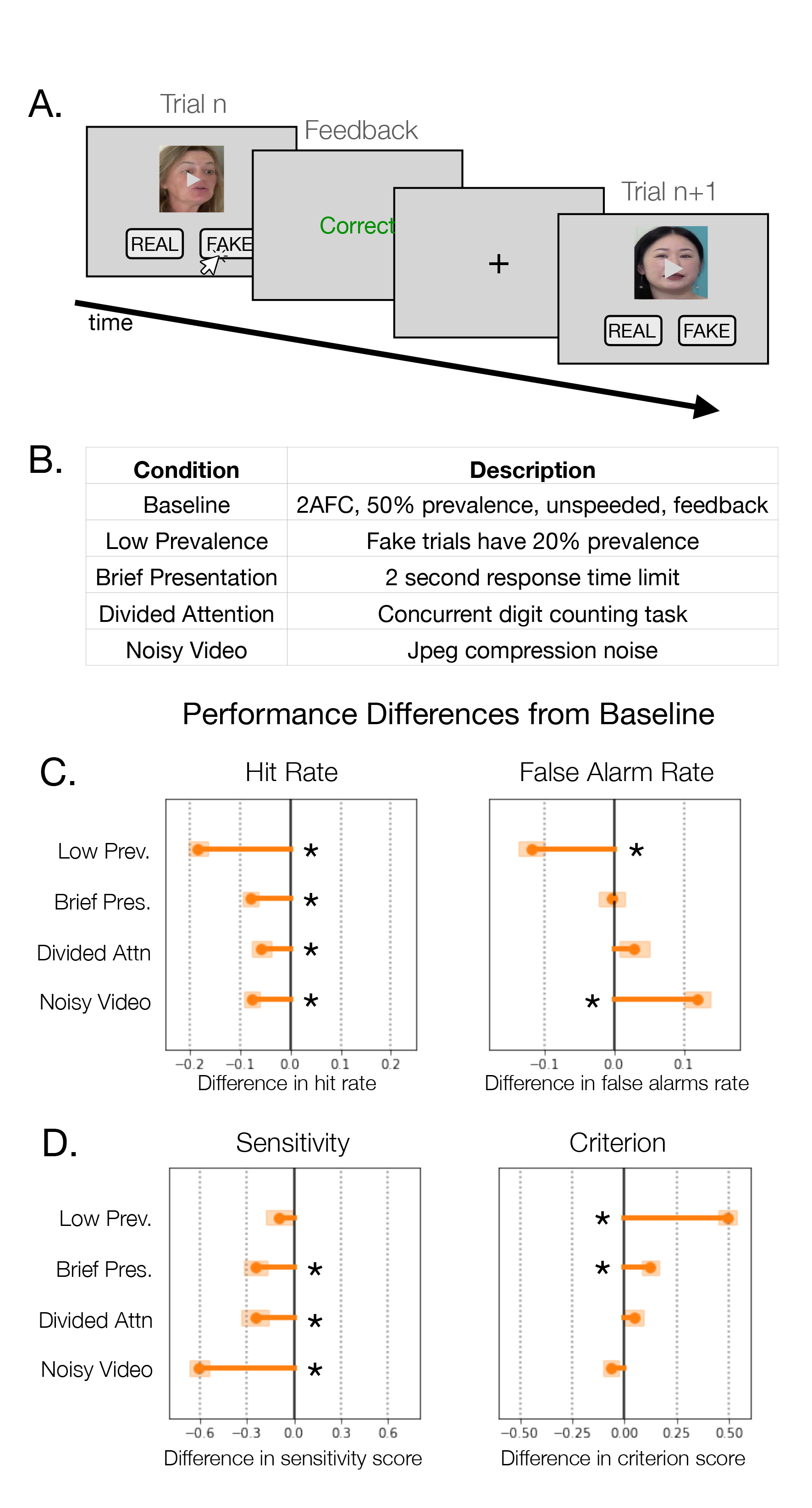

The development of technologies for easily and automatically falsifying video has raised practical questions about people's ability to detect false information online. How vulnerable are people to deepfake videos? What technologies can be applied to boost their performance? Human susceptibility to deepfake videos is typically measured in laboratory settings, which do not reflect the challenges of real-world browsing. In typical browsing, deepfakes are rare, engagement with the video may be short, participants may be distracted, or the video streaming quality may be degraded. Here, we tested deepfake detection under these ecological viewing conditions, and found that detection was lowered in all cases. Principles from signal detection theory indicated that different viewing conditions affected different dimensions of detection performance. Overall, this suggests that the current literature underestimates people's susceptibility to deepfakes. Next, we examined how computer vision models might be integrated into users' decision process to increase accuracy and confidence during deepfake detection. We evaluated the effectiveness of communicating the model's prediction to the user by amplifying artifacts in fake videos. We found that artifact amplification was highly effective at making fake video distinguishable from real, in a manner that was robust across viewing conditions. Additionally, compared to a traditional text-based prompt, artifact amplification was more convincing: people accepted the model's suggestion more often, and reported higher final confidence in their model-supported decision, particularly for more challenging videos. Overall, this suggests that visual indicators that cause distortions on fake videos may be highly effective at mitigating the impact of falsified video.

翻译:开发易于自动伪造视频的技术引发了人们对在线检测虚假信息能力的实际问题。人类对深度伪造视频的脆弱性如何?可以应用哪些技术来提高他们的性能?人类对深伪视频的易感性通常在实验室环境中进行测量,这不反映浏览现实世界的挑战。在典型的浏览中,深度假视频很少,与视频的接触可能很短,参与者可能会分心,或者视频流媒体质量可能会降低。在这里,我们在这些生态浏览条件下测试了深假检测,并发现在所有情况下检测都降低了。信号检测理论的原则表明,不同的浏览条件影响了检测性能的不同维度。总体而言,这表明目前的文献低估了人们对深假视频的易感性。接下来,我们研究了计算机视觉模型如何融入用户的决策过程,以提高深假检测的准确度和信心。我们评估了通过放大伪视频中的制品来向用户传达模型预测的有效性。我们发现,制品放大在区分伪造视频和真实视频方面非常有效,并且在各种浏览条件下都很稳健。此外,与传统的基于文本的提示相比,制品放大更具说服力:人们更经常接受模型的建议,并为更具挑战性的视频报告更高的最终信心。总体而言,这表明在伪造视频上引起畸变的视觉指示符可能在缓解伪造视频的影响方面非常有效。