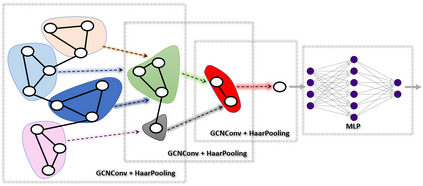

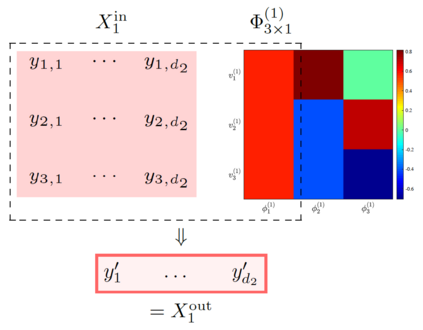

Deep Graph Neural Networks (GNNs) are instrumental in graph classification and graph-based regression tasks. In these tasks, graph pooling is a critical ingredient by which GNNs adapt to input graphs of varying size and structure. We propose a new graph pooling operation based on compressive Haar transforms, called HaarPooling. HaarPooling is computed following a chain of sequential clusterings of the input graph. The input of each pooling layer is transformed by the compressive Haar basis of the corresponding clustering. HaarPooling operates in the frequency domain by the synthesis of nodes in the same cluster and filters out fine detail information by compressive Haar transforms. Such transforms provide an effective characterization of the data and preserve the structure information of the input graph. By the sparsity of the Haar basis, the computation of HaarPooling is of linear complexity. The GNN with HaarPooling and existing graph convolution layers achieves state-of-the-art performance on diverse graph classification problems.

翻译:深图神经网络(GNNS) 有助于图形分类和基于图形的回归任务。 在这些任务中, 图形集合是一个关键元素, 使GNNS能够适应不同大小和结构的输入图形。 我们提议了一个新的图形集合操作, 其基础是压缩的Haar Pooling 。 Haar Pooling 是根据输入图的顺序组合链计算的。 每个集合层的输入由相应组群的压缩轴基质转换。 Haar Pooling 运行于频率域, 整合同一组群中的节点, 过滤压缩的Haar 变形的精细信息。 这种变形提供了数据的有效定性, 并保存了输入图的结构信息 。 根据 Haar 基础的宽度, Haar Pooling 的计算具有线性复杂性。 带有Haar Pooling 和现有图形变形层的GNNN在不同的图形分类问题上取得了最新业绩 。