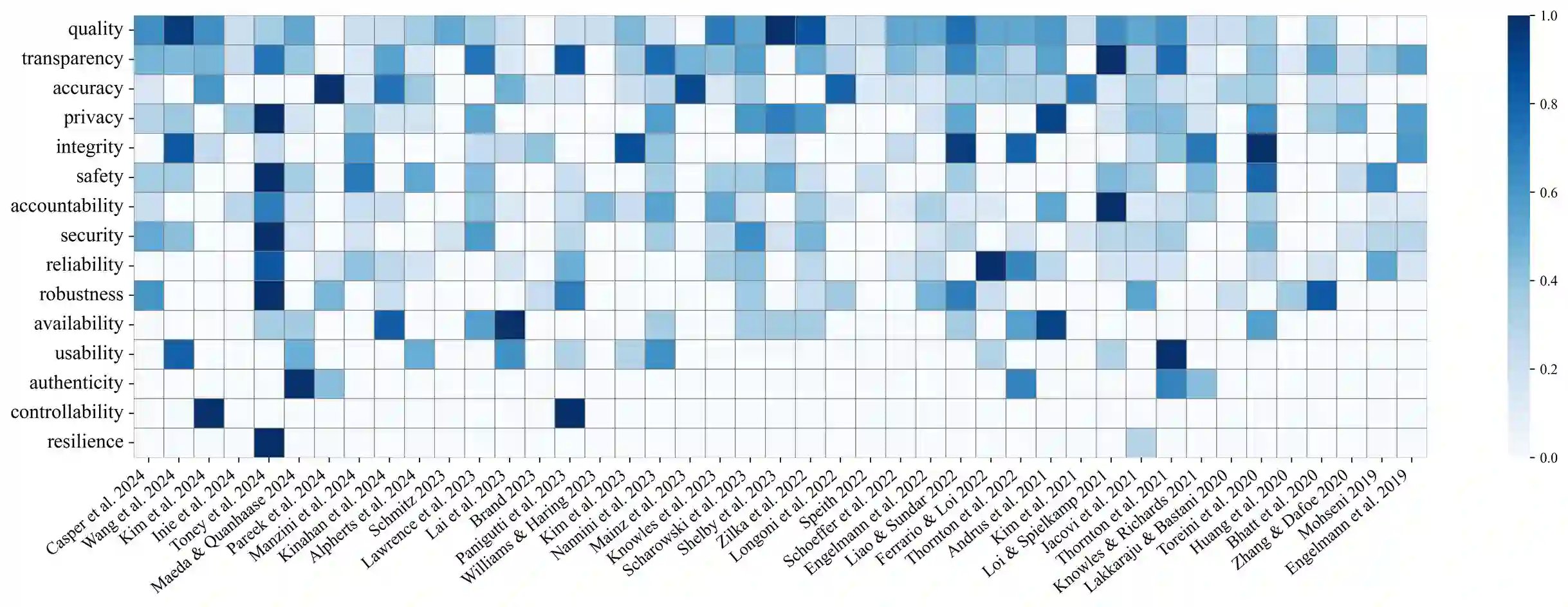

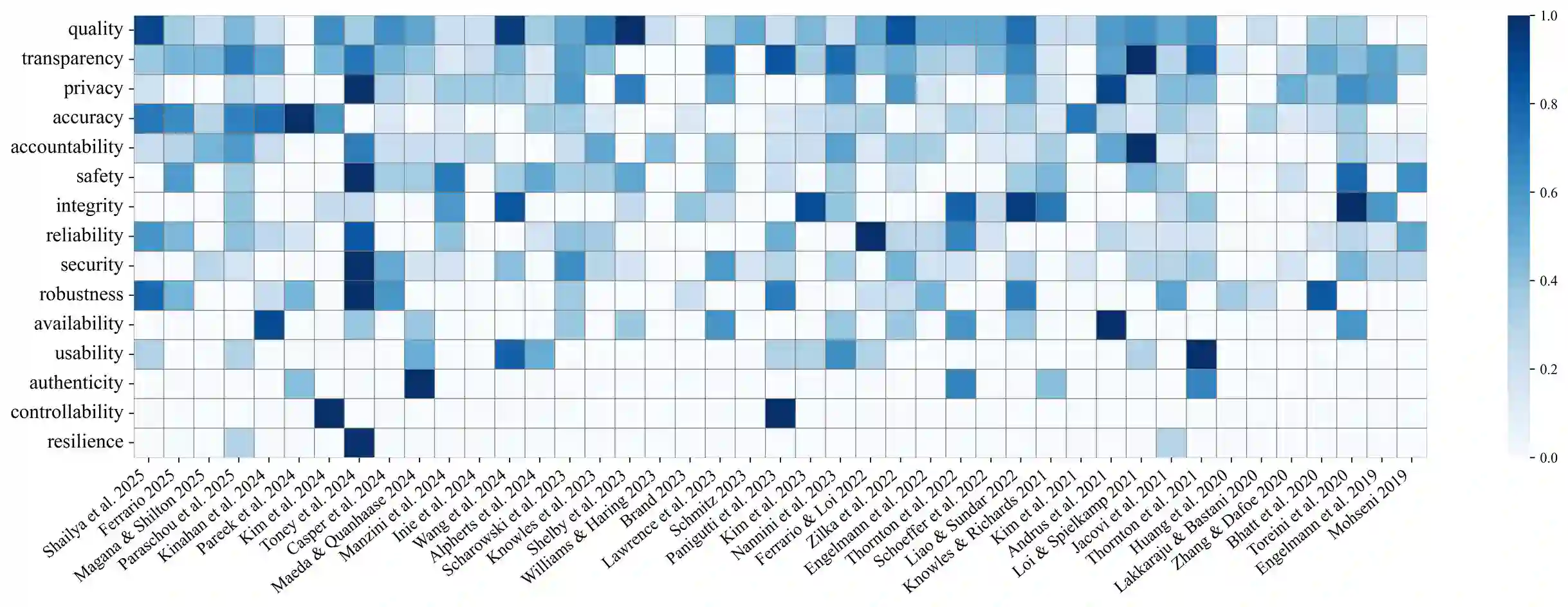

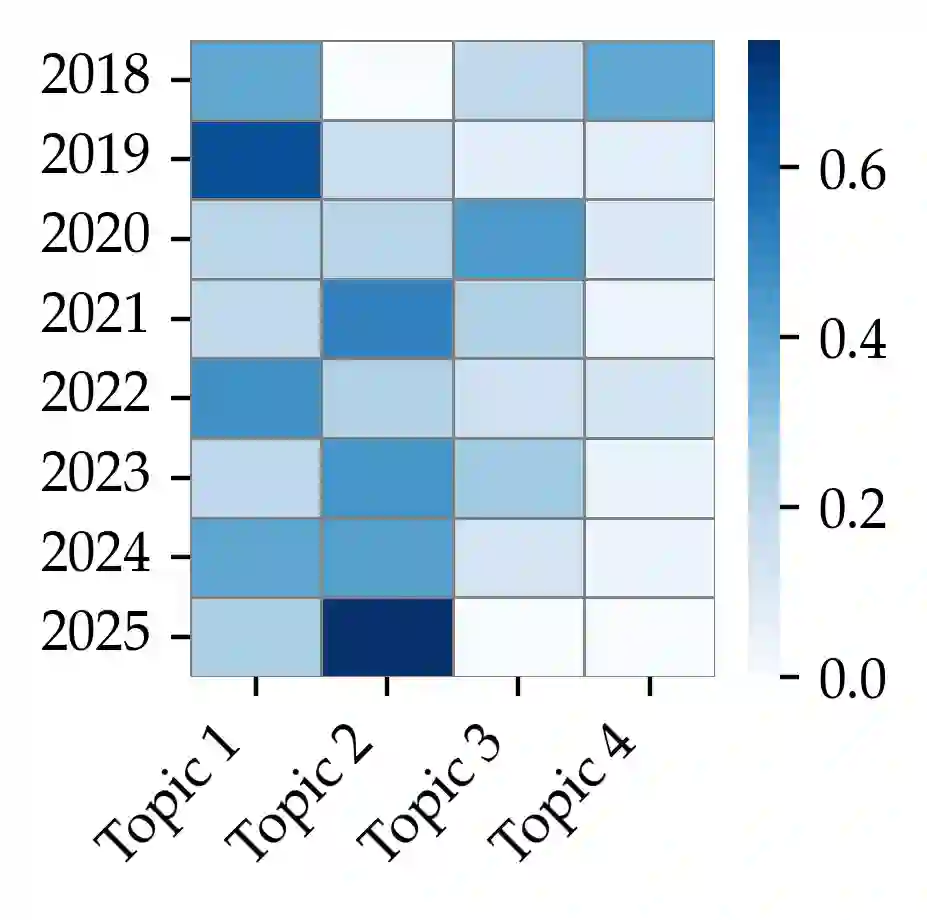

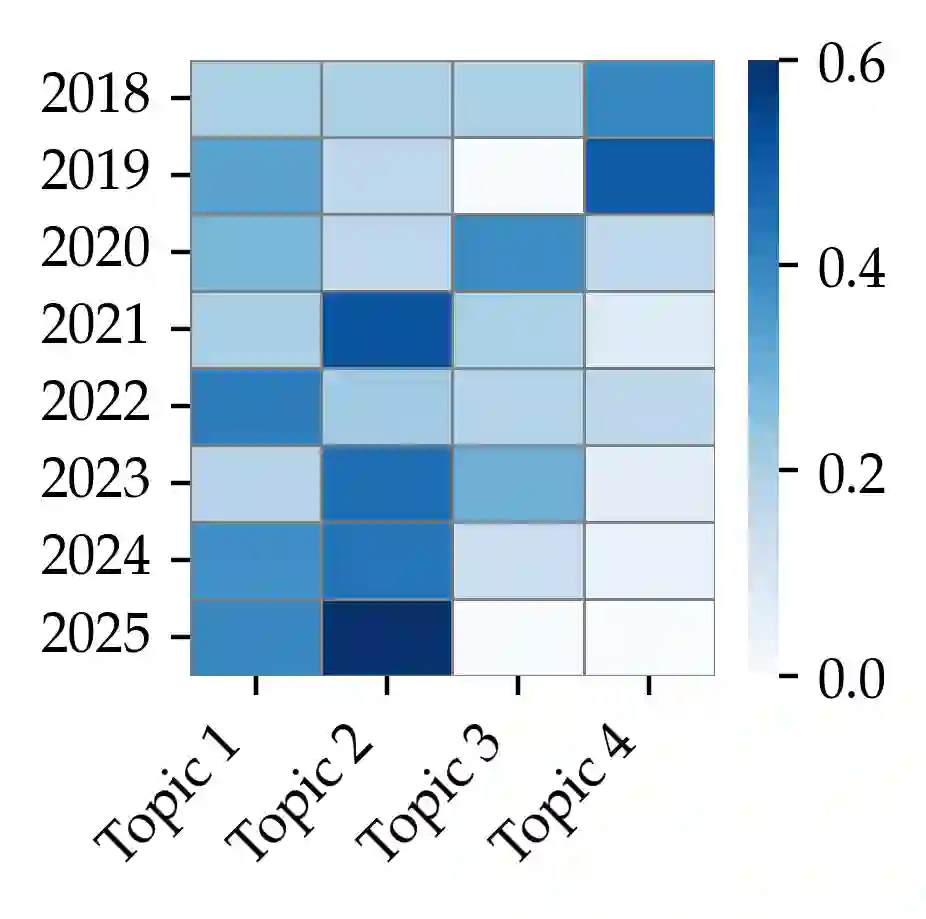

Background: Trustworthy AI serves as a foundational pillar for two major AI ethics conferences: AIES and FAccT. However, current research often adopts techno-centric approaches, focusing primarily on technical attributes such as reliability, robustness, and fairness, while overlooking the sociotechnical dimensions critical to understanding AI trustworthiness in real-world contexts. Objectives: This scoping review aims to examine how the AIES and FAccT communities conceptualize, measure, and validate AI trustworthiness, identifying major gaps and opportunities for advancing a holistic understanding of trustworthy AI systems. Methods: We conduct a scoping review of AIES and FAccT conference proceedings to date, systematically analyzing how trustworthiness is defined, operationalized, and applied across different research domains. Our analysis focuses on conceptualization approaches, measurement methods, verification and validation techniques, application areas, and underlying values. Results: While significant progress has been made in defining technical attributes such as transparency, accountability, and robustness, our findings reveal critical gaps. Current research often predominantly emphasizes technical precision at the expense of social and ethical considerations. The sociotechnical nature of AI systems remains less explored and trustworthiness emerges as a contested concept shaped by those with the power to define it. Conclusions: An interdisciplinary approach combining technical rigor with social, cultural, and institutional considerations is essential for advancing trustworthy AI. We propose actionable measures for the AI ethics community to adopt holistic frameworks that genuinely address the complex interplay between AI systems and society, ultimately promoting responsible technological development that benefits all stakeholders.

翻译:背景:可信人工智能是AIES和FAccT两大人工智能伦理会议的基础支柱。然而,当前研究常采用技术中心化方法,主要关注可靠性、鲁棒性和公平性等技术属性,而忽视了理解现实场景中人工智能可信度所必需的社会技术维度。目标:本范围综述旨在探究AIES和FAccT学界如何概念化、度量和验证人工智能可信度,识别主要研究缺口,并为推进可信人工智能系统的整体理解提供机遇。方法:我们对迄今AIES和FAccT会议论文集进行范围综述,系统分析可信度在不同研究领域中的定义、操作化及应用方式。分析聚焦于概念化路径、度量方法、验证与确认技术、应用领域及基础价值取向。结果:尽管在透明度、问责制和鲁棒性等技术属性的定义方面已取得显著进展,但研究发现仍存在关键缺口。当前研究常过度强调技术精确性,却以牺牲社会伦理考量作为代价。人工智能系统的社会技术本质仍未被充分探索,可信度已成为由定义权持有者塑造的争议性概念。结论:融合技术严谨性与社会、文化及制度考量的跨学科方法对推进可信人工智能至关重要。我们为人工智能伦理学界提出可操作建议,倡导采用真正应对人工智能系统与社会复杂互动的整体框架,最终促进惠及所有利益相关方的负责任技术发展。