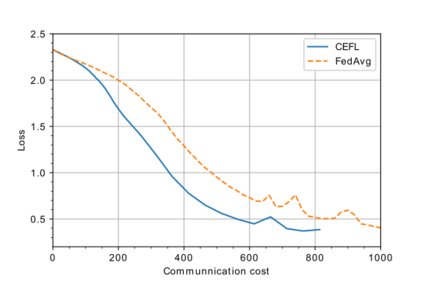

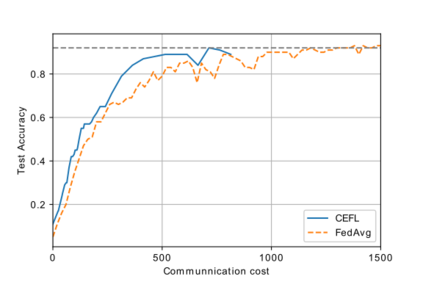

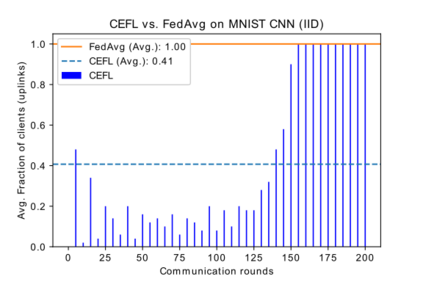

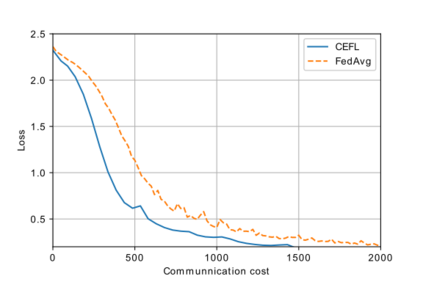

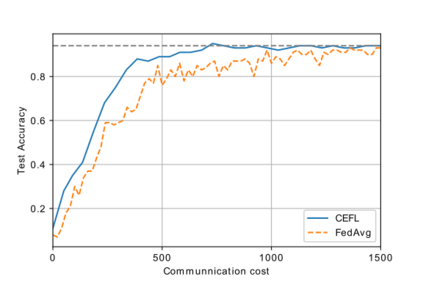

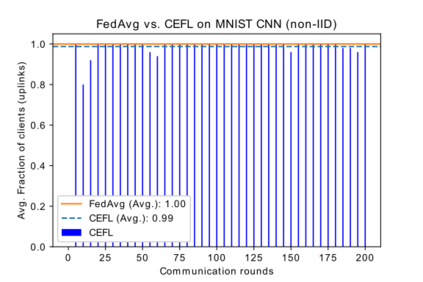

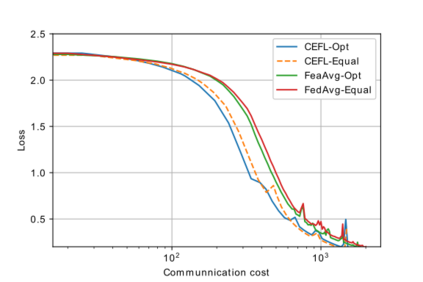

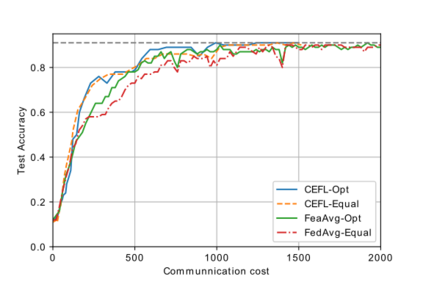

To leverage massive distributed data and computation resources, machine learning in the network edge is considered to be a promising technique especially for large-scale model training. Federated learning (FL), as a paradigm of collaborative learning techniques, has obtained increasing research attention with the benefits of communication efficiency and improved data privacy. Due to the lossy communication channels and limited communication resources (e.g., bandwidth and power), it is of interest to investigate fast responding and accurate FL schemes over wireless systems. Hence, we investigate the problem of jointly optimized communication efficiency and resources for FL over wireless Internet of things (IoT) networks. To reduce complexity, we divide the overall optimization problem into two sub-problems, i.e., the client scheduling problem and the resource allocation problem. To reduce the communication costs for FL in wireless IoT networks, a new client scheduling policy is proposed by reusing stale local model parameters. To maximize successful information exchange over networks, a Lagrange multiplier method is first leveraged by decoupling variables including power variables, bandwidth variables and transmission indicators. Then a linear-search based power and bandwidth allocation method is developed. Given appropriate hyper-parameters, we show that the proposed communication-efficient federated learning (CEFL) framework converges at a strong linear rate. Through extensive experiments, it is revealed that the proposed CEFL framework substantially boosts both the communication efficiency and learning performance of both training loss and test accuracy for FL over wireless IoT networks compared to a basic FL approach with uniform resource allocation.

翻译:为了利用大规模分布的数据和计算资源,网络边缘的机器学习被认为是一个很有希望的技术,特别是大规模模型培训。作为协作学习技术的范例,联邦学习(FL)已经获得越来越多的研究关注,并受益于通信效率和数据隐私的改善。由于通信渠道丢失,通信资源(例如带宽和电力)有限,因此有兴趣对无线系统进行快速反应和准确的FL计划进行调查。因此,我们调查了通过无线互联网(IoT)网络联合优化FL通信效率和资源的问题。为降低复杂性,我们将总体优化问题分为两个次级问题,即客户排期问题和资源配置问题。为了降低无线IoT网络中的FL通信成本,建议采用新的客户排期政策,重新使用平坦的本地模型参数。为了在网络上最大限度地实现成功的信息交流,首先通过分解变量,包括电力变量、带宽变量和传输指标,来优化FL的通信效率问题。然后,我们将基于线性研究的电力和带宽度分配问题分为两个子分级分配问题,即客户排时间问题和资源分配问题。为无线性IOT网络的升级化测试框架,我们提议通过适当的超高水平的FL学习,通过高水平测试框架,通过高压化学习,提出一个测试框架。我们提议的FLLFLLLLLFLL试验,通过适当的升级化的深度学习,通过适当的学习,从深级化的进度式学习进行广泛的学习。我们制式式学习。我们学习。