当今社会,人工智能正在改变临床诊断、自动驾驶、语音翻译等各个领域。但是,数据量的快速增长给AI中使用的电子计算硬件带来了巨大的挑战,计算速度和功耗问题已成为人工智能的主要瓶颈。Xu等人和Feldmann等人的两篇论文报告了一种通过利用光的独特属性来加速AI处理的光子处理器。这些报告引发了光学计算的复兴。

随着人工智能的兴起,传统的电子计算方式逐渐达到其性能极限,远远落后于可处理数据的快速增长。在各种类型的AI中,神经网络由于其出色的表现而被广泛用于AI任务中。这些网络使用多层相互连接的人工神经元执行复杂的数学运算,其中占用了大多数计算资源的基本运算是矩阵向量乘法。

研究人员进行了各种努力来设计和实现特定的电子计算系统,以加速人工神经网络中的计算。尤其是专用集成电路、脑启发计算和内存内计算(使用称为忆阻器的一组存储设备在原位执行计算)等定制芯片的使用已经取得了相当大的成功。

虽然在电子计算中信息的载体是电子,但是光子长期以来一直被视为一种可行的替代方案。由于光谱涵盖的波长范围更加广泛,许多不同波长的光可以同时进行多路复用(并行传输)和调制(改变得可以携带信息),而不会相互干扰光信号。此外,信息以光速传播会使时间延迟达到最小,无源传输(不需要输入功率)有助于超低功耗,并且相位调制(用来改变光波的量子力学相位)使光可以轻易地在大于40 GHz的频率下调制和检测。

在过去的几十年里,光纤通信取得了巨大的成功。但是,利用光子进行计算仍然具有挑战性,尤其是在与先进的电子处理器相当的规模和性能水平上。其困难来源于缺乏合适的并行计算机制、允许人工神经元进行复杂的高速非线性响应的材料以及可集成到计算硬件中的可扩展光子设备。

幸运的是,过去几年中一种被称为光学频率梳的设备的发展为集成光子处理器带来了新的机遇。光学频率梳是一种具有发射光谱的光源,其频谱由成千上万条离散的、等距的频率线组成。这种设备在光谱学、光学时钟计量学、电信等各个领域都取得了巨大的成功,并获得了2005年诺贝尔物理学奖。光学频率梳可以被用作光学计算的节能电源集成到计算机芯片中,并且该系统非常适合通过波长复用进行数据并行化处理。

Xu及其同事就是使用这种设备来制造通用的集成光子处理器,该设备用来执行一种相当于图像处理中的卷积的矩阵向量乘法。Xu和他的团队使用了一种巧妙的方法来实现卷积:首先用色散让波长复用的光信号产生不同的时间延迟(光的传输速度取决于其波长),然后沿着与光的波长相关的维度组合这些信号。

通过充分利用大范围的光子波长,Xu和他的团队实现了本质上是不同卷积运算的并行计算。使用单个处理内核的光计算速度超过 10 万亿次/秒,并且仅受数据吞吐量的限制。这项工作值得肯定的另一点是,他们还确定了其光子卷积处理器在实际应用中的切入点。他们建议处理器在光电子混合框架中使用,如在光纤通信过程中进行原位计算。

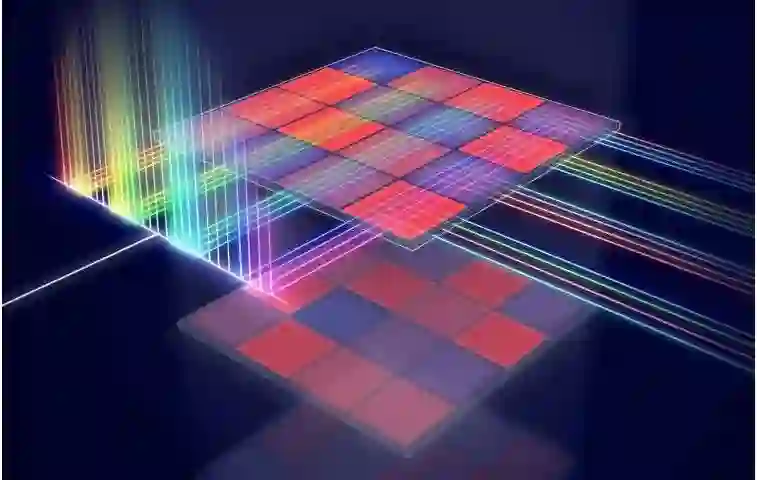

Feldmann和他的同事也独立地制造出一个集成光子处理器,该处理器可执行涉及跨越二维光信号的卷积。该设备在基于相变材料(可以在非晶相和结晶相之间切换的材料)的内存内计算架构中使用了光学频率梳。他们通过波长复用和使用相变材料集成的单元阵列模拟矩阵向量乘法,对输入数据进行了完全并行化处理。

这种高度并行化的框架具有在单个步骤中高速处理整个图像的潜力。此外,原则上来说,该系统可以按照商业制造规程进行大规模扩展,并有助于在不久的将来实现实时的机器学习。由于该卷积过程涉及无源传输,因此理论上光子处理器可以以光速和低功耗执行计算。对于像云计算这种能源密集型应用而言,这种能力是非常有价值的。

鉴于传统电子计算方式面临诸多挑战,集成光子技术的出现或许能成为实现未来计算架构性能大幅提升的潜在继任者。但是,构建实用的光学计算机将需要材料科学、光学、电子学等领域的研究人员共同努力,加强跨学科合作。尽管报道的光子处理器具有较高的单位面积计算能力和潜在的可延展性,但是完全光计算的规模(光学人工神经元的数量)仍然很小。并且,能量效率受到固有地吸收光的计算元件以及电信号和光信号需要频繁相互转换的限制。

另一个研究路径是开发高等非线性集成光子计算体系结构,而不是一维或二维线性卷积。通过将电子电路和数千或数百万个光子处理器集成到合适的体系结构中,同时利用光子和电子处理器的混合光电框架可以在不久的将来革新AI硬件的发展。这样的硬件将在通信、大数据和云计算等领域具有重要的应用。

https://www.nature.com/articles/d41586-020-03572-y

Huaqiang Wu & Qionghai Dai

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com