学界 | 新研究将GRU简化成单门架构,或更适用于语音识别

选自arXiv

机器之心编译

参与:Panda

Yoshua Bengio 领导的一个团队近日在 arXiv 上发布了一篇论文,介绍了他们通过修改门控循环单元(GRU)提升语音识别效果的研究进展。据介绍,这项研究是修改 GRU 方面的进一步研究进展,提出了一种可能更加适合语音识别的架构。机器之心对本论文进行了摘要介绍。另外,本研究相关的实验代码也已发布在 GitHub 上。

论文:https://arxiv.org/abs/1710.00641v1

代码:https://github.com/mravanelli/theano-kaldi-rnn

本论文有两大贡献:

第一,我们提出从网络设计中移除重置门(reset gate)。与 [31] 类似,我们发现移除重置门并不会影响系统的表现,因为我们观察到在更新门(update gate)和重置门发挥的作用上存在一定的冗余。

第二,我们提出在状态更新过程中使用修正线性单元(ReLU)激活函数替代双曲正切(tanh)。在过去,由于 ReLU 激活函数的无界性所引起的数值不稳定性,我们会在 RNN 上避开这样的非线性。但是,当我们将基于 ReLU 的 GRU 架构与批规范化(batch normalization)[4] 结合到一起时,我们没有遇到这样的数值问题。这让我们可以使用 ReLU 神经元了,这种神经元已经在进一步缓解梯度消失问题以及加速网络训练上得到了有效的证明。

我们在多种不同的任务、输入特征和噪声条件上进行了实验,结果表明:在我们的实现中,这种修改后的架构可以将每 epoch 的训练时钟时间减少 30% 以上,同时在本研究所涉及的所有实验条件中都实现了识别水平的提升。

论文:通过修改门控循环单元改善语音识别(Improving speech recognition by revising gated recurrent units)

语音识别正在广泛使用深度学习,表明现代循环神经网络(RNN)具有很多显著优势。最流行的 RNN 是长短期记忆(LSTM),由于它们学习长期依赖性和对梯度消失保持稳健的能力,它们往往能在很多任务上达到当前最佳的表现。尽管如此,LSTM 有一种带有三个乘法门的相当复杂的设计,这可能会妨碍 LSTM 的有效实现。最近对 LSTM 的一次简化尝试为我们带来了门控循环单元(GRU),它只基于两个乘法门。

本论文立足于这些成果,通过进一步修改 GRU 提出了一种简化的架构,该架构可能更加适合语音识别。本研究有两大贡献。第一,我们提出移除 GRU 设计中的重置门,从而得到一种更高效的单门架构。第二,我们提出在状态更新过程中使用 ReLU 激活函数替代 tanh。结果表明,在我们的实现中,比起标准的 GRU,这种修改后的架构可以将每 epoch 的训练时钟时间减少 30% 以上,同时还能在多种不同的任务、输入特征和噪声条件上都实现识别表现的提升。

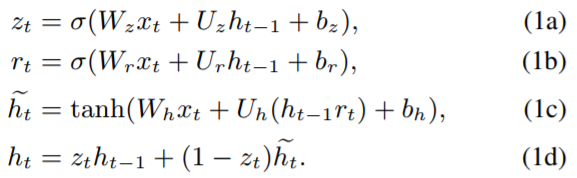

一般的 GRU 架构定义如下:

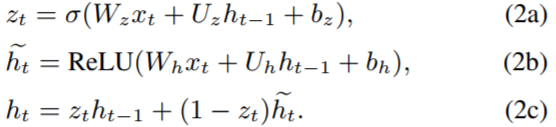

移除重置门并且使用 ReLU 激活函数替代 tanh 后,我们可以得到新的公式:

我们将这个架构称为 M-reluGRU。

我们使用 Theano 实现了我们提出的这个系统,并且结合使用 Kaldi 解码器 [35] 创建了一个具有语境依赖的 DNN/HMM 语音识别器。实验代码请访问:https://github.com/mravanelli/theano-kaldi-rnn/

在 TIMIT 上的结果

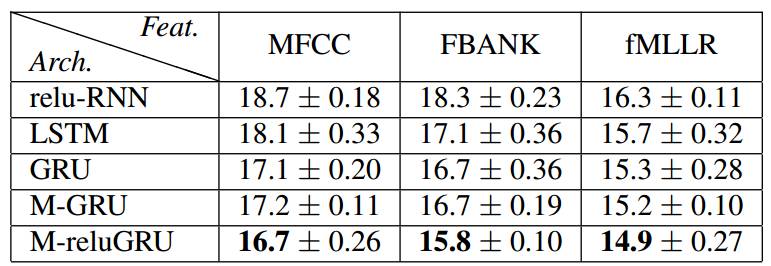

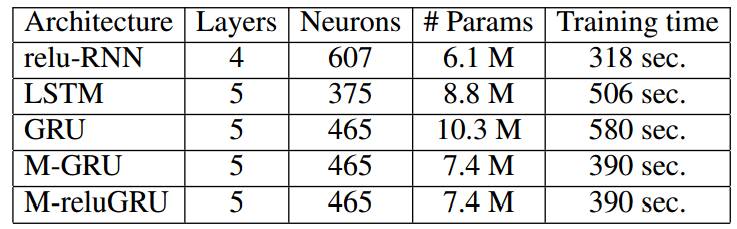

表 1:各种 RNN 架构在 TIMIT 的测试集上所得到的音素错误率(PER%)

表 2:在 TIMIT 开发集上优化过的 RNN 架构的每 epoch 训练时间比较

在 DIRHA English WSJ 上的结果

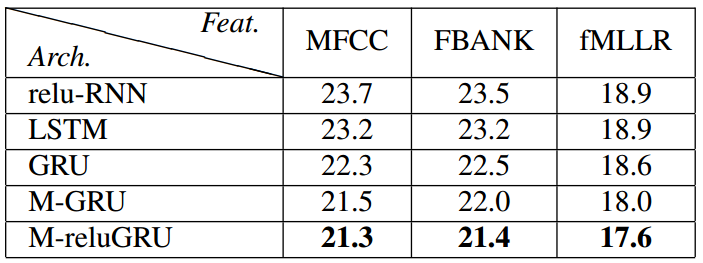

表 3:各种 RNN 架构在 DIRHA English WSJ 数据集(仿真的部分)上所得到的词错率(%)

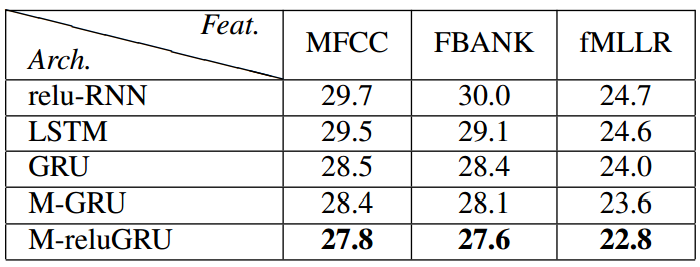

表 4:各种 RNN 架构在 DIRHA English WSJ 数据集(真实部分)上所得到的词错率(%)

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者/实习生):hr@jiqizhixin.com

投稿或寻求报道:content@jiqizhixin.com

广告&商务合作:bd@jiqizhixin.com