ACL 2019 | 通过问题分解和重新打分,让机器学会做多跳阅读理解

作者丨袁一鸣

学校丨武汉大学硕士生

研究方向丨对话系统、目标检测

本文是由华盛顿大学以及艾伦人工智能研究所联合发表在自然语言处理顶会 ACL 2019 的一篇有关多跳机器阅读理解的文章,其代码已开源在:

概述

主要工作

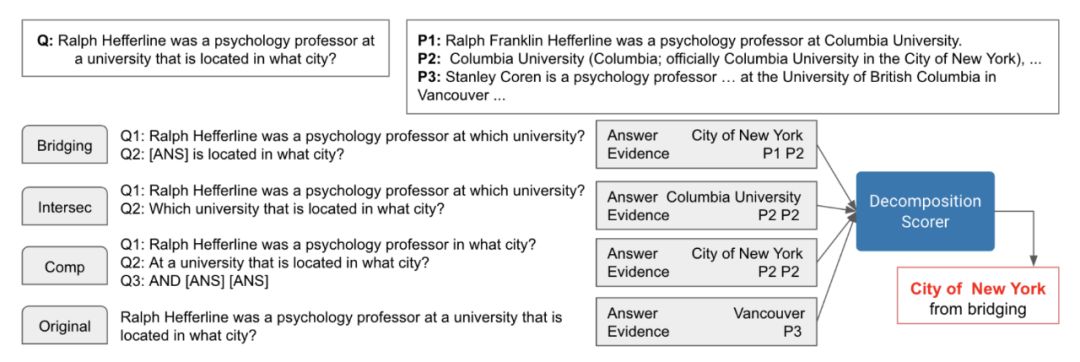

▲ 图1. 系统工作原理

组合问题分解

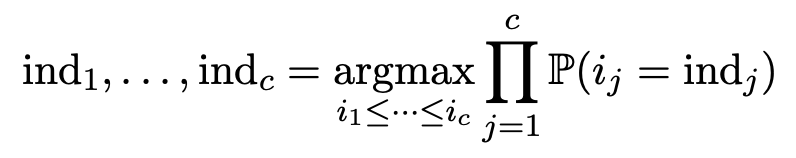

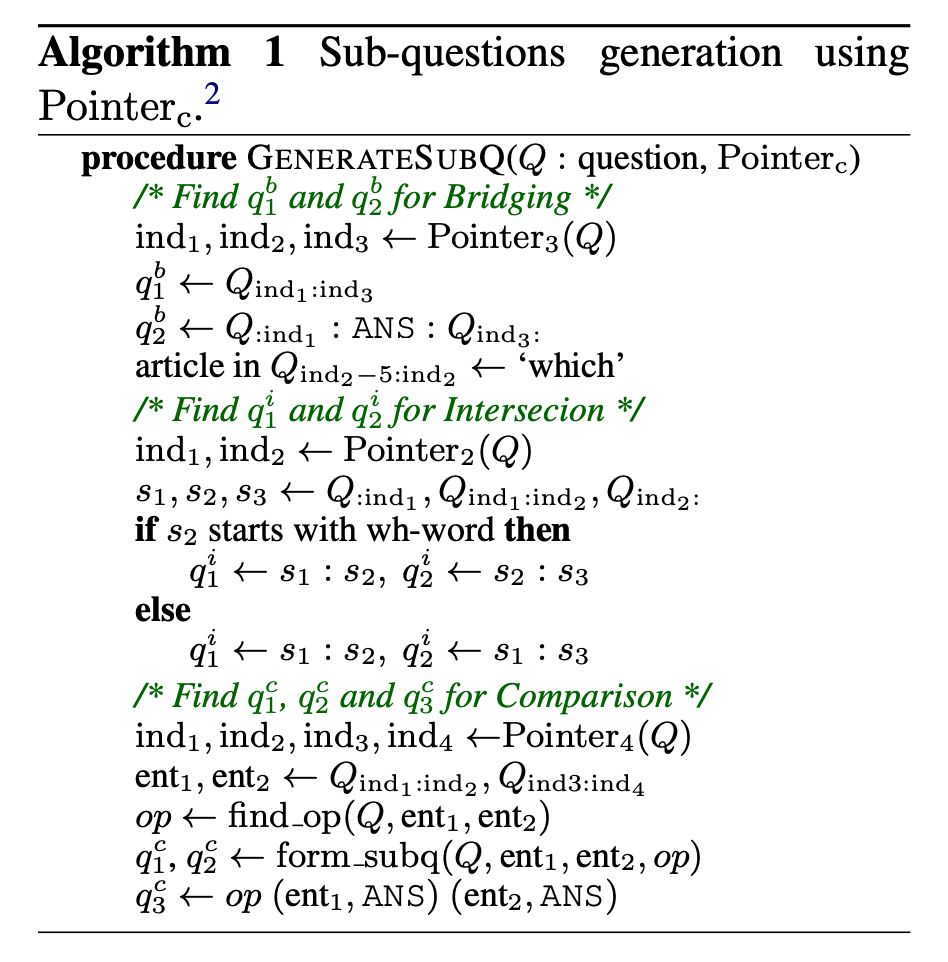

本文提出了一种使用问题的 span 预测来创建子问题的方法。其核心思想是,每个子问题都可以通过复制和适当地编辑原问题的关键片段来形成,每种推理类型都需要不同的片段。

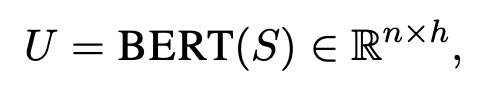

该方法不需要太多的监督(400 个注释)。注释是通过将问题映射成若干个点来收集的,这些点将问题划分为若干个区间。本文训练一个模型

其中 h 为编码器的输出维数。

令

其中

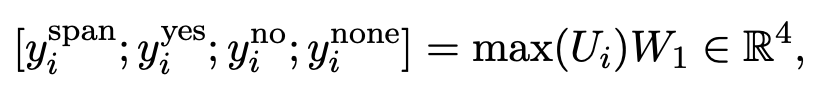

单跳阅读理解

,这种方法独立计算来自每个段落

,这种方法独立计算来自每个段落 和

和 和

和

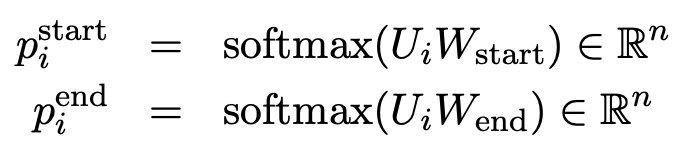

代表一个参数矩阵,此外,该模型计算的

代表一个参数矩阵,此外,该模型计算的 和

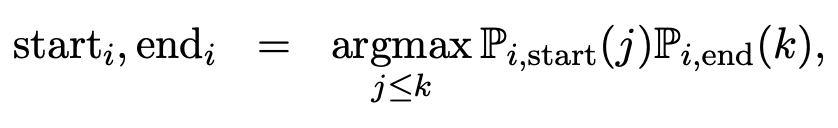

和 分别表示第 j 个单词是答案空间的开始和第 k 个单词是答案空间的结束的概率。

分别表示第 j 个单词是答案空间的开始和第 k 个单词是答案空间的结束的概率。 和

和 是由

是由 是参数方程。最终 answer 被确定为

是参数方程。最终 answer 被确定为

分解打分器

和

和 为来自推理类型 t 的答案和证据。设 x 为问题、推理类型 t、答案

为来自推理类型 t 的答案和证据。设 x 为问题、推理类型 t、答案 和

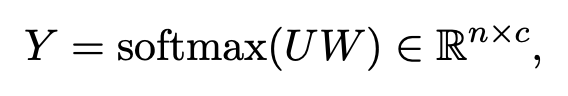

和 串联而成的 n 个单词序列。分解打分器使用 BERT 来编码这个输入 x 得到

串联而成的 n 个单词序列。分解打分器使用 BERT 来编码这个输入 x 得到 ,得分

,得分 是可训练的矩阵。

是可训练的矩阵。

,并选择与此推理类型对应的答案作为最终答案。

,并选择与此推理类型对应的答案作为最终答案。

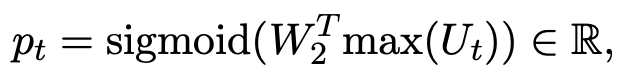

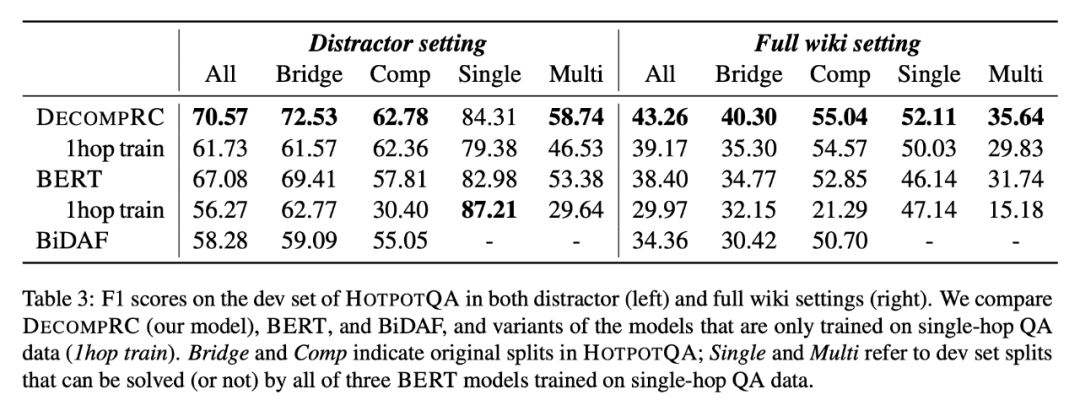

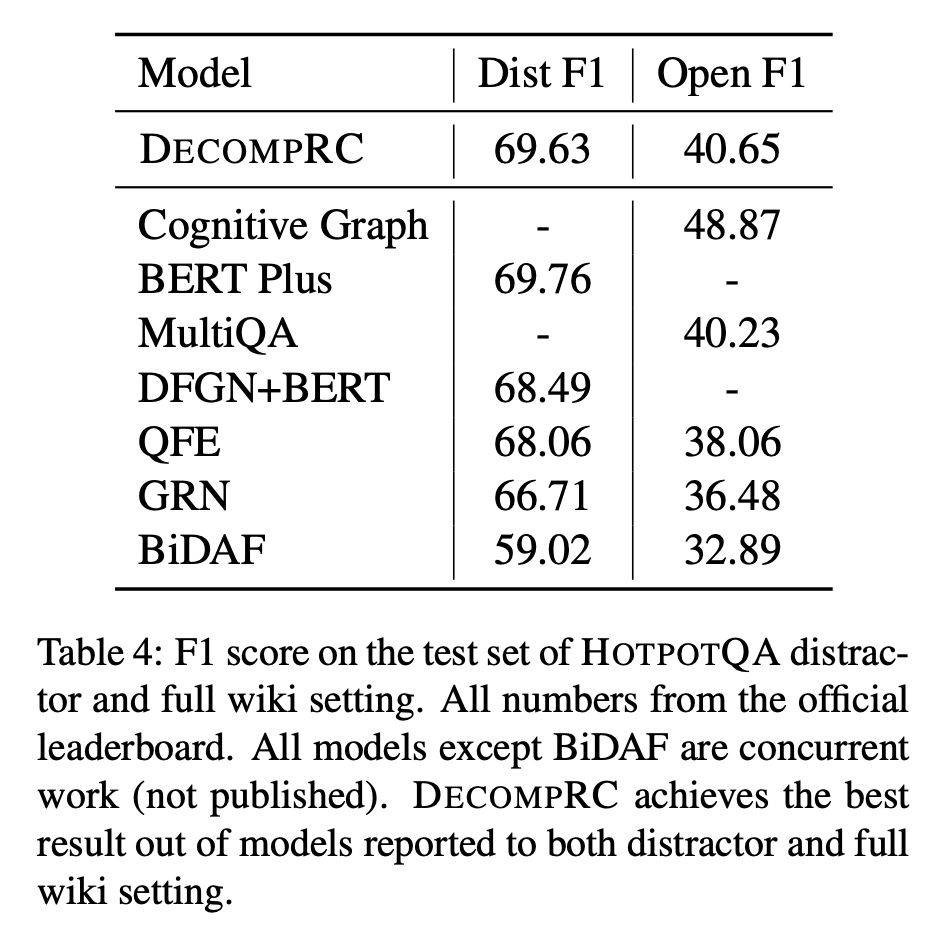

实验结果与讨论

启发与思考

模型,它学会将一个问题映射成 c 个点,然后通过算法 1 用 c 个点为每个推理类型组成子问题,其中使用了 BERT 将问题进行编码。通过此方法分解得到的子问题与人工编写的子问题一样有效,这得益于BERT通过语言建模学习到句子的语法信息。

模型,它学会将一个问题映射成 c 个点,然后通过算法 1 用 c 个点为每个推理类型组成子问题,其中使用了 BERT 将问题进行编码。通过此方法分解得到的子问题与人工编写的子问题一样有效,这得益于BERT通过语言建模学习到句子的语法信息。

参考文献

[1] Min S, Zhong V, Zettlemoyer L, et al. Multi-hop Reading Comprehension through Question Decomposition and Rescoring[J]. arXiv preprint arXiv:1906.02916, 2019.

[2] Yang Z, Qi P, Zhang S, et al. Hotpotqa: A dataset for diverse, explainable multi-hop question answering[J]. arXiv preprint arXiv:1809.09600, 2018.

[3] Peters M E, Neumann M, Iyyer M, et al. Deep contextualized word representations[J]. arXiv preprint arXiv:1802.05365, 2018.

[4] Radford A, Narasimhan K, Salimans T, et al. Improving language understanding by generative pre-training[J]. URL https://s3-us-west-2. amazonaws. com/openai-assets/researchcovers/languageunsupervised/language understanding paper. pdf, 2018.

[5] Devlin J, Chang M W, Lee K, et al. Bert: Pre-training of deep bidirectional transformers for language understanding[J]. arXiv preprint arXiv:1810.04805, 2018.

点击以下标题查看更多往期内容:

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 下载论文 & 源码