一种基于激光雷达和视觉的行人检测方法 | 厚势汽车

厚势按:针对一般城市环境的道路交通安全问题,提出了一种联合激光雷达和视觉的行人检测方法。利用激光雷达和摄像头坐标之间的透视变换关系,将环境的深度信息映射到图像中,并使用航位角推算方法同步激光雷达和摄像头,然后提取兴趣区域。在激光雷达聚类过程中,提出了一种基于行人宽度信息的目标分割方法,能有效分割并排行人。

在基于视觉的行人检测中,首先根据行人边缘对称性的特点,预处理兴趣区域,然后采用基于 Hausdorff 距离的模板匹配方法,根据激光雷达的深度信息匹配行人上半身模板.实验结果表明,该方法可以取得较理想的效果。

本文来自 2010 年 7 月出版的《 上海交通大学学报 》,作者是上海交通大学电子信息与电气工程学院的钱慧佳、杨明教授与李顥以及上海交通大学机械与动力工程学院的王春香副教授。

道路交通安全作为智能交通系统中的重要一环,越来越受到国内外研究机构的重视。在混合交通环境下,行人检测对安全辅助驾驶有着重要意义。在目前的行人检测方法中,普遍采用基于单传感器的方法。

文献 [1] 中综合运用纹理、熵、模板匹配等方法在一般城市环境下检测运动行人;文献[2]中采用立体视觉系统,运用摄像头倾斜度补偿方法获得地面兴趣区域,并利用支持向量机检测行人;文献 [3] 中采用行人边缘特征集作为训练样本,利用 Adaboost 分类器对不同行人部位进行训练,并通过贝叶斯模型得到检测结果。

但是,基于单一传感器的方法受到信息量少、算法较复杂的制约,已很难满足当前快速、鲁棒性要求高的行人检测要求,由此开展了多传感器联合检测行人的研究 [4]。本文利用车载激光雷达和摄像头进行联合标定,得到 2 个坐标系之间的透视变换关系,提出了一种基于航位角推算的坐标变换方法,以同步激光雷达和摄像头采集数据间的时差。

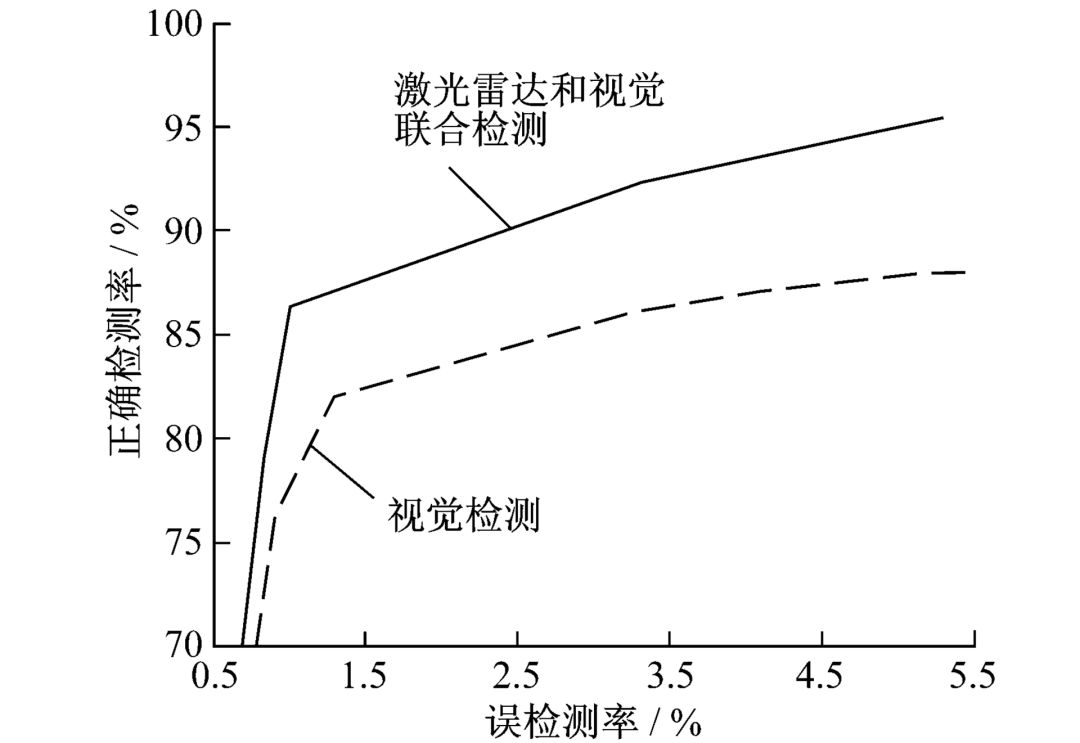

在兴趣区域提取层面,改进了传统的聚类方法,使它可以分辨并排行人;在图像处理层面,根据行人的边缘对称性预处理兴趣区域,并采用基于Hausdorff 距离的模板匹配方法定位行人;在实验中利用 CyberCars3 智能车对各个不同环境下的场景进行行人检测,得出了正确检测率/误检率曲线。

1. 基于激光雷达和视觉的信息融合

1.1 激光雷达摄像头联合标定

由于传感器具有各自独立的数据空间向量,获得它们之间的映射关系是实现多传感器融合的前提。如果将激光雷达和摄像头位置固定,则透视变换关系为

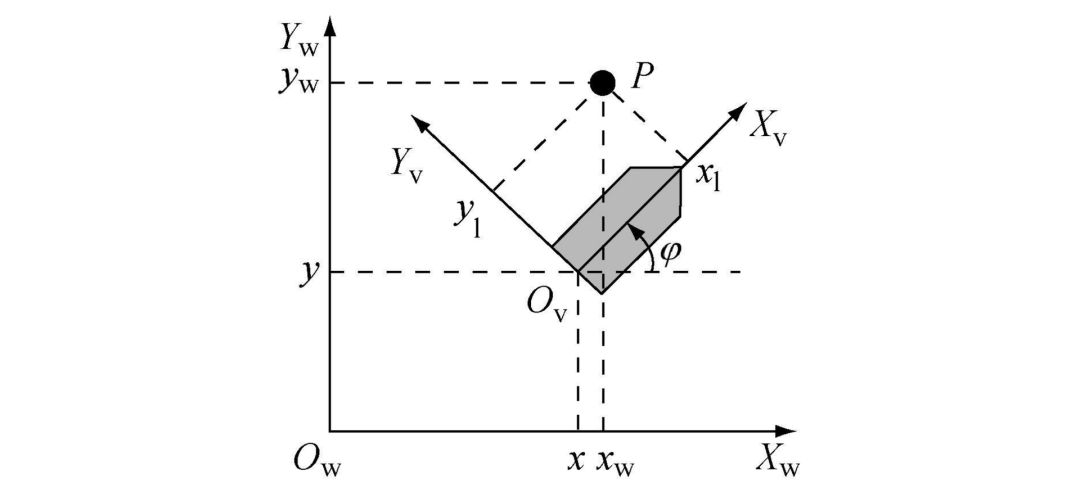

式中:[u,v,1]^T 为图像坐标系;[X,Y,Z,1]^T 为激光雷达层局部坐标系,通过透视投影变换可以将激光雷达层坐标映射到图像坐标系中。图 1 从直观角度说明了 2 种传感器之间的空间映射关系。

图 1 直观图

本文采用文献 [5] 中的标定方法得到透视矩阵,共使用 9 对图像坐标和激光雷达局部坐标。图 2 所示为透视变换矩阵将某一激光雷达数据帧映射到图像中的结果。其中,激光雷达的安装高度为 0.36m,水平放置于车辆正前方。从实验结果可见,通过透视变换,可以很好地将激光雷达数据融进图像信息中。

图 2 融合结果

1.2 激光雷达摄像头同步

由于激光雷达与摄像头采集频率不同,在给定触发信号情况下,一帧激光雷达数据和图像数据对应的时刻不尽相同。在本实验中,对 1000 帧数据进行分析,发现平均同步时差达到 35.2 ms。为解决同步时差带来的数据偏移,本文采用基于航位推算下的坐标变换方法(见图 3)来实现 2 种传感器之间的同步。

图 3 坐标变换示意图

在图 3 中,P 点代表行人,(x_l,y_l) 代表某车辆坐标下的行人局部坐标,(x_w,y_w) 代表行人的世界坐标,(x,y)为车辆位姿。在某一触发信号下,由于激光雷达和摄像头采集数据帧时刻不同,车辆位姿在这 2 个时刻之间发生了偏移,以图像时刻为基准点,由平面坐标变换可推导得:

式中:(x_lb, y_lb) 和 (x_la,y_la) 分别为摄像头和激光雷达采集时刻下的行人局部坐标,由于行人速度相对车辆移动速度较慢,其位移可忽略不计,而激光雷达时刻下的行人局部坐标可以直接通过激光雷达数据获得,2 个时刻之间的车辆位姿差,即 (x_a - x_b,y_a - y_b) 可以通过航位推算公式获得。从而可以获得在图像采集时刻下的行人局部坐标,即获得了这个时刻下的激光雷达层坐标,解决了两者之间的同步问题。

2. 激光雷达和图像数据处理

由于激光雷达获取了大量的数据,其中包括潜在的行人候选区域以及非兴趣区域,因此,对这些区域进行划分成为了关键,必须先对激光雷达数据进行预处理,本文采用的预处理手段是激光雷达数据聚类。

2.1 激光雷达数据聚类

聚类就是将一帧激光雷达数据分割为几个点簇,这个点簇包含了可能的行人和非行人,聚类的判断规则如下 [6]:

式 (3) 的物理含义为:当相邻 2 个激光雷达距离小于某个阈值时,可视为同一个物体。

2.2 聚类算法改进

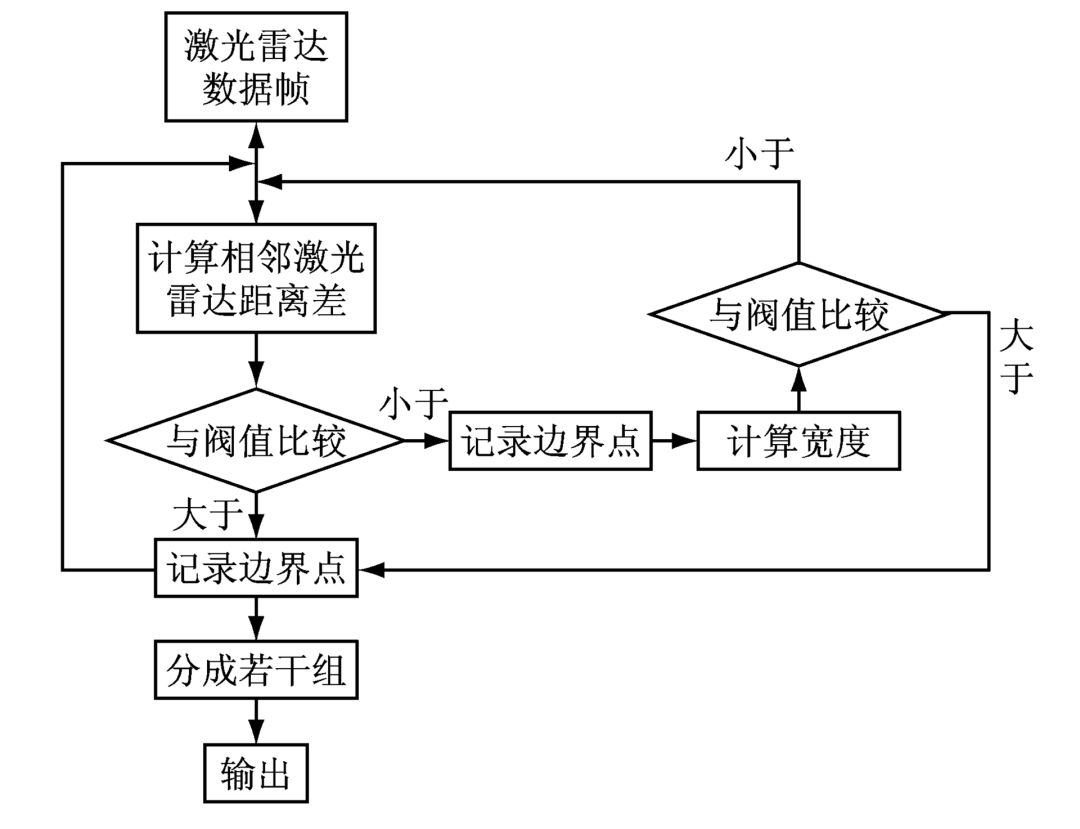

图 4 流程图

通过以上判据,可以有效地分割激光雷达数据,使原本属于同一物体的点簇聚为一类。但在行人检测中,当出现并排走的行人时,很可能将并排行人聚为一类,将原本多个行人视为单个行人而无法对行人进行行为分析。因此,本文提出一种根据行人宽度信息的改进型聚类算法,流程如图 4 所示,当聚类宽度超过一定范围时重新进行聚类。

行人宽度的计算如下:

式中:r_left、r_right 分别为某一点集左、右边界上的距离;θ 为从左边界到右边界的角度。由于行人宽度有限,根据经验值,行人宽度一般不大于 0.6 m,这里作为阈值。

图 5 结果对比图

图 5 所示为算法改进前后结果对比图。图中,竖线代表一类。由图可见,在图 5(a) 中,由于左边 2 个行人靠得很近,所以将这 2 个行人聚成了一类;而在图 5(b) 中,由于加入了行人的宽度信息,正确地将 2 个靠近的行人聚为 2 类。

2.3 兴趣区域预处理

经过激光雷达聚类后投影到图像中的是各个可能包含行人的兴趣区域。首先,需要确定兴趣区域的大小,由透视投影矩阵可得:

式中:v 为图像纵向坐标:N 为透视变换矩阵;(x, y, z) 为行人的局部坐标,其中 z 为行人高度。由式 (5) 可得不同距离下行人在图像中的高度 Δv。同理,由聚类过程中得到的边界点信息,可以得到行人在图像中的宽度,在实验中,设行人高 h = 2.0 m。

图 6 兴趣区域提取结果

图 6 所示为模拟交叉路口环境下采集的某一视频帧。由图可见,通过以上方法可以有效提取不同距离下的行人兴趣区域。

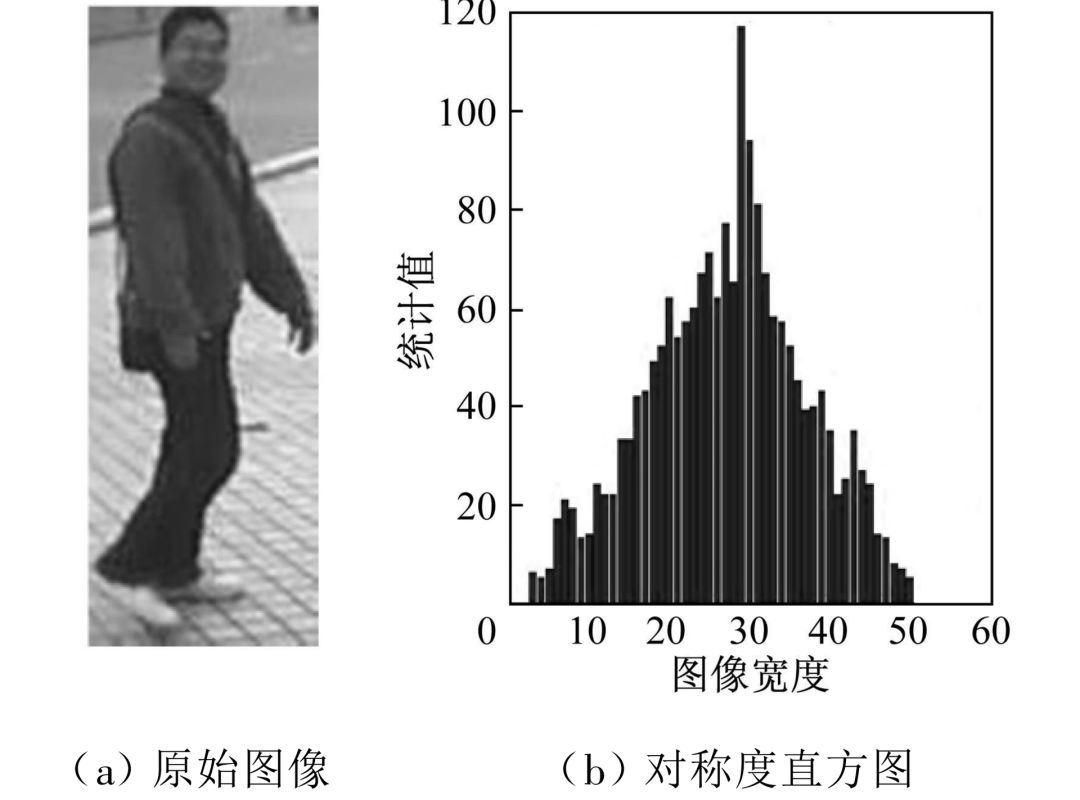

图 7 对称度实验结果

在确定了兴趣区域的范围后,本文利用行人具有边缘对称性的特征,采用文献 [7] 中的方法,进一步对提取区域进行预处理,实现对称性分析。图 7 所示为对称度实验结果。其中,对称度直方图的长度代表其对称性统计值,最大值出现的位置可认为是对称中心。

因此,在得到了兴趣区域的对称度直方图后,把最大统计值作为对称度,由于行人具有较高的对称度,可以根据其大小排除部分非候选区域。

2.4 基于 Hausdorff 距离的自适应模板匹配

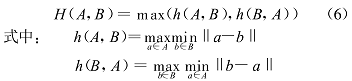

在确定了兴趣区域的大小和对称中心后,本文利用行人高度信息自适应地匹配行人上半身模板。Hausdorff 距离是描述 2 个点集之间相似程度的一种度量,它对基于图像的边缘匹配具有较强的鲁棒性,其算法如下 [8]:

A 和 B 代表 2 个点集;‖°‖为 2 个点之间的欧式距离;H(A,B) 为 2 个边缘点集合之间的最大不匹配程度。

为了提高匹配算法的鲁棒性,实验中取 5 个最大 Hausdorff 距离的平均值作为匹配值。根据摄像头采集图像大小 (320×240),共采用 8 个大小不同的标准上半身模板来代表不同尺度下的行人样本。模板数量越多,则匹配精度相应越高。首先,根据激光雷达信息判断候选区域大小,然后,自适应地匹配相应的标准模板,最后,得到结果。

3. 实验结果和讨论

图 8 检测结果

实验以 CyberC3 智能车辆为平台进行行人检测。车上装有 2 种传感器:激光雷达(德国 SICK 公司的 LMS 291-S05 激光测距传感器)和罗技网络摄像头。配置激光雷达为毫米模式,角度分辨率 0.25°,角度测量范围 0°~100°,摄像头分辨率为 320×240。为了全方位评估本文算法的可靠性,笔者在校园不同场景(包括一般路面、十字路口、食堂门口)中采集了数据并进行了大量实验,共对超过 3000 帧的数据进行了处理。图 8 所示为对所采集数据分析得到的正确检测率/误检测率曲线。

由图可见,由于通过激光雷达有效划分了兴趣区域,所以,联合检测结果比单一使用视觉的检测方法更好。当误检率在 4% 左右时,行人检测率可以达到 93% 左右,最高检测率可以达到 95%。另外,由于激光雷达不受光照等天气因素的影响,其鲁棒性较强;而目前普遍采用的基于机器学习的行人检测方法,需要对样本进行学习,受光照条件影响较大,很难应用于实时检测中。通过实验可以看出,激光雷达和视觉联合检测方法可以取得较好的结果。

4. 结语

本文提出了一种基于多传感器融合框架下的行人检测方法。通过激光雷达和摄像头之间的标定关系,可以将激光雷达数据投影到图像坐标中,并提出了一种基于航位推算下的坐标变换方法来同步 2 种传感器之间的时差。通过激光雷达确定兴趣区域,运用一定的图像算法来定位行人,并通过大量实验,验证了本文方法的可靠性。

在实验中发现,汽车行驶所造成的激光雷达抖动对实验结果造成了一定的干扰,降低汽车运动所造成的影响是今后的一个研究方向;其次,提高图像算法的鲁棒性而进一步提高行人检测的准确性,也是有待于研究的重点,如在行人对称性分析中如何运用对称中心等。另外,如何更深入地融合传感器数据而提高可靠性也值得深入探讨。

参考文献

[1] Curio C, Edelbrunne r J, Kalinke r T, et al .Walking Pedestrian recognition [J] .IEEE Transactions on Intelligent Transportation Systems, 2000, 1(3):155-163

[2] Llorca D R, Sotelo M A, Parra I, etal. A experimental study on pitch compensation in pedestrian-protection systems for collision av oidance and mitigation [J]. IEEE Transactions on Intelligent Transportation Systems, 2009, 10(3):469-474

[3] Wu B, Nevatia R. Detection and tracking of multiple, partially occluded humans by bayesian combination of edgelet based part detectors [ J] .International Journal of Computer Vision, 2007, 75(2):247-266

[4] Jung H G, Lee Y H, Yoon P J, etal. Sensor fusion based obstacle detection/classification for active pedest rian pr otectio n sy stem [C]//Proceedings of Advances In Visual Computing/ Second International Symposium. Lake Tahoe, USA: LNCS P ress, 2006: 294-305

[5] LIU Da-xue, DAI Bin, L I Zheng, etal. A method for Calibration of single line laser radar and camera [J]. Journal of Huazhong University of Science and Technology, 2008, 36(z1):68-71

[6] Mendel A, Nunes U .Situation-based multi-target detection and tracking with laser scanner in outdoor semistructured environment [C]//Proceedings of 2004 IEEE/ RSJ International Conference on Intelligent Robots and Systems. Sendai , Japan : IEEE Press, 2004:88-93

[7] Collado J M, Hilario C, de la Escalera A. Model based vehicle detection for intelligent vehicles [C] //Proc IEEE Intelligent Vehicles Symposium.Prma,Italy : IEEE Press , 2004: 572-577 百度 陆奇

[8] Tan H C , Zhang Y J .Computing eigenface from edge images fo r face reco gnition based on hausdorff distance [C] // Proceedings of the 4th International Conference on Image and Graphics.Sichuan, China: IEEE Press, 2007:639-644

编辑整理:厚势分析师伊龙马

转载请注明来自厚势和厚势公号:iHoushi

-END-

文章精选

企业家

智能驾驶

新能源汽车

项目和评论

这些大神从Google出走,创办了五家(命运各异的)无人车公司

厚

势

汽

车

为您对接资本和产业

新能源汽车 自动驾驶 车联网

联系邮箱

bp@ihoushi.com

点击阅读原文,查看文章「基于多传感器的车道级高精细地图制作方法」