ETP:精确时序动作定位

论文地址:https://arxiv.org/abs/1804.04803

背景介绍

时序动作检测,指的是在一段untrimmed video中找到感兴趣动作发生的起止时间,同时知道这个动作的具体类别。

目前主流的模型是three-stages,分别是时序动作提名,即先提出一些可能包含动作的时序段,以减少直接采用滑动窗方法带来的计算量;然后在提出的这些proposal基础上,进行微调,通常是采用regression的方式;最后,在得到所有可能包含的proposal后,对每一个proposal做分类,得到最终结果。

这个目前的准确率在IOU=0.5的情况下还处于比较低的水平,而主要原因是当前模型提出的proposal质量不高,而在action recognition方面,UCF101数据集上已经取得了98%的准确率。

主要贡献

提出了three-phase的evolving temporal proposal模型(ETP),引入了non-local pyramid features,该方法实现了目前state-of-the-arts。

模型结构

EPT网络由三个子网络组成,Actionness Network:在frame level上得出每一个frame的包含动作的置信概率,即actionness score;Refinement Network:在前一步基础上,通过regression来调整proposal,得到更精确的边界;Localization Network:同样是refine。具体看各个子网络:

Actionness Network:

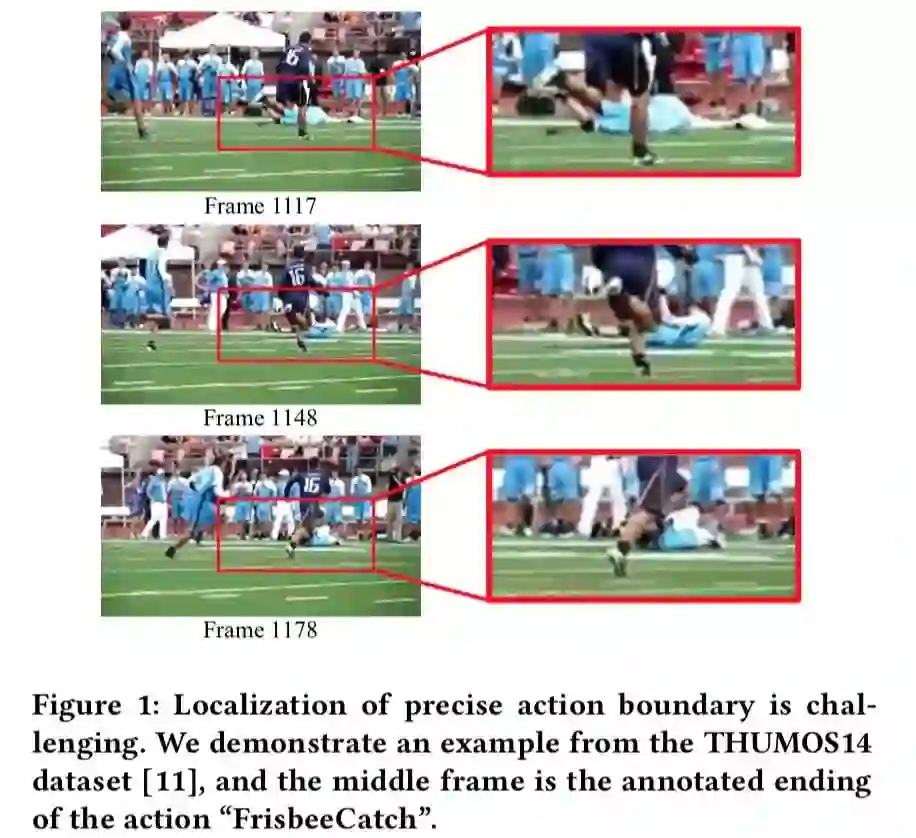

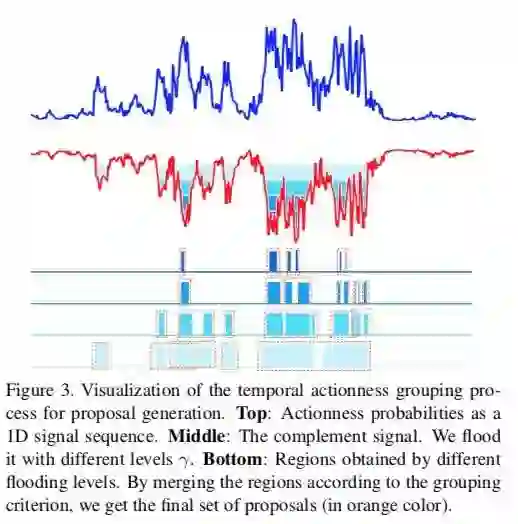

这个网络和[3]中提出的TAG方法(如下图)是一样的。AN本身是一个分类网络,目的是为了得到frame-level class-specific actionness,也就是当前帧包含动作的概率值。分类网络对网络结构没有要求,本文采用的是预训练的ResNet模型。

在得到了每一帧的score后,通过聚类的方法,将离散的score组合,得到proposal,然后用非极大值抑制(NMS)剔除多余proposal。聚类方法见下图。

Refinement Network:

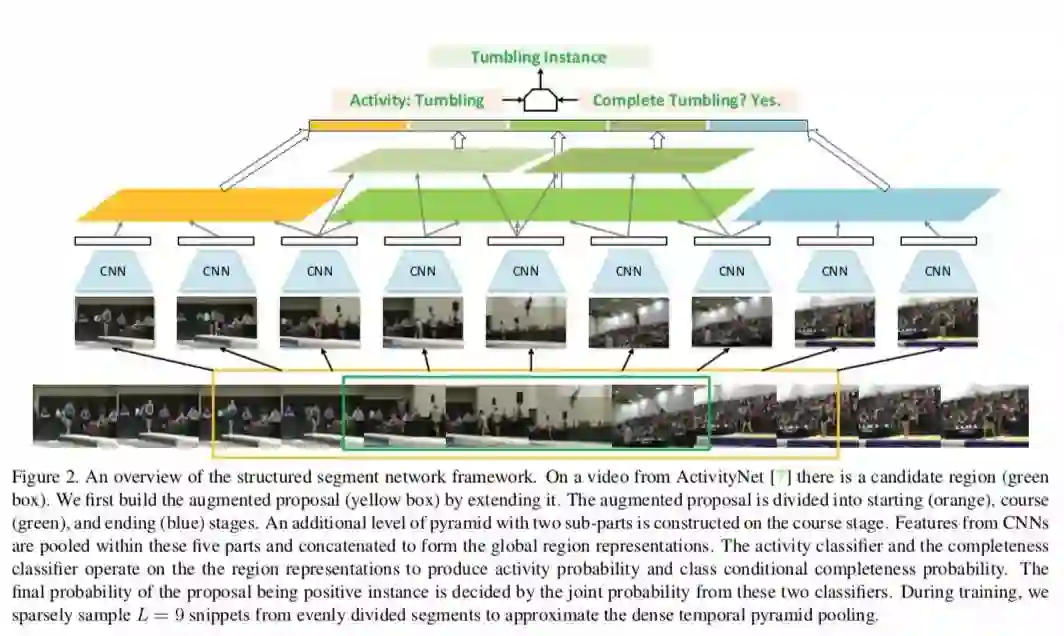

与Actionness Network在frame-level上考虑不同,Refinement Network从unit-level上考虑,这样做的原因是,在refine环节,为了减少边界本身模糊性的影响,[2]实验发现在coarse-grained是做回归比在frame-level上做回归更有效和稳定。同时考虑context信息,即proposal周边的units,方式和[3]SSN一致。

与[2]中使用Two-Stream特征作为unit特征不同,Refinement Network使用non-local pyramid features作为unit特征。另外与[2]的差异在于,[2]在提取unit特征后,直接在unit-level上通过full connected layers做regression,而这里则是把unit特征输入到RNN-based sequence encoder中,然后把经过编码后的context feature再去做regression,回归的是proposal的中心坐标和proposal的长度([2]中回归的是offset)。这里RNN采用[4]中提出的BiGRU,GRU在这不做说明。

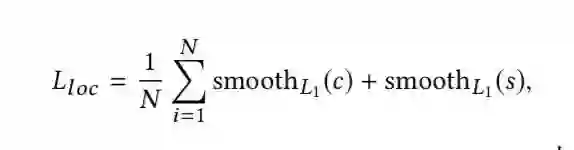

Refinement Network采用的loss函数为:

c代表proposal的中心坐标,s代表proposal的长度。N包含positive和incomplete的proposal。

Localization Network:

在Refinement Network得到新的proposal后,采用[3]中SSN作为backbone,如上图[3],在最后一层加入non-local block[5],其中non-local block[5]以residual connection[6]形式存在。具体细节请参阅[3],这里不再叙述。

实验

实验细节

(1)Actionness Network中采用在Image-Net上预训练后并且在UCF101上fine-tune的RseNet-34作为base-bone。

(2)Refinement Network中使用2 BiGRU cells,每一个包含512个隐藏单元。

(3)Localization Network中使用在Kinetics上预训练的Inception-V3作为base-bone。

对比实验

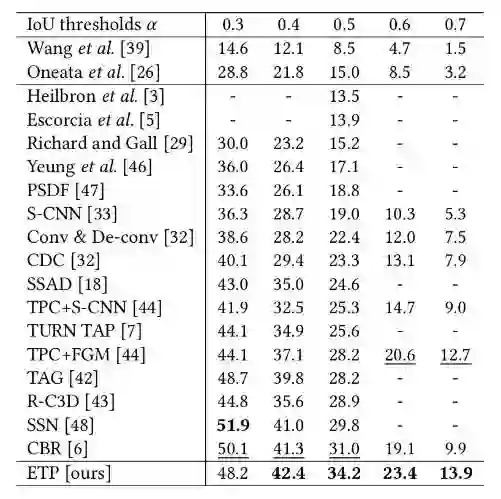

可以看到,ETP方法在IOU大于0.3之后的准确率高于所有主流方法,而且提升了很多。

文中还做了几个比较细致的对比实验。

(1)Refinement Network的效果。

(2)Unit长度的影响。

(3)Non-local pyramid feature的影响。

(4)多模态的影响。

其中(2)已经在TURN-TAP中被探索过了,unit长度大约在32左右会有最好效果。而(4)几乎已经是视频领域共识了,任何主流模型,RGB+Flow都要好于单RGB,这里不再多说。

值得注意的是,在增加了Refinement Network的情况下,在各个类别上的效果并没有明显的提升,甚至在一些类别下降了。

Refinement Network中主要是增加了RNN模块。所以原因可能是来自RNN本身(单纯基于RNN的方法一直没有取得明显进展),也有可能是Refinement Network和Localization Network都在做refine,Localization Network起决定性的作用。

而Non-local feature则在各个类别上基本都实现了提升,原因可能来自unit与unit之间增加了更多响应,有利于网络学习到它们之间的联系。但这样无疑也增加了很大计算量。

个人见解

论文亮点

个人认为亮点主要来自两方面:

(1)引入了non-local feature,对比实验也证明,non-local feature能够带来效果上的提升。

(2)一个模型内同时融入了很多主流的tricks,并且实验效果很惊人,在IOU=0.5的情况下,相比TURN-TAP提升近10%,超过TAG6%,比去年state-of-the-arts的CBR(TURN-TAP同一作者)仍高出近3%。

个人看法:

熟悉这个领域的同学知道,这篇文章集成了很多主流方法的核心。

例如Actionness Network其实就是SSN中提出的TAG方法;unit-level上做regression效果比frame-level上要好这一点也在TURN-TAP中首先得到了使用;pyramid特征来获得context information也是早就被应用的trick;non-local feature应该也有人尝试过。

所以整个模型其实可以看成是TAG+TURN-TAP+LSTM的组合拳,效果喜人。

存在的问题:

(1)数据本身:

(1.1):一方面动作本身的边界是模糊的,这就表明主流数据集上的label首先就不是完全可靠的,而用这样的数据学习出来的模型肯定是有问题的。

(1.2):另一方面,视频数据通常有两种:固定摄像头拍摄(监控视频异常行为检测),非固定摄像头拍摄(电视节目精彩片段提取)。现在数据集没有针对这两者做区分可能也是存在问题的。

比如固定摄像头情况下,检测边界的难点可能来自动作本身的模糊性;而非固定摄像头拍摄情况下,数据存在噪声,比如被标记为跳水的视频段,可能是由【跳水+观众席+跳水】组成的,由于摄像头本身的移动,没有一个对准主体对象,中间的背景信息没有被处理,也被标记了,这样学习出来的特征可能也存在问题。

(2)模型本身

如何提取有效的temporal特征是模型需要考虑的最大问题,这个也是目前主流论文着手解决的问题。

通常方法有三种,C3D衍生的3D模型、Two-Stream模型、RNN模型。但这三种方法都没有取得像2D卷积在图像上取得的进展。同时temporal特征的可解释性低,有时候网络效果很好,但很难说明网络到底学到了什么。

参考文献

[1] Jiyang Gao,Zhenheng Yang,and Ram Nevatia. 2017.Cascaded Boundary Regression for Temporal Action Detection. arXiv:1705.01180 (2017).

[2] Jiyang Gao,Zhenheng Yang,Chen Sun,Kan Chen,and Ram Nevatia. 2017.TURN TAP: Temporal Unit Regression Network for Temporal Action Proposals. In International Conference on Computer Vision (ICCV). 3648–3656.

[3] Yue Zhao,Yuanjun Xiong,Limin Wang,Zhirong Wu,Xiaoou Tang,and Dahua Lin. 2017. Temporal Action Detection With Structured Segment Networks. In International Conference on Computer Vision (ICCV).

[4] Mike Schuster and Kuldip K Paliwal. 1997. Bidirectional recurrent neural net- works. IEEE Transactions on Signal Processing 45, 11 (1997), 2673–2681.

[5] Xiaolong Wang, Ross Girshick, Abhinav Gupta, and Kaiming He. 2017. Non-local Neural Networks. arXiv:1711.07971 (2017).

[6] Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun. 2016. Deep residual learning for image recognition. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR). 770–778.

本文为极市原创,转载请标明出处,同时欢迎大家投稿~

*推荐文章*

Video Analysis 相关领域解读之Temporal Action Detection(时序行为检测)

SCNN-用于时序动作定位的多阶段3D卷积网络

PS.极市平台正式启动了极市原创作者计划。欢迎各位的高质量的视觉方向的原创投稿文章,我们将不遗余力得在我们所有的平台上进行传播分享。更多详情请点击:活动 | 加入极市原创作者行列,实现一个小目标