四周掌握RNN与注意力机制,这门播放百万次的课程进度已过半

动手学深度学习直播课前三部分完结!

在过去的4个月中,亚马逊资深首席科学家李沐博士分别讲解了深度学习基础、卷积神经网络和计算机视觉三个部分。自开课以来,已有10000余人参与直播学习,课程回放在哔哩哔哩的播放数已超过92万次。

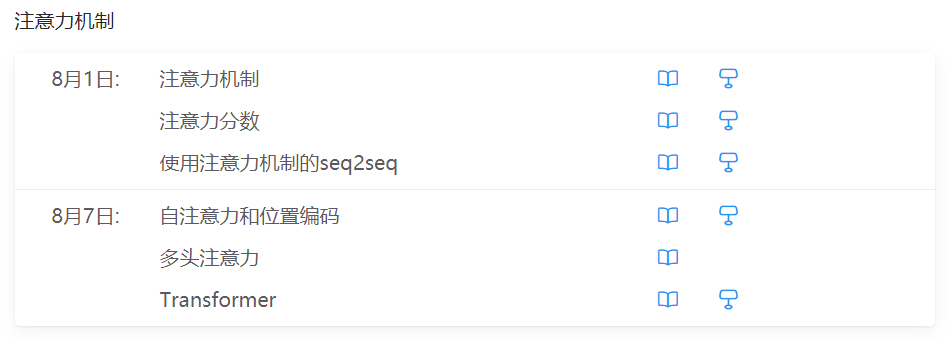

本周末,课程将进入第四部分「循环神经网络」的讲解,随后是第五部分「注意力机制」,让我们为还没上车的小伙伴再次推荐这门可能是今年最火的深度学习公开课。

课程内容基于《动手学深度学习》中文第二版(图书预计今年年末上市),共七大模块分:深度学习基础、卷积神经网络、计算机视觉、循环神经网络、注意力机制、自然语言处理、优化算法。课程不仅讲述模型算法,还会讲述如何用PyTorch实现每一处细节,帮助大家在真实数据上获得第一手经验。

按目前的进度,课程预计持续到9月,每周周六与周日下午13:00-14:30直播。

课程官网:http://courses.d2l.ai/zh-v2/

-

直播地址: https://jmq.h5.xeknow.com/s/3nk3lb -

课程回放: https://space.bilibili.com/1567748478

本次课程期间,每个模块的讲解结束后,都会设置一次课内比赛,帮助大家掌握如何利用学到的知识解决实际问题。竞赛后也欢迎大家公开代码进行交流讨论。每次竞赛的优胜选手都将获得沐神签名版《动手学深度学习》。

本周的课程将介绍第三次课程竞赛:目标检测,还没完成课程内容学习的小伙伴请抓紧时间赶赶进度。

第四部分《循环神经网络》课程安排

欢迎大家加入课程交流群,共同学习讨论。我们也将在群中第一时间发布课程直播通知。

如群已超出人数限制,添加机器之心小助手:syncedai2、syncedai3、syncedai4或syncedai6,备注「动手学」即可加入。

点击 阅读原文 ,收藏直播间。

登录查看更多

相关内容

Attention机制最早是在视觉图像领域提出来的,但是真正火起来应该算是google mind团队的这篇论文《Recurrent Models of Visual Attention》[14],他们在RNN模型上使用了attention机制来进行图像分类。随后,Bahdanau等人在论文《Neural Machine Translation by Jointly Learning to Align and Translate》 [1]中,使用类似attention的机制在机器翻译任务上将翻译和对齐同时进行,他们的工作算是是第一个提出attention机制应用到NLP领域中。接着类似的基于attention机制的RNN模型扩展开始应用到各种NLP任务中。最近,如何在CNN中使用attention机制也成为了大家的研究热点。下图表示了attention研究进展的大概趋势。

Arxiv

7+阅读 · 2018年5月25日

Arxiv

4+阅读 · 2018年2月19日

Arxiv

3+阅读 · 2017年8月2日