WWW'22|用于分布外推荐的因果表征学习

-

论文地址:https://dl.acm.org/doi/10.1145/3485447.3512251

简介

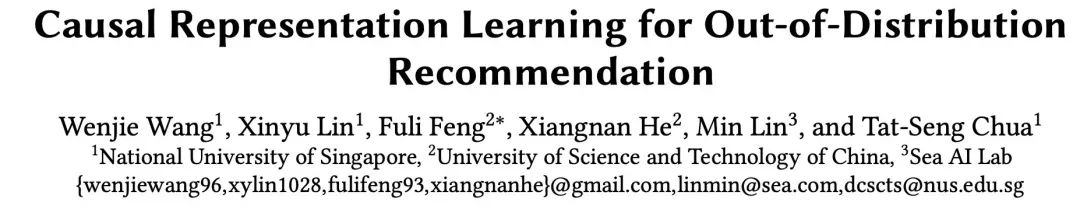

现代推荐系统从历史交互中学习用户表征,这就存在着用户特征变化带来的问题,比如收入的增加。历史交互会将过时的信息注入到与最新的用户特征相冲突的表示中,从而导致不恰当的推荐。在这项工作中,作者考虑了在用户特征发生变化的Out-Of-Distribution (OOD) 环境中的推荐问题,并为表征学习设定了额外的两个目标:强大的OOD泛化能力以及快速的OOD适应能力。OOD场景的推荐问题如图所示:

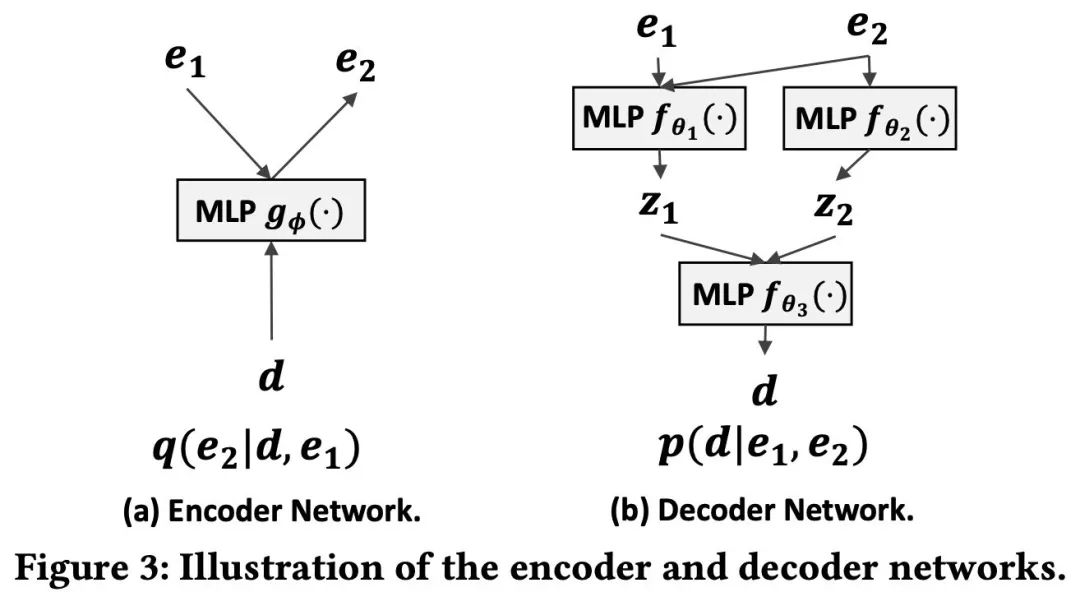

这项工作从因果关系的角度阐明并解决了这个问题。作者将用户特征的转变表述为一种干预措施,将OOD推荐表述为交互概率的干预后推断,并采用了因果模型为用户特征到交互结果的生成过程建模。作者设计了一个新型变分自动编码器来进行因果建模,利用编码器从历史上的互动中推断出未观察到的用户特征,利用解码器来对交互的生成过程进行建模并进行干预后推断,并且进一步进行反事实推理,来减轻过时的交互的影响。固有的快速的OOD适应能力来自于部分用户表征的再利用。变分自动编码器结构如图所示:

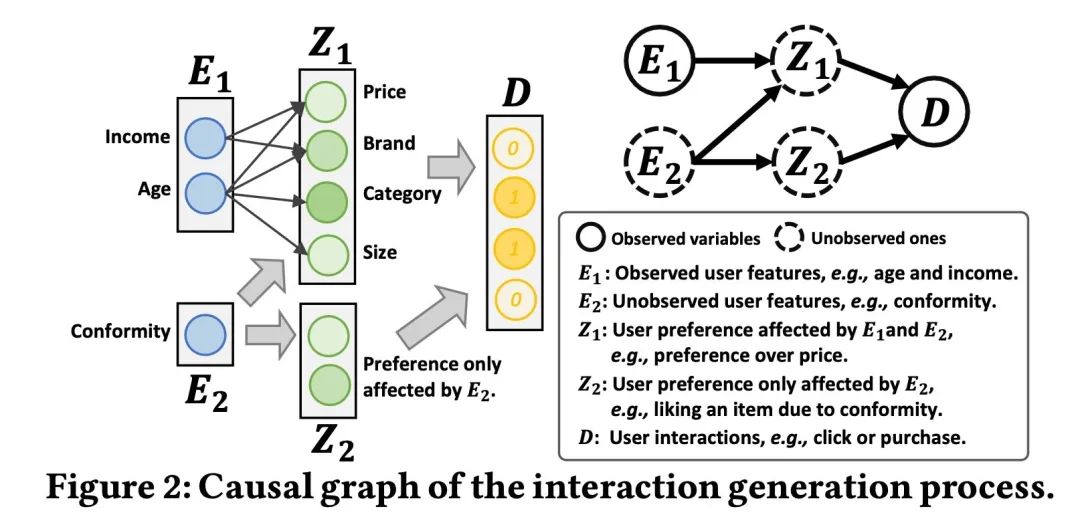

最后,作者设计了一个扩展的因果图,对从用户特征到用户偏好的细粒度因果关系进行编码。在三个数据集上的实证结果验证了所提方法的强大OOD泛化和快速适应能力。

问题定义

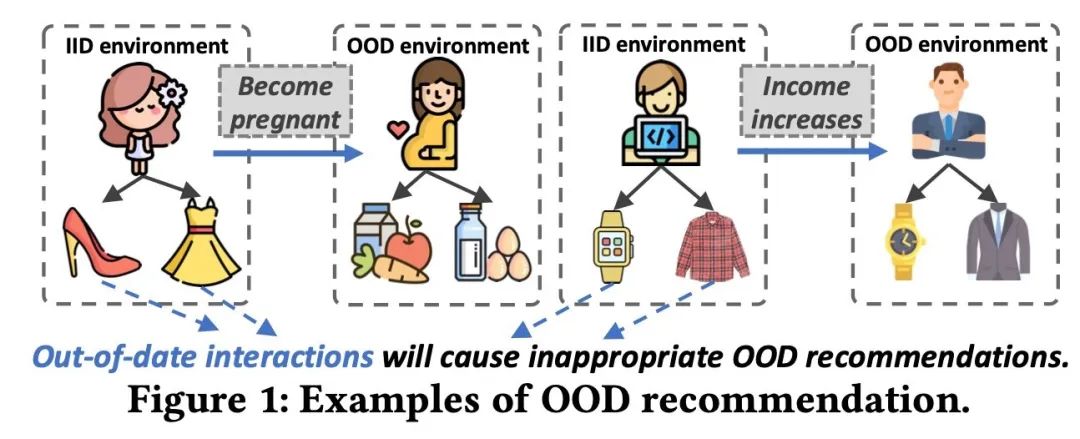

首先通过因果关系的视角定义推荐问题,包括了用户交互的生成过程的因果视角和对OOD推荐问题的规范。用户交互生成的因果关系图如图所示:

对于每个用户,用户的偏好 同时受可观测的特征 (例如收入和年龄),和不可观测的特征 例如心理状态的影响。 仅受不可观测特征的影响,而 受所有特征的影响。用户偏好会影响最终的交互结果 。

将 和 分别定义为用户索引和产品索引, 为用户偏好,交互为 ,用户特征从 到 的转移表示为干预 ,OOD推荐系统的任务即为推断出经过干预后用户交互的分布,具体分为两个任务:第一是在只能够获取到用户特征变化前的历史交互信息的情况下,为特征变化后的用户推荐合适的产品;第二是当用户特征变化后的交互能被获取时,推荐系统具有快速适应到OOD环境的能力。

方法

作者提出了Causal OOD Recommendation(COR)框架为交互的生成过程进行建模来解决用户特征变化后的OOD场景下的推荐问题。相对的,用户变化前的环境即传统的训练环境(拥有用户特征与对应的历史交互信息)被称作Independent and Identically Distribution (IID)环境。

1. 目标函数

假设用户的不可观测变量 服从标准正态分布,同时受观测特征与不可观测特征影响的用户偏好 ,和仅受不可观测特征影响的用户偏好 均服从分解高斯分布。交互信息则服从多项式分布。

其中 和diag 分别表示从 和 估计的高斯分布的均值和方差。 和diag 则分别表示从 估计的高斯分布的均值和方差。多项式分布的参数 ,代表用户的产品交互数量。 则表示用 对输出归一化的结果。

模型参数 通过重构用户的历史交互进行优化。具体地,给定一个用户 ,和该用户的特征 以及交互历史 ,想要最大化log-likelihood log :

但是对不可观测变量 进行积分显然是难以实现的。为了解决这个问题,作者利用变分推断将难以实现的积分转变为可计算的ELBO:

其中最后一条等式的第一项为重构损失,第二项则是用户特征 的分布预估误差,即估计分布和先验分布的KL散度。于是现在只需要通过最大化ELBO,来实现log-likelihood的最大化。

2. 实现方法

我们已经知道目标函数为ELBO,而要计算ELBO,就需要计算得到 和log 。关于第一项

作者通过引入一个编码器 来获取 和 。而关于第二项

作者通过蒙特卡罗方法并引入一个解码器 获取 作为对 的估计,最终可以得到

其中 表示用户 是否和产品 交互, 是对 经过 归一化后的结果,该式最终可以计算出重构时用户产生交互的概率。

综上,训练模型时就可以通过最大化ELBO来优化编码器和解码器的参数 。而在测试的时候,通过估计的交互概率 为所有产品排序并作出推荐。

3. 因果推断方法

我们已经知道在用户特征没有发生变化时(IID),通过最大化ELBO来优化模型参数。但是在用户特征发生变化时,作者提出用反事实推理来估计用户 对产品 的交互概率。该反事实推理是通过设想如果 并没有受到历史交互 的影响,用户的推荐产品会是哪些?反事实推理分为三个步骤:(1)通过用户可观测特征 和 估计出用户偏好 。(2)干预 ,即视用户没有历史交互信息,估计不可观测的用户特征 以及用户偏好 ,这样就能够消除过时的交互信息 的影响。(3)利用 和 计算用户和产品的交互概率。

4. OOD环境的微调

在用户特征发生变化后,会逐渐获取新的历史交互信息 。在OOD环境中,重复利用用户特征没有发生变化时的 ,并微调模型更新OOD环境下的用户偏好 为用户做OOD环境下的推荐。由于作者所提出的模型是基于因果关系建立的,因此在用户特征发生变化后,该模型会有更稳定的推荐表现并且在OOD环境中需要更少的交互信息 来调微调。

实验

-

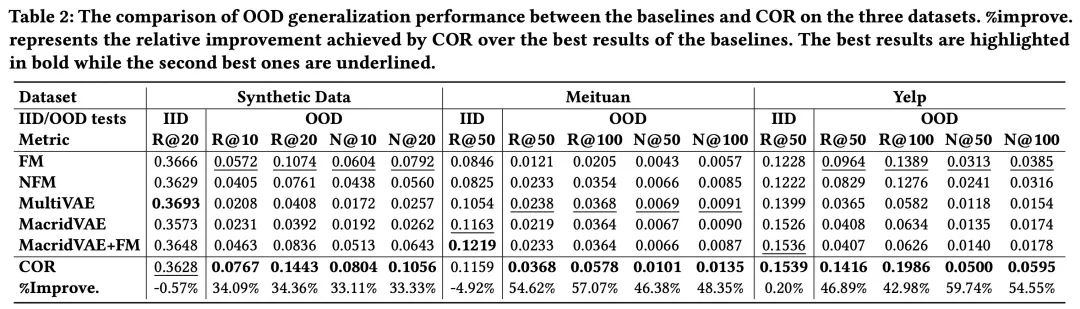

作者在三个数据集上验证了COR的强大 OOD泛化能力,在不同数据集下IID和OOD环境下模型的表现如图所示:

可以看到在OOD环境下,COR的召回率相比最高的基准模型提升了超过34%,同时在IID的环境下与基准模型具有相近的表现,从而验证了COR框架的较强的OOD泛化能力。

-

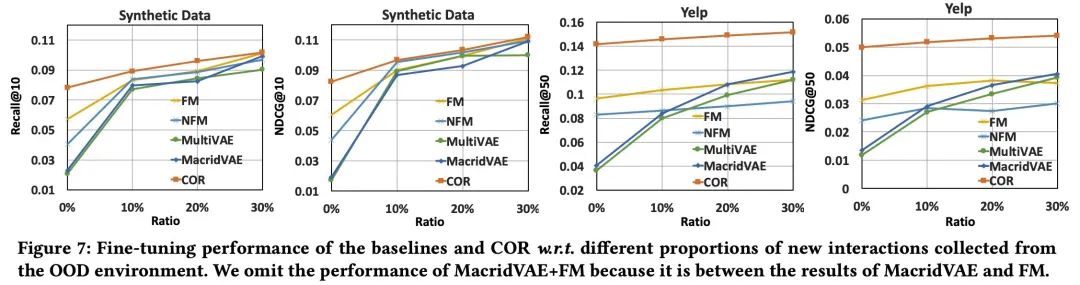

而对于第二个OOD推荐任务的目标即 快速适应能力,作者也在不同数据集上进行了验证,如图所示:

通过对比在用户特征发生变化后的OOD环境下,分别对没有最新交互信息(0%),和10%,20%以及30%的最新交互信息微调在IID上预训练好的模型。实验结果验证COR框架能够让模型拥有很快的OOD适应能力

-

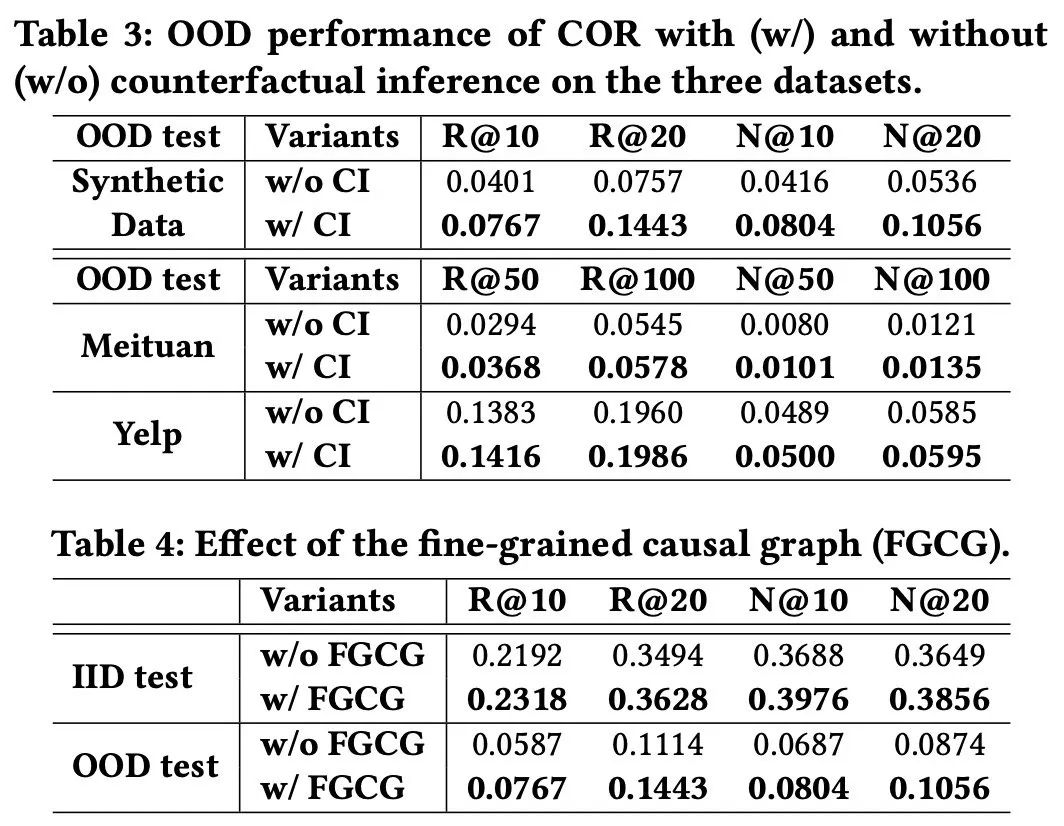

反事实推理和细粒度因果图的消融实验:

-

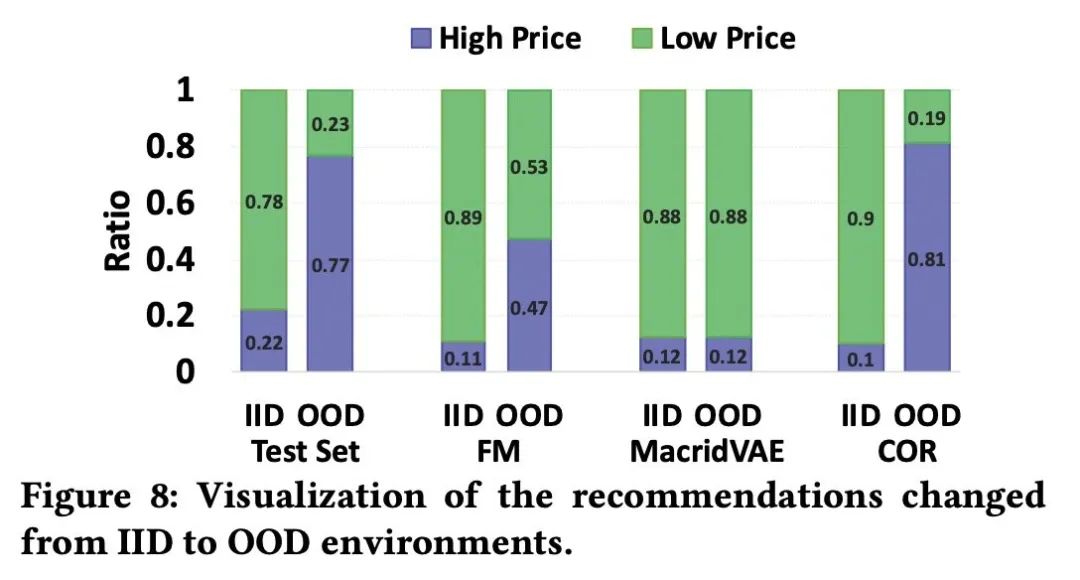

案例分析:在IID环境中用户收入较低,真实消费更偏向于低价产品,而在OOD环境中用户的收入较高,真实消费更偏向于高价产品。IID和OOD环境下不同模型为用户推荐的产品在价格的分布如下图所示:

可以看到COR推荐的分布最逼近不同环境下的真实交互产品分布。

结论

作者提出且规范了用户特征发生变化的OOD推荐问题。为了达到较强的OOD泛化能力和快速的OOD适应能力,作者提出了COR框架,从因果关系的视角为用户的交互过程进行建模,利用干预和反事实推理减轻了OOD环境中过时的交互信息对推荐结果的影响。此外,通过在OOD环境的微调,推荐模型能够快速适应并给出更恰当的推荐。