一张图生成定制版二次元人脸头像,还能“模仿”你的表情

转载自:AI科技大本营(ID:rgznai100)

作者:Pramook Khungurn

整理:Jane、刘畅

【导读】最近,日本一位酷爱 Vtubers的粉丝结合了此前发表的多项 GAN 工作制作了两个动漫人物生成器的工具,这两个工具一个可以帮助广大动漫迷们快速、轻松的生成带有不同姿态的动漫人物形象,另一个可以帮助大家把真人脸表情移植到动漫人物上,以后你也可以定制你的“动漫Twins姐妹 / 兄弟”了。

效果展示

copy 你的一颦一笑,不在话下。看了上面的最终成果展示视频,再来了解这两个工具是怎么做到的吧。

首先是第一个工具:基于GUI的单图动漫人脸表情生成器。

基于这一个工作的成功方法,作者还在这个系统中加入了人脸表情检测功能。这个动漫角色就可以实时模仿人脸的表情了。通过改变输入,用摄像头获取的人脸姿态表情特征,输入后让动漫人物 Get 到人脸表情同款:

有了第二个工作,作者也尝试把输入换成一段视频,当然方法同样奏效。

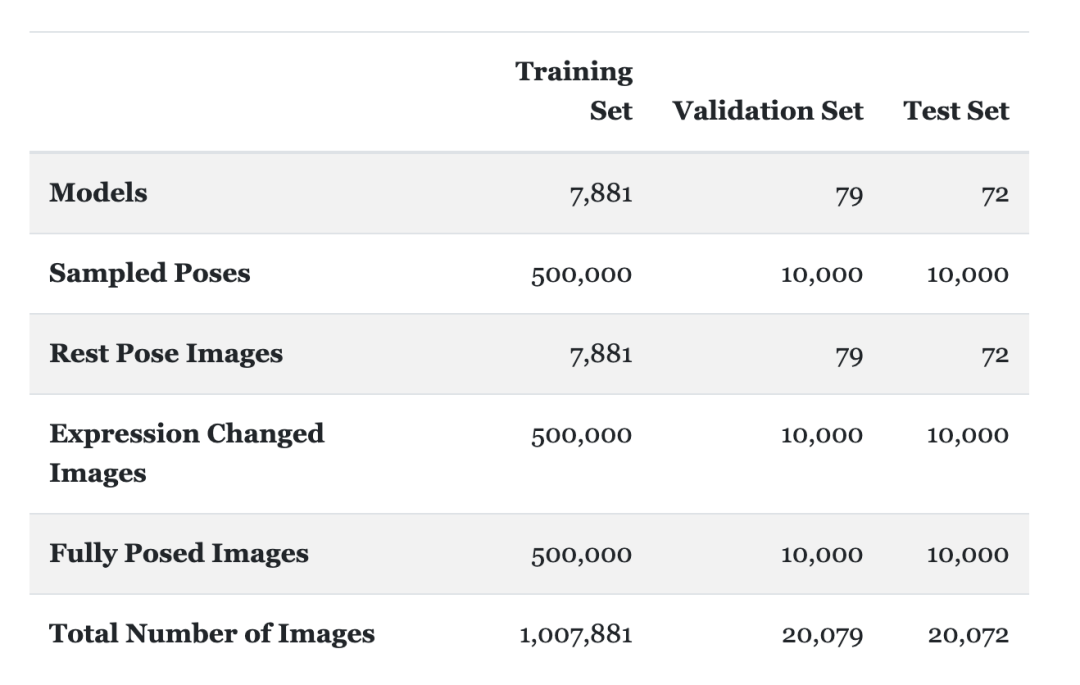

这么有意思,卡哇伊的工作是怎么做到的?下面我们会介绍一下模型、数据这两大方面的方法,但是在整个工作中,还涉及如何标注数据、图像数据处理规范、采样与渲染等诸多细节工作的处理,我们无法一一讲到,但是作者本人进行了详细的说明与介绍,大家可以仔细阅读项目。

项目地址:

https://pkhungurn.github.io/talking-head-anime/

方法介绍

(1)输入和输出

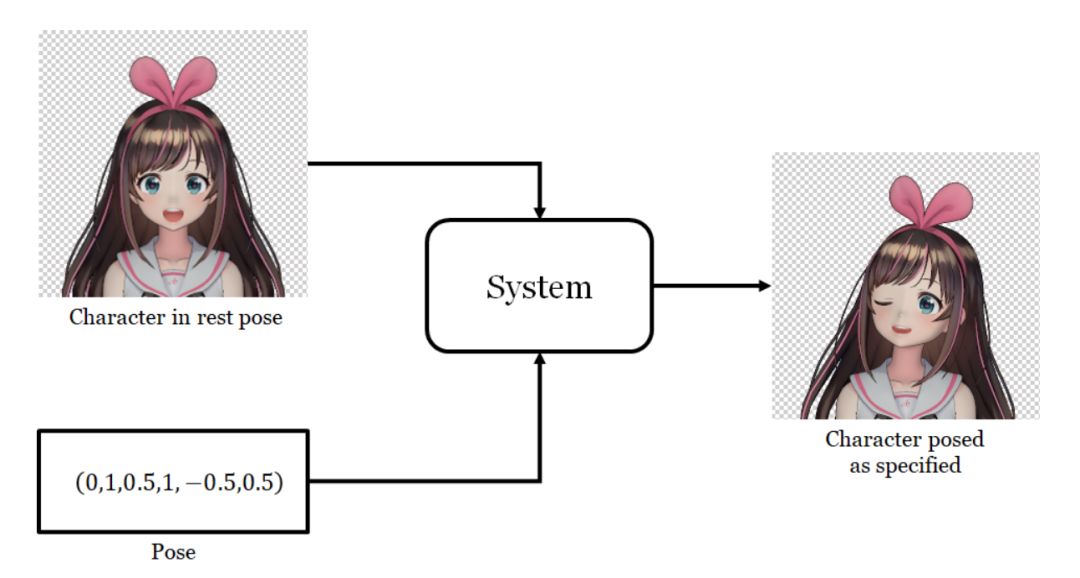

大家在上面的视频中可以看到,界面左侧表示的是输入的单幅动漫人物图像,中间罗列了 6 种姿态调节栏,每种姿态有一定的设置范围,可以多种姿态叠加使用,而右侧图像中则直接输出生成的效果图像。即整个工作只需要输入一张动漫脸和一个姿态(如一种表情),系统就可以在另一张背景中输出给定姿态的动漫脸。

输入与输出

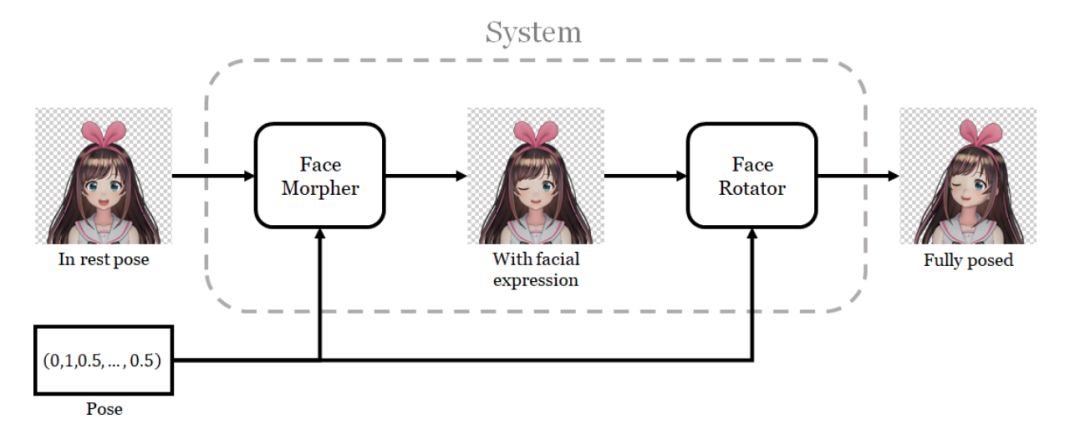

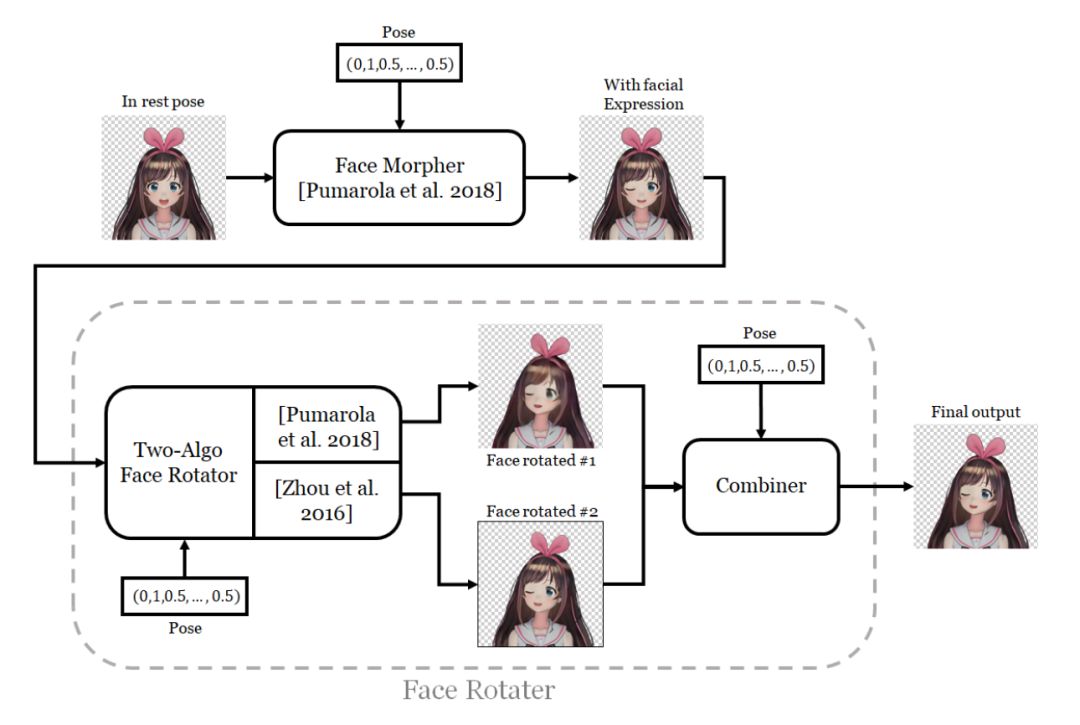

(2)实现的主要两个环节

“两步走”系统

“两步走”系统

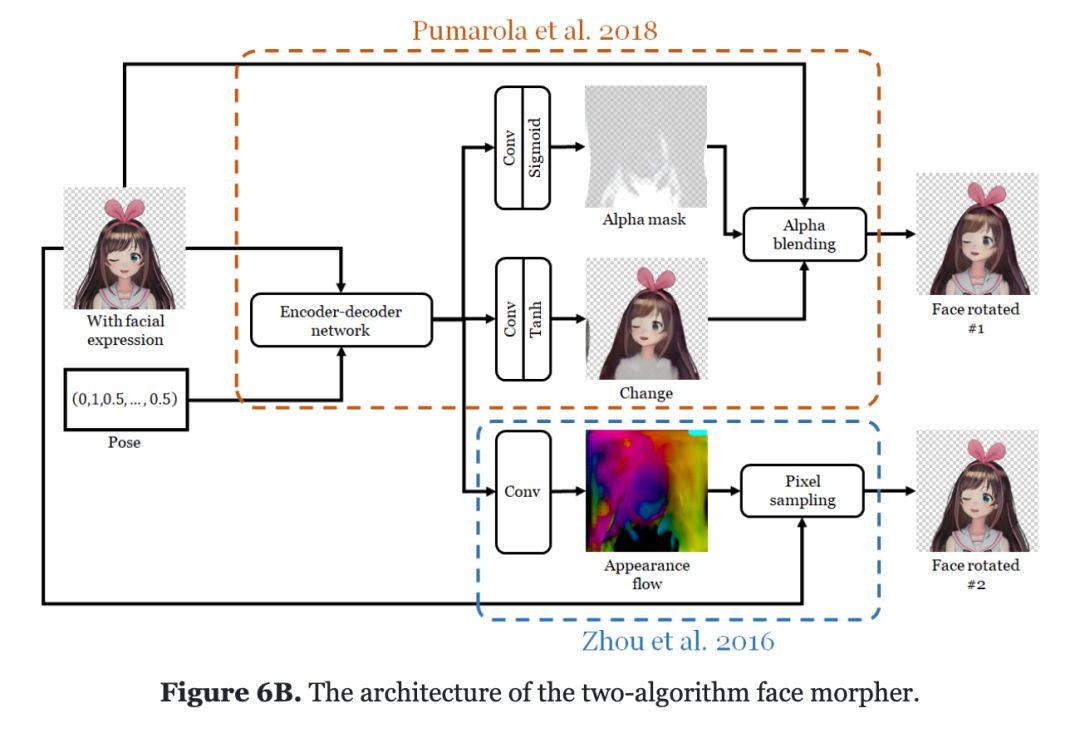

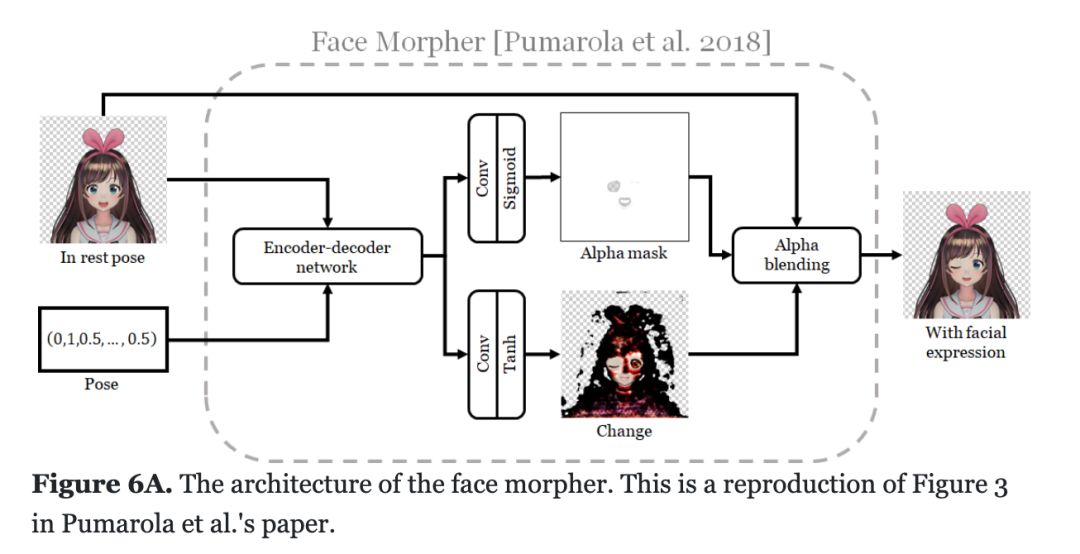

模型总图

模型总图

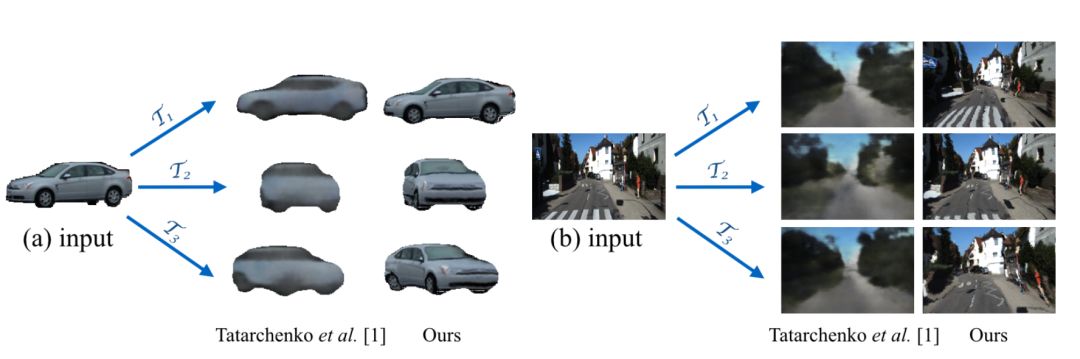

《View Synthesis by Appearance Flow》

《View Synthesis by Appearance Flow》

(1)关于 GANimation 模型,可阅读论文: https://www.albertpumarola.com/research/GANimation/index.html (2)《View Synthesis by Appearance Flow》 https://arxiv.org/pdf/1605.03557.pdf

MikuMikuDance,简称 MMD,是一个免费的动画程序,可让用户制作动画并创建3D动画模型。

总结

登录查看更多

相关内容

专知会员服务

27+阅读 · 2019年8月10日