ICCV 2019 | Label-PEnet: 基于序列化标签传播与增强网络的弱监督实例分割

点击上方“CVer”,选择加"星标"或“置顶”

重磅干货,第一时间送达

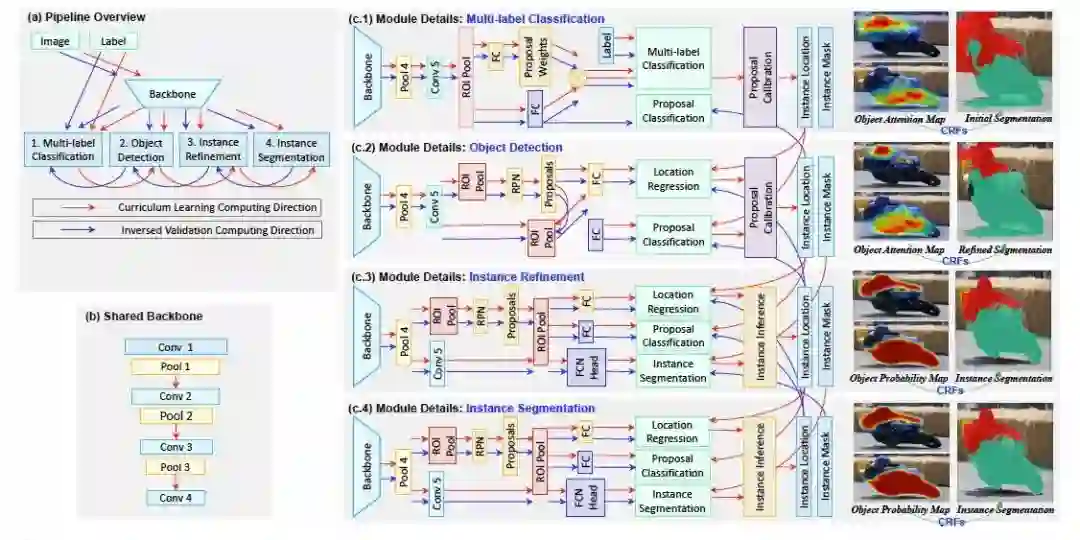

本文来源:码隆科技

弱监督学习致力于在仅仅给定图像级别标签的情况下精确地检测与分割物体实例。不同于以前那些包含多个离线模块的方法,我们提出了序列化标签传播与增强网络(缩写为 Label-PEnet)。Label-PEnet 基于一种由粗到细的方式可以递进地将图像级别的标签转化成像素级标签。我们设计了四个级联的模块,包括多目标分类模块,物体检测模块,实例细化模块和实例分割模块。这些模块共享同一个主干网络。我们基于课程学习的策略交替这些级联的模块,从而把标签从高层图像级别推广到低层像素级别。此外,我们提出了物体候选校准模块去分析一个分类网络,找出那些代表物体部件的重要像素。该模块作为一种后期校验的策略以一种和正向前馈相反的方式运行。我们在标准测试集 PASCAL VOC 2007 和 PASCAL VOC 2012 上评估 Label-PEnet 在挖掘实例掩码上的效率。实验表明 Label-PEnet 超越了明显超越了现有最新算法,并且和全监督的方法有一定的可比性。

基于大量手工标注数据,深度卷积神经网络在计算机视觉中取得了巨大突破。通过设计强大的网络结构,卷积神经网络可以检测物体位置,并精确地分割出物体实例。然后,当缺少物体级别或者像素级别标注信息时,仅仅使用图像级别的标签训练出的神经网络在物体检测和分割方面的性能将会大幅下降。

为了探究神经网络在仅给出图像级别标签下估计像素级别标签的能力,许多弱监督检测和分割方法被提出来。一些方法使用自底向上的方式将像素聚合形成物体候选,然后重复评估这些物体候选并找出物体的准确位置。另外一些方法通过自顶向下或者自底向上的方式,分析卷积神经网络的分类过程,从而为实例分割生成实例候选。也有一些方法结合了以上两种方式。

现有的弱监督学习方法可以达到很有竞争力的结果,但是仍然和全监督方式训练出的神经网络有很大的性能差距。尽管我们可以通过一个分类网络去粗略地鉴定出物体位置,但即使是在使用多种后处理的情况下,想要精确地对像素进行分类仍然是十分困难的。这促使我们重新思考卷积神经网络在各种视觉任务中的角色,比如图像分类,物体检测和实例分割等。我们发现全监督方式中精确的标注信息是成功的关键。因此,弱监督检测和分割的核心任务就是如何以由粗到细的方式使用多种模块逐步地将图像级别标签转换为像素级别标签。

卷积神经网络的二维结构允许它能够准确地抓取局部信息,并且随着网络的加深其卷积核的感受域也随之变大。这些特性允许它能够记住并正确分类物体。我们的目标是在仅仅只有图像级别的标签的情况下分割出物体。这里我们一种按序级联的卷积神经网络。它包含四种模块:a)多目标分类模块,b)物体检测模块,c)实例细化模块,和 d)实例分割模块。

多目标分类模块 在这个模块中,一张图像首先被分化成许多小块,然后生成一系列的物体候选。这里我们使用基于低阶统计特性的无监督方法 Selective Search 或 Edge Box 来生成物体候选。然后一个分类分支和一个加权分支被引入以实现多目标分类。此外,我们提出了一个物体候选校准模块,用以更加准确地定位物体,并精确地预测出每个候选中的像素标签。

物体检测模块 使用生成的粗略物体位置信息来训练一个标准的 Faster-RCNN 物体检测模型。但是这样的话可能会导致训练不够稳定。这里我们把分类模块中每个物体候选的得分作为训练物体检测的权重,并且在序列化学习时在线推理物体位置。类似地,我们使用物体候选框校准来判定哪些像素属于相应物体,以进一步提升检测和分割准确率。

实例细化模块 在拥有生成的物体位置和实例掩码之后,我们使用 Mask-RCNN 训练标准的实例分割。然而,当前监督信息仍然不够准确,因此我们需要进一步使用检测模块中的得分去引导当前的实例分割的训练。此外,我们使用增添新的实例分割分支是因为随着神经网络训练的进行,它可以逐步修正之前物体候选校准模块单个生成的实例掩码中的错误。

实例分割模块 在这个模块中,我们获得相对而言更加强大和精确的监督信息。这些信息被用以指导当前实例分割的训练,并生成最终的实例分割结果。

本文的主要贡献总结如下:

第一,我们设计了一种新的弱监督实例分割算法:序列化标签传播与增强网络(Label-PEnet)。Label-PEnet 包含四个级联的模块来逐渐地挖掘、总结并修正对物体表观的精确预测。Label-PEnet 的训练包含了两个阶段。它是探索卷积神经网络在识别像素方面向前迈进的重要一步,并提升了弱监督实例分割的性能。

第二,我们提出了一个物体候选校准模块去揭示卷积神经网络的分类过程,然后从图像级别和物体级别去挖掘像素标签。在这个模块中,自上而下和自下而上的方法都被使用并且被结合去精确地识别物体像素。

第三,为了检验 Label-PEnet 的性能,我们在标准数据集 Pascal VOC 2007 和 Pascal VOC 2012 上进行测试。实验证明 Label-PEnet 可以明显超越现有的方法,并且性能与全监督方法有一定的可比性。

3.1 任务背景与方法总述

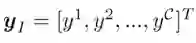

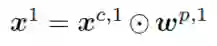

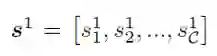

给定一张标签为

3.2 多级联模块

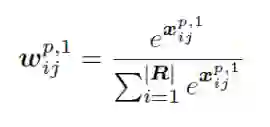

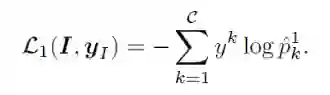

多目标分类模块 这个模块的目标是使用图像类别标签生成出一系列物体候选的对应类别置信度和对应候选框对于最终分类的权重。为了粗略地鉴别出物体区域,我们使用 Selective Search 去生成一系列物体候选框

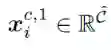

对于一个分辨率为

这里

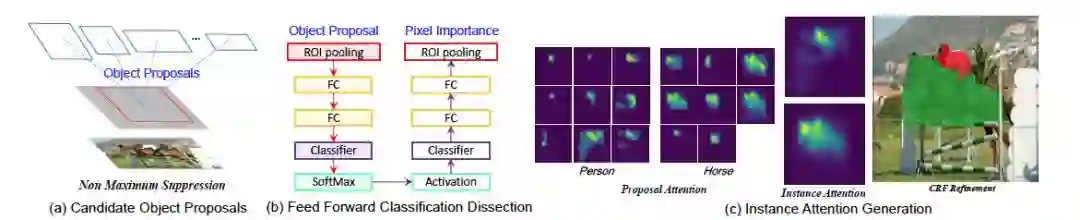

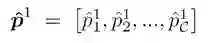

物体候选框校准模块 前面模块中的那些物体候选框和他们的分类得分

最近一种叫做 Excitation Back-Propagation (Excitation BP) 的方法被提出来使用预测出的图像级别的标签去生成一个具有判别性的物体注意力图像。这启发我们去使用预测的分类得分来为每个物体候选框计算出注意力图像。我们分析与分类模块相同的网络结构。具体地说,给定一个物体候选框

我们进一步对每个实例类别计算一个物体热力图。对于实例类别 c,我们计算每个候选框的分类得分

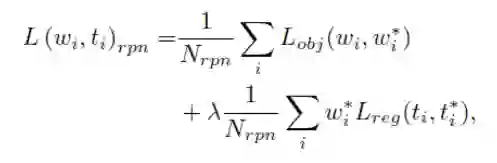

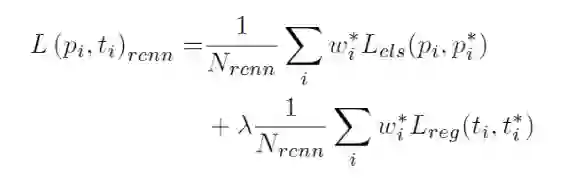

物体检测模块 在拥有生成出的物体外接框

这里

这里

实例精细化模块 在拥有生成出的实例掩码

实例分割模块 在这个模块中,图像级别标签被成功地转移到密集的像素级标签。我们简单的采用实例精细化模块中的策略,用标准的全监督的方式训练实例分割,并最终输出实例分割的结果。

3.3 基于标签传播的训练

为了更好地训练序列化模型并避免局部最小值,我们使用一个 ImageNet 预训练的模型初始化我们的主干网络。整个训练过程通过使用前面模块的输出而逐渐地增强监督信息。我们采用了级联预训练和前向后向课程学习来完成整个网络的参数训练。

级联预训练 主干网络在进行级联预训练时被固定住。我们依次从多目标分类开始到实例分割逐步对四个级联模块进行预训练。当当前模块训练收敛,模型输出被修正后,该输出作为下一个阶段的训练数据。通过级联预训练,我们将弱监督实例分割任务分解为四个序列化的子问题,将图像级别的监督信息逐渐地并且高效地传播到密集像素级别。

前向后向课程学习 训练四个级联模块是非常有挑战性的,因为在进行标签传播时,网络非常容易陷入局部极小值。为了克服这个问题,我们提出了前向后向课程学习。课程学习包含两个阶段,即前向课程学习阶段和后向验证阶段。在前向课程学习阶段,四个模块被依次训练,同时监督信息逐渐增强。在反向验证阶段,我们以相反的方向训练这四个模块。反向训练模块从实例分割模块开始,它仅仅进行推理,为实例精细化模块准备好物体位置和实例掩码。然后实例精细化模块被以一种全监督的方式进行,为物体检测模块提供训练数据。在多目标分类模块,我们将和物体检测模块推理出的物体位置重叠大于 0.5 的都设定为相应物体,否则设为背景。然后我们在这些物体候选中进行单标签分类,同时保持多标签分类任务。在每次迭代中前向后向学习交替进行,并放开主干网络使其参与参数训练。

我们提出了一种新的弱监督物体检测与实例分割算法,叫做序列化标签传播与增强网络(简写为Label-PEnet)。Label-PEnet 使用四个级联的模块可以以一种由粗到细的方式逐步地将图像级别的标签转换为像素级别的预测。这四个模块分别是:多目标分类模块、物体检测模块、实例精细化模块与实例分割模块。此外,我们设计了一种候选框校准模块去探索用于进行分类任务的卷积神经网络在鉴别物体上关键像素的能力,从而提升后续检测和分割任务的准确率。我们的算法在标准的弱监督物体检测和分割的测试集上进行了,明显超过了现有的最新算法。

重磅!CVer-图像分割交流群已成立

扫码添加CVer助手,可申请加入CVer-目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪&去雾&去雨等群。一定要备注:研究方向+地点+学校/公司+昵称(如图像分割+上海+上交+卡卡)

▲长按加群

▲长按关注我们

麻烦给我一个在看!