NLP入门 | 通俗讲解Subword Models

作者:芙蕖,Datawhale优秀学习者,东北石油大学

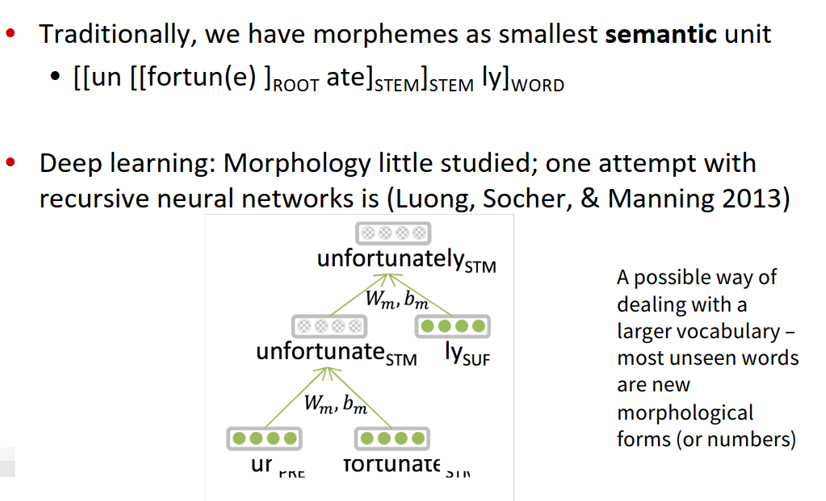

对于英文来说,文字的粒度从细到粗依次是character, subword, word,character和word都很好理解,分别是字母和单词。而subword相当于英文中的词根、前缀、后缀等,如unfortunately中的un、ly、fortun(e)等就是subword,它们都是有含义的。

首先,来梳理下word-level存在的几个问题:

-

需要系统需要极大的词汇量; -

如果遇到了不正式的拼写, 系统很难进行处理; 做翻译问题时, 音译姓名比较难做到。

一、人类语言声音:语音学和音系学

语音学(Phonetics)是一种非常基本的理论,只要是正常人,有着相同的人体器官和相同的发声结构,就会遵循着相同的发声规则和原理。

语音体系(Phonology)是有语义的声音的合集,各国各文明的人都会制定自己的语音体系。

-

音素(Phoneme)是语音中划分出来的最小的语音单位,分为元音和辅音

国际音标(由音素构成)按理来说可以表示所有的语音,但是会发现好多语音是没有语义的,这时我们采取的办法就是看音素的下一级(part of words)。

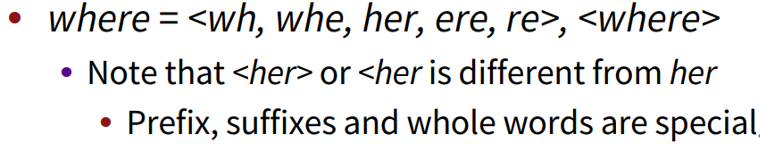

词法学:一个n-grams的代替方案。在基于单词的模型中存在一些问题:需要处理很大的词汇表,在英语中单词只要变个形态就是另一个单词了,比如说:gooooood bye

二、字符级模型(Character-LevelModels)

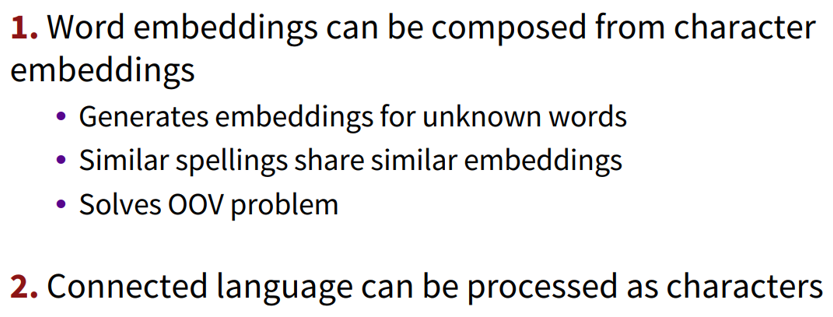

单词嵌入可以由字符嵌入表示:

能为不知道的单词生成嵌入

相似的拼写有相似的嵌入

解决了oov问题

三、子词模型(Sub-word models)

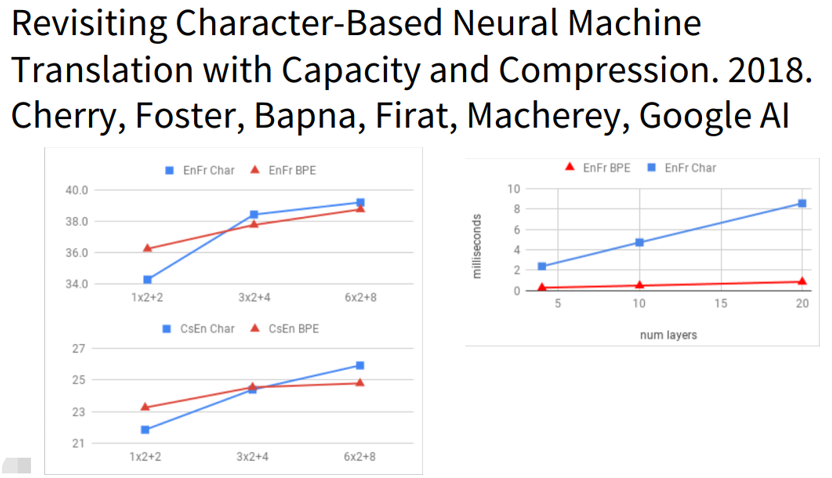

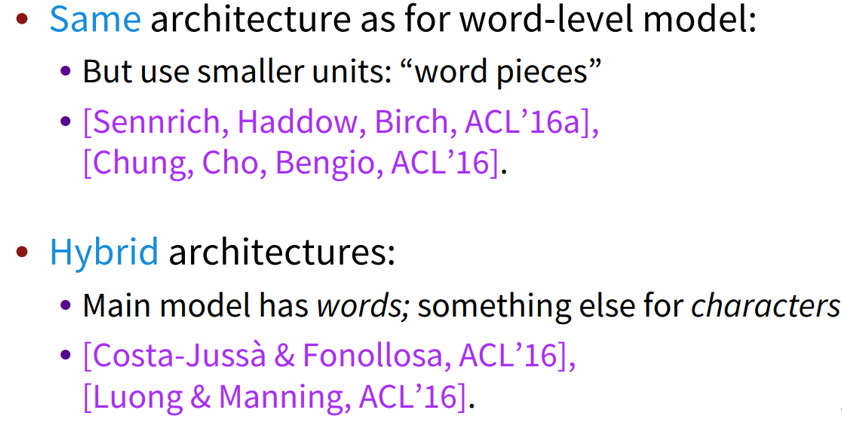

Hybrid architectures:主要的模型含有单词,一些其他的含有字符、字节对的编码。使用的是一个压缩算法:将大部分频繁出现的字节对标记为新的字节对。

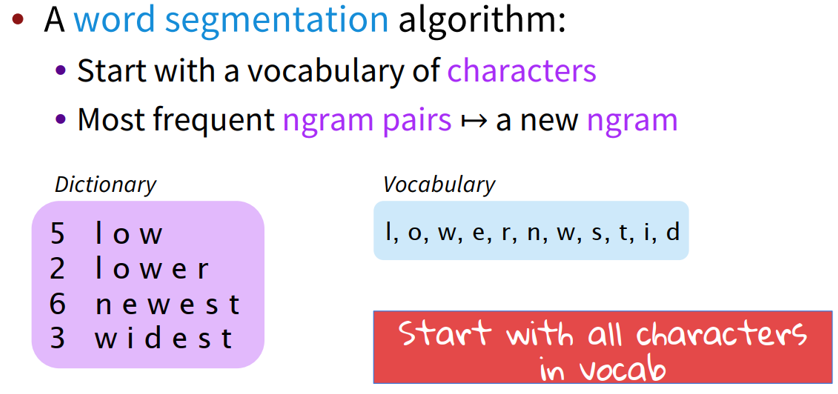

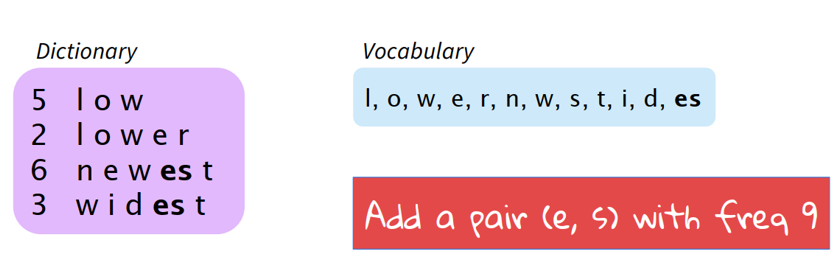

3.1 Byte Pair Encoding(BPE)

Byte Pair Encoding,简称BPE,是一种压缩算法。

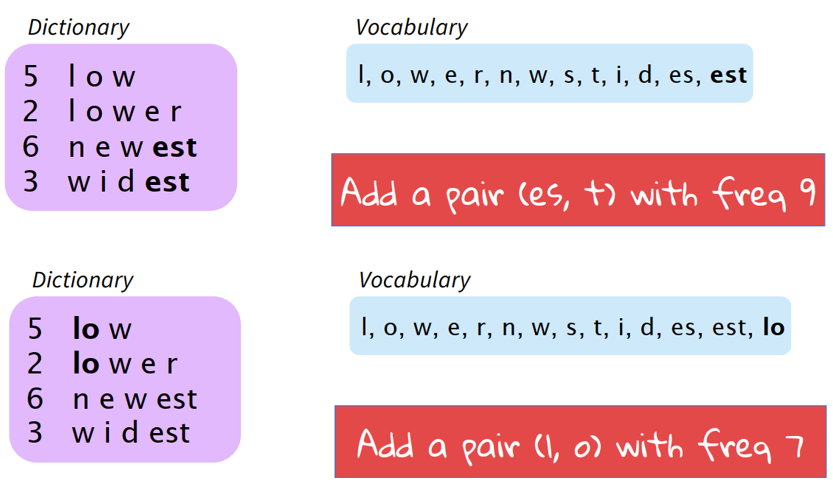

上述例子是,比如有一个初始的文本库和词汇库。首先,可见此时出现频率最高的n-gram pair是“e,s”,出现了9次,因此我们将“es”作为新词加入到词汇库中同时更新文本库。然后,这时词汇库中出现频率最高的n-gram pair是“es,t”,出现了9次,因此我们将“est”加入词汇库中同时更新文本库。依次类推,可以逐渐的通过增加新的n-gram的方式达到我们的目标。对于现实生活中有很多词汇量非常大的task,这种通过BPE逐步建立词汇库的方式就显得非常有用了。

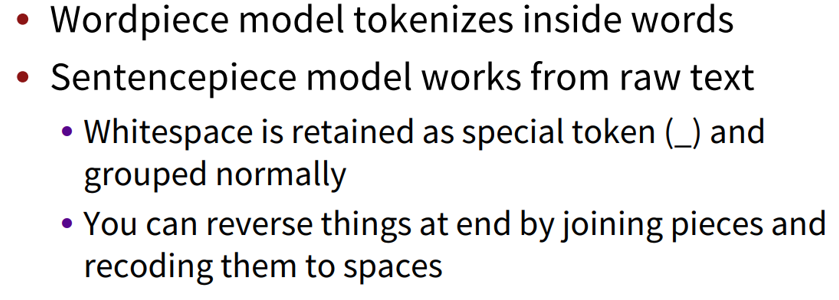

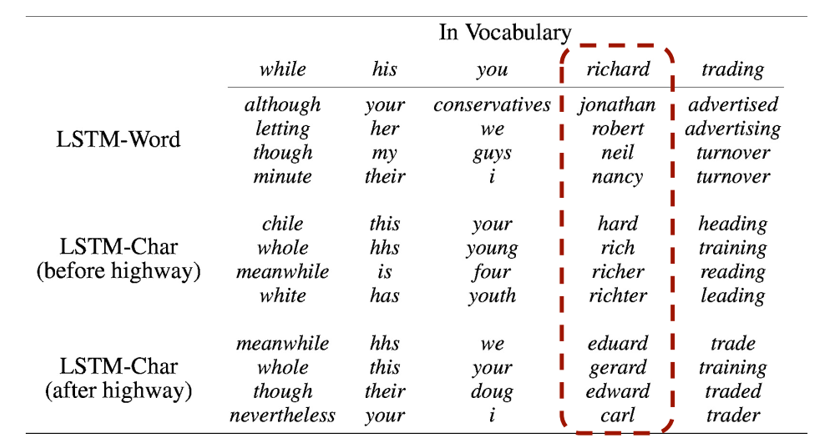

课程分析用char-level得到词向量的特点,经由他们直接输出的word-embedding更倾向于在形状上相似,输入high-way之后,形状上的相似会朝含义上的相似发展。如图所示:

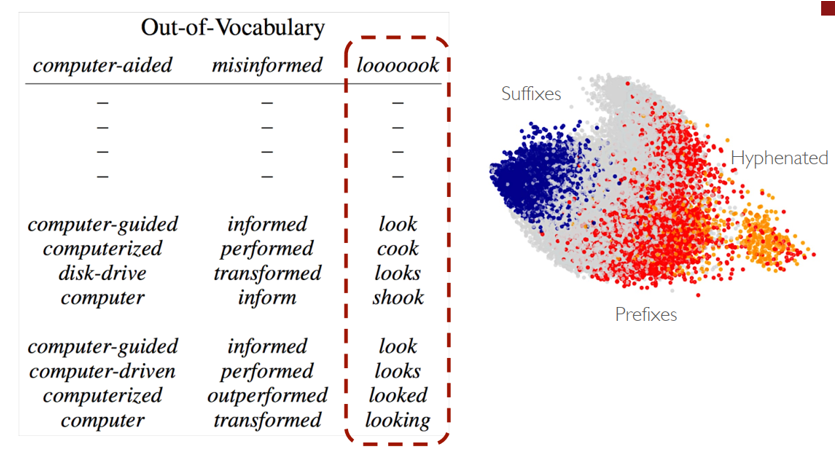

使用char-level的可以轻易解决,此没有出现在词库的情况,如图所示:

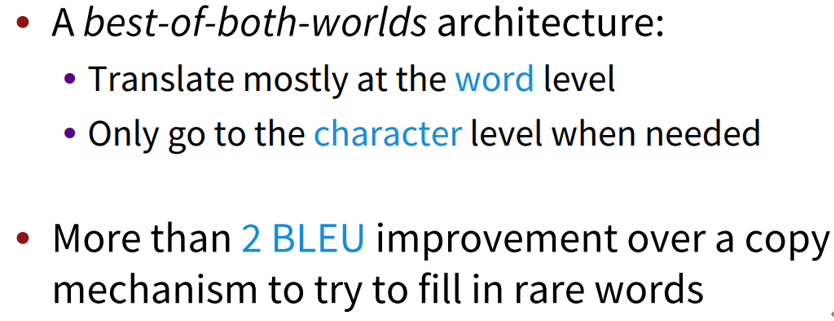

四、混合字符和词级模型

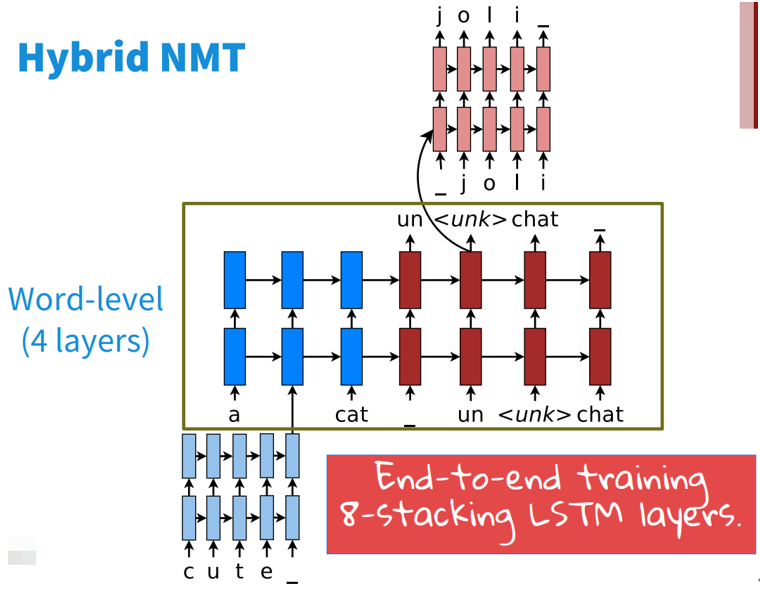

4.1 Hybrid NMT

混合模型即两种方式并存的模型,在正常处理时采用word-level的模型,当出现奇怪的词的后,使用char-level级的模型。

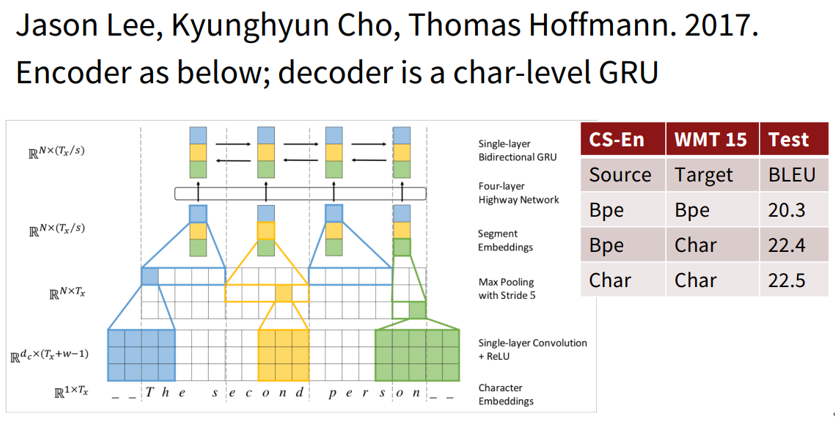

一篇论文的结构如图所示:

可以看到输入未知的单词时,采用char-level进行编码,输出< unk >时也采用char-level级的进行解码。同时训练跟beam-search也时要同时对两个结构进行。

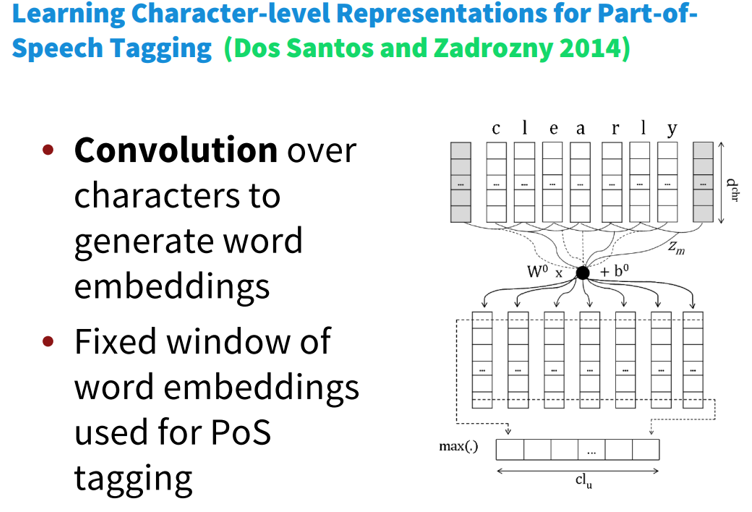

4.2 Chars for word embeddings

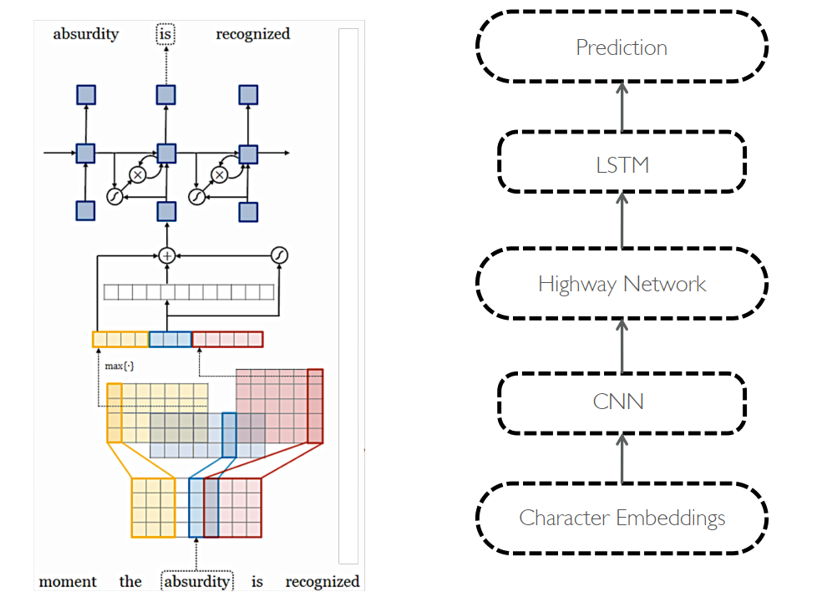

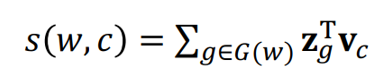

采用subword的方式长生词向量,课程中提到了FastText。主要思路如图所示:

字符的卷积来生成词嵌入

-

使用pos标记固定的窗口

五、FastText

于是,就可以使用原有的word2vec算法来训练得到对应单词的embedding。其保证了算法速度快的同时,解决了OOV的问题,是很好的算法。

5.1 FastText和word2vec的区别

1. 相似处:

图模型结构很像,都是采用embedding向量的形式,得到word的隐向量表达。

都采用很多相似的优化方法,比如使用Hierarchicalsoftmax优化训练和预测中的打分速度。

2. 不同处:

模型的输出层:word2vec的输出层,对应的是每一个term,计算某term的概率最大;而fasttext的输出层对应的是分类的label。不过不管输出层对应的是什么内容,起对应的vector都不会被保留和使用。

模型的输入层:word2vec的输出层,是 context window 内的term;而fasttext 对应的整个sentence的内容,包括term,也包括 n-gram的内容。

3. 两者本质的不同,体现在 h-softmax的使用:

Word2vec的目的是得到词向量,该词向量 最终是在输入层得到,输出层对应的 h-softmax也会生成一系列的向量,但最终都被抛弃,不会使用。

fastText则充分利用了h-softmax的分类功能,遍历分类树的所有叶节点,找到概率最大的label(一个或者N个)

FastText是一个能用浅层网络取得和深度网络相媲美的精度,并且分类速度极快的算法。按照作者的说法“在标准的多核CPU上,能够训练10亿词级别语料库的词向量在10分钟之内,能够分类有着30万多类别的50多万句子在1分钟之内”。但是它也有自己的使用条件,它适合类别特别多的分类问题,如果类别比较少,容易过拟合。

推荐阅读

征稿启示| 200元稿费+5000DBC(价值20个小时GPU算力)

完结撒花!李宏毅老师深度学习与人类语言处理课程视频及课件(附下载)

模型压缩实践系列之——bert-of-theseus,一个非常亲民的bert压缩方法

文本自动摘要任务的“不完全”心得总结番外篇——submodular函数优化

斯坦福大学NLP组Python深度学习自然语言处理工具Stanza试用

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLPer(id:ainlper),备注工作/研究方向+加群目的。

阅读至此了,分享、点赞、在看三选一吧🙏