TPAMI’21 | 跨域人脸表情识别新基准

极市导读

中山大学联合广东工业大学构建了一个统一且公平的评测基准,该基准复现了多个效果较好的跨域人脸表情识别方法,以及数个最新发表的通用领域自适应算法 >>加入极市CV技术交流群,走在计算机视觉的最前沿

在跨域人脸表情识别领域中,由于不同算法选择的源/目标域数据集和骨干网络不一致,研究者们很难对其进行公平的比较。为此,中山大学联合广东工业大学构建了一个统一且公平的评测基准,该基准复现了多个效果较好的跨域人脸表情识别方法,以及数个最新发表的通用领域自适应算法,并使用统一的源/目标域以及骨干网络选择,以此进行公平的比较评测。该基准可以公平评测各个工作提出的算法的有效性,更好地推进跨域人脸表情识别领域的发展。此外,我们提出了一个新的对抗图表达学习框架,该框架创造性地把图表示传播与对抗学习机制相结合,从而实现高效的跨域整体-局部表达协同迁移和学习。基于我们所提出的统一且公平的评测基准,该框架取得了优于所有现有方法的效果。

1. 概述

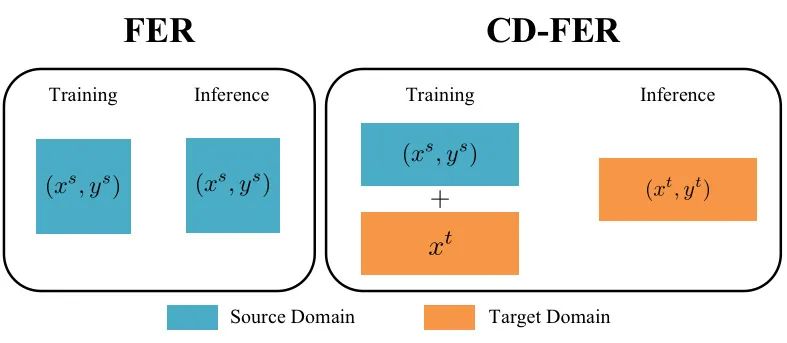

随着深度学习的快速发展,许多研究者们开始尝试利用卷积神经网络解决人脸表情识别(Facial Expression Recognition, FER)任务,并已取得了不俗的进展。但是,各个人脸表情数据集之间的数据不一致(Data Inconsistence)极大地削弱了模型的泛化能力,导致现有的大部分人脸表情识别算法在跨域场景下无法通用。因此,许多研究者致力于开发跨域人脸表情识别(Cross-Domain Facial Expression Recognition, CD-FER)算法来解决这个问题。

然而,由于不同跨域人脸表情识别算法的源/目标域数据集和骨干网络的选择不一致,导致后续研究者难以对各个工作进行全面且公平的比较。此外,当前大多数跨域人脸表情识别算法主要利用全局特征用于域迁移,却忽略了更具有可迁移性以及判别性的的局部特征。

针对上述两个问题,我们做了以下两方面的工作:

-

首先,我们构建了一个统一且公平的跨域人脸表情识别任务测试基准。为了保证对比的公平性,我们复现了多个性能较好的跨域人脸表情识别方法以及多个最新的通用的领域自适应算法,并在确保这些算法采用相同的源/目标域数据集和相同的骨干网络的设置下进行实验对比。 -

其次,我们提出了一种新颖的 对抗图表达学习 (Adversarial Graph Representation Adaptation, AGRA) 框架。该框架将图表示传播与对抗学习机制相结合,实现有效的跨域整体-局部特征协同适应。根据在测试基准上得到的比较结果,我们发现我们所提出的 AGRA 框架优于以前的最先进方法。

2. 统一且公平的评测基准

2.1. 人脸表情识别任务存在的领域偏移问题

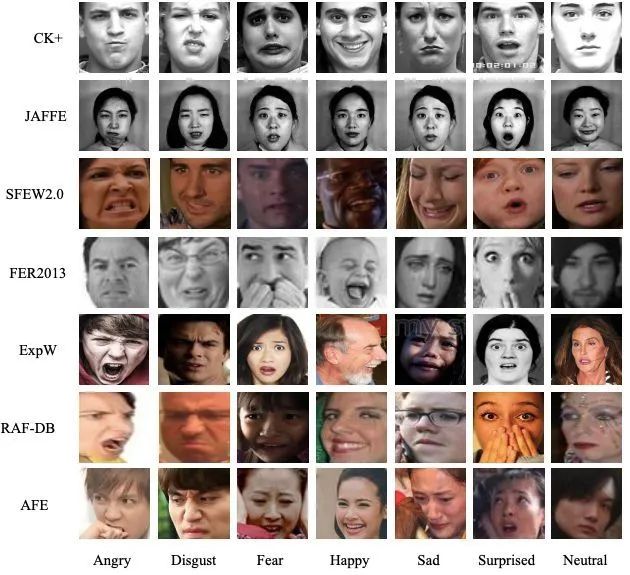

由于数据收集条件以及标注标准的不一致,各个人脸表情数据集之间存在较为明显的领域偏移,从而导致模型在跨域场景下的性能大幅下降。其中,数据收集条件不一致具体表现为收集环境不一致(实验室受控环境 vs 自然非受控环境)和目标人群不一致;标注标准不一致具体表现为不同数据集的标注人员对于表情的理解具有主观性,易受所处地区文化影响。如图 2 所示,我们可以直观地感受到不同人脸表情数据集之间所存在的明显差异。

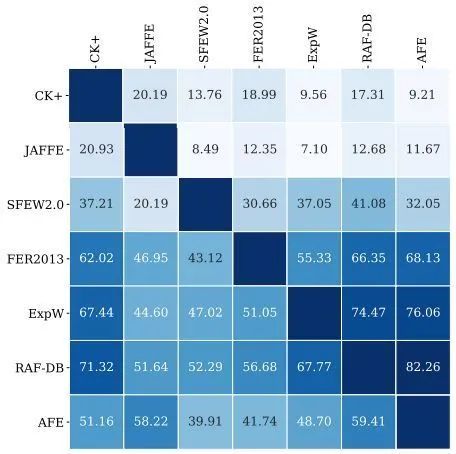

除了通过图像数据进行直观的感受外,我们还可以通过模型在各个数据集上的性能差异来衡量各个人脸表情数据集之间所存在的领域偏差。如图 3 所示,我们以 ResNet-50 作为骨干网络,分别在各个数据集上进行训练,再直接放该模型放在其他数据集上进行测试,由此得到全面且公平的基准结果。

2.2. 设置不一致的影响

在跨域人脸表情识别领域中,以往的工作往往存在对比不公平问题,使得研究者们难以准确衡量各个方法的有效性。其中,以往工作主要存在两个不一致问题:1)源/目标域数据集选择不一致,即不同算法选择的源/目标域数据集不一致;2)骨干网络选择不一致,即不同算法选择的骨干网络不一致。

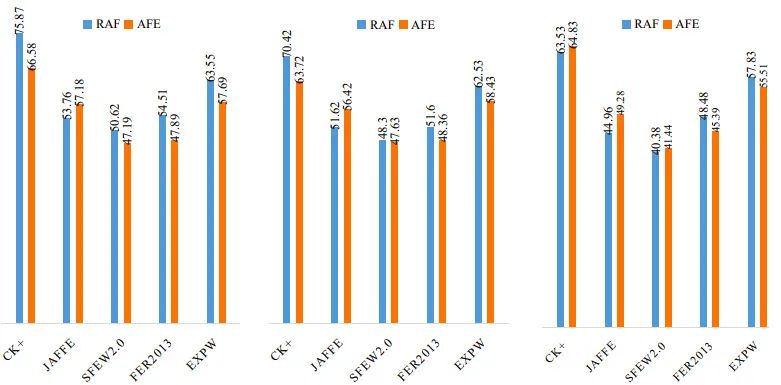

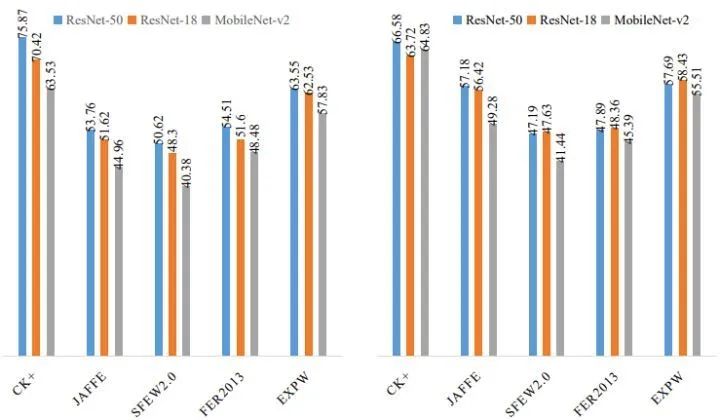

(1) 源/目标域数据集选择不一致的影响:当源/目标域数据集选择不一致时,不同算法将无法公平的进行比较。为更好地理解这一点,我们在论文中分别以 RAF 和 AFE 作为源域数据集进行实验分析,即我们统计了在使用不同骨干网络的情况下所有方法的评价测试结果:如图 4 所示,仅仅选取 RAF 和 AFE 进行源域对比实验就存在 9.29% 的性能差异,证明源/目标域数据选取不一致极大地阻碍了不同算法之间的公平对比。其中,图 4 中所使用骨干网络从左往右分别为 ResNet-50,ResNet-18 和 MobileNet-v2。

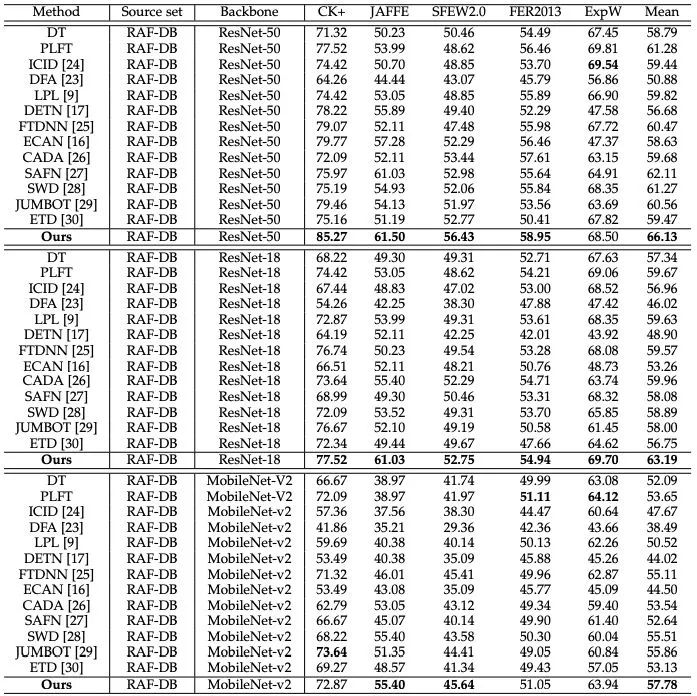

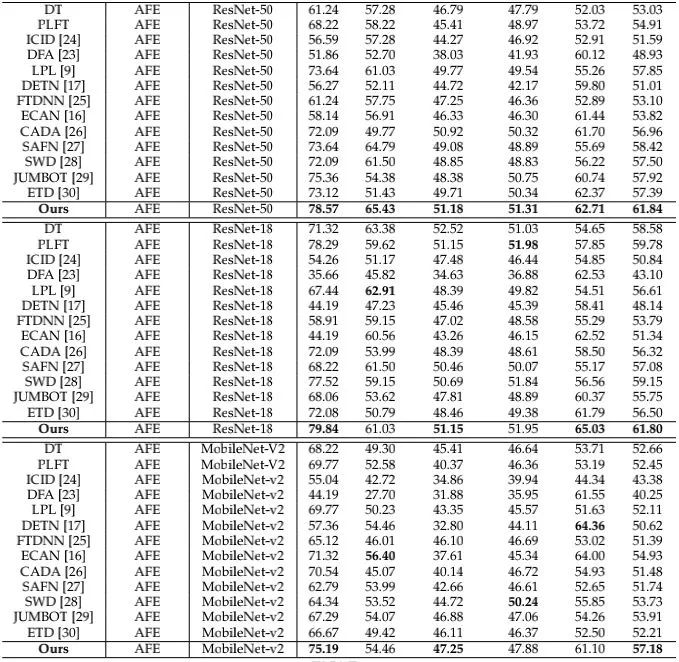

(2) 骨干网络选择不一致的影响: 当骨干选择不一致时,不同算法将无法公平的进行比较。为更好地理解这一点,我们在论文中分别以 ResNet-50,ResNet-18 和 MobileNet-v2 作为骨干网络进行实验分析。具体而言,我们分别统计了以 RAF 和 AFE 作为源域数据集时所有方法的平均测试结果:如图 5 所示,利用不同骨干网络进行特征提取会存在多达 12% 的性能差异,说明骨干网络选取不一致极大地阻碍了不同算法之间的公平对比。其中,图 5 所使用源域数据从左往右分别为 RAF 和 AFE。

2.3. 统一且公平的评测基准

为了解决上述对比不公平的现状,我们构建了一个统一且公平的评测基准。该评测基准复现了多个效果较好的跨域人脸表情识别方法,以及数个最新发表的通用领域自适应算法,并使用统一的源/目标域以及骨干网络选择,以此进行公平的比较评测。与其他工作相比,该评测基准有多个优点:

-

数据选取一致:该评测基准统一了所有方法的源/目标域数据集选取设置,以此确保对各个方法进行统一且公平的对比。 -

骨干网络选取一致:该评测基准统一了所有方法的骨干网络选取设置,以此确保对各个方法进行统一且公平的对比。 -

骨干网络多样: 该基准选择较为通用且参数量较多的 ResNet-50 和 ResNet-18,以及轻量化网络Mobilenet-v2 作为骨干网络进行测试。 -

数据集涵盖范围广:该评测基准囊括了多样化的数据集作为源/目标域:1)选择较多的数据集,包括 CK+ [1],JAFFE [2],SFEW2.0 [3],FER2013 [4],ExpW [5],RAF [6],AFE;2)数据集收集环境多样,包括实验室受控环境收集 [1, 2] 和自然非受控环境收集 [3,4,5,6] 和AFE;3)数据集人种文化多样,包括来自欧美文化 [1,3,4,5] 的以及来自亚洲文化的 [2] 和 AFE。 -

对比方法涵盖范围广:除了自然直观的方法(如:直接迁移,基于伪标签进行微调)外,该评测基准对比了多样化的不同方法:1)效果较好的跨域人脸表情识别方法,包括 ICID [7],DFA [8],LPL [9],DETN [10],FTDNN [11],ECAN [12];2)最新发表的通用领域自适应算法,包括 CADA [13],SAFN [14],JUMBOT [15],ETD [16]。

3. 对抗图表达学习

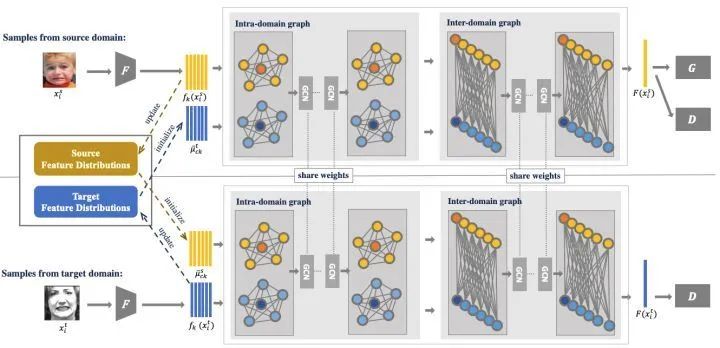

鉴于目前跨域人脸表情识别方法主要利用全局特征用于域迁移的情况,我们提出了一个新颖的对抗图表达学习框架,创造性地结合了图表达传播和对抗学习机制,以此实现跨域全局-局部特征的协同学习和迁移。具体而言,该框架首先构建两个图来分别关联每个域内和不同域之间的整体区域和局部区域。然后,该框架从所给定的输入图像中提取整体特征和局部特征,并使用可学习的各类统计分布来初始化相应的图节点。最后,该框架采用两个堆叠的图卷积网络在域内传播整体-局部特征以此探索整体区域与局部区域的相互关系,以及跨不同域传播整体-局部特征从而进行整体-局部特征的协同适应。通过这种方式,该框架可以自适应地学习细粒度的域不变特征,从而提高模型在跨域人脸表情识别设置下的性能。基于我们所提出的统一且公平的评测基准,该框架取得了优于所有现有方法的效果。

4. 亚洲人脸表情数据集

在人脸表情识别领域中,常见人脸表情数据集的人种文化主要以欧美文化为主 [1,3,4,5] ,很少有亚洲文化为主的人脸表情数据集。为补充跨人种文化表情识别这一空白领域,我们提出了一个大型的亚洲人脸表情数据集 AFE。该数据集包含 54901 张图像,其中,训练集包含 32757 张图像,验证集包含 16380 张图像,测试集包含5464 张图像。

相关成果:

T. Chen, T. Pu, H. Wu, Y. Xie, L. Liu, L. Lin, "Cross-Domain Facial Expression Recognition: A Unified Evaluation Benchmark and Adversarial Graph Learning", in TPAMI 2021. [https://arxiv.org/pdf/2008.00923.pdf]

Y. Xie, T. Chen, T. Pu, H. Wu, L. Lin, "Adversarial Graph Representation Adaptation for Cross-Domain Facial Expression Recognition", in ACM MM 2021. [https://dl.acm.org/doi/10.1145/3394171.3413822]

Project Page:https://github.com/HCPLab-SYSU/CD-FER-Benchmark

Reference:

[1] P. Lucey, J. F. Cohn, T. Kanade, J. Saragih, Z. Ambadar, and I. Matthews, "The extended cohn-kanade dataset (ck+): A complete dataset for action unit and emotion-specified expression", in CVPR Workshops 2010.

[2] M. Lyons, S. Akamatsu, M. Kamachi, and J. Gyoba, "Coding facial expressions with gabor wavelets", in FG 1998.

[3] A. Dhall, R. Goecke, S. Lucey, and T. Gedeon, "Static facial expression analysis in tough conditions: Data, evaluation protocol and benchmark", in ICCV Workshop 2011.

[4] I. J. Goodfellow, D. Erhan, P. L. Carrier, A. Courville, M. Mirza, B. Hamner, W. Cukierski, Y. Tang, D. Thaler, D.-H. Lee et al., "Challenges in representation learning: A report on three machine learning contests,” Neural Networks 2015.

[5] Z. Zhang, P. Luo, C. C. Loy, and X. Tang, “From facial expression recognition to interpersonal relation prediction", in IJCV 2018.

[6] S. Li and W. Deng, “Reliable crowdsourcing and deep localitypreserving learning for unconstrained facial expression recognition", in TIP 2018.

[7] Y. Ji, Y. Hu, Y. Yang, F. Shen, and H. T. Shen, "Cross-domain facial expression recognition via an intra-category common feature and inter-category distinction feature fusion network", in Neurocomputing 2019.

[8] R. Zhu, G. Sang, and Q. Zhao, "Discriminative feature adaptation for cross-domain facial expression recognition", in ICB 2016.

[9] S. Li, W. Deng, and J. Du, "Reliable crowdsourcing and deep locality-preserving learning for expression recognition in the wild", CVPR 2017.

[10] S. Li and W. Deng, "Deep emotion transfer network for cross-database facial expression recognition", in ICPR 2018.

[11] M. V. Zavarez, R. F. Berriel, and T. Oliveira-Santos, "Cross-database facial expression recognition based on fine-tuned deep convolutional network", in SIBGRAPI 2017.

[12] S. Li and W. Deng, "A deeper look at facial expression dataset bias", in TAC 2020.

[13] M. Long, Z. Cao, J. Wang, and M. I. Jordan, "Conditional adversarial domain adaptation", in NIPS 2018.

[14] C.-Y. Lee, T. Batra, M. H. Baig, and D. Ulbricht, "Sliced wasserstein discrepancy for unsupervised domain adaptation", in CVPR 2019.

[15] K. Fatras, T. Sejourne, R. Flamary, and N. Courty, "Unbalanced minibatch optimal transport; applications to domain adaptation", in PMLR 2021.

[16] M. Li, Y.-M. Zhai, Y.-W. Luo, P.-F. Ge, and C.-X. Ren, "Enhanced transport distance for unsupervised domain adaptation", in CVPR 2020.

如果觉得有用,就请分享到朋友圈吧!

公众号后台回复“transformer”获取最新Transformer综述论文下载~

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~