为啥看恐怖片老是忘不掉?最新研究:恐惧记忆的形成方式更利于稳定存储

博雯 发自 凹非寺

量子位 | 公众号 QbitAI

为啥恐怖片看完了老是忘不掉?

科学家们观察了**活体大脑”中的记忆形成过程后,得出了答案。

你没听错,确实是在肉眼观摩了全程后发现:

大脑会用不同的编码途径形成不同类型的记忆,比如像恐怖片这种会造成心理创伤的记忆,就会选择一种简单粗暴的做法——

直接剪掉大脑皮层中的某些突触,并在其他区域生成新的突触。

就像是盆栽的修剪和移植一样。

这项研究引起了诸多热议,获得了500+的热度:

目前,这项研究已经登上PNAS:

肉眼观测“恐惧”形成过程

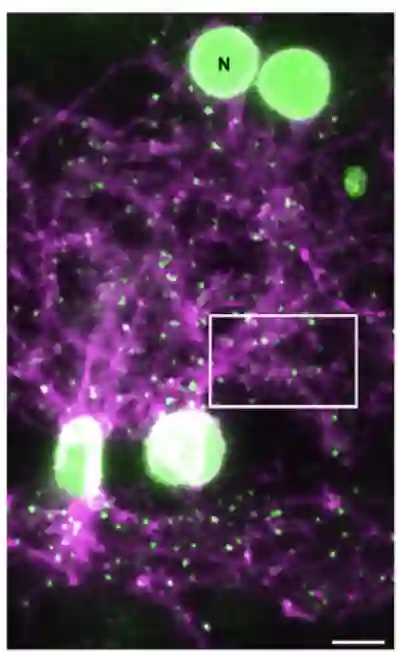

科学家们选择了斑马鱼作为研究对象。

这种生物在幼年期是全身透明的,非常易于观察。

并且,虽然没有哺乳动物负责联想记忆的杏仁核(amygdala),但有一个功能类似的大脑皮层区域。

对于记忆形成的过程,学界的有一种普遍认知:

即大脑是通过调整神经元之间连接的强度,修改突触来形成记忆的。

为了让这个过程可视化,科学家们通过基因工程让斑马鱼产生神经元,并加入了一种标记蛋白,能够在显微镜下观察到荧光:

接下来,就是给斑马鱼人为地制造恐怖回忆了。

研究人员选择了使用“巴浦洛夫的狗”的逆向版方法——

就像是狗最后被训练成听到铃声就以为能够获得奖励,自动分泌唾液一样。

让斑马鱼把光和不舒服的加热联系起来,最终形成一种恐惧心理,使斑马鱼看到光就游开。

接下来就是观测这种回忆形成前后的不同之处。

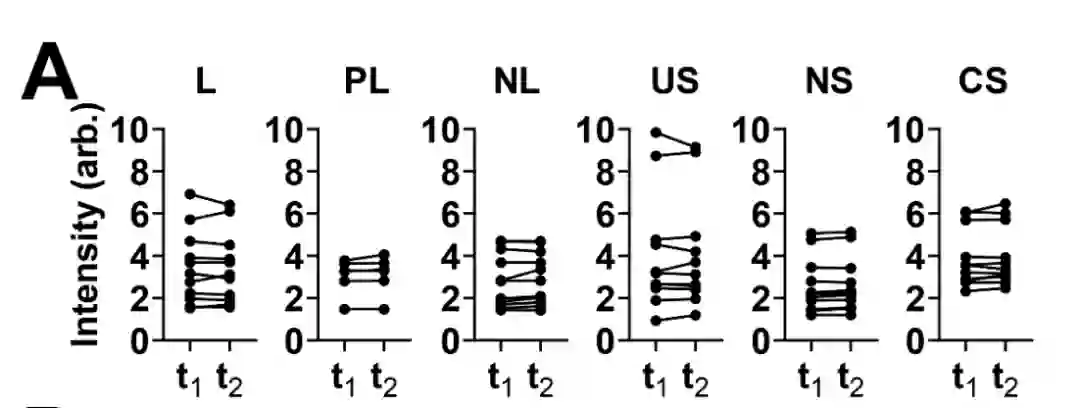

首先,科学家们发现,在任何组中,记忆产生前后的荧光标记的中位值都基本一致:

△t1为记忆前,t2为记忆后

这就意味着一个与预期相反的发现:突触的强度并不会随着学习行为而产生变化。

既然并没有修改突触强度,那么记忆到底是怎么形成的?

在产生了这种记忆的鱼的腭部,科学家们发现了华点:

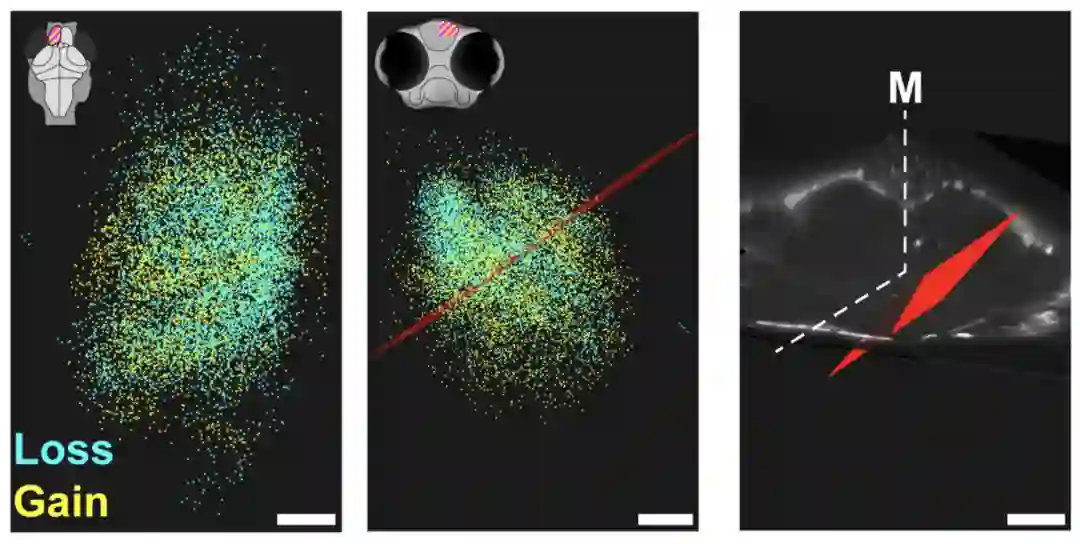

腭部外侧(这一区域含有在记忆形成和检索期间活跃的神经元)的突触数量急剧增加,而腭部的内侧则主要发生突触的丧失。

△青色为丢失,黄色为获得

事实上,“记忆可以通过增加和删除突触形成”这一观点以前也有相关研究,但都柏林圣三一大学的一位神经科学家就表示:

这项研究中对大脑的“实时和大规模可视化”提供了令人信服的证据。

而研究团队则表示,他们希望这一研究能够帮助他们了解较紧张、焦虑综合症,以及PTSD等疾病造成创伤的记忆机制,并能借此进一步提出缓解这些疾病的治疗手段。

作者介绍

论文有两位共同一作William P. Dempseya和Zhuowei Du,两位都来自南加州大学。

其中William P. Dempseya在加州理工大学获得博士学位,现在是南加州大学分子与生物计算分部的一名博士后。

论文:

https://www.pnas.org/doi/10.1073/pnas.2107661119

参考链接:

https://www.quantamagazine.org/scientists-watch-a-memory-form-in-a-living-brain-20220303/

— 完 —

本文系网易新闻•网易号特色内容激励计划签约账号【量子位】原创内容,未经账号授权,禁止随意转载。

直播报名 | 如何建立AI生态的“Android”

从感知到认知,AI还需要多久才能触及生产核心?从软件到数件,AI生态该如何建立自己“Android”?

3月16日19:30,「量子位·视点」CEO/CTO系列分享活动将邀请天云数据CEO雷涛直播分享个人见解。扫码预约直播围观吧~

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

一键三连「分享」「点赞」和「在看」

科技前沿进展日日相见 ~