论文浅尝 | 知识表示、多模态融合、搜索匹配三大方向探索——360人工智能研究院知识图谱算法团队

转载公众号 | 老刘说NLP

当前以促进技术发展、提升模型指标,探究模型天花板的竞赛越来越多,也逐步成为各大研究机构、互联网大厂竞相角逐的主战场。

自2022年以来,在组员的共同努力下,团队(360人工智能研究院知识图谱算法团队),陆续在知识表示、多模态知识融合、知识匹配三个方向上进行探索,并参加相关比赛,取得了一定的成绩。

其中:

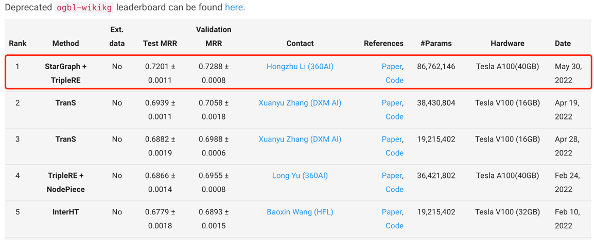

知识表示方向上,提出StarGraph+TripleRE知识表示模型,当前结果在OGB-wikikg2榜位列第一名。可用于图谱表征、实体链接预测、知识补全等潜在应用场景。

多模态知识融合上,采用基于交互编码与蒸馏的多模态实体对齐模型,在ccks2022基于知识图谱的商品同款挖掘评测中获得第二名。该模型可用于图谱融合对齐场景。

知识匹配方向上,采用混合对比学习与课程式难负例采样的搜索匹配模型,在2022问天引擎电商搜索算法赛获得第二名。该模型可用关于图谱推荐、实体匹配等场景。

本文是对这三个竞赛的总结性回顾,供大家一起参考。

一、OGB-wikikg2实体链接预测任务

1、任务描述

就OGB评测而言,其包括了面向节点属性补全的Node Property Prediction、预测边缘(节点对)属性的Link Property Prediction以及面向整个图或子图的属性预测的Graph Property Prediction任务。

ogbl-wikikg2数据集是从维基数据知识库中提取的知识图谱,包含一个三元组(head、relation、tail),捕捉了世界实体之间的不同类型的关系,例如(加拿大、公民、辛顿)。

通过检索维基数据中的所有关系语句,并过滤掉稀有实体,形成的KG包含2,500,604个实体和535种关系类型。

该任务是预测新三元组,即给定一组训练三元组,预测一组新的测试三元组,也就是对于每个测试三重(head、relation、tail),要求模型从(head、relation)预测tail实体。

通过用随机采样的1000个负实体(head500个,tail500个)替换其head或tail来生成每个测试三元组,并确保由此产生的三元组不会出现在原始KG中,目标是对真实head(或tail)实体进行高于负实体的排名。

2、所用模型

去年年末,由360提出的TripleRE,全名Knowledge Graph Embeddings Via Triple Relation Vectors,直译过来就是通过三份关系向量进行知识图谱嵌入,创新的将TransE与pairRE进行融合。

1)模型示意图

PairRE模型,将头实体和尾实体分别做投影,得到一个向量表示,可以有效的建模对称性关系。而是否可以将TransE与它进行融合呢。

带着这种思想,我们提出了tripleRE,在原有2段关系向量的基础上,加入一个中间翻译向量,形成三段。

我们可以看到的是,中间翻译向量为0的时候,也就等同于PairRE。

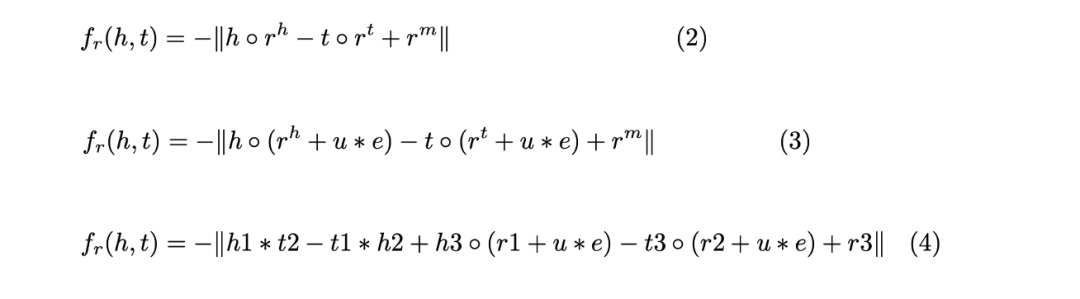

2、score function公式

TripleRE共设计了三个score-function,其中第三个版本中,在InterHT的启发下, 我们发现实体的转换形成可以学到更多的实体信息,因此我们尝试在TripleRE中加入基于实体的转换表示,并将实体分为三个部分, 即h1, h2, h3和t1, t2, t3。

而其中的nodepiece由于采样方法的局限性,并不能有效的区分实体之间的差异性,所以我们在今年5月份的版本中,优化nodepiece的采样方式,提出StarGraph+TripleRE知识表示模型,MRR提升了3-4个点,当前结果在OGB-wikikg2榜位列第一名。

3、最终成绩:

地址:https://ogb.stanford.edu/docs/leader_linkprop/#ogbl-wikikg2

二、ccks2022基于知识图谱的商品同款挖掘评测

1、任务描述

同款商品是指商品的重要属性完全相同且客观可比的商品,商品同款识别的主要目的是从海量结构化和无结构化的商品图文数据库中匹配得到同款商品,是构建电商产品关系的一个重要环节。商品同款作为商品知识图谱的重要组成部分,有很多应用场景,如同款商品发现等。

商品定义:商品(即item)通常由多个sku构成,其基础信息包括item级信息(主图、标题、类目、属性及属性值)以及sku级信息(sku图片、sku销售属性),例如:Redmi K50 是一个item(见图1),(Redmi K50,银迹,8GB+128GB)是一个sku。从消费者视角出发,对于手机类目,品牌+型号一致的商品可以认定是同款商品。

但由于商家个性化发布导致商品标准化、结构化程度差,且不同类目下的商品关注的重要属性不一,给细粒度同款对齐带来了困难。且考虑到电商平台商品量级大,现有方法通常基于表示学习的方法,基于商品的基础信息得到商品的向量表示,在此基础上基于向量检索的方式,得到item同款。

本任务聚焦于item同款,并为了简化问题,我们将商品同款识别任务定义为二分类任务,即给定商品对信息,判断是否item同款。

2、所用模型

在具有多模态商品信息的场景中,可以利用其他模态的信息实现更细粒度的同款商品对齐。

为了解决这一问题,我们提出了面向电商领域的基于交互编码与蒸馏的多模态实体对齐模型。

该模型利用商品的图像和文本信息,并使用遮蔽语言模型、图文对比、图文匹配等预训练手段来增强模型对于商品的表征能力。借助领域预训练、递推推理的数据增广和知识蒸馏等方法,使模型效果远好于单模态对齐方案和常规表示学习建模算法。

其中:

如上图所示,我们首先基于开源的R2D2模型【360自研多模态模型】,在领域相关的语料上采用不同的策略进行继续预训练,分别得到领域预训练模型R2D2-S和R2D2-P。然后,基于R2D2-P构建交互编码器CrossR2D2,并在训练集上完成训练。最后,使用训练好的CrossR2D2作为教师模型,未经过训练的BiR2D2作为学生模型,进行知识蒸馏。

其中,继续预训练是使预训练模型适应领域数据的常见手段之一,我们分别采用了遮挡语言模型、图文对比(目标是拉近匹配的文本和图像的同时,拉远不匹配的文本和图像)、以及图文匹配三种损失函数作为模型损失,并采用单商品预训练策略和成对商品预训练策略。

此外,由于交互编码器效果要好于双编码器,我们设计并实现了一种基于R2D2的交互编码器,称为CrossR2D2以及基于R2D2的双编码器,称为BiR2D2。

最后考虑到交互编码器和双编码器之间存在的性能差异,通过知识蒸馏的方式将CrossR2D2中的“知识”迁移至BiR2D2,即教师模型为CrossR2D2,学生模型为BiR2D2。

3、最终成绩

在“CCKS2022 面向数字商务的知识图谱评测任务二:基于知识图谱的商品同款挖掘”竞赛中,复赛F1值为0.8997,排名第二。

地址:https://tianchi.aliyun.com/competition/entrance/531956/rankingList

三、2022问天引擎电商搜索算法赛

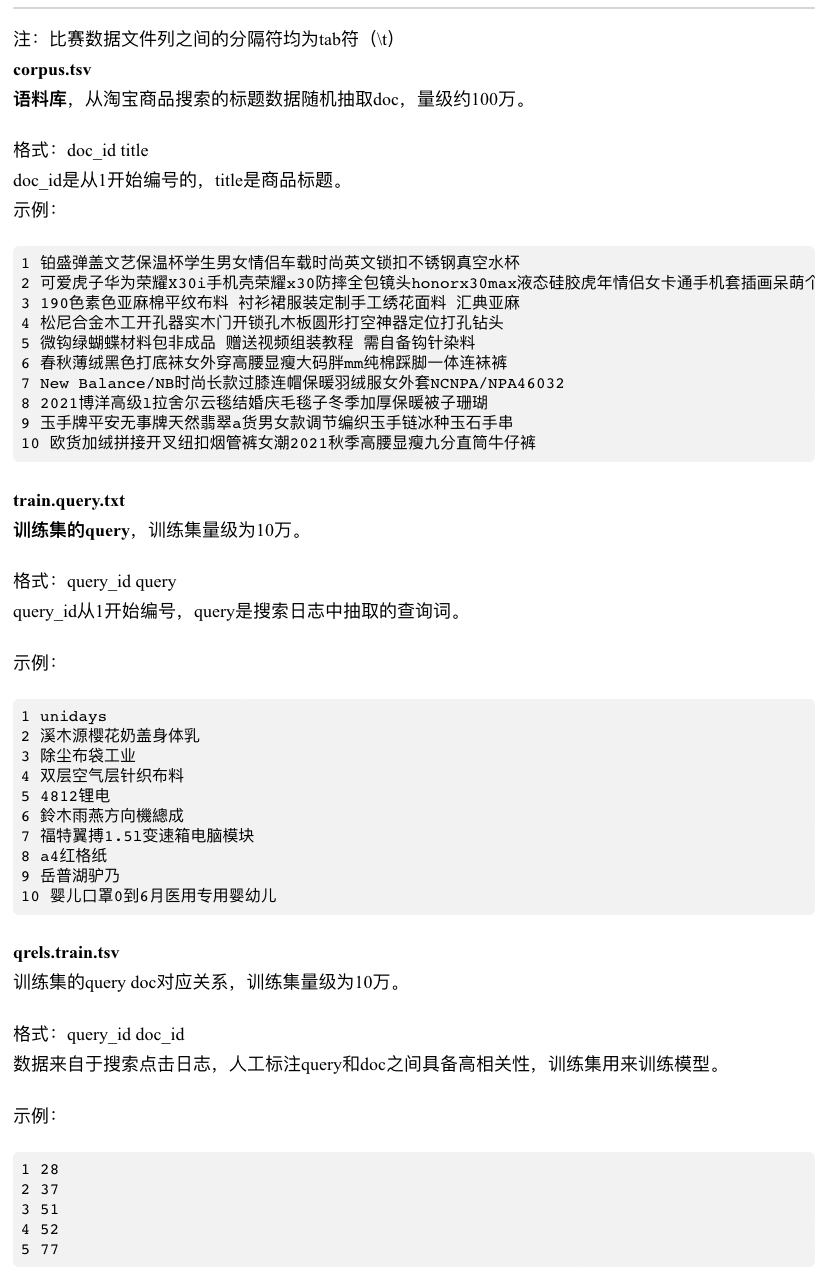

1、任务描述

受疫情催化影响,近一年内全球电商及在线零售行业进入高速发展期。作为线上交易场景的重要购买入口,搜索行为背后是强烈的购买意愿,电商搜索质量的高低将直接决定最终的成交结果,因此在AI时代,如何通过构建智能搜索能力提升线上GMV转化成为了众多电商开发者的重要研究课题。

整个任务是一个匹配问题。

2、所用模型

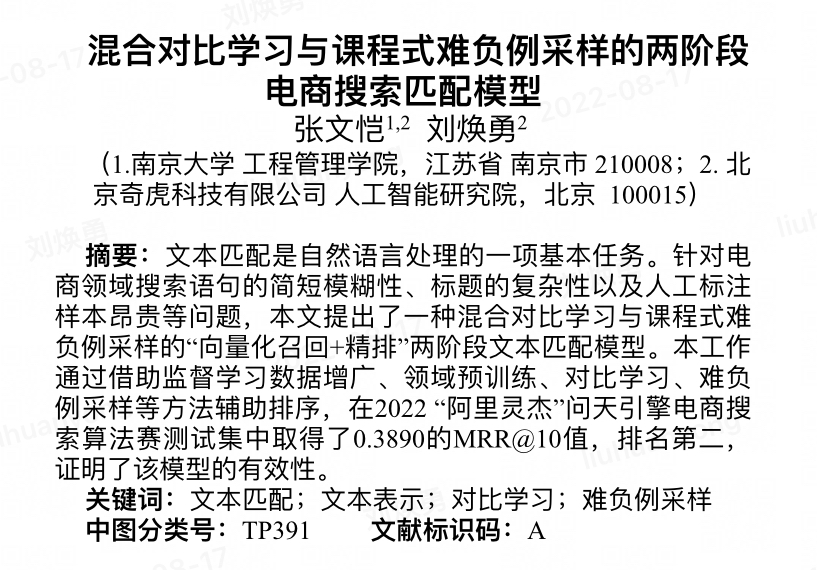

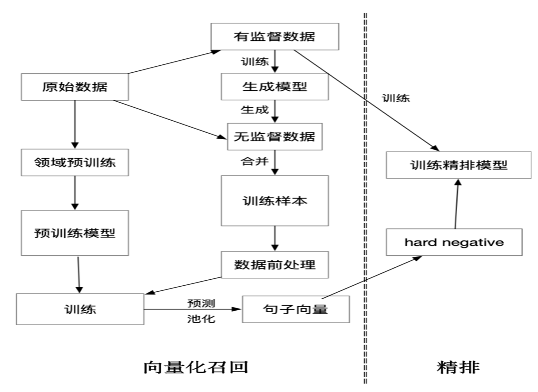

文本匹配是自然语言处理的一项基本任务。针对电商领域搜索语句的简短模糊性、标题的复杂性以及人工标注样本昂贵等问题,我们提出了一种混合对比学习与课程式难负例采样的“向量化召回+精排”两阶段文本匹配模型。

其中:

在向量化召回阶段,给定query,模型在总的doc集合中推理出得分最高的m个doc得到向量化召回结果。

在精排阶段,对于向量化召回得到的m个doc进行排序,得到最终推理结果。

此外,通过借助监督学习数据增广、领域预训练、对比学习、难负例采样等方法辅助排序。

在数据增广上,我们在有监督样本上训练生成模型BART,在无标注样本上进行数据生成,形成监督样本,最终形成增广的有监督数据。

在向量表示上,我们对于输入文本的编码采用BERT的编码形式,将输入的句子,通过分词器按字划分得到序列,将通过look-up表得到由字向量、文本向量、位置向量组成的向量表示为,将向量通过N层Transformer得到文本语义表示向量。

在召回阶段,我们采用SimCSE作为向量化阶段模型,参照对比学习框架和in-batch negative的负样本采样方法,使用交叉熵作为损失函数。

为提高模型的泛化能力,本文在模型训练过程中进一步加入对抗训练。

此外,在向量化召回阶段,模型需要在大规模语料中快速区分出差异样本,对差异样本的辨识精度要求低;而对于精排阶段,模型需要细粒度的区分相似样本,模型需要在小的集合中精准区分出最优样本。

因此,受课程学习思想的启发,本工作将hard negative进行划分,以提升模型的泛化性。

具体的,我们将Knn召回的结果按照相似度得分大小进行排序,从不同排名段的样本抽取形成难负例。经过实验,我们最终将hard negative由简单到困难划分为三个层次:

第一层次,选取相似度得分排名第40-46的样本,此类样本与query匹配度适中;

第二层次,选取相似度得分排名第20-26的样本,此类样本与query的匹配程度高于第一层次;

第三层次,选取相似度得分排名在5-11的样本,此类样本与query的匹配程度极高。

在精排模型训练时,首先采用第一层次的hard negative作为负样本,其次采用第二层次的hard negative作为负样本,最后采用第三层次的hard negative作为负样本。

如此一来,实现让模型从容易的样本开始学习,逐渐进阶到复杂的样本,使模型具有更好的泛化性能,熟练到更好的局部最优解。

3、最终成绩

我们在2022 “阿里灵杰”问天引擎电商搜索算法赛测试集中取得了0.3890的MRR@10值。

地址:https://tianchi.aliyun.com/competition/entrance/531946/rankingList/1

四、总结

自2022年以来,在组员的共同努力下,我团队(360人工智能研究院知识图谱算法组),陆续在知识表示、多模态知识融合、知识匹配三个方向上进行探索,并参加相关比赛,取得了一定的成绩。

本文是对上述三个竞赛任务的一些技术总结性分享,从中我们可以看到三个典型任务以及可用的技术手段,当然,打比赛是一种做法,模型创新是另外一种做法,我们可以做更多的尝试,并更贴近落地去做。

最后,为团队做一次广告,我们360人工智能研究院知识图谱团队,从产品、项目交付,技术深度均已取得一定成果,欢迎关注我们的工作。

五、关于作者

老刘,刘焕勇,NLP开源爱好者与践行者,主页:https://liuhuanyong.github.io。

就职于360人工智能研究院、曾就职于中国科学院软件研究所。

老刘说NLP,将定期发布语言资源、工程实践、技术总结等内容,欢迎关注。

OpenKG

OpenKG(中文开放知识图谱)旨在推动以中文为核心的知识图谱数据的开放、互联及众包,并促进知识图谱算法、工具及平台的开源开放。

点击阅读原文,进入 OpenKG 网站。