【ACL2020】生成事实验证解释,Generating Fact Checking Explanations

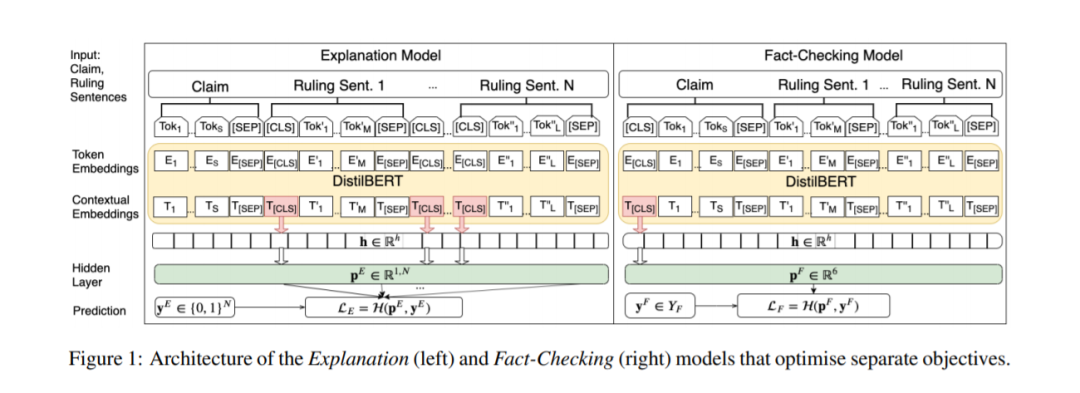

大多数关于自动事实核查的现有工作都是基于元数据、社会网络传播、声明中使用的语言,以及最近支持或否认声明的证据,来预测声明的准确性。这个谜题中仍然缺失的一个关键部分是,理解如何自动化这个过程中最复杂的部分——为声明的裁决生成理由。本文首次研究了如何根据可用的声明上下文自动生成这些解释,以及如何将此任务与准确性预测联合建模。我们的结果表明,同时优化这两个目标,而不是分别训练它们,可以提高事实核查系统的性能。手工评估的结果进一步表明,在多任务模型中生成的解释的信息量、覆盖率和整体质量也得到了提高。

https://www.zhuanzhi.ai/paper/f1c7bb760f04f5b94ea172514505293a

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“GFCE” 就可以获取《【ACL2020】生成事实验证解释,Generating Fact Checking Explanations》专知下载链接

登录查看更多

相关内容

专知会员服务

99+阅读 · 2020年7月3日

专知会员服务

17+阅读 · 2020年3月23日

专知会员服务

52+阅读 · 2020年1月20日

Arxiv

10+阅读 · 2018年4月11日

Arxiv

4+阅读 · 2017年10月26日