发现果体:鉴黄AI职业技能大赛,谷歌微软亚马逊谁最强?| 附代码

开车栗 发自 凹非寺

量子位 出品 | 公众号 QbitAI

虽说,大家都喜欢看,会被举报的那种图片。

但网络,特别是社交网络,还是需要净化环境。毕竟,没有分级制度,纯洁的花朵可能受到污染。

鉴黄师,令人艳羡的职业,就这样诞生了。牺牲了自己,成全千万家 (写反了) 。

△ 手动@唐马儒

当然,能做鉴黄师的不只有人类:计算机不需要发工资,阅片无数也不会产生生理反应影响工作。

于是,许多科技巨头开发了自己的AI鉴黄师,自动过滤一些NSFW的内容。

△ Not Safe For Work

有些内容,如果AI不是很确定要不要阻挡,再交由人类做最终的裁决。

这样一来,鉴黄师的身心得到了保护,工作效率也比从前高出许多。

职业技能大赛

谷歌、微软、亚马逊,以及Clarifai这样的初创公司,都提供了图像审查API,把成人向元素检测出来——

1号选手:Google Cloud Vision

2号选手:Microsoft Image Moderation

3号选手:AWS Rekognition (亚马逊)

4号选手:Clarifai Nudity

Dataturks团队,想要比一比这几家AI的鉴黄能力,也看看人类的工作能从多大程度上被取代。

比赛用的是开源数据集YACVID,包含180幅图像,其中90幅被人类鉴黄师标注为“果体 (Nude) ”,另外90幅为“非果体 (Not Nude) ”,是为标准答案。

非果体举栗:

果体举栗 (此处不便,请使用传送门) :

https://s3.amazonaws.com/com.dataturks.imagemoderation/nonnude26.jpg

(需把nonnude26,改成nude01、43、57、74等)

每位选手要辨别全部180幅图,到底果不果。

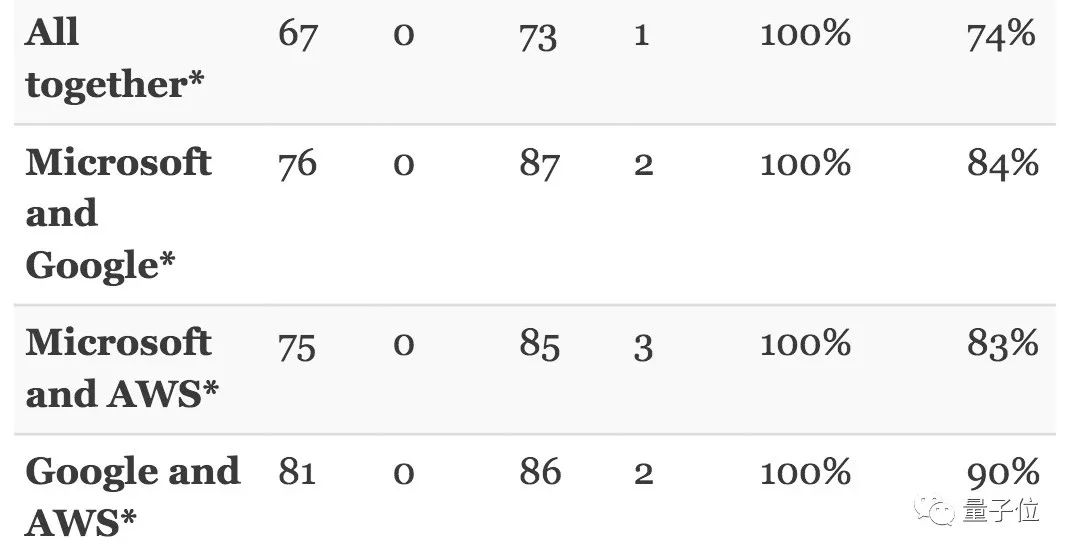

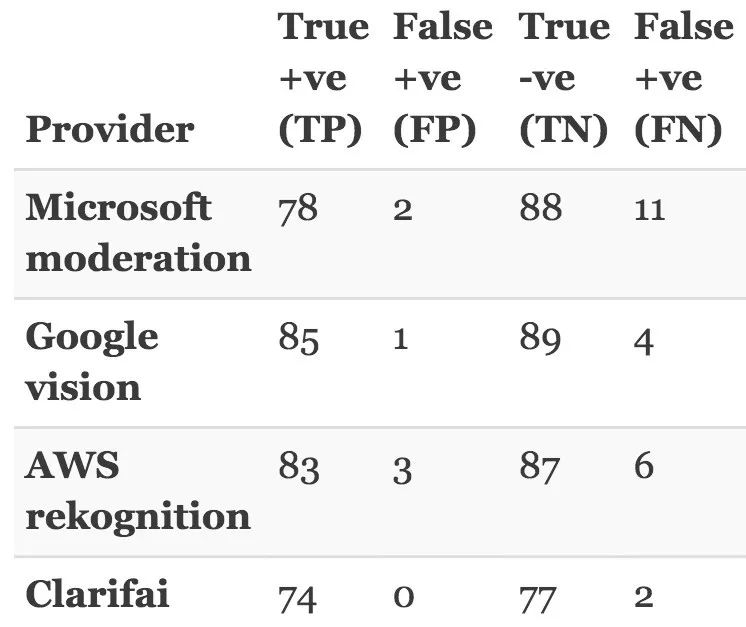

比赛成绩由几部分组成——

真正 (True Positive,TP) :正确识别非果图的次数;

假正 (False Positive,FP) :将果图识别成非果图的次数;

假负 (False Negative,FN) :将非果图识别为果图的次数;

真负 (True Negative,TN) :正确识别果图的次数。

这个世界很危险,真正越多越好,假正越少越好。

另外,如果假负太多,表示系统的功能比较弱小,人类的工作负担就比较重。

谷歌是第一

看一下结果吧。

总体来讲,谷歌表现最为出色,真正和真负的都是最高的。

相比之下,微软和亚马逊AWS的假负略高,容易谎报险情。

而Clarifai,虽然假正 (0) 和假负 (2) 都比较低,但真正和真负也都在80以下。也就是说,它不易错报军情,但有许多情况要交给人类判断,因为AI不确定。

但总体来说,四位选手的表现都不差,所以测试团队决定让它们联手。

结果是,谷歌与亚马逊AWS,合作最为顺滑。不过,依然有10%的安全图像,需要得到人类的确认。

也不知道,人类鉴黄师会不会感念AI的帮助。

大家容易错在哪?

Google Cloud Vision

被谷歌鉴黄师标记成“可能 (Possible) ”,“好像 (Likely) ”,“非常像 (Very Likely) ”的图像,就是去往危险分类的图像。

这些是谷歌报告危险,但人类认为安全的栗子:

标记成”不像 (Unlikely) “,以及“非常不像 (Very Unlikely) ”的,便是AI判断的安全图像了。

比如,谷歌说nude61 (可从上文传送门前往观察) 是安全的,但人类不同意。

AWS Rekognition

亚马逊审查员,有“显然是果图 (Explicit Nudity) ”,“果图 (Nudity)”,“可能是果图 (Suggestive)”这几种危险标记,被划到NSFW里去。

这样一来,穿得客气一点的小姐姐,就很难过审了。

看来,像“Possible”和“Suggestive”这样的谦虚标记,容易比人类的过滤得更严格。

这样,鉴黄师们就算有了AI的协作,也依然能审到一些比较不错的图片,不会失去工作的动力吧。

温柔的畅想

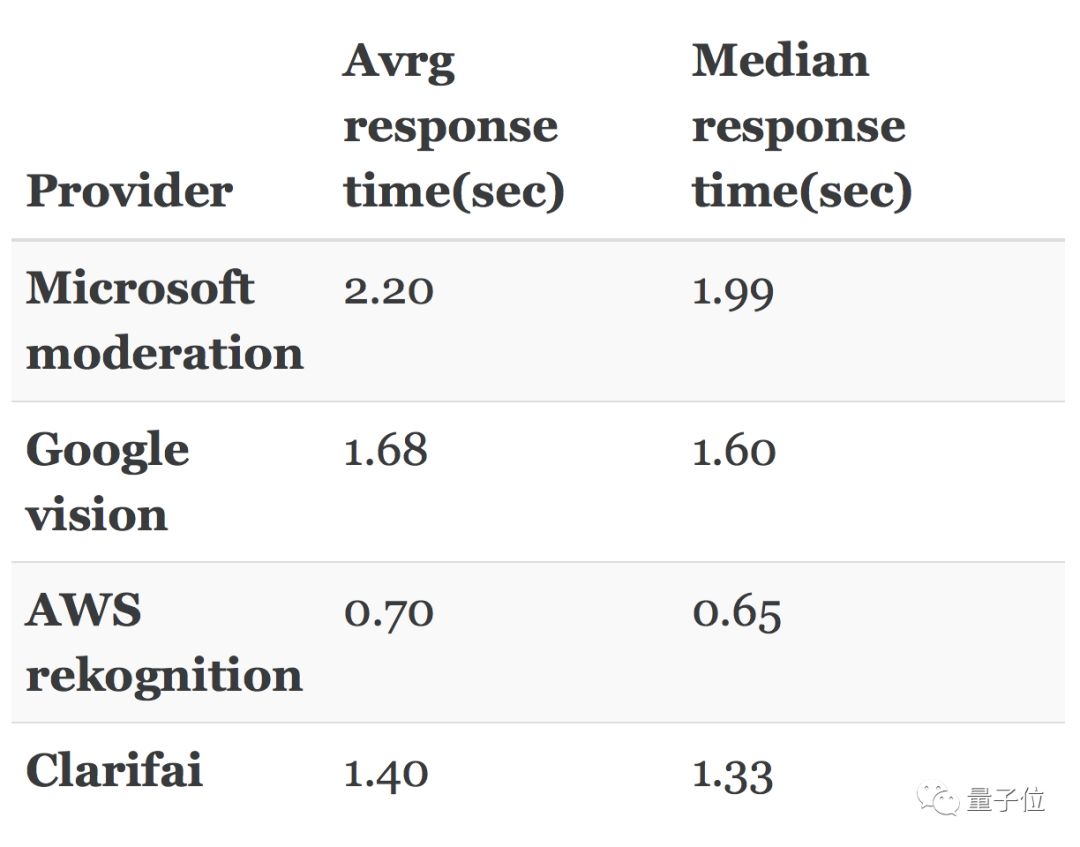

180张图片,AI秒速欣赏完毕。单身30年也难企及的速度。

听上去不错,就是不知道,未来的AI能不能解锁人类的快感。

有兴趣的各位,可以前往以下地址,获取数据集和代码:

https://dataturks.com/blog/image-moderation-api-comparison.php

— 完 —

加入社群

量子位AI社群19群开始招募啦,欢迎对AI感兴趣的同学,在量子位公众号(QbitAI)对话界面回复关键字“交流群”,获取入群方式;

此外,量子位专业细分群(自动驾驶、CV、NLP、机器学习等)正在招募,面向正在从事相关领域的工程师及研究人员。

进专业群请在量子位公众号(QbitAI)对话界面回复关键字“专业群”,获取入群方式。(专业群审核较严,敬请谅解)

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态