注意!深度学习不仅存在“黑盒”,还存在不少缺点!

“全球人工智能”拥有十多万AI产业用户,10000多名AI技术专家。主要来自:北大,清华,中科院,麻省理工,卡内基梅隆,斯坦福,哈佛,牛津,剑桥...以及谷歌,腾讯,百度,脸谱,微软,阿里,海康威视,英伟达......等全球名校和名企。

来自:人机与认知实验室 作者:边际

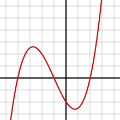

导读:深度学习的局限性和不足,该方法主要使用在具有可微分(函数连续)、强监督(样本数据标定很好、样本类别/属性/评价目标恒定)学习、封闭静态系统(干扰少、鲁棒性好、不复杂)任务下,而对于不可微分、弱监督学习(样本分布偏移大、新类别多、属性退化严重、目标多样)、开放动态环境下该方法效果较差,计算收敛性不好。

相对于其他机器学习方法,使用深度学习生成的模型非常难以解释。这些模型可能有许多层和上千个节点;单独解释每一个是不可能的。数据科学家通过度量它们的预测结果来评估深度学习模型,但模型架构本身是个“黑盒”。它有可能会让你在不知不觉间,失去“发现错误”的机会。

评论家有时候对深度学习的这方面特性持反对态度,但牢记分析的目的是重要的。例如,如果分析的主要目的是解释方差或者处理结果,选择深度学习可能是错误的。然而,也可以根据其重要性对预测变量排序,这也是数据科学家经常要实现的。部分依赖图可以为数据科学家提供可视化深度学习模型的功能。深度学习同样也有其他机器学习方法的倾向,对训练数据过度学习。这意味着算法“记住了”训练数据的特征,在模型将要使用的生产环境中,这些被记住的特征可能会也可能不会被用到。这一问题并不只出现在深度学习之中,这可以通过独立验证来避免。

由于深度学习模型很复杂,它们需要大量的计算性能来构建。虽然计算成本已经大幅下降,但是计算仍旧不是免费的。对于小数据集的简单问题,在计算开销和时间相同的情况下,深度学习可能不会比更简单方法产生足够的额外效果。复杂性同样是部署的一个潜在问题。NetFlix从来没有部署那个赢得了100万美元奖励的模型,因为工程成本太高了。在测试数据上表现良好但无法落实的预测模型是没有实际用途的。如今的深度学习技术还有另一个问题,它需要大量的数据作为训练基础,而训练所得的结果却难以应用到其他问题上。

深度学习并不是新鲜的技术,原始的深度学习技术早在上世纪50年代就出现了。但是随着计算成本的下降,数据量的提升,技术的进步,业界对深度学习的兴趣激增。无需专业知识,费时的特征工程,甚至大量的数据准备,深度学习可以发现大量数据集中隐藏的关系,它已经成为一种解决日益增长业务问题的引人注目的方法。

来源:知乎 作者:Haven Feng

链接:https://www.zhihu.com/question/28638393/answer/74523879

首先深度学习(DL)的历史很久远,其实是人工神经网络(ANN)配以不同的改进(现在CNN最火啦)换个名字炒个新概念。Hinton、LeCun等几个大神都属于在上一拨冷淡期坚持下来的,等到了GPU加速运算体现效能的时代。由于ANN源于对神经结构极不彻底的模仿(只能叫借鉴),而我们对神经结构内部涌现出的智能性尚且无法做出合理的解释,对于人工神经网络的理论当然处于黑箱的阶段了,这就是为啥好多人吐槽搞DL和大数据是像中医诊断一样基于经验和巧合的工作,因为理论本身就没有做出来但是有些识别效果却不错,于是先调参数再说吧,调一调也就差不离了(文科生做大物实验即视感)。当然实际过程复杂得多,贝叶斯是个很厉害的人,众PhD和Msc的数学都很好。

而真正的深度学习,我个人觉得要追溯到人类智能产生的源头,在此贴上 Jeff Hawkins 大神的TED演(吐)讲(槽)『这我男神啊,Palm和webOS发明人』Jeff Hawkins: How brain science will change computing,另外还有他所写的On Intelligence (豆瓣),我只是一枚小小搬运工,分享观点~~

演讲和书都是十年前的作品了,相信很多人都已经看过了,在演讲中男神说他创办了一个叫 NUMENTA 的公司来应用他的HTM算法,但事实上真的很难,NUMENTA已经转型好几次了,而其主要产品Grok现在已经专门剥离出来替代了原公司,变成了一个针对AWS分析的玩意儿,和初衷差得有点远哈。传送门:能否介绍一下 jeff hawkins 所创建公司 numenta 的 htm(hierarchical temporal memory)算法? 这位答主讲得很清楚,另外有使用过的童鞋说还不错但肯定不如CNN啦。我个人觉得这也不能否定HTM算法本身,就像《模仿游戏》里图灵的机器造好前大家还觉得手算更快呢。好在Jeff男神并不是一个人在战斗~

我简述一下 Jeff Hawkins 的观点就是,DL的本质应该是基于一套智能理论框架的,而这套理论框架和人脑应该是没有太大差别,虽然从某种意义上讲,DL已经比SVM这些传统的ML先进太多,但和真正的智能相比相去甚远。。。 Yann LeCun巨巨就特反对这种观点,『计算就计算,扯什么大脑啊,反正不如CNN~』

所谓智能理论框架是个现在看来非常复杂的问题了。因为Neuroscience领域(知乎上大大太多我不敢讲~,大家多批评多修改啊)现在面临的一大问题就是得到的数据越来越多但是却无法有效的联系起来,科学家们把大量的精力投入到获取更多的数据,但是理论构架的建立却并没有取得突破性成就。 这是欧洲人脑计划(HBP)的发起人 Henry Markram (Prof of EPFL)的观点,是不是和演讲中『我们取得的这些数据还弄不明白,再多数据又有什么用呢』听上去一样一样的。当然也有一大票神牛巨巨反对他,还联名写信给EU要求削减他预算,嗯,因为EU给拨了十亿欧,大家担心他没搞好以后就没钱了。 HBP计划是利用超算模拟人脑,整合Neuroscience各子领域知识搭建智能框架,再把该理论反向应用回算法和芯片领域,听上去雄心勃勃呢。最近刚在Cell上发了一篇82作的报告。

可微条件

1、可微必要条件

若函数在某点可微分,则函数在该点必连续;

若二元函数在某点可微分,则该函数在该点对x和y的偏导数必存在。

2、可微充分条件

若函数对x和y的偏导数在这点的某一邻域内都存在,且均在这点连续,则该函数在这点可微。

AI专家问答平台